HDFS:

Apache Hadoop 分散ファイルシステム(HDFS)は、Hadoop クラスタの複数のノードにわたって大量の データ を保存および管理するように設計された分散ファイルシステムです。ビッグデータ の保存と処理のために、高可用性、耐障害性、スケーラビリティを提供します。HDFS は Apache Hadoop エコシステムの重要なコンポーネントです。

Snowflake:

Snowflake は、企業が大量のデータをスケーラブルかつ効率的に保存・分析できるクラウドベースのデータウェアハウジングプラットフォームです。データ共有、リアルタイムデータ処理、安全なデータストレージなどの機能を提供します。Snowflake は使いやすさと多様なデータタイプの処理能力で知られています。

CData Sync で HDFS と Snowflake を統合

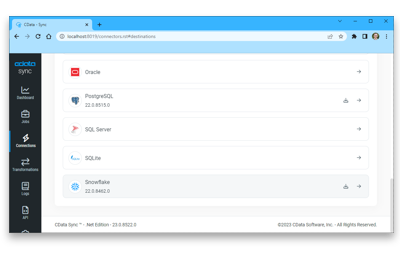

CData Sync は、Apache HDFS データを任意のデータベース、データレイク、データウェアハウスに継続的にパイプライン化する簡単な方法を提供し、分析、レポート作成、AI、機械学習に容易に利用できるようにします。

- Snowflake を含む、幅広い従来型および新興データベースとデータを同期できます。

- HDFS データをデータベースやデータウェアハウスシステムにレプリケートして、運用レポート、BI、分析を促進します。

- HDFS からクエリをオフロードして、負荷を軽減しパフォーマンスを向上させます。

- HDFS をビジネス分析に接続して、BI と意思決定支援に活用します。

- ディザスタリカバリのために Apache HDFS データをアーカイブします。

HDFS を Snowflake と統合

HDFS データ統合機能

シンプルなノーコード HDFS データ統合

コードや複雑なセットアップを不要にして、より短時間でより多くのデータを移動できます。ドラッグアンドドロップの簡単な操作で HDFS を任意の宛先に接続できます。

数分で構築できる手間のかからないデータパイプライン

増分更新と自動スキーマレプリケーションにより、HDFS データ統合の悩みを解消し、Snowflake が常に最新のデータを保持できるようにします。

行ごとの課金はありません

予測可能で透明性の高い価格設定で、重要なすべてのデータをレプリケートできます。HDFS と Snowflake 間の無制限のレプリケーション。

その他の HDFS データ統合ツール

HDFS からサポートされている任意のデータストアにデータを統合・レプリケートするデータパイプラインを簡単に作成できます: