CData Connect AI 経由でPostgreSQL インターフェースからリアルタイムの Azure Data Lake Storage のデータに接続

インターネット上には数多くのPostgreSQL クライアントがあります。PostgreSQL はデータアクセスのための一般的なインターフェースです。PostgreSQL をCData Connect AI と組み合わせることで、PostgreSQL からリアルタイムのAzure Data Lake Storage のデータにデータベースのようにアクセスできます。この記事では、Connect AI でAzure Data Lake Storage のデータに接続し、TDS foreign data wrapper(FDW)を使用してConnect AI とPostgreSQL 間の接続を確立するプロセスを説明します。

CData Connect AI は Azure Data Lake Storage 専用のSQL Server インターフェースを提供し、ネイティブでサポートされているデータベースにデータをレプリケートすることなく Azure Data Lake Storage のデータをクエリできます。最適化されたデータ処理を標準で使用し、CData Connect AI はサポートされているすべてのSQL 操作(フィルター、JOIN など)を Azure Data Lake Storage に直接プッシュし、サーバーサイド処理を活用して必要なAzure Data Lake Storage のデータを迅速に返します。

Connect AI で Azure Data Lake Storage に接続

CData Connect AI は、シンプルなポイント&クリック操作でデータソースに接続できるインターフェースを提供しています。

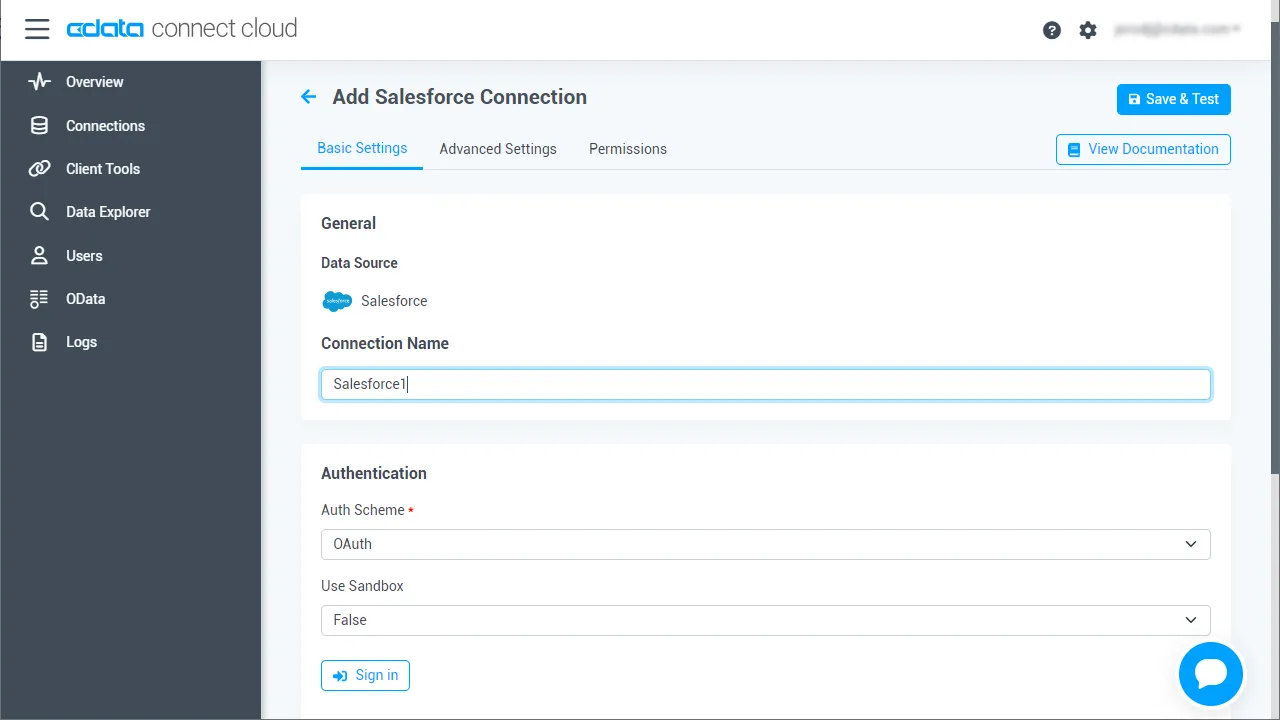

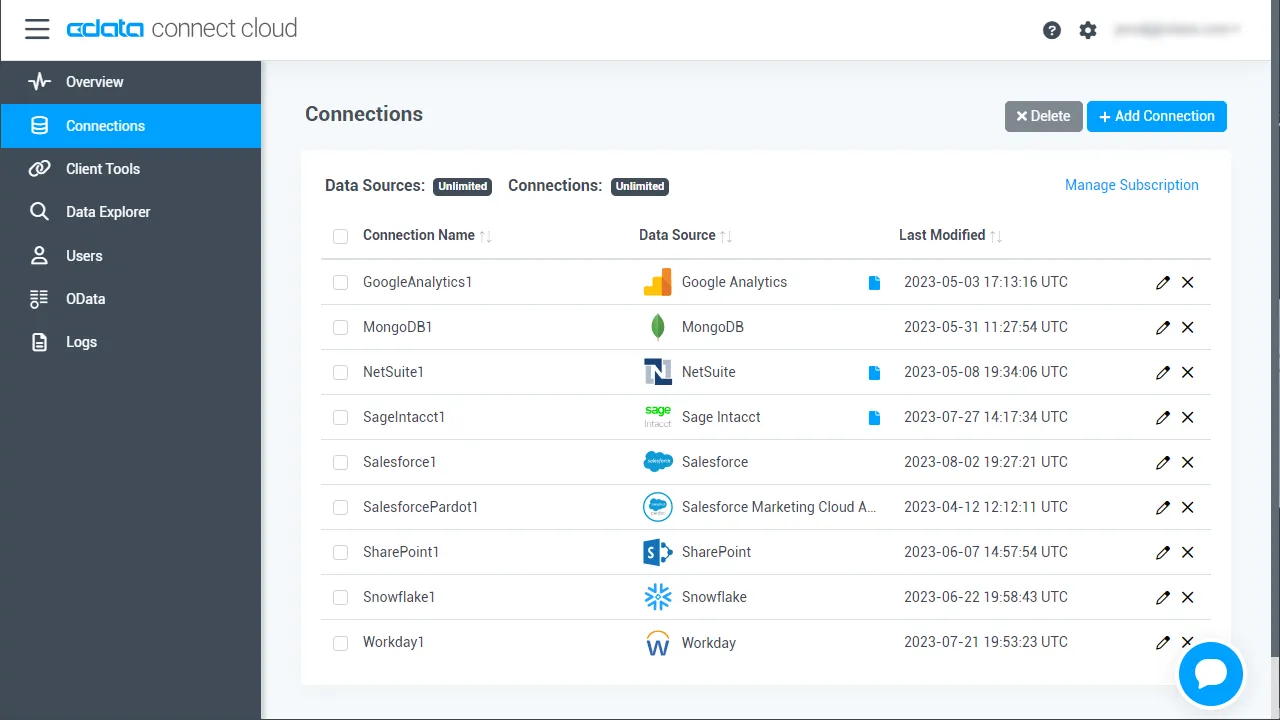

- Connect AI にログインして「Sources」をクリックし、 Add Connection をクリックします

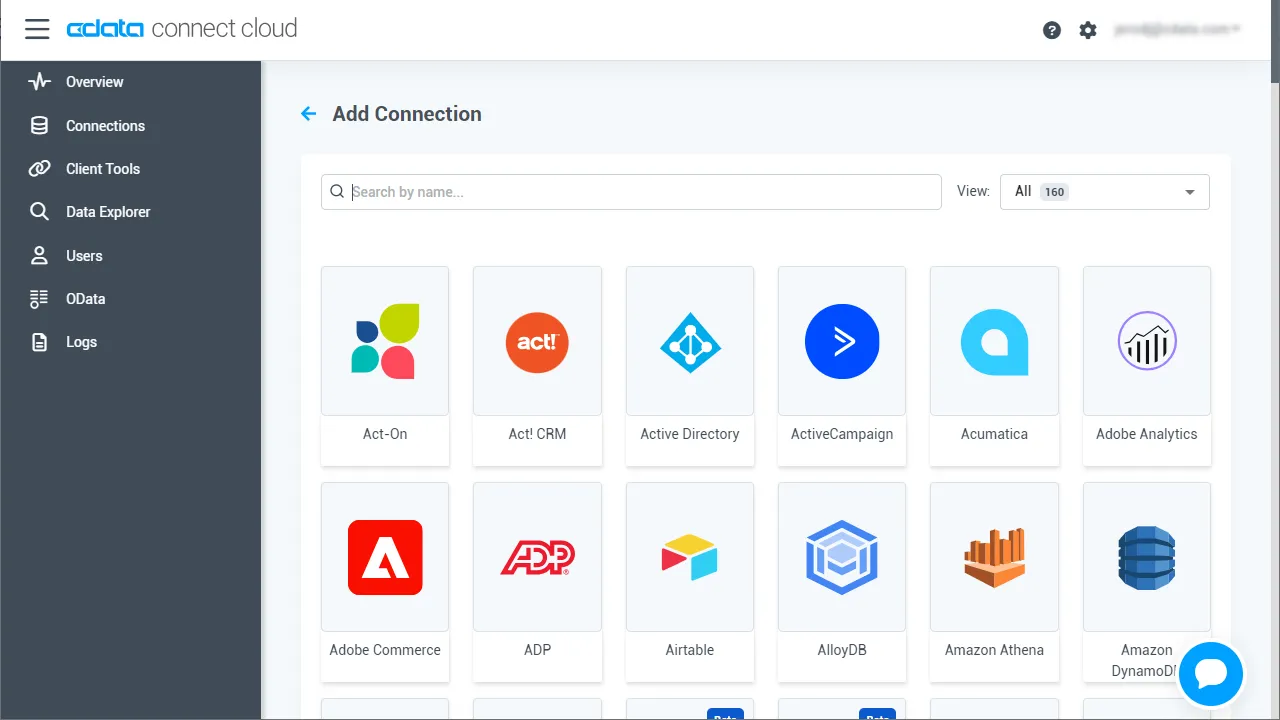

- Add Connection パネルから「Azure Data Lake Storage」を選択します

-

Azure Data Lake Storage への接続に必要な認証プロパティを入力します。

Azure Data Lake Storage 接続プロパティの取得・設定方法

Azure Data Lake Storage Gen2 への接続

それでは、Gen2 Data Lake Storage アカウントに接続していきましょう。接続するには、以下のプロパティを設定します。

- Account:ストレージアカウントの名前

- FileSystem:このアカウントに使用されるファイルシステム名。例えば、Azure Blob コンテナの名前

- Directory(オプション):レプリケートされたファイルが保存される場所へのパス。パスが指定されない場合、ファイルはルートディレクトリに保存されます

Azure Data Lake Storage Gen2への認証

続いて、認証方法を設定しましょう。CData 製品では、5つの認証方法をサポートしています:アクセスキー(AccessKey)の使用、共有アクセス署名(SAS)の使用、Azure Active Directory OAuth(AzureAD)経由、Azure サービスプリンシパル(AzureServicePrincipal またはAzureServicePrincipalCert)経由、およびManaged Service Identity(AzureMSI)経由です。

アクセスキー

アクセスキーを使用して接続するには、まずADLS Gen2ストレージアカウントで利用可能なアクセスキーを取得する必要があります。

Azure ポータルでの手順は以下のとおりです:

- ADLS Gen2ストレージアカウントにアクセスします

- 設定でアクセスキーを選択します

- 利用可能なアクセスキーの1つの値をAccessKey 接続プロパティにコピーします

接続の準備ができたら、以下のプロパティを設定してください。

- AuthScheme:AccessKey

- AccessKey:先ほどAzure ポータルで取得したアクセスキーの値

共有アクセス署名(SAS)

共有アクセス署名を使用して接続するには、まずAzure Storage Explorer ツールを使用して署名を生成する必要があります。

接続の準備ができたら、以下のプロパティを設定してください。

- AuthScheme:SAS

- SharedAccessSignature:先ほど生成した共有アクセス署名の値

その他の認証方法については、 href="/kb/help/" target="_blank">ヘルプドキュメントの「Azure Data Lake Storage Gen2への認証」セクションをご確認ください。

- Save & Test をクリックします

-

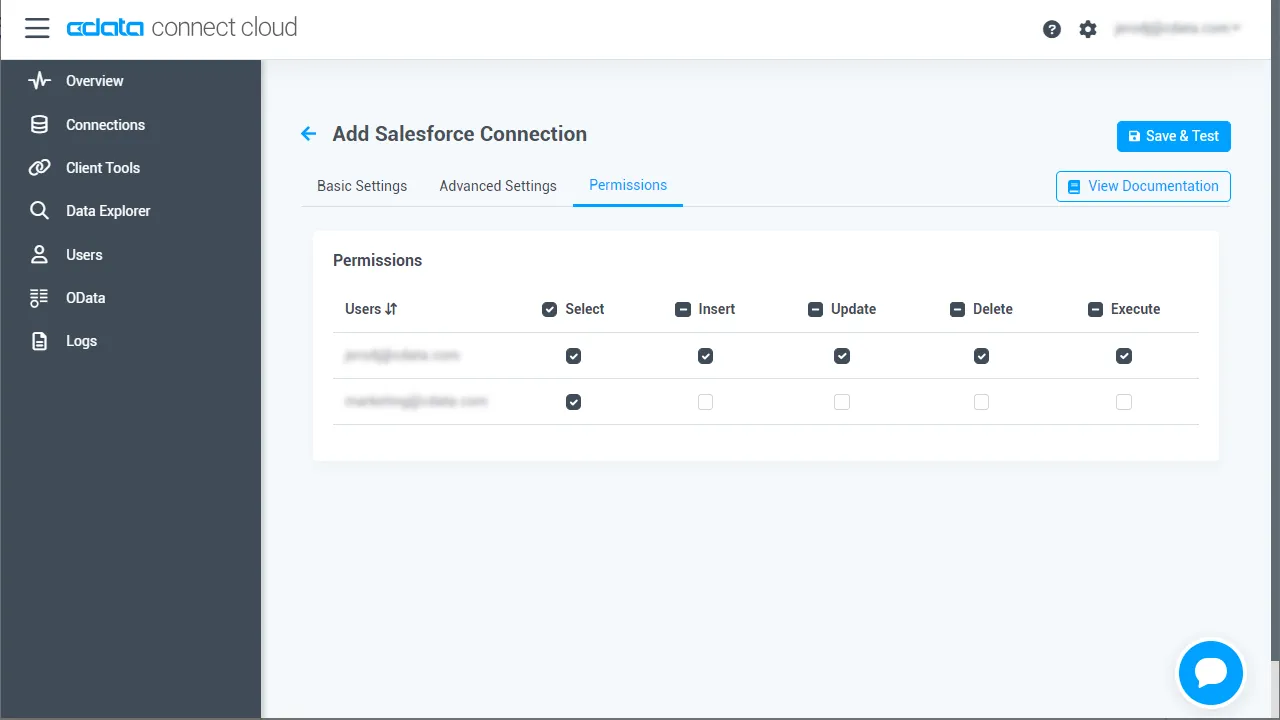

Add Azure Data Lake Storage Connection ページの「Permissions」タブに移動し、ユーザーベースの権限を更新します。

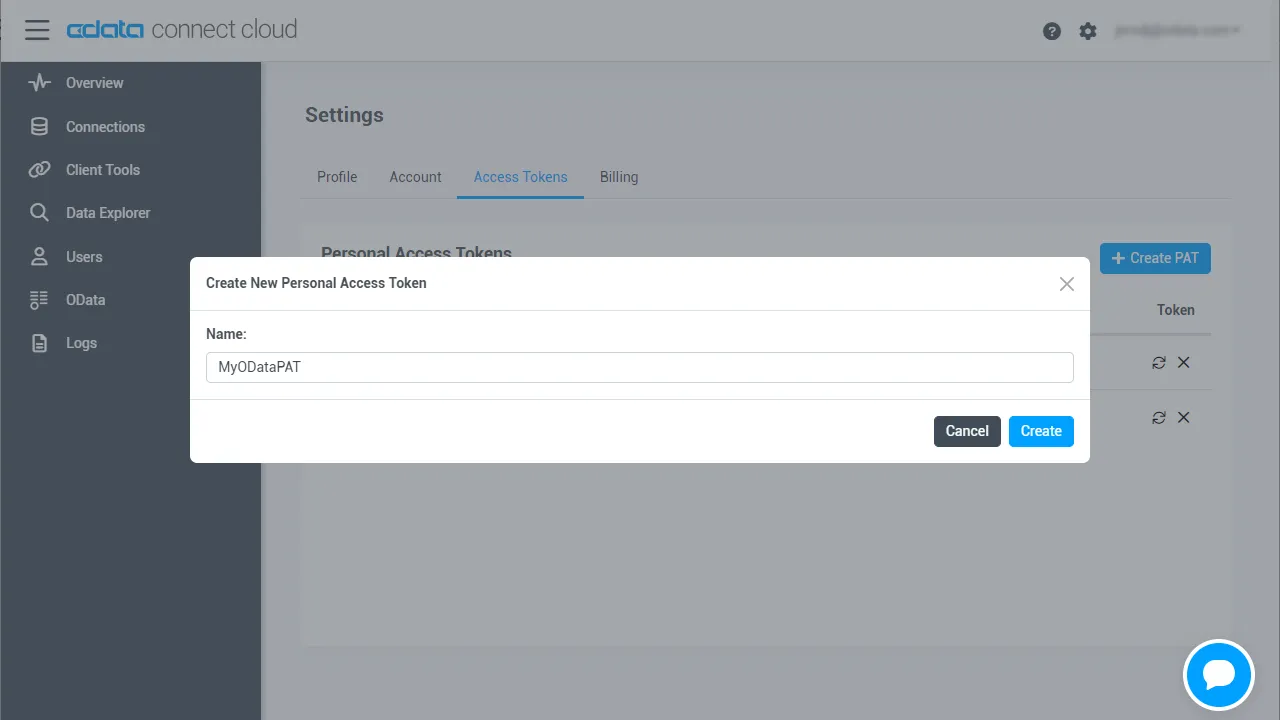

Personal Access Token の追加

REST API、OData API、またはVirtual SQL Server 経由でConnect AI に接続する場合、Personal Access Token(PAT)を使用してConnect AI への接続を認証します。アクセス管理の粒度を維持するために、サービスごとに個別のPAT を作成することをお勧めします。

- Connect AI アプリの右上にある歯車アイコン()をクリックして設定ページを開きます。

- Settings ページで「Access Tokens」セクションに移動し、 Create PAT をクリックします。

-

PAT に名前を付けて「Create」をクリックします。

- Personal Access Token は作成時にのみ表示されるため、必ずコピーして安全な場所に保存してください。

接続の設定とPAT の生成が完了したら、PostgreSQL からAzure Data Lake Storage のデータに接続する準備が整いました。

TDS Foreign Data Wrapper のビルド

Foreign Data Wrapper は、PostgreSQL を再コンパイルすることなく、PostgreSQL の拡張機能としてインストールできます。例として tds_fdw 拡張機能を使用します(https://github.com/tds-fdw/tds_fdw)。

- 以下のようにgit リポジトリをクローンしてビルドできます:

sudo apt-get install git git clone https://github.com/tds-fdw/tds_fdw.git cd tds_fdw make USE_PGXS=1 sudo make USE_PGXS=1 install

注意:複数のPostgreSQL バージョンがあり、デフォルト以外のバージョン用にビルドする場合は、まずpg_config のバイナリの場所を見つけてフルパスをメモし、make コマンドでUSE_PGXS=1 の後にPG_CONFIG=を追加します。 - インストールが完了したら、サーバーを起動します:

sudo service postgresql start

- 次に、Postgres データベースに入ります

psql -h localhost -U postgres -d postgres

注意:localhost の代わりにPostgreSQL がホストされているIP を指定することもできます。

PostgreSQL データベースとしてAzure Data Lake Storage のデータに接続し、データをクエリ!

拡張機能をインストールした後、以下の手順に従ってAzure Data Lake Storage のデータへのクエリを開始します:

- データベースにログインします。

- データベース用の拡張機能をロードします:

CREATE EXTENSION tds_fdw;

- Azure Data Lake Storage のデータ 用のサーバーオブジェクトを作成します:

CREATE SERVER "ADLS1" FOREIGN DATA WRAPPER tds_fdw OPTIONS (servername'tds.cdata.com', port '14333', database 'ADLS1');

- Connect AI アカウントのメールアドレスとPersonal Access Token を使用してユーザーマッピングを設定します:

CREATE USER MAPPING for postgres SERVER "ADLS1" OPTIONS (username '[email protected]', password 'your_personal_access_token' );

- ローカルスキーマを作成します:

CREATE SCHEMA "ADLS1";

- ローカルデータベースに外部テーブルを作成します:

#table_name 定義を使用: CREATE FOREIGN TABLE "ADLS1".Resources ( id varchar, Permission varchar) SERVER "ADLS1" OPTIONS(table_name 'ADLS.Resources', row_estimate_method 'showplan_all'); #またはschema_name とtable_name 定義を使用: CREATE FOREIGN TABLE "ADLS1".Resources ( id varchar, Permission varchar) SERVER "ADLS1" OPTIONS (schema_name 'ADLS', table_name 'Resources', row_estimate_method 'showplan_all'); #またはquery 定義を使用: CREATE FOREIGN TABLE "ADLS1".Resources ( id varchar, Permission varchar) SERVER "ADLS1" OPTIONS (query 'SELECT * FROM ADLS.Resources', row_estimate_method 'showplan_all'); #またはリモートカラム名を設定: CREATE FOREIGN TABLE "ADLS1".Resources ( id varchar, col2 varchar OPTIONS (column_name 'Permission')) SERVER "ADLS1" OPTIONS (schema_name 'ADLS', table_name 'Resources', row_estimate_method 'showplan_all');

- これで、Azure Data Lake Storage に対して読み取り/書き込みコマンドを実行できます:

SELECT id, Permission FROM "ADLS1".Resources;

詳細情報と無償トライアル

これで、リアルタイムのAzure Data Lake Storage のデータからシンプルなクエリを作成できました。Azure Data Lake Storage(およびその他200以上のデータソース)への接続の詳細については、Connect AI ページをご覧ください。無償トライアルに登録して、今すぐPostgreSQL でリアルタイムのAzure Data Lake Storage のデータを活用してみてください。