Dremio でHive のデータに外部ソースとして接続

CData JDBC Driver for Apache Hive はJDBC 標準を実装しており、Dremio を含むさまざまなアプリケーションでリアルタイムのHive のデータを扱えるようにします。Dremio は、データレイク上でのセルフサービス型インタラクティブ分析を実現するために設計されたデータレイクハウスプラットフォームです。CData JDBC ドライバーを使用することで、エンタープライズデータレイクの一部としてリアルタイムHive のデータを活用できます。この記事では、Dremio でHive のデータに外部ソースとして接続する方法について説明します。

CData JDBC Driver を使用すると、Dremio でリアルタイムHive のデータへの高速アクセスが可能になります。ドライバーをインストールしてHive で認証すれば、データレイク内でHive のデータにすぐにアクセスできます。ネイティブのデータ型を使用してHive のデータを表示し、複雑なフィルタ、集計、その他の操作を自動的に処理することで、CData JDBC Driver はHive のデータへのシームレスなアクセスを提供します。

前提条件

この記事では、Docker を使用して Dremio を実行することを想定しています。以下のようなコマンドで Dremio サービスを含む Docker コンテナを作成できます。

docker run -d --name dremio -p 9047:9047 -p 31010:31010 dremio/dremio-oss

ここで、dremio はコンテナの名前、9047 は Dremio Web インターフェース用のコンテナポート、31010 は Dremio クエリサービスにマッピングされるポートです。dremio/dremio-oss は使用するイメージを指定します。

ARP コネクタのビルド

CData JDBC Driver を Dremio で使用するには、Advanced Relation Pushdown(ARP)コネクタをビルドする必要があります。GitHub でソースコードを確認するか、ZIP ファイル(GitHub.com)を直接ダウンロードできます。ファイルをコピーまたは展開したら、コネクタのルートディレクトリ(pom.xml ファイルがあるディレクトリ)から以下のコマンドを実行してコネクタをビルドします。

mvn clean install

NOTE:CData ARP コネクタは Java 11 でコンパイルするようにビルドされています。Java 11 をインストールし、正しいバージョンを使用していることを確認してください。以下のようなコマンドで Java バージョンを更新できます。

sudo update-alternatives --config java

コネクタ用の JAR ファイルが(target ディレクトリに)ビルドされたら、ARP コネクタと JDBC Driver を Dremio インスタンスにコピーする準備が整いました。

コネクタと JDBC Driver のインストール

ARP コネクタを %DREMIO_HOME%/jars/ に、Hive 用の JDBC Driver を %DREMIO_HOME%/jars/3rdparty にインストールします。以下のようなコマンドを使用できます。

ARP コネクタ

docker cp PATH\TO\dremio-apachehive-plugin-{DREMIO_VERSION}.jar dremio_image_name:/opt/dremio/jars/

Hive 用 JDBC Driver

docker cp PATH\TO\cdata.jdbc.apachehive.jar dremio_image_name:/opt/dremio/jars/3rdparty/

Hive への接続

これで、Dremio の外部ソースオプションに Hive が表示されるようになりました。ビルドした ARP コネクタは、JDBC URL を使用してHive のデータに接続します。JDBC Driver には、接続文字列を作成できるビルトインの接続文字列デザイナーがあります(以下を参照)。

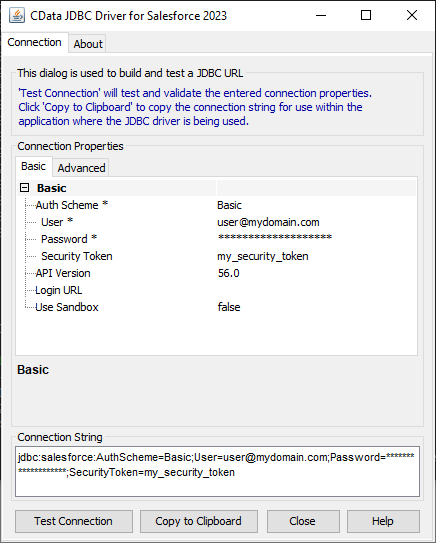

ビルトイン接続文字列デザイナー

JDBC URL の構成については、Hive JDBC Driver に組み込まれている接続文字列デザイナーを使用してください。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行します。

java -jar cdata.jdbc.apachehive.jar

接続プロパティを入力し、接続文字列をクリップボードにコピーします。

Apache Hive への接続を確立するには以下を指定します。

- Server:HiveServer2 をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:HiveServer2 インスタンスへの接続用のポートに設定。

- TransportMode:Hive サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

- CData 製品においてTLS/SSL を有効化するには、UseSSL をTrue に設定します

NOTE:Dremio で JDBC Driver を使用するには、ライセンス(正式版または評価版)とランタイムキー(RTK)が必要です。このライセンス(または評価版)の取得については、営業チームにお問い合わせください。

ランタイムキー(RTK)を JDBC URL に追加します。最終的に、以下のような JDBC URL になります。

jdbc:apachehive:RTK=5246...;Server=127.0.0.1;Port=10000;TransportMode=BINARY;

Hive に外部ソースとしてアクセス

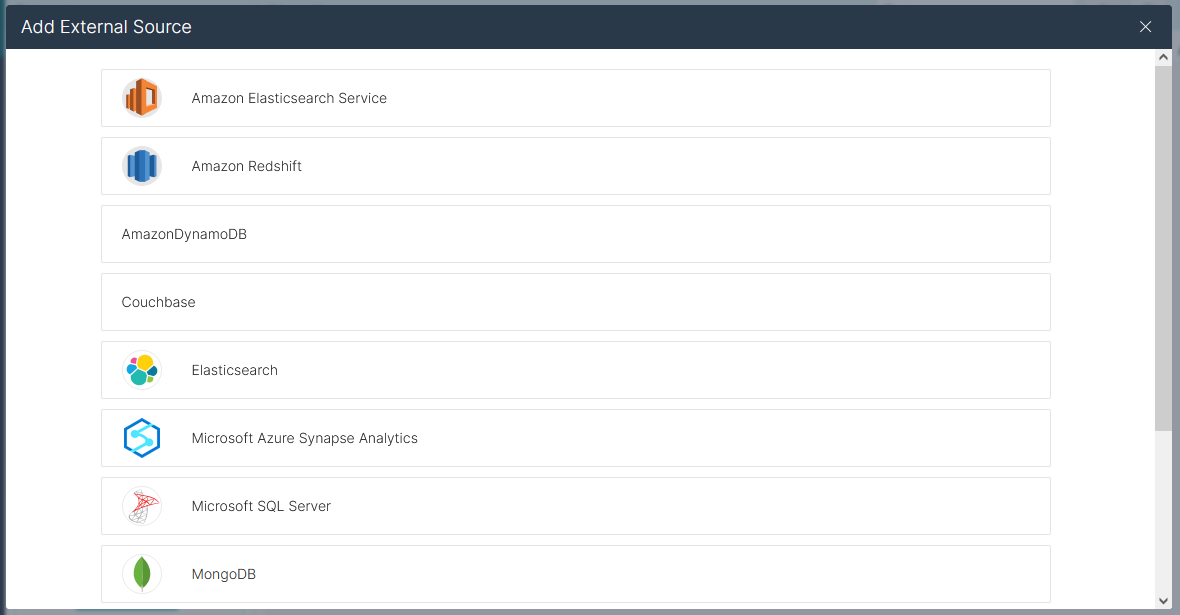

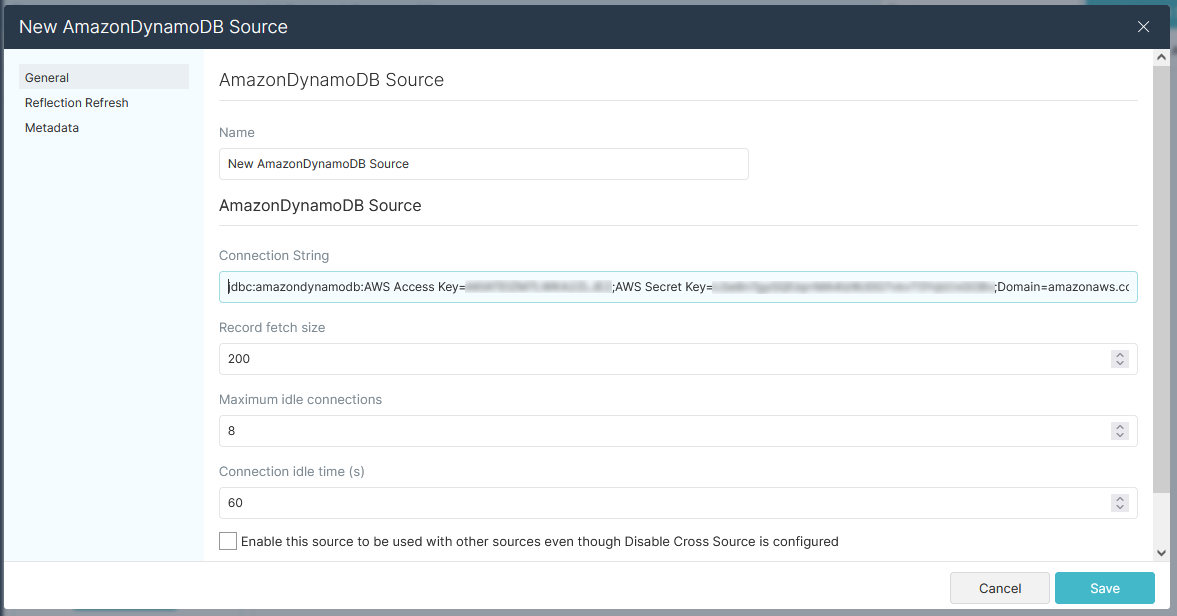

Hive を外部ソースとして追加するには、新しいソースを追加するためにクリックし、ApacheHive を選択します。JDBC URL をコピーして、New ApacheHive Source ウィザードに貼り付けます。

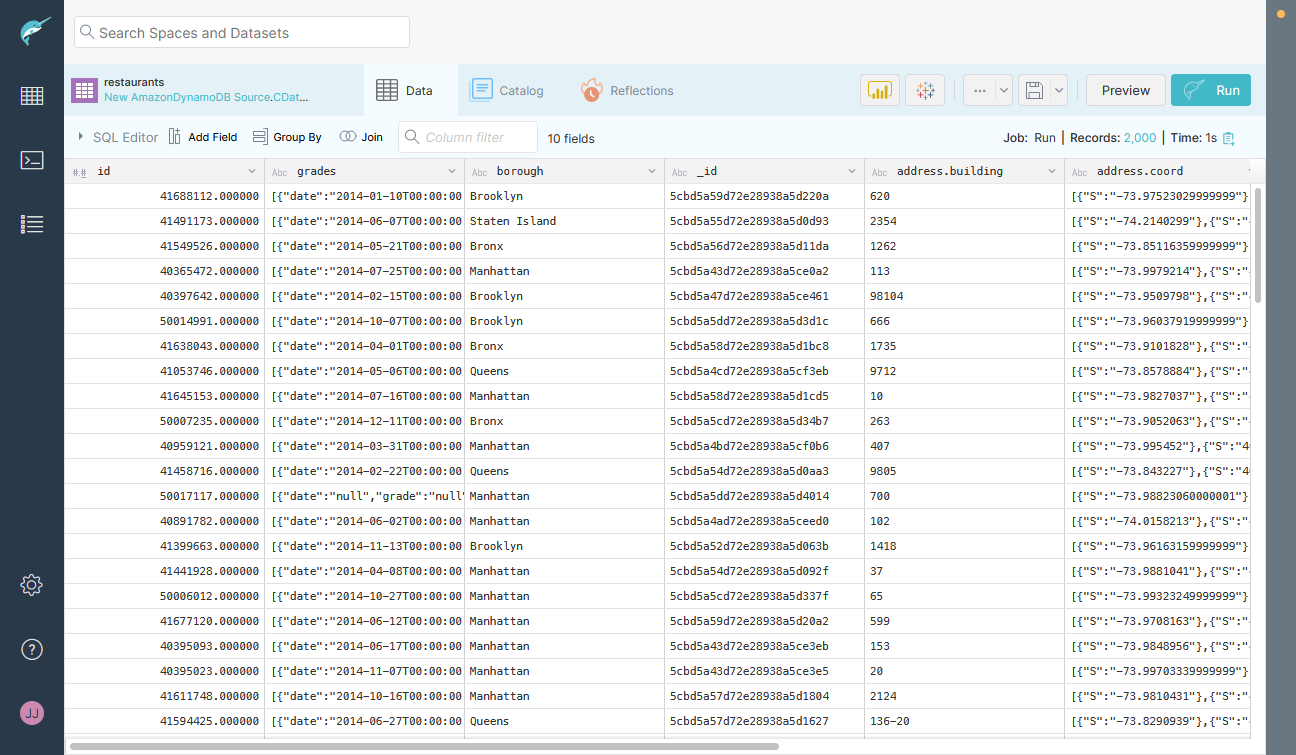

接続を保存すれば、Dremio でリアルタイムHive のデータをクエリする準備が整い、Hive のデータをデータレイクに簡単に取り込むことができます。

詳細情報と無償トライアル

Dremio で CData JDBC Driver for Apache Hive を使用すると、リアルタイムHive のデータをデータレイクに取り込むことができます。Hive への接続の詳細については、CData JDBC Driver for Apache Hive ページをご覧ください。CData JDBC Driver for Apache Hive の30日間無償トライアルをダウンロードして、今すぐ始めましょう。