Apache NiFi でJSON のデータにバッチ操作を実行

Apache NiFi は、データルーティング、変換、およびシステム間連携ロジックを強力かつスケーラブルに構築できるプラットフォームです。CData JDBC Driver for JSON と組み合わせることで、NiFi からリアルタイムJSON servicesを操作できるようになります。この記事では、CSV ファイルからデータを読み取り、Apache NiFi(バージョン1.9.0 以降)でCData JDBC Driver forJSON servicesを使用してバッチ操作(INSERT/UPDATE/DELETE)を実行する方法を説明します。

最適化されたデータ処理が組み込まれたCData JDBC Driver は、リアルタイムJSON servicesを扱う上で比類のないパフォーマンスを提供します。JSON に複雑なSQL クエリを発行すると、ドライバーはフィルタや集計などのサポートされているSQL 操作をJSON に直接プッシュし、サポートされていない操作(主にSQL 関数やJOIN 操作)は組み込みSQL エンジンを利用してクライアント側で処理します。組み込みの動的メタデータクエリを使用すると、ネイティブデータ型を使ってJSON servicesを操作・分析できます。

JDBC URL の生成

Apache NiFi からJSON servicesに接続するには、JDBC URL が必要です。

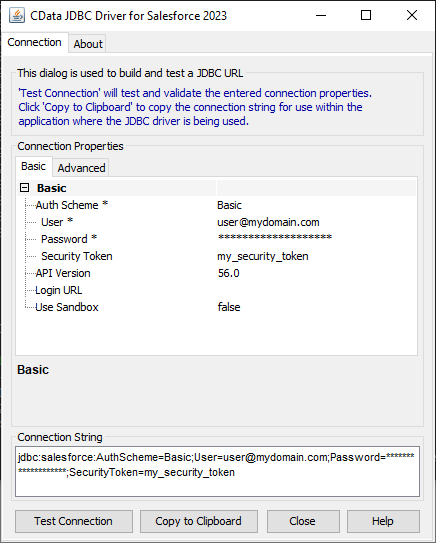

組み込みの接続文字列デザイナー

JDBC URL の作成をサポートするために、JSON JDBC Driver に組み込まれている接続文字列デザイナーが使用できます。JAR ファイルをダブルクリックするか、コマンドラインからJAR ファイルを実行します。

java -jar cdata.jdbc.json.jar

接続プロパティを入力し、接続文字列をクリップボードにコピーします。

データソースへの認証については、ヘルプドキュメントの「はじめに」を参照してください。CData 製品は、JSON API を双方向データベーステーブルとして、JSON ファイルを読み取り専用ビュー(ローカル ファイル、一般的なクラウドサービスに保存されているファイル、FTP サーバー)としてモデル化します。HTTP Basic、Digest、NTLM、OAuth、FTP などの主要な認証スキームがサポートされています。詳細はヘルプドキュメントの「はじめに」を参照してください。

URI を設定して認証値を入力したら、DataModel を設定してデータ表現とデータ構造をより厳密に一致させます。

DataModel プロパティは、データをどのようにテーブルに表現するかを制御するプロパティで、次の基本設定を切り替えます。

- Document(デフォルト):JSON データのトップレベルのドキュメントビューをモデル化します。CData 製品 は、ネストされたオブジェクト配列を集約されたJSON オブジェクトとして返します。

- FlattenedDocuments:ネストされた配列オブジェクトと親オブジェクトを、単一テーブルに暗黙的に結合します。

- Relational:階層データから個々の関連テーブルを返します。テーブルには、親ドキュメントにリンクする主キーと外部キーが含まれています。

リレーショナル表現の設定についての詳細は、ヘルプドキュメントの「JSON データのモデリング」を参照してください。また、以下の例で使用されているサンプルデータも確認できます。データには人や所有する車、それらの車に行われたさまざまなメンテナンスサービスのエントリが含まれています。

Amazon S3 内のJSON への接続

URI をバケット内のJSON ドキュメントに設定します。さらに、次のプロパティを設定して認証します。

- AWSAccessKey:AWS アクセスキー(username)に設定。

- AWSSecretKey:AWS シークレットキーに設定。

Box 内のJSON への接続

URI をJSON ファイルへのパスに設定します。Box へ認証するには、OAuth 認証標準を使います。 認証方法については、Box への接続 を参照してください。

Dropbox 内のJSON への接続

URI をJSON ファイルへのパスに設定します。Dropbox へ認証するには、OAuth 認証標準を使います。 認証方法については、Dropbox への接続 を参照してください。ユーザーアカウントまたはサービスアカウントで認証できます。ユーザーアカウントフローでは、以下の接続文字列で示すように、ユーザー資格情報の接続プロパティを設定する必要はありません。 URI=dropbox://folder1/file.json; InitiateOAuth=GETANDREFRESH; OAuthClientId=oauthclientid1; OAuthClientSecret=oauthcliensecret1; CallbackUrl=http://localhost:12345;

SharePoint Online SOAP 内のJSON への接続

URI をJSON ファイルを含むドキュメントライブラリに設定します。認証するには、User、Password、およびStorageBaseURL を設定します。

SharePoint Online REST 内のJSON への接続

URI をJSON ファイルを含むドキュメントライブラリに設定します。StorageBaseURL は任意です。指定しない場合、ドライバーはルートドライブで動作します。 認証するには、OAuth 認証標準を使用します。

FTP 内のJSON への接続

URI をJSON ファイルへのパスが付いたサーバーのアドレスに設定します。認証するには、User およびPassword を設定します。

Google Drive 内のJSON への接続

デスクトップアプリケーションからのGoogle への認証には、InitiateOAuth をGETANDREFRESH に設定して、接続してください。詳細はドキュメントの「Google Drive への接続」を参照してください。

Apache NiFi でのバッチ操作(INSERT/UPDATE/DELETE)

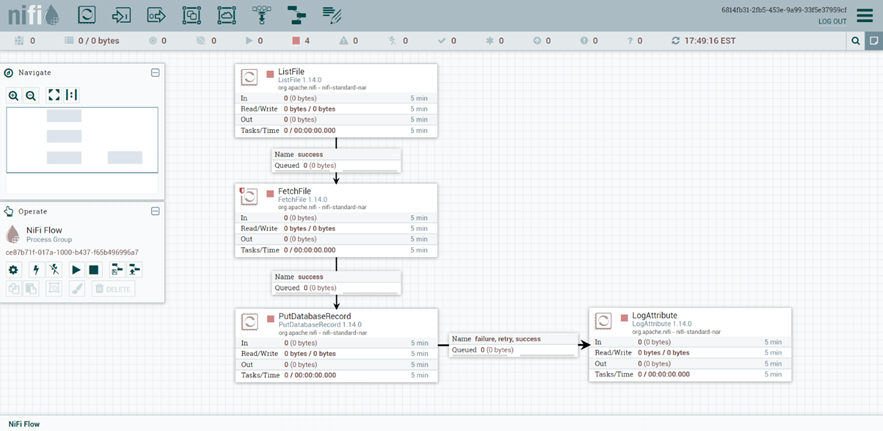

以下のサンプルフローは、次のNiFi プロセッサに基づいています:

- ListFile - ローカルファイルシステムからファイルリストを取得し、取得した各ファイルにFlowFile を作成します。

- FetchFile - ListFile プロセッサから受け取ったFlowFile のコンテンツを読み取ります。

- PutDatabaseRecord - 指定されたRecordReader を使用して、FetchFile プロセッサからのフローファイルからレコードを入力します。これらのレコードはSQL 文に変換され、単一のトランザクションとして実行されます。

- LogAttribute - 指定されたログレベルでFlowFile の属性を出力します。

完成したフローは以下のようになります:

注意事項

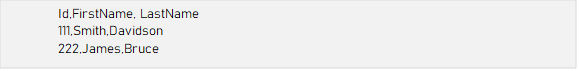

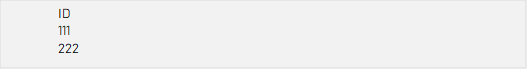

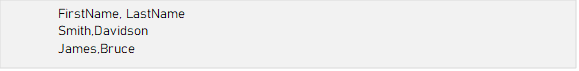

1. CSV ファイルのカラム名は、挿入/更新/削除するデータソーステーブルのレコードのカラム名と一致する必要があります。

2. Apache NiFi バージョン1.9.0 より前のバージョンでは、PutDatabaseRecord プロセッサの Maximum Batch Size プロパティがサポートされていません。

設定

バッチINSERT、UPDATE、またはDELETE を実行するには、NiFi プロセッサを以下のように設定します:

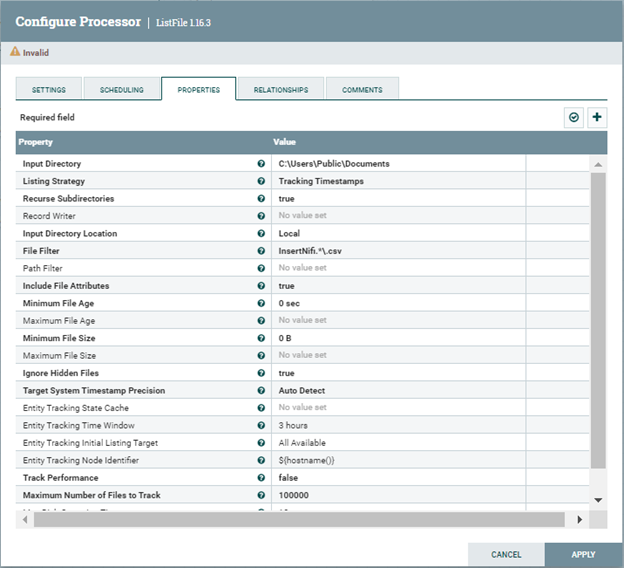

- ListFile プロセッサの設定:Input Directory プロパティを、CSV ファイルを取得するローカルフォルダパスに設定します。 File Filter プロパティを、名前が式に一致するファイルのみを選択する正規表現に設定します。 例:CSV ファイルのフルパスがC:\Users\Public\Documents\InsertNiFi.csv の場合、プロパティは以下の画像のように設定します:

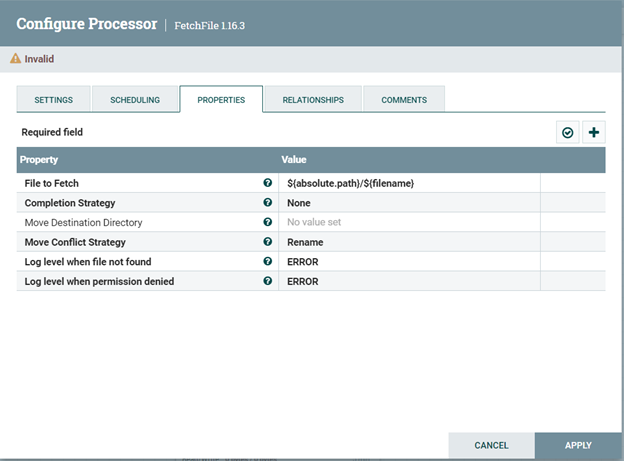

- FetchFile プロセッサの設定 FetchFile プロセッサのプロパティ設定はデフォルト値のままにします:

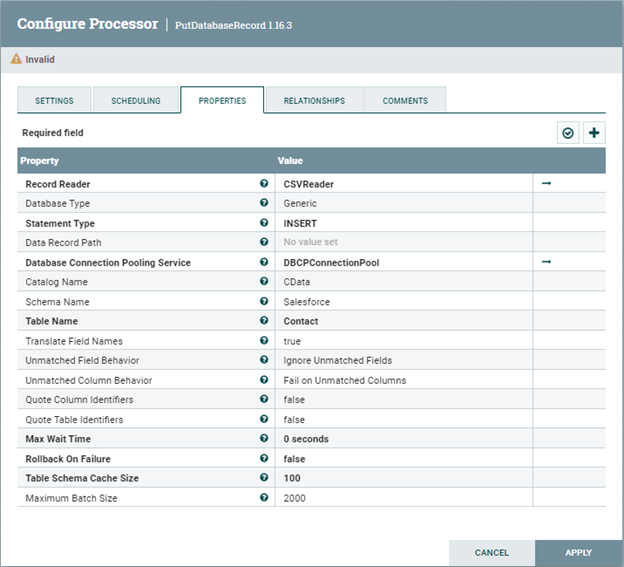

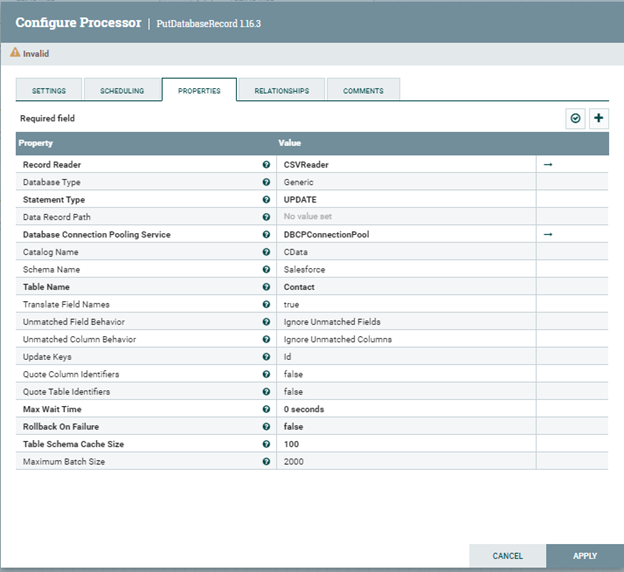

- PutDatabaseRecord プロセッサの設定

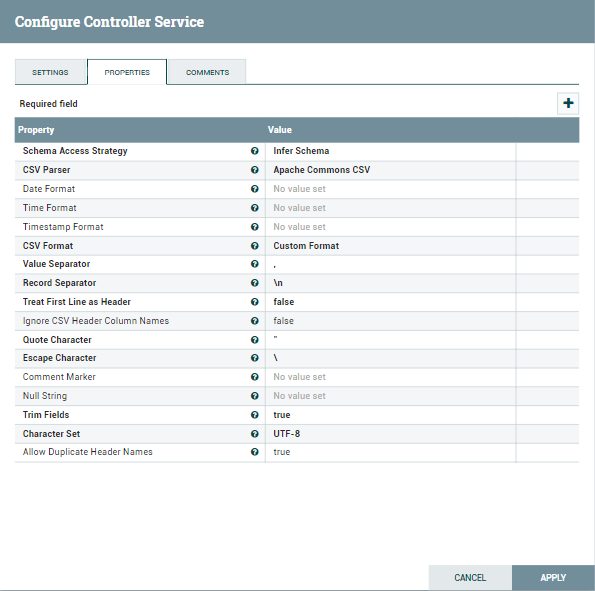

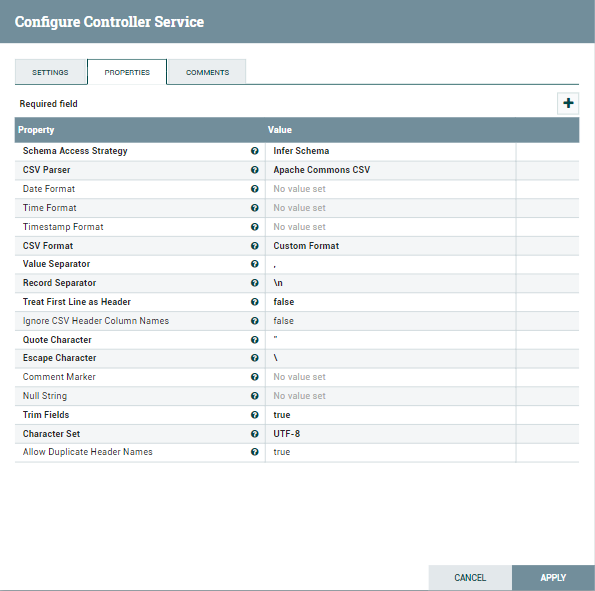

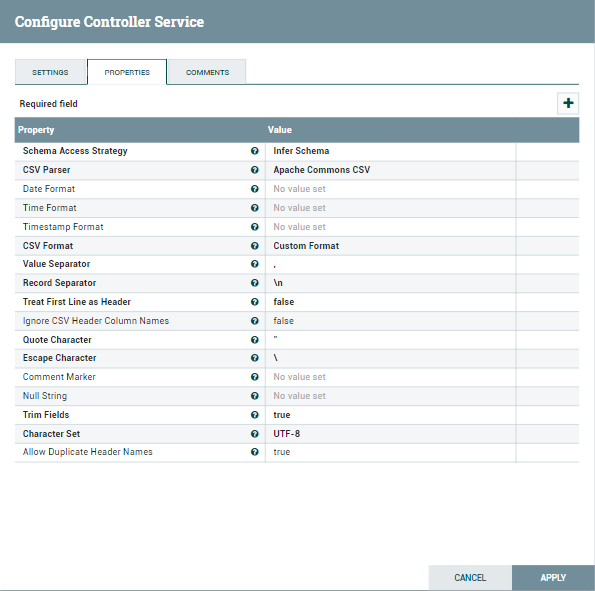

- Record Reader プロパティをCSV Reader Controller Service に設定します。CSV Reader Controller Service を、CSV ファイルの形式に合わせて設定します。

- Statement Type プロパティをINSERT に設定します。

-

Database Connection Pooling Service を、ドライバー設定を保持するDBCPConnection Pool に設定します。ドライバーはBulk API を使用するように設定する必要があります。

プロパティ 値 Database Connection URL jdbc:json:URI=C:/people.json;DataModel=Relational; Database Driver Class Name cdata.jdbc.json.JSONDriver - Catalog Name プロパティを、テーブルが属するカタログの名前に設定します。

- Schema Name プロパティを、テーブルが属するスキーマの名前に設定します。

- Table Name プロパティを、INSERT 先のテーブル名に設定します。

-

Maximum Batch Size プロパティを、単一のバッチに含めるレコードの最大数に設定します。

-

Record Reader プロパティをCSV Reader Controller Service に設定します。CSV Reader Controller Service を、CSV ファイルの形式に合わせて設定します。

- Statement Type プロパティをUPDATE に設定します。

- Database Connection Pooling Service を、ドライバー設定を保持するDBCPConnection Pool に設定します。ドライバーはBulk API を使用するように設定する必要があります。上記と同じDatabase Connection URL 形式を使用します。

- Catalog Name プロパティを、テーブルが属するカタログの名前に設定します。

- Schema Name プロパティを、テーブルが属するスキーマの名前に設定します。

- Table Name プロパティを、UPDATE 対象のテーブル名に設定します。

- Update Keys プロパティを、UPDATE に必要なカラム名に設定します。

-

Maximum Batch Size プロパティを、単一のバッチに含めるレコードの最大数に設定します。

-

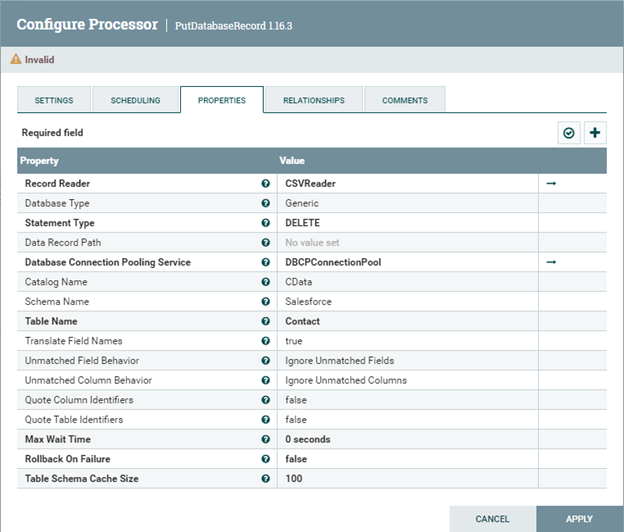

Record Reader プロパティをCSV Reader Controller Service に設定します。CSV Reader Controller Service を、CSV ファイルの形式に合わせて設定します。

- Statement Type プロパティをDELETE に設定します。

- Database Connection Pooling Service を、ドライバー設定を保持するDBCPConnection Pool に設定します。ドライバーはBulk API を使用するように設定する必要があります。上記と同じDatabase Connection URL 形式を使用します。

- Catalog Name プロパティを、テーブルが属するカタログの名前に設定します。

- Schema Name プロパティを、テーブルが属するスキーマの名前に設定します。

- Table Name プロパティを、UPDATE 対象のテーブル名に設定します。

- INSERT やUPDATE のStatement Type とは異なり、DELETE 操作ではMaximum Batch Size プロパティは表示されません。ただし、操作は引き続きバッチで処理されます。変更しない場合、バッチあたりの最大レコード数はデフォルト値の2000 です。DELETE 操作で使用するMaximum Batch Size の値を変更するには、Statement Type をINSERT またはUPDATE に変更し、Maximum Batch Size プロパティの値を変更して「Apply Changes」をクリックします。最後に、プロセッサの設定を再度開き、Statement Type をDELETE に戻して「Apply Changes」をクリックします。

-

LogAttribute プロセッサの設定

最後に、LogAttribute プロセッサを設定して、ユースケースに基づいてログに記録または無視する属性とログレベルを指定します。

INSERT 操作

バッチINSERT 操作を実行するには、PutDatabaseRecord プロセッサを以下のように設定します:

UPDATE 操作

バッチUPDATE 操作を実行するには、PutDatabaseRecord プロセッサを以下のように設定します:

DELETE 操作

バッチDELETE 操作を実行するには、PutDatabaseRecord プロセッサを以下のように設定します:

無償トライアルと詳細情報

CData JDBC Driver for JSON の30日間無償トライアルをダウンロードして、Apache NiFi でリアルタイムJSON servicesの操作をはじめましょう。ご不明な点があれば、サポートチームにお問い合わせください。