Kafka のデータでGoogle Sheets を拡張

マクロ、カスタム関数、アドオンを使用してGoogle スプレッドシートからKafka のデータとやり取りします。CData API Server は、ADO.NET Provider for ApacheKafka(またはその他の250+ ADO.NET Providers)と組み合わせることで、Google Sheets のようなクラウドベースのモバイルアプリケーションからKafka のデータに接続できるようになります。API Server は、Kafka およびCData ADO.NET Providers にサポートされるすべてのソースのOData サービスを生成する軽量のWeb アプリケーションです。

Google Apps Script(GAS)は、これらのOData サービスをJSON 形式で利用できます。この記事では、Google スプレッドシートにSampleTable_1 データを取り込み、変更を加えたときにKafka のデータの更新を実行するシンプルなアドオンを作成する方法を説明します。

API Server の設定

以下のリンクからAPI Server の無償トライアルをスタートしたら、セキュアなKafka OData サービスを作成していきましょう。

Kafka への接続

GAS からKafka のデータを操作するには、まずKafka への接続を作成・設定します。

- API Server にログインして、「Connections」をクリック、さらに「接続を追加」をクリックします。

- 「接続を追加」をクリックして、データソースがAPI Server に事前にインストールされている場合は、一覧から「Kafka」を選択します。

- 事前にインストールされていない場合は、コネクタを追加していきます。コネクタ追加の手順は以下の記事にまとめてありますので、ご確認ください。

CData コネクタの追加方法はこちら >> - それでは、Kafka への接続設定を行っていきましょう!

-

Apache Kafka 接続プロパティの取得・設定方法

それでは、Apache Kafka に接続していきましょう。.NET ベースのエディションは、Confluent.Kafka およびlibrdkafka ライブラリに依存して機能します。 これらのアセンブリはインストーラーにバンドルされており、CData 製品と一緒に自動的にインストールされます。 別のインストール方法をご利用の場合は、NuGet から依存関係のあるConfluent.Kafka 2.6.0をインストールしてください。

Apache Kafka サーバーのアドレスを指定するには、BootstrapServers パラメータを使用します。

デフォルトでは、CData 製品はデータソースとPLAINTEXT で通信しており、これはすべてのデータが暗号化なしで送信されることを意味します。 通信を暗号化したい場合は、以下の設定を行ってください:

- UseSSL をtrue に設定し、CData 製品がSSL 暗号化を使用するように構成します

- SSLServerCert およびSSLServerCertType を設定して、サーバー証明書をロードします

Apache Kafka への認証

続いて、認証方法を設定しましょう。Apache Kafka データソースでは、以下の認証方法をサポートしています:

- Anonymous

- Plain

- SCRAM ログインモジュール

- SSL クライアント証明書

- Kerberos

Anonymous 認証

Apache Kafka の特定のオンプレミスデプロイメントでは、認証接続プロパティを設定することなくApache Kafka に接続できます。 このような接続はanonymous(匿名)と呼ばれます。

匿名認証を行うには、以下のプロパティを設定してください。

- AuthScheme:None

その他の認証方法については、ヘルプドキュメントをご確認ください。

- 接続情報の入力が完了したら、「保存およびテスト」をクリックします。

Apache Kafka 接続プロパティの取得・設定方法

それでは、Apache Kafka に接続していきましょう。.NET ベースのエディションは、Confluent.Kafka およびlibrdkafka ライブラリに依存して機能します。 これらのアセンブリはインストーラーにバンドルされており、CData 製品と一緒に自動的にインストールされます。 別のインストール方法をご利用の場合は、NuGet から依存関係のあるConfluent.Kafka 2.6.0をインストールしてください。

Apache Kafka サーバーのアドレスを指定するには、BootstrapServers パラメータを使用します。

デフォルトでは、CData 製品はデータソースとPLAINTEXT で通信しており、これはすべてのデータが暗号化なしで送信されることを意味します。 通信を暗号化したい場合は、以下の設定を行ってください:

- UseSSL をtrue に設定し、CData 製品がSSL 暗号化を使用するように構成します

- SSLServerCert およびSSLServerCertType を設定して、サーバー証明書をロードします

Apache Kafka への認証

続いて、認証方法を設定しましょう。Apache Kafka データソースでは、以下の認証方法をサポートしています:

- Anonymous

- Plain

- SCRAM ログインモジュール

- SSL クライアント証明書

- Kerberos

Anonymous 認証

Apache Kafka の特定のオンプレミスデプロイメントでは、認証接続プロパティを設定することなくApache Kafka に接続できます。 このような接続はanonymous(匿名)と呼ばれます。

匿名認証を行うには、以下のプロパティを設定してください。

- AuthScheme:None

その他の認証方法については、ヘルプドキュメントをご確認ください。

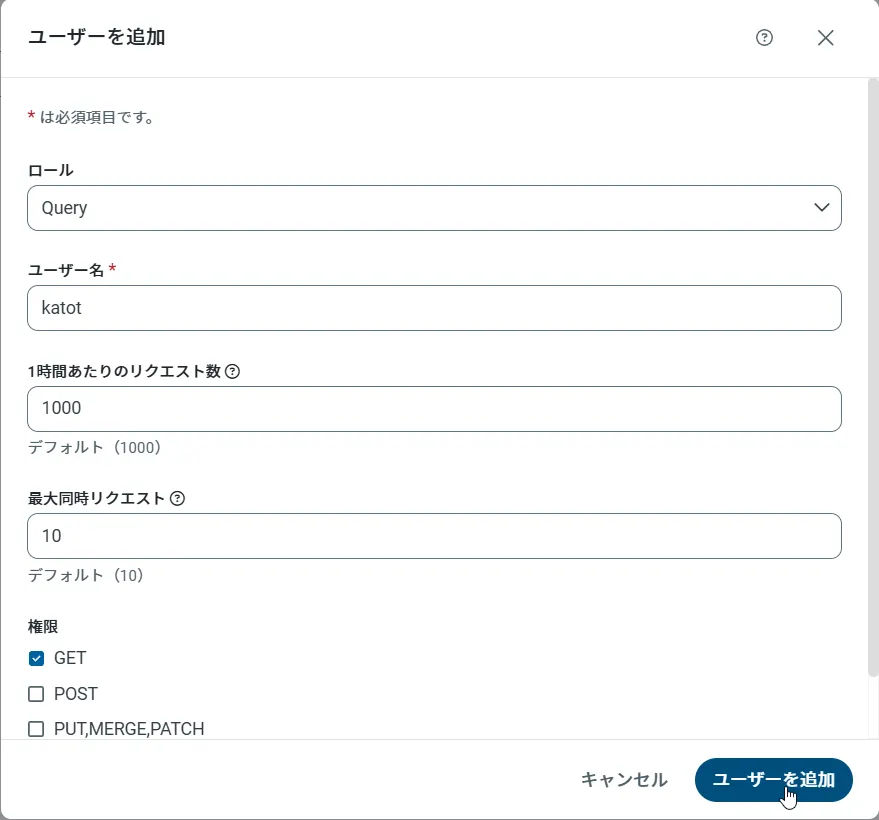

API Server のユーザー設定

次に、API Server 経由でKafka にアクセスするユーザーを作成します。「Users」ページでユーザーを追加・設定できます。やってみましょう。

- 「Users」ページで ユーザーを追加をクリックすると、「ユーザーを追加」ポップアップが開きます。

-

次に、「ロール」、「ユーザー名」、「権限」プロパティを設定し、「ユーザーを追加」をクリックします。

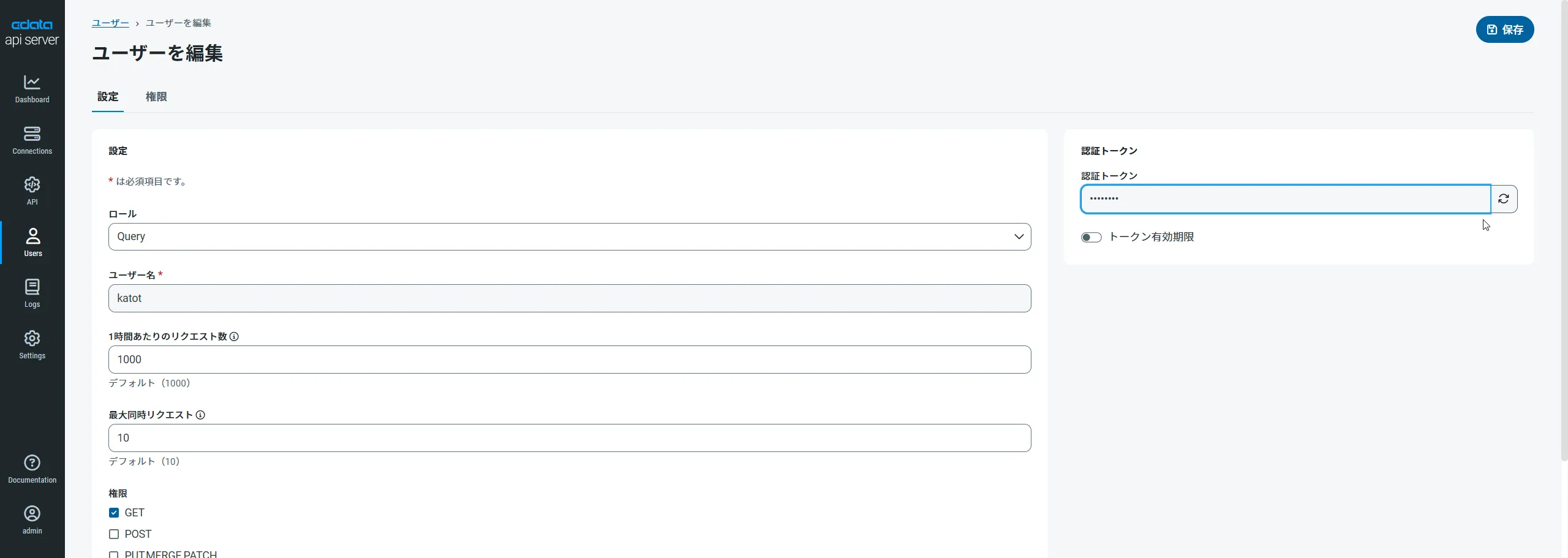

-

その後、ユーザーの認証トークンが生成されます。各ユーザーの認証トークンとその他の情報は「Users」ページで確認できます。

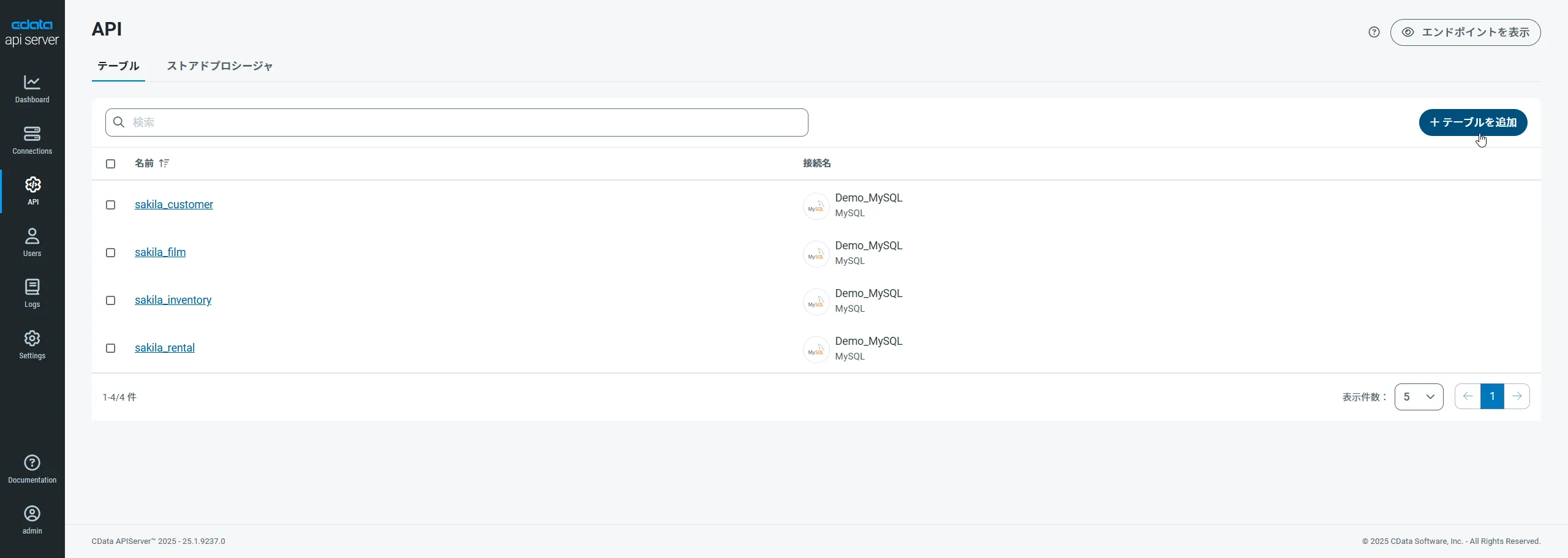

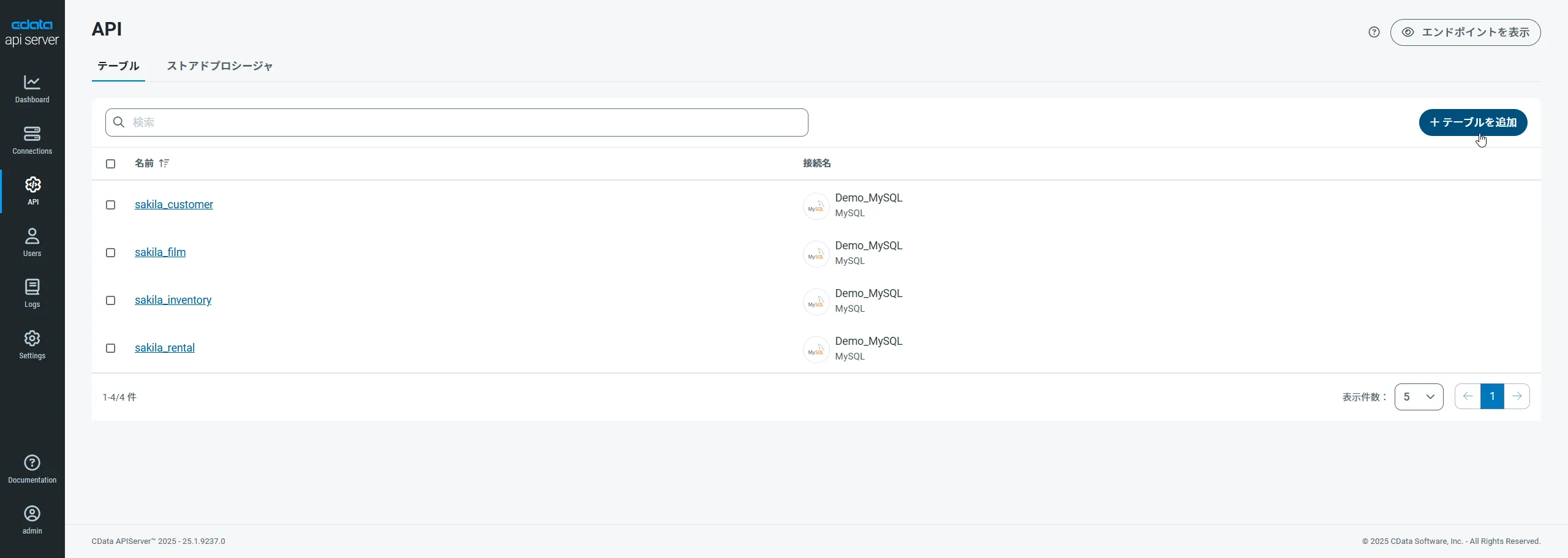

Kafka 用のAPI エンドポイントの作成

ユーザーを作成したら、Kafka のデータ用のAPI エンドポイントを作成していきます。

-

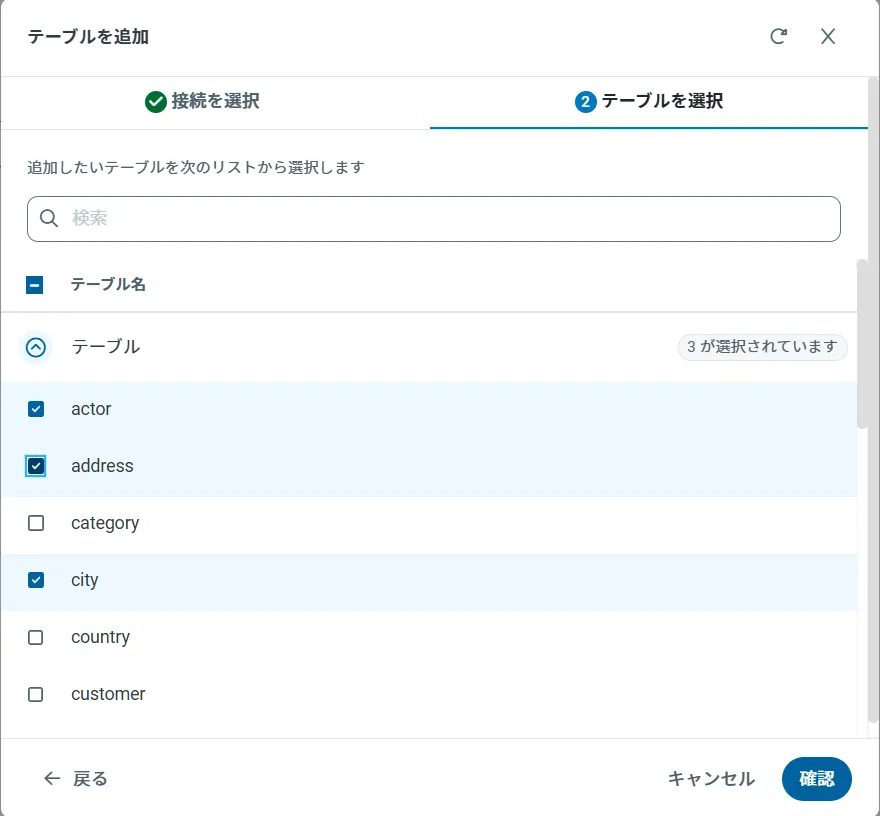

まず、「API」ページに移動し、

「 テーブルを追加」をクリックします。

-

アクセスしたい接続を選択し、次へをクリックします。

-

接続を選択した状態で、各テーブルを選択して確認をクリックすることでエンドポイントを作成します。

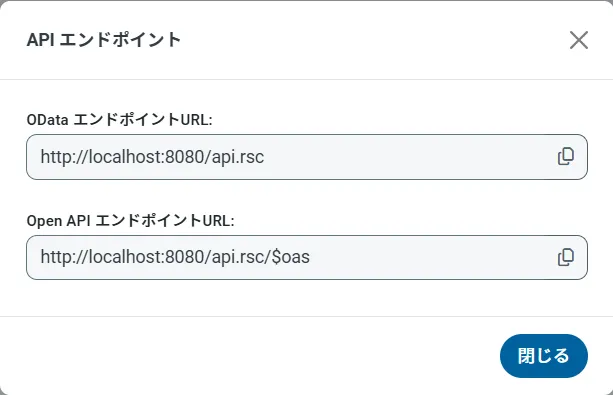

OData のエンドポイントを取得

以上でKafka への接続を設定してユーザーを作成し、API Server でKafka データのAPI を追加しました。これで、OData 形式のKafka データをREST API で利用できます。API Server の「API」ページから、API のエンドポイントを表示およびコピーできます。

Kafka のデータを取得する

「Tools」->「Script Editor」とクリックして、スプレッドシートからScript Editor を開きます。Script Editor で次の機能を追加し、スプレッドシートにOData クエリの結果を入力します。

function retrieve(){

var url = "https://MyUrl/api.rsc/SampleTable_1?select=Id,Id,Column1,Column2";

var response = UrlFetchApp.fetch(url,{

headers: {"Authorization":"Basic " + Utilities.base64Encode("MyUser:MyAuthtoken")}

});

var json = response.getContentText();

var sheet = SpreadsheetApp.getActiveSheet();

var a1 = sheet.getRange('a1');

var index=1;

var sampletable_1 = JSON.parse(json).value;

var cols = [["Id","Id","Column1","Column2"]];

sheet.getRange(1,1,1,4).setValues(cols);

row=2;

for(var i in sampletable_1){

for (var j in sampletable_1[i]) {

switch (j) {

case "Id":

a1.offset(row,0).setValue(account[i][j]);

break;

case "Id":

a1.offset(row,1).setValue(account[i][j]);

break;

case "Column1":

a1.offset(row,2).setValue(account[i][j]);

break;

case "Column2":

a1.offset(row,3).setValue(account[i][j]);

break;

}

}

row++;

}

}

次のステップに従って、開いたタイミングでスプレッドシートに入力するインストール可能なトリガーを追加します。

- 「Resources」->「Current Project's Triggers」->「Add a New Trigger」とクリックします。

- 「Run」メニューで「retrieve」を選択します。

- 「From Spreadsheet」を選択します。

- 「On open」を選択します。

ダイアログを閉じると、アプリケーションへのアクセスを許可するように要求されます。

Kafka のデータへの変更を追加する

以下の関数を追加し、セルへの変更をAPI Server に追加します。

function buildReq(e){

var sheet = SpreadsheetApp.getActiveSheet();

var changes = e.range;

var id = sheet.getRange(changes.getRow(),1).getValue();

var col = sheet.getRange(1,changes.getColumn()).getValue();

var url = "http://MyServer/api.rsc/SampleTable_1("+id+")";

var putdata = "{\"@odata.type\" : \"CDataAPI.SampleTable_1\", \""+col+"\": \""+changes.getValue()+"\"}";;

UrlFetchApp.fetch(url,{

method: "put",

contentType: "application/json",

payload: putdata,

headers: {"Authorization":"Basic " + Utilities.base64Encode("MyUser:MyAuthtoken")}

});

}

下記の手順に従って、アップデートトリガーを追加します。

- 「Resources」->「Current Project's Triggers」とクリックします。

- 「Run」メニューで「buildReqe」を選択します。

- 「From Spreadsheet」を選択します。

- 「On edit」を選択します。

「Publish」->「Test as Add-On」とクリックすることで、スクリプトを確認できます。バージョン、インストールタイプ、およびスプレッドシートを選択し、テストの構成を作成します。作成したら、選択して実行できます。

セルを変更すると、API Server はKafka のデータのアップデートを実行します。