Google Data Fusion で Lakebase に連携した ETL プロセスを作成

Google Data Fusion を使用すると、セルフサービス型のデータ連携を行い、異なるデータソースを統合できます。CData JDBC Driver for Lakebase をアップロードすることで、Google Data Fusion のパイプライン内から Lakebase のデータ にリアルタイムでアクセスできるようになります。CData JDBC Driver を使用すると、Lakebase のデータ を Google Data Fusion でネイティブにサポートされている任意のデータソースにパイプできますが、この記事では、Lakebase から Google BigQuery へデータをパイプする方法を説明します。

CData JDBC Driver for Lakebase を Google Data Fusion にアップロード

CData JDBC Driver for Lakebase を Google Data Fusion インスタンスにアップロードして、Lakebase のデータ にリアルタイムでアクセスしましょう。Google Data Fusion では JDBC ドライバーの命名規則に制限があるため、JAR ファイルを driver-version.jar という形式に合わせてコピーまたはリネームしてください。例:cdatalakebase-2020.jar

- Google Data Fusion インスタンスを開きます

- をクリックしてエンティティを追加し、ドライバーをアップロードします

- "Upload driver" タブで、リネームした JAR ファイルをドラッグまたは参照します。

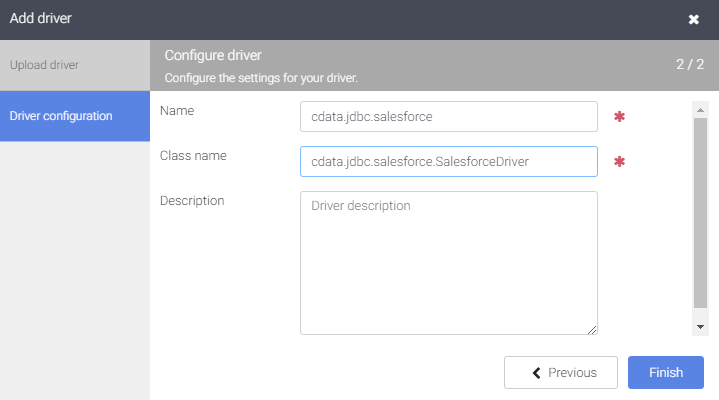

- "Driver configuration" タブで以下を設定します:

- Name: ドライバーの名前(cdata.jdbc.lakebase)を作成し、メモしておきます

- Class name: JDBC クラス名を設定します:(cdata.jdbc.lakebase.LakebaseDriver)

- "Finish" をクリックします

Google Data Fusion で Lakebase のデータ に接続

JDBC Driver をアップロードしたら、Google Data Fusion のパイプラインで Lakebase のデータ にリアルタイムでアクセスできます。

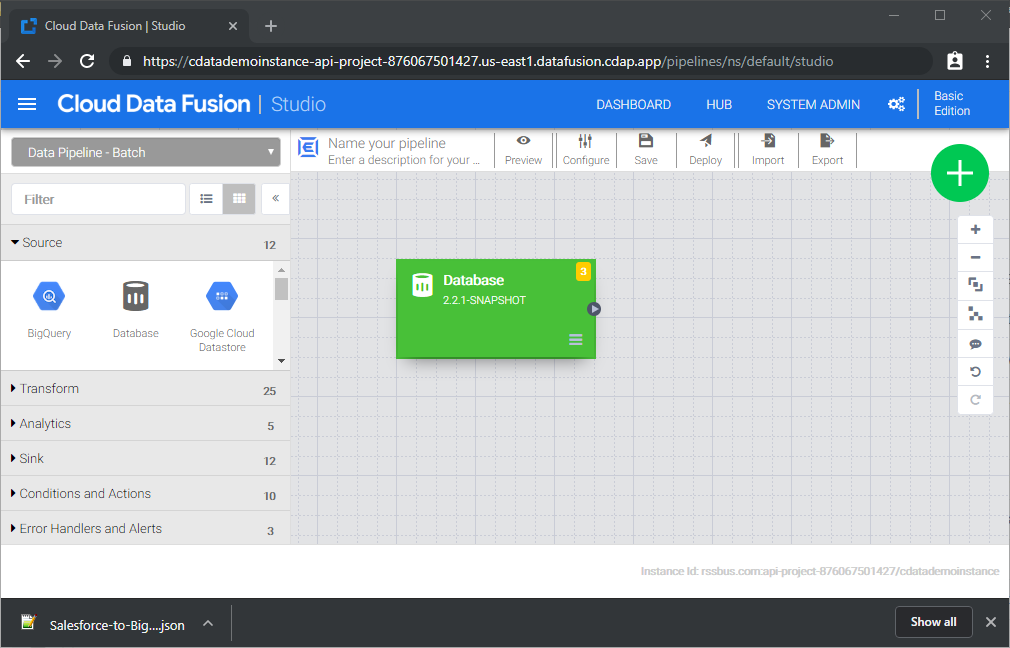

- Pipeline Studio に移動して、新しいパイプラインを作成します

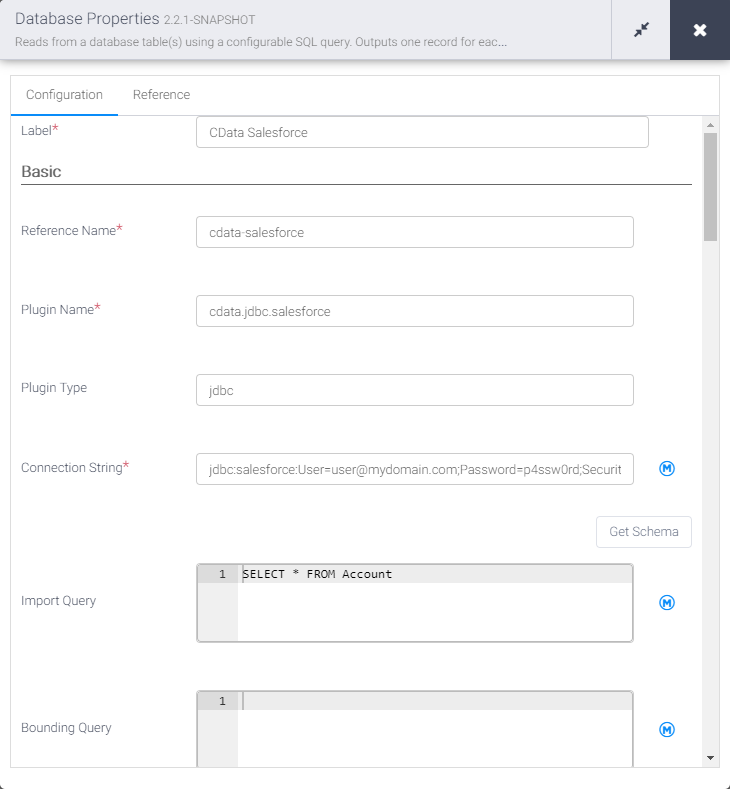

- "Source" オプションから "Database" をクリックして、JDBC Driver 用のソースを追加します

- Database ソースの "Properties" をクリックしてプロパティを編集します

NOTE:Google Data Fusion で JDBC Driver を使用するには、ライセンス(製品版またはトライアル)とランタイムキー(RTK)が必要です。ライセンス(またはトライアル)の取得については、CData までお問い合わせください。

- Label を設定します

- Reference Name を将来の参照用の値に設定します(例:cdata-lakebase)

- Plugin Type を "jdbc" に設定します

- Connection String を Lakebase の JDBC URL に設定します。例:

jdbc:lakebase:RTK=5246...;DatabricksInstance=lakebase;Server=127.0.0.1;Port=5432;Database=my_database;Databricks Lakebase に接続するには、以下のプロパティを設定します。

- DatabricksInstance: Databricks インスタンスまたはサーバーホスト名を指定します。形式は instance-abcdef12-3456-7890-abcd-abcdef123456.database.cloud.databricks.com です。

- Server: Lakebase データベースをホストするサーバーのホスト名または IP アドレスを指定します。

- Port(オプション): Lakebase データベースをホストするサーバーのポート番号を指定します。デフォルトは 5432 です。

- Database(オプション): Lakebase サーバーへの認証後に接続するデータベースを指定します。デフォルトでは認証ユーザーのデフォルトデータベースに接続します。

OAuth クライアント認証

OAuth クライアント資格情報を使用して認証するには、サービスプリンシパルで OAuth クライアントを構成します。手順の概要は以下のとおりです。

- 新しいサービスプリンシパルを作成・構成する

- サービスプリンシパルに権限を割り当てる

- サービスプリンシパル用の OAuth シークレットを作成する

詳細については、ヘルプドキュメントの「Setting Up OAuthClient Authentication」セクションをご参照ください。

OAuth PKCE 認証

PKCE(Proof Key for Code Exchange)を使用した OAuth code タイプで認証するには、以下のプロパティを設定します。

- AuthScheme: OAuthPKCE を指定します。

- User: 認証ユーザーのユーザー ID を指定します。

詳細については、ヘルプドキュメントをご参照ください。

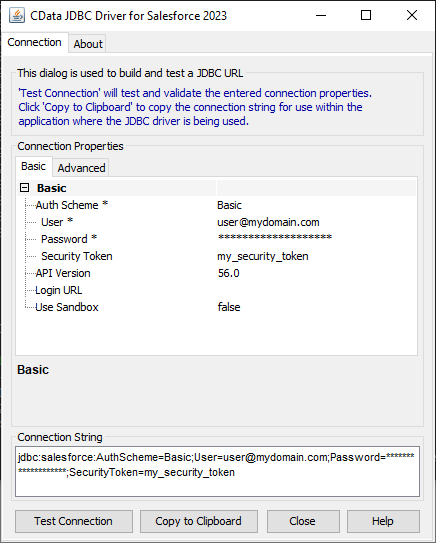

ビルトイン接続文字列デザイナー

JDBC URL の作成には、Lakebase JDBC Driver に組み込まれている接続文字列デザイナーを使用できます。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行してください。

java -jar cdata.jdbc.lakebase.jar接続プロパティを入力し、接続文字列をクリップボードにコピーします。

- Import Query を Lakebase から取得したいデータを抽出する SQL クエリに設定します。例:

SELECT * FROM Orders

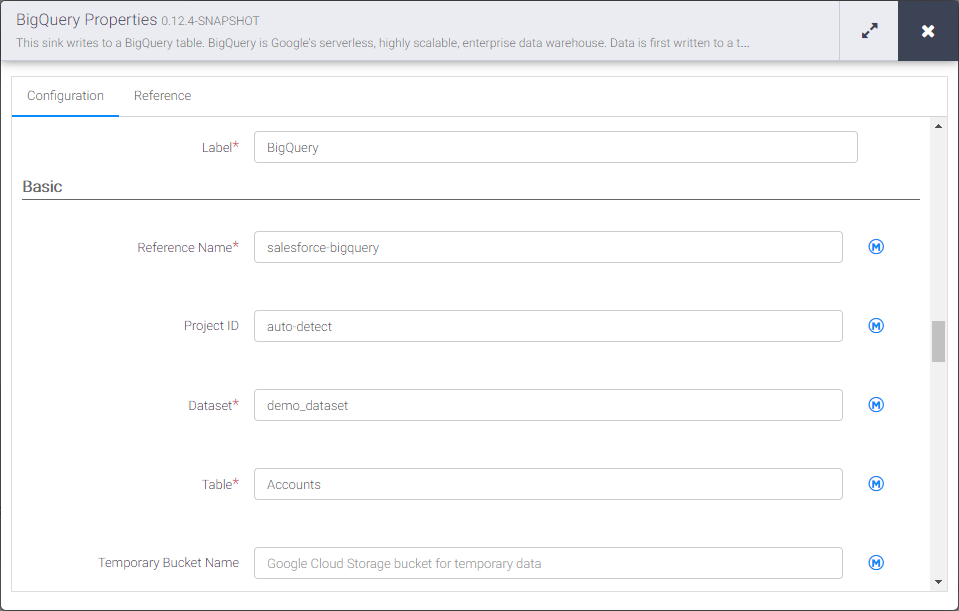

- "Sink" タブから、同期先シンクを追加します(この例では Google BigQuery を使用します)

- BigQuery シンクの "Properties" をクリックしてプロパティを編集します

- Label を設定します

- Reference Name を lakebase-bigquery のような値に設定します

- Project ID を特定の Google BigQuery プロジェクト ID に設定します(またはデフォルトの "auto-detect" のままにします)

- Dataset を特定の Google BigQuery データセットに設定します

- Table を Lakebase のデータ を挿入するテーブル名に設定します

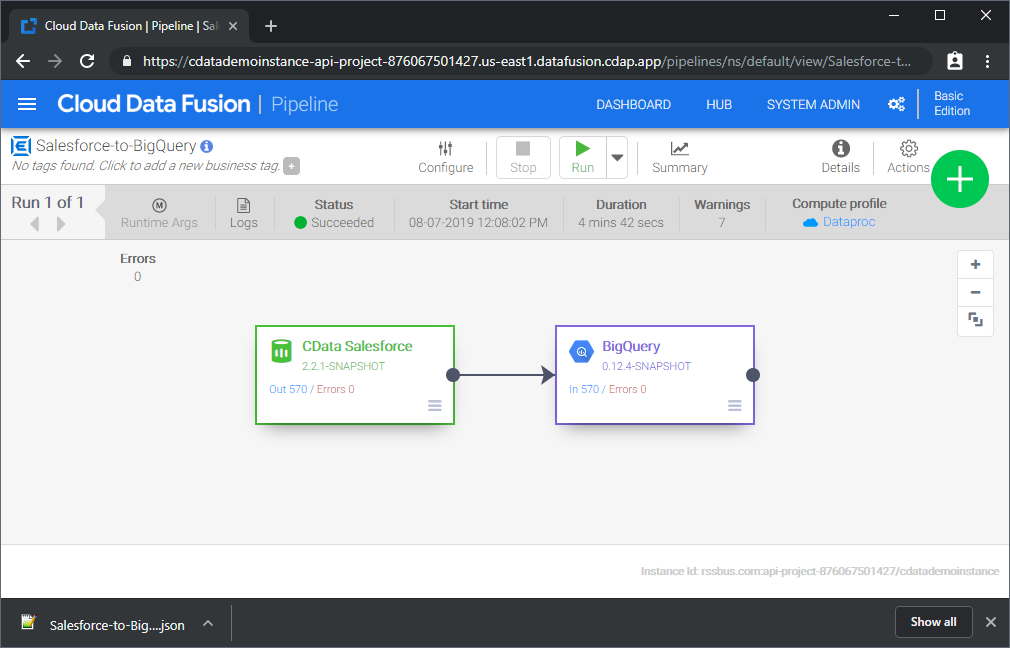

Source と Sink を設定すると、Lakebase のデータ を Google BigQuery にパイプする準備が整います。パイプラインを保存してデプロイしてください。パイプラインを実行すると、Google Data Fusion が Lakebase からリアルタイムデータをリクエストし、Google BigQuery にインポートします。

これはシンプルなパイプラインの例ですが、変換、分析、条件などを使用してより複雑な Lakebase パイプラインを作成できます。CData JDBC Driver for Lakebase の 30日間の無償トライアルをダウンロードして、今すぐ Google Data Fusion で Lakebase のデータ をリアルタイムで活用しましょう。