CData Connect AI を使用して Databricks でリアルタイムの Redshift データに接続・クエリ

Databricks は、データエンジニアリング、機械学習、アナリティクスを大規模に統合する AI クラウドネイティブプラットフォームです。 データウェアハウスのパフォーマンスとデータレイクの柔軟性を兼ね備えた強力なデータレイクハウスアーキテクチャを提供しています。 Databricks を CData Connect AI と統合すると、 複雑な ETL パイプラインやデータの複製を必要とせず、Redshift のデータ にリアルタイムでアクセスでき、 運用の効率化とインサイトまでの時間短縮を実現できます。

この記事では、CData Connect AI を使用して Databricks から Redshift へのセキュアなライブ接続を設定する方法を説明します。 設定が完了すると、標準 SQL を使用して Databricks ノートブックから直接Redshift のデータにアクセスでき、 データエコシステム全体でリアルタイム分析を統合できます。

概要

シンプルなステップの概要は以下のとおりです:

- ステップ 1 - 接続と設定: CData Connect AI で Redshift ソースへの接続を作成し、ユーザー権限を設定して、 Personal Access Token(PAT)を生成します。

- ステップ 2 - Databricks からクエリ: Databricks に CData JDBC ドライバーをインストールし、ノートブックに接続情報を設定して、 SQL クエリでリアルタイムのRedshift のデータにアクセスします。

前提条件

始める前に、以下を準備してください:

- アクティブな Redshift アカウント

- CData Connect AI アカウント。ログインまたは 無料トライアルにサインアップできます。

- Databricks アカウント。こちらからサインアップまたはログインできます。

ステップ 1:CData Connect AI で Redshift 接続を設定

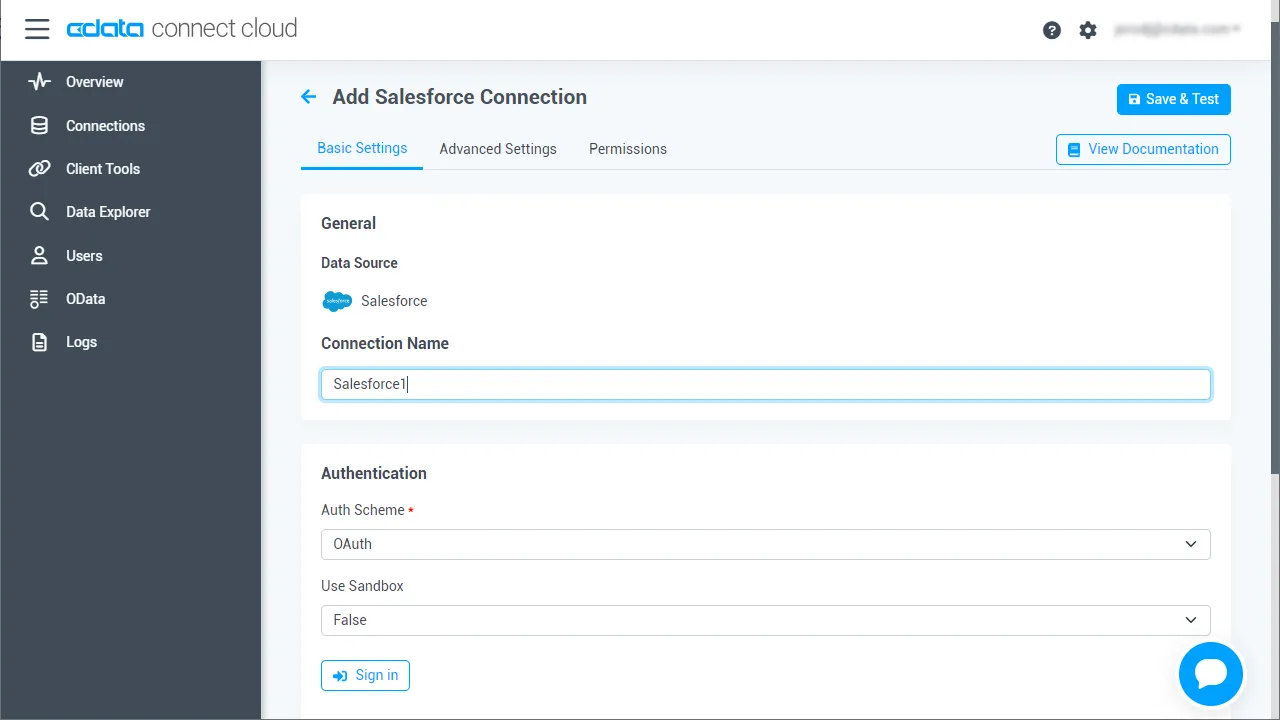

1.1 Redshift への接続を追加

CData Connect AI は、利用可能なデータソースに接続するためのシンプルなポイント&クリックインターフェースを提供しています。

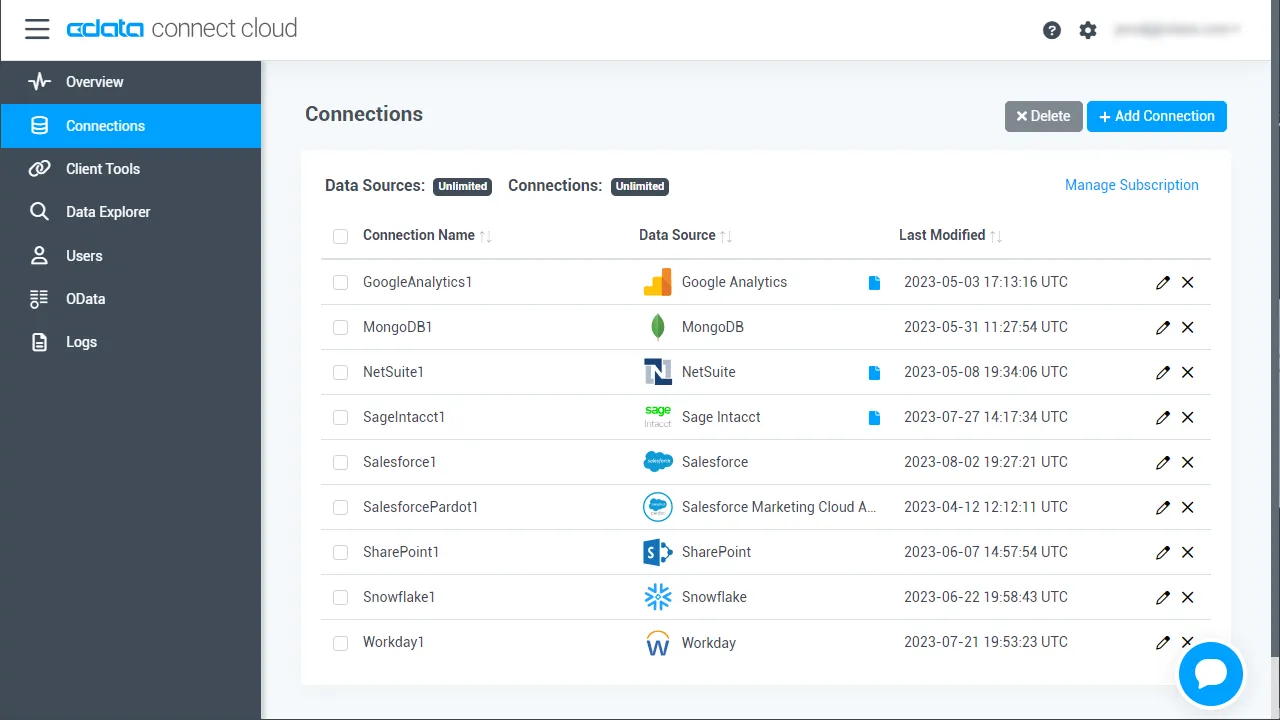

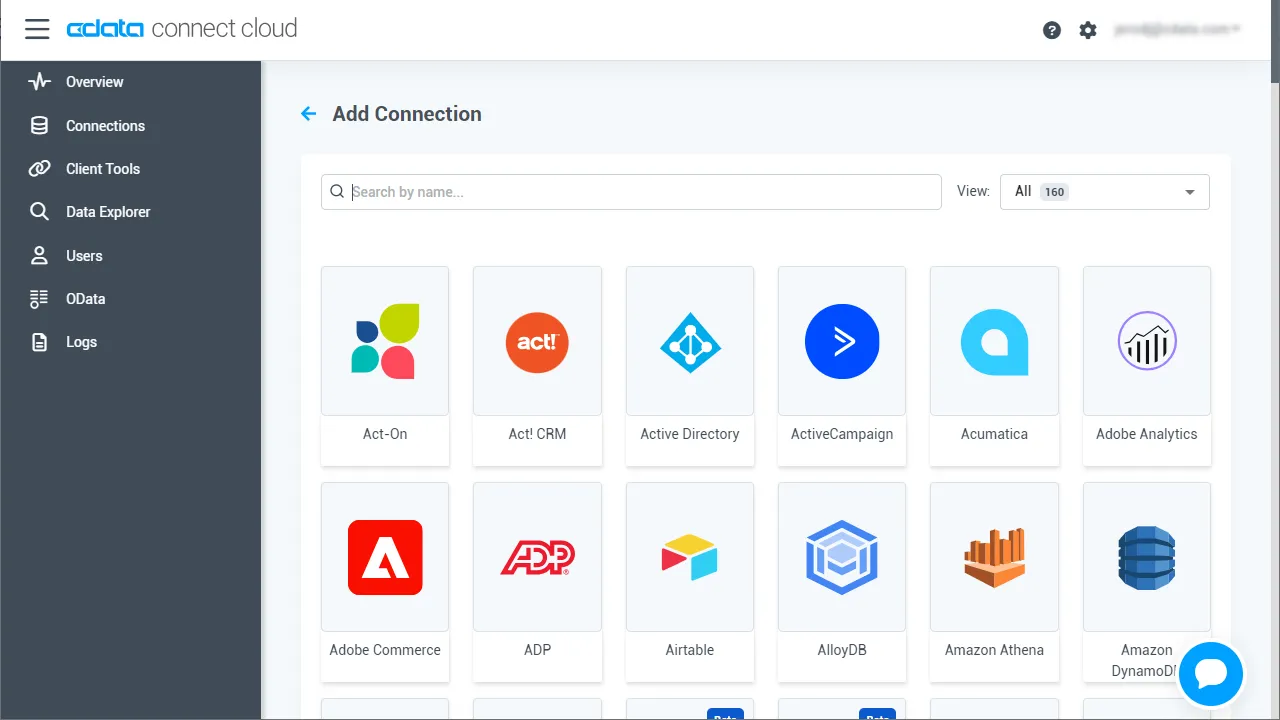

- Connect AI にログインし、左側の Sources をクリックして、 右上の Add Connection をクリック

- Add Connection パネルから 「Redshift」 を選択

-

Redshift に接続するために必要な認証プロパティを入力します。

Amazon Redshift への接続

それでは、早速Amazon Redshift に接続していきましょう。データに接続するには、以下の接続パラメータを指定します。

- Server:Amazon Redshift データベースをホスティングしているサーバーのホスト名またはIP アドレス

- Database:Amazon Redshift クラスター用に作成したデータベース

- Port(オプション):Amazon Redshift データベースをホスティングしているサーバーのポート。デフォルトは5439です

これらの値は、以下のステップでAWS マネージメントコンソールから取得できます。

- Amazon Redshift コンソールを開きます(http://console.aws.amazon.com/redshift)

- Clusters ページで、クラスター名をクリックしてください

- Configuration タブの"Cluster Database Properties" セクションからプロパティを取得します。接続プロパティの値は、ODBC URL で設定された値と同じになります

Amazon Redshiftへの認証

CData 製品では幅広い認証オプションに対応しています。標準認証情報からIAM クレデンシャル、ADFS、Ping Federate、Microsoft Entra ID(Azure AD)、Azure AD PKCE まで利用可能です。標準認証

ログイン資格情報を使用してAmazon Redshift に接続するには、以下のプロパティを設定してみましょう。- AuthScheme:Basic

- User:認証するユーザーのログイン情報

- Password:認証するユーザーのパスワード

その他の認証方法については、ヘルプドキュメントをご確認ください。

- 右上の Save & Test をクリック

-

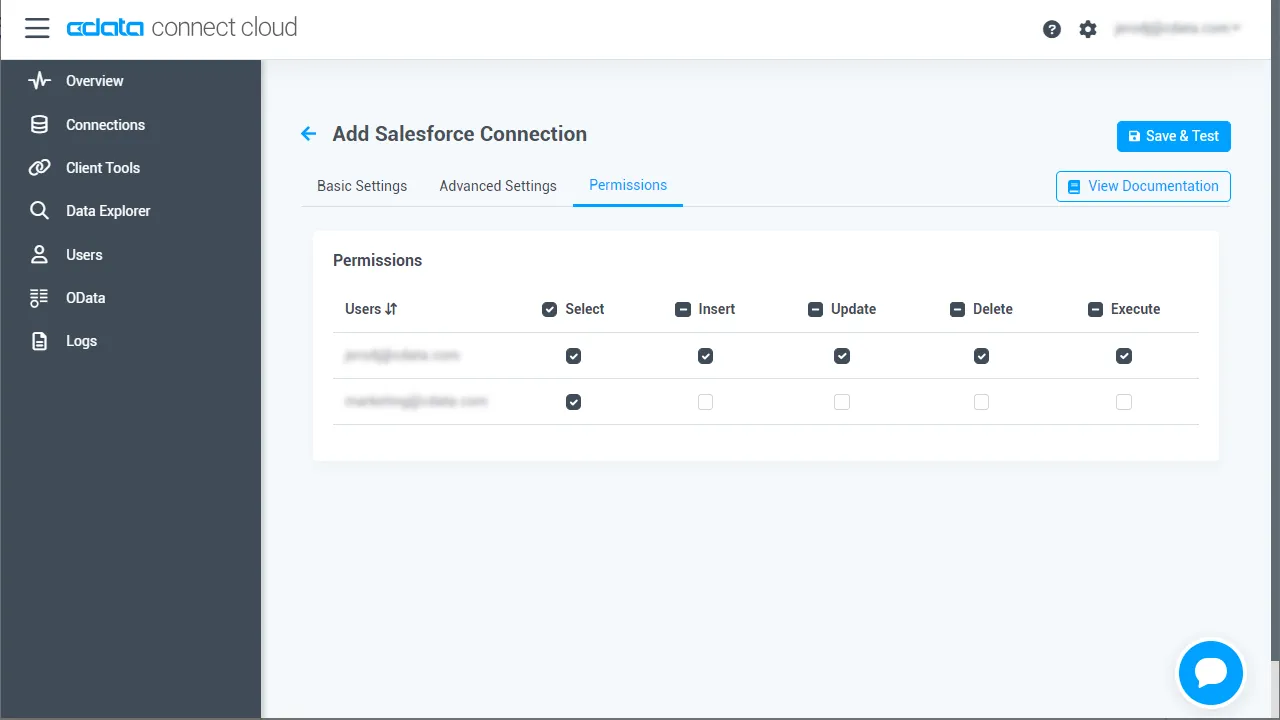

Redshift Connection ページで Permissions タブに移動し、

お好みに応じてユーザーベースの権限を更新します。

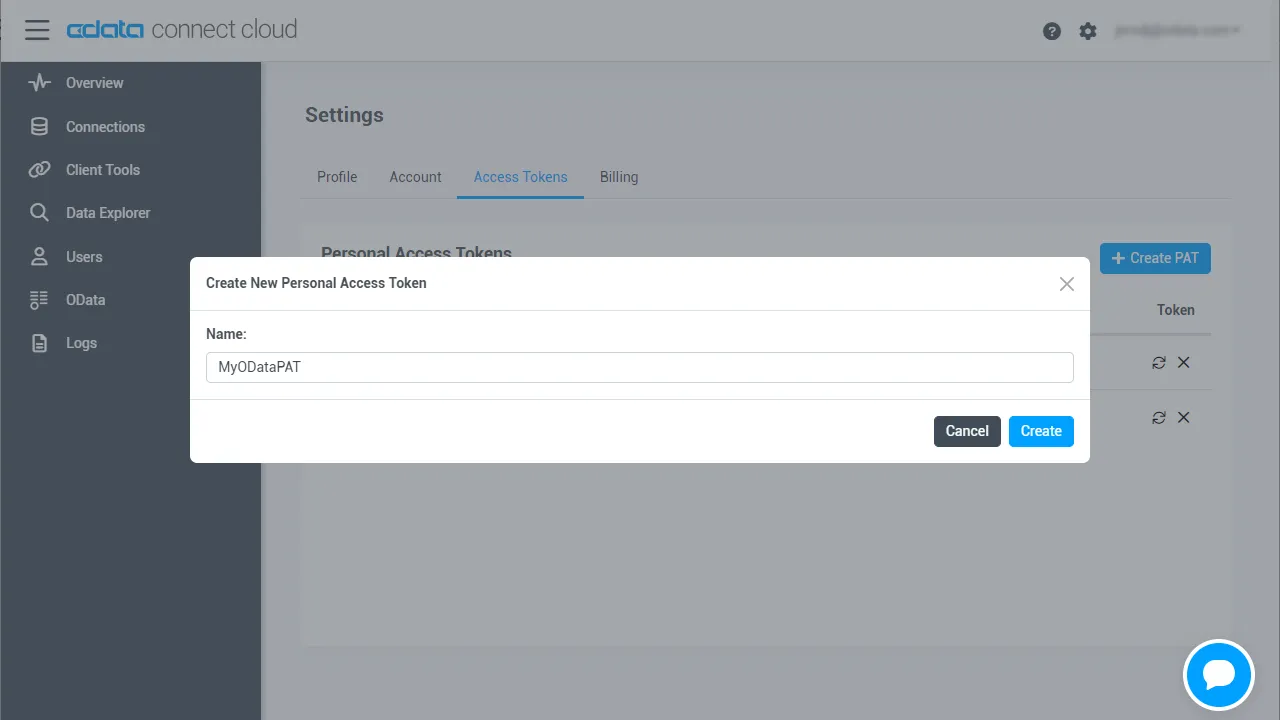

1.2 Personal Access Token(PAT)を生成

REST API、OData API、または仮想 SQL Server 経由で Connect AI に接続する場合、 Personal Access Token(PAT)が Connect AI への接続認証に使用されます。PAT は、セキュアなトークンベースの認証として ログイン認証情報の代わりに機能します。アクセスの粒度を維持するため、 サービスごとに個別の PAT を作成することをお勧めします。

- Connect AI アプリの右上にある歯車アイコン()をクリックして Settings ページを開く

- Settings ページで Access Tokens セクションに移動し、 Create PAT をクリック

-

PAT に名前を付けて Create をクリック

- 注意:Personal Access Token は作成時にのみ表示されるので、必ずコピーして安全な場所に保存してください。

ステップ 2:Databricks で Redshift データに接続・クエリ

以下の手順に従って、Databricks から Redshift への接続を確立します。 CData JDBC Driver for Connect AI をインストールし、JAR ファイルをクラスターに追加して、ノートブックを設定し、 SQL クエリでリアルタイムのRedshift のデータにアクセスします。

2.1 CData JDBC Driver for Connect AI をインストール

- CData Connect AI で、左側の Integrations ページをクリック。 JDBC または Databricks を検索し、Download をクリックして、 お使いの OS 用のインストーラーを選択します。

-

ダウンロード後、インストーラーを実行して指示に従います:

- Windows の場合:セットアップファイルを実行し、インストールウィザードに従います。

- Mac/Linux の場合:アーカイブを解凍し、フォルダを /opt または /Applications に移動します。実行権限があることを確認してください。

-

インストール後、インストールディレクトリで JAR ファイルを見つけます:

- Windows:

C:\Program Files\CData\CData JDBC Driver for Connect AI\lib\cdata.jdbc.connect.jar

- Mac/Linux:

/Applications/CData/CData JDBC Driver for Connect AI/lib/cdata.jdbc.connect.jar

- Windows:

2.2 Databricks に JAR ファイルをインストール

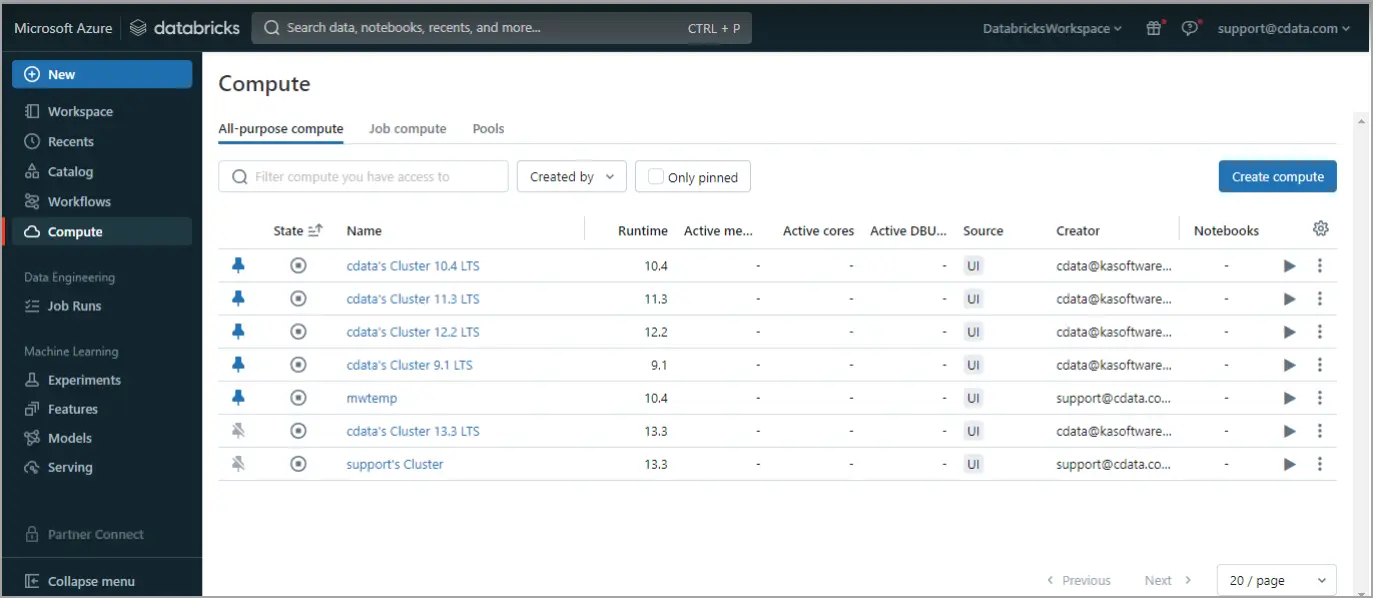

-

Databricks にログイン。左側のナビゲーションペインで Compute をクリック。コンピュートクラスターを開始または作成します。

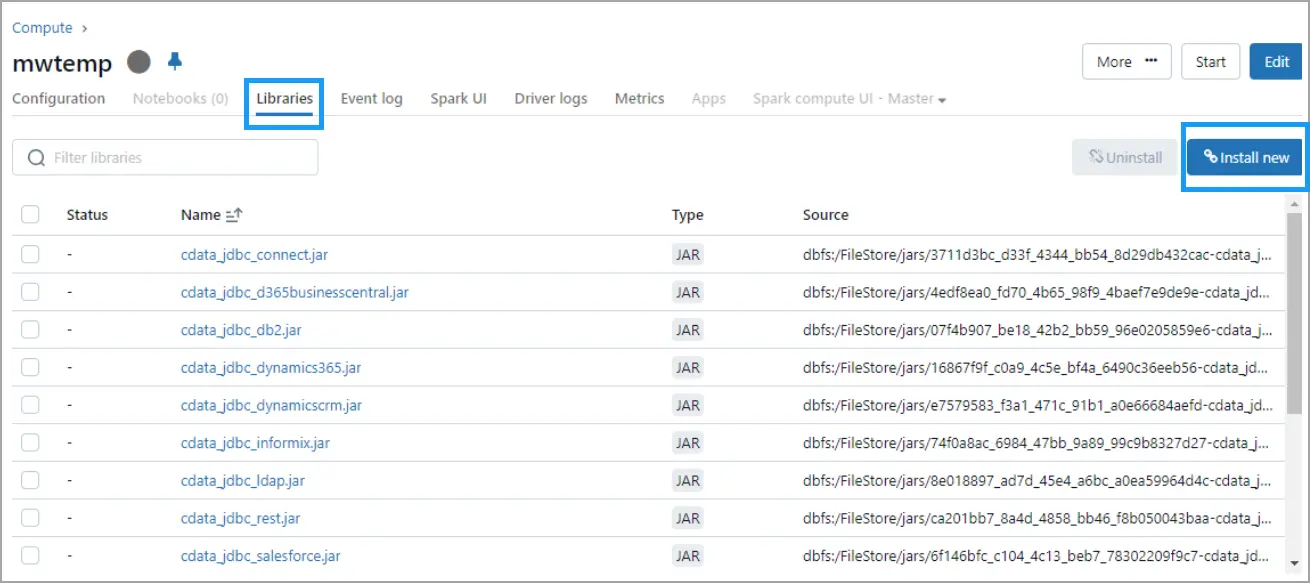

-

実行中のクラスターをクリックし、Libraries タブに移動して、右上の Install New をクリック。

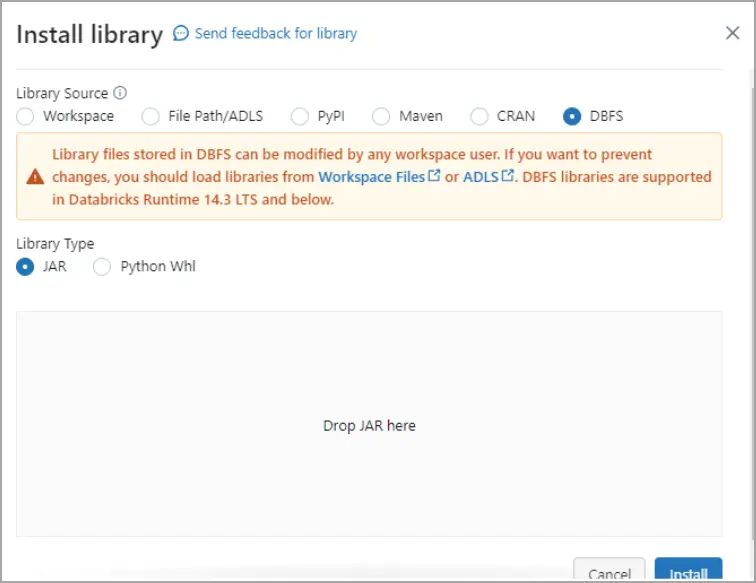

-

Install Library ダイアログで DBFS を選択し、

cdata.jdbc.connect.jar ファイルをドラッグ&ドロップ。Install をクリック。

2.3 Databricks ノートブックで Redshift データをクエリ

ノートブックスクリプト 1 - JDBC 接続を定義:

- 以下のスクリプトをノートブックセルに貼り付けます:

driver = "cdata.jdbc.connect.ConnectDriver" url = "jdbc:connect:AuthScheme=Basic;User=your_username;Password=your_pat;URL=https://cloud.cdata.com/api/;DefaultCatalog=Your_Connection_Name;"

- 以下を置き換えます:

- your_username - CData Connect AI のユーザー名

- your_pat - CData Connect AI の Personal Access Token(PAT)

- Your_Connection_Name - Sources ページの Connect AI データソース名

- スクリプトを実行します。

ノートブックスクリプト 2 -Redshift のデータから DataFrame を読み込み:

- 2 番目のスクリプト用に新しいセルを追加します。ノートブック右側のメニューから Add cell below をクリック。

- 以下のスクリプトを新しいセルに貼り付けます:

remote_table = spark.read.format("jdbc") \

.option("driver", "cdata.jdbc.connect.ConnectDriver") \

.option("url", "jdbc:connect:AuthScheme=Basic;User=your_username;Password=your_pat;URL=https://cloud.cdata.com/api/;DefaultCatalog=Your_Connection_Name;") \

.option("dbtable", "YOUR_SCHEMA.YOUR_TABLE") \

.load()

- 以下を置き換えます:

- your_username - CData Connect AI のユーザー名

- your_pat - CData Connect AI の Personal Access Token(PAT)

- Your_Connection_Name - Sources ページの Connect AI データソース名

- YOUR_SCHEMA.YOUR_TABLE - スキーマとテーブル名(例:Redshift.Orders)

- スクリプトを実行します。

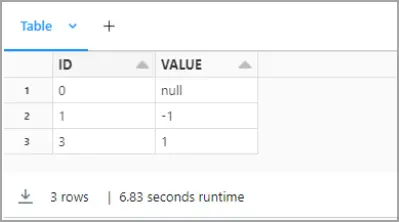

ノートブックスクリプト 3 - カラムをプレビュー:

- 同様に、3 番目のスクリプト用に新しいセルを追加します。

- 以下のスクリプトを新しいセルに貼り付けます:

display(remote_table.select("ColumnName1", "ColumnName2"))

- ColumnName1 と ColumnName2 を Redshift 構造の実際のカラム名に置き換えます(例:ShipName、ShipCity など)。

- スクリプトを実行します。

これで、バックエンド API の複雑さを意識することなく、またRedshift のデータをレプリケーションすることなく、 Databricks ノートブック内で直接リアルタイムの Redshift のデータ を探索、結合、分析できるようになりました。

CData Connect AI を 14 日間無料でお試しください

Redshift のデータへのリアルタイムアクセスを簡素化する準備はできましたか? CData Connect AI の 14 日間無料トライアルを今すぐ開始して、 Databricks から Redshift へのシームレスなライブ接続を体験してください。

ローコード、インフラ不要、レプリケーション不要 - 重要なデータとインサイトへの シームレスでセキュアなアクセスを実現します。