【MCP Server】Gumloop をSpark のデータと連携するフローを作る

Gumloop は、トリガー、AI ノード、API、データコネクタを組み合わせてAI を活用したワークフローを作成できるビジュアル自動化プラットフォームです。Gumloop と CData Connect AI を組み込みの「MCP (Model Context Protocol) Server」を通じて統合することで、ワークフローからライブの にシームレスにアクセスして対話できるようになります。

このプラットフォームはローコード環境を提供しているため、大規模な開発作業なしで複雑なプロセスを簡単にオーケストレーションできます。柔軟性が高く、複数のビジネスアプリケーション間での統合が可能で、ライブデータを使ったエンドツーエンドの自動化を実現します。

CData Connect AI は、Spark のデータに接続するための専用クラウド間インターフェースを提供します。CData Connect AI Remote MCP Server により、Google ADK エージェントと Sparkの間でセキュアな通信が可能になります。これにより、ネイティブ対応データベースへのデータレプリケーションを必要とせずに、エージェントから Spark のデータの読み取りや操作を実行できます。CData Connect AIは最適化されたデータ処理機能を備えており、フィルタや JOIN を含むサポート対象のすべての SQL 操作を効率的に Sparkへ直接送信します。サーバーサイド処理を活用することで、要求されたSpark のデータ を迅速に取得できます。

この記事では、Connect AI での Spark 接続の構成、Gumloop への MCP Serverの登録、そして Spark をクエリするワークフローの構築に必要な手順をご紹介します。

ステップ 1: Gumloop 用のSpark 接続を構成する

それでは早速、Gumloop からSpark への接続を設定していきましょう。Gumloop から Spark と対話するには、まず CData Connect AI で Spark への接続を作成して構成します。

-

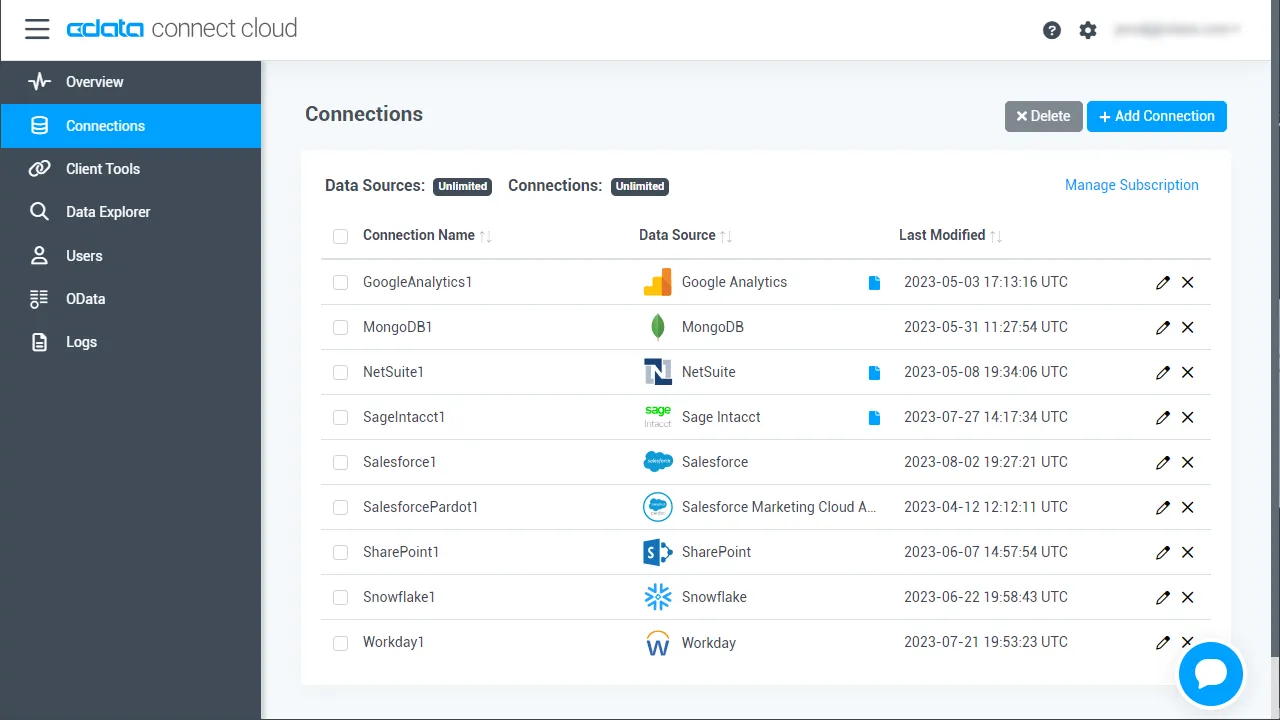

Connect AI にログインし、「Connections」をクリックして「 Add Connection」をクリックします

-

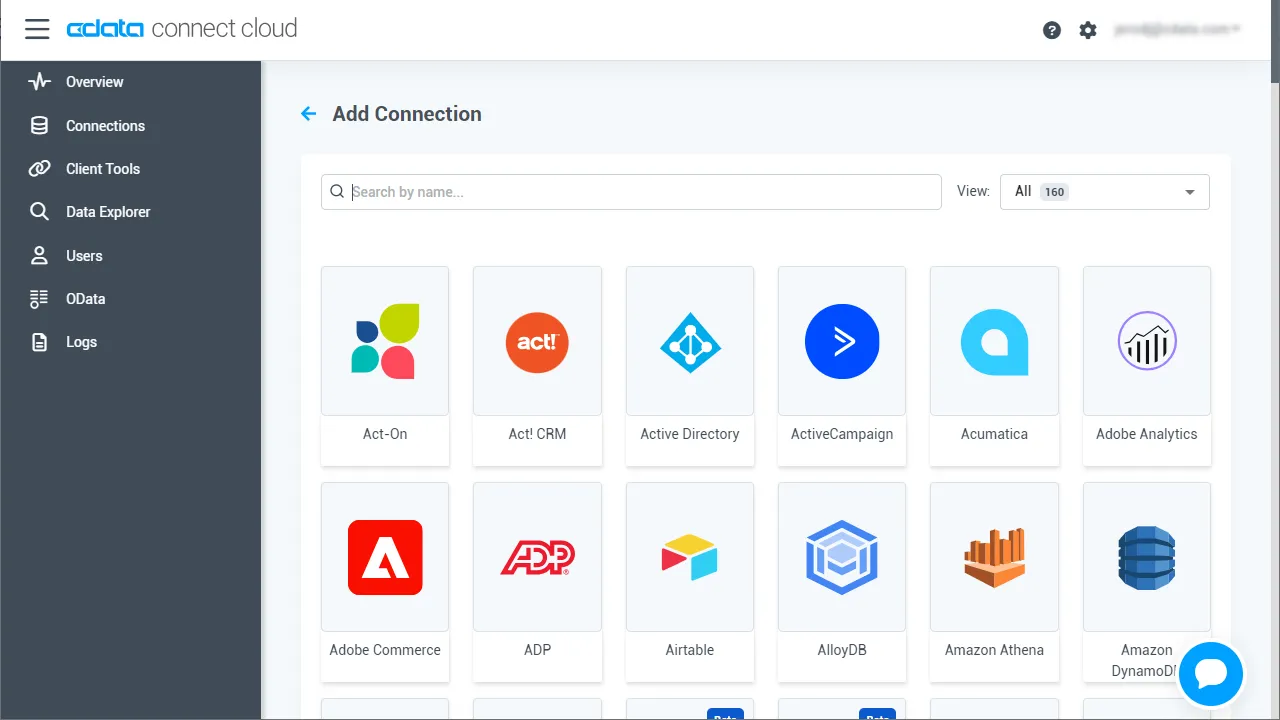

「Add Connection」パネルから「Spark」を選択します

-

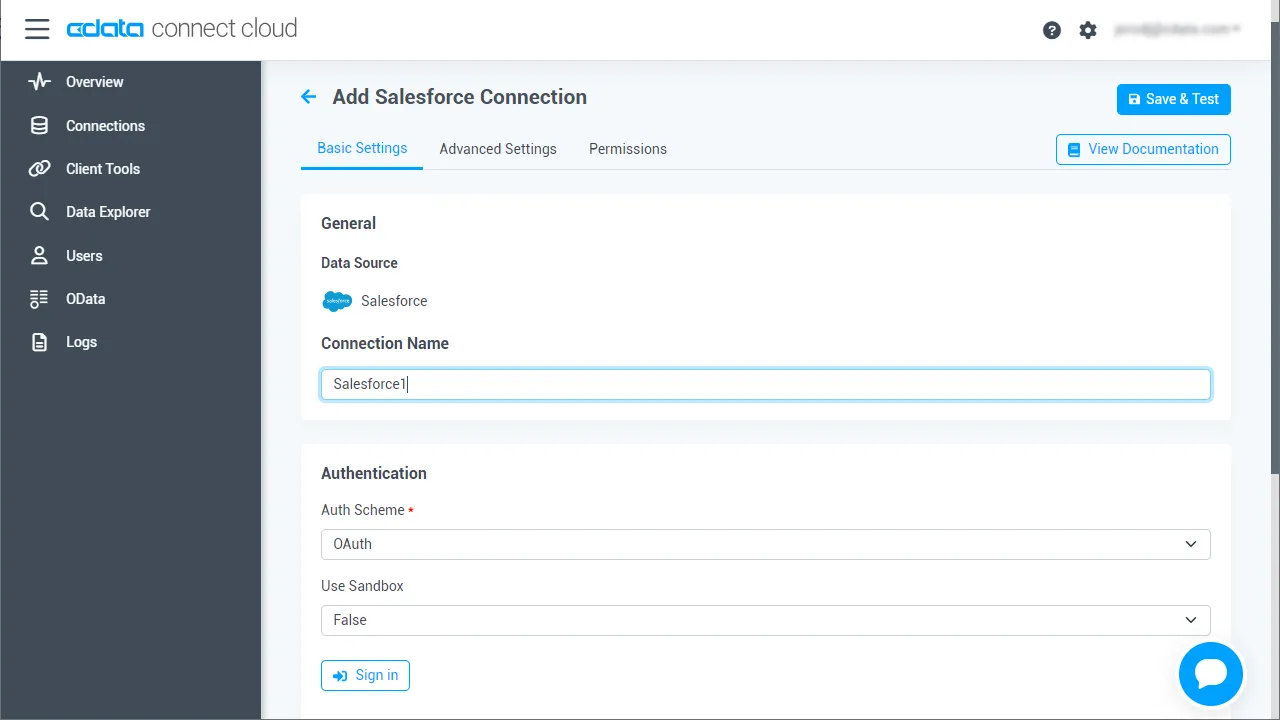

Spark に接続するために必要な認証情報を入力しましょう。

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

「Create & Test」をクリックします

「Create & Test」をクリックします

-

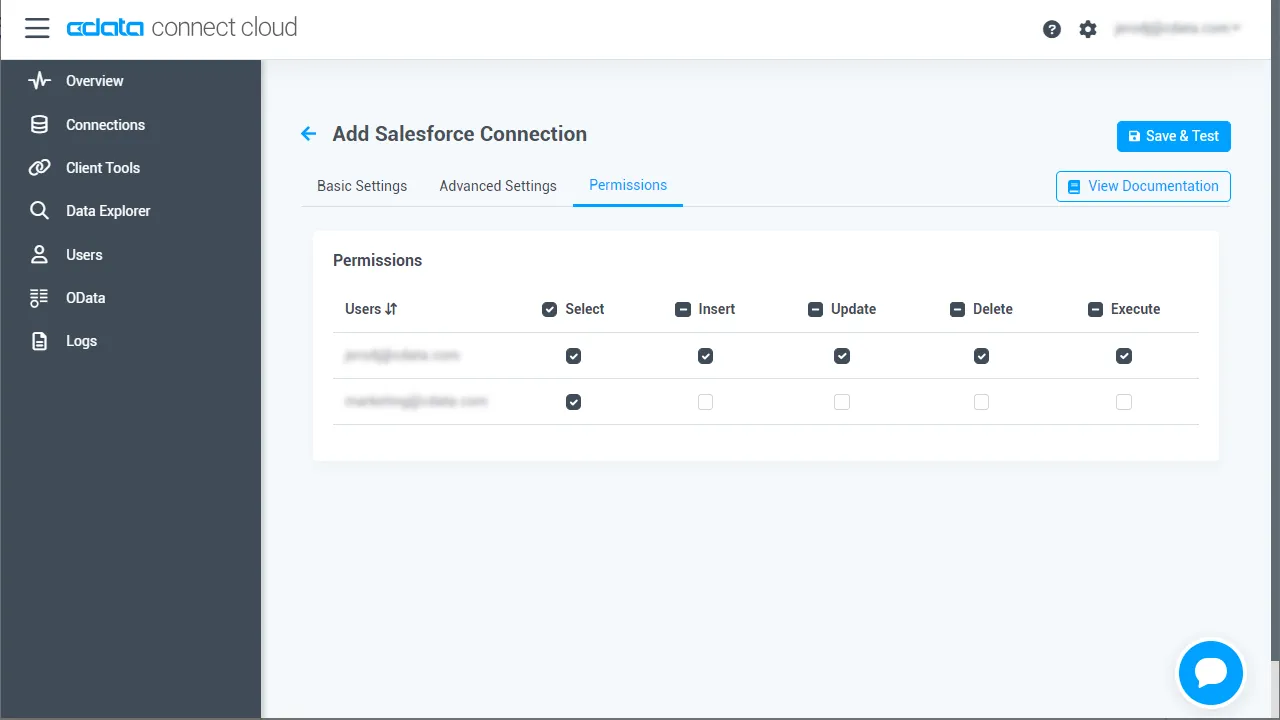

「Add Spark Connection」ページの「Permissions」タブに移動し、ユーザーベースの権限を更新します。

パーソナルアクセストークンを追加する

パーソナルアクセストークン (PAT) は、Gumloop からConnect AI への接続を認証するために使用します。アクセスの粒度を維持するために、サービスごとに個別の PAT を作成することをおすすめします。

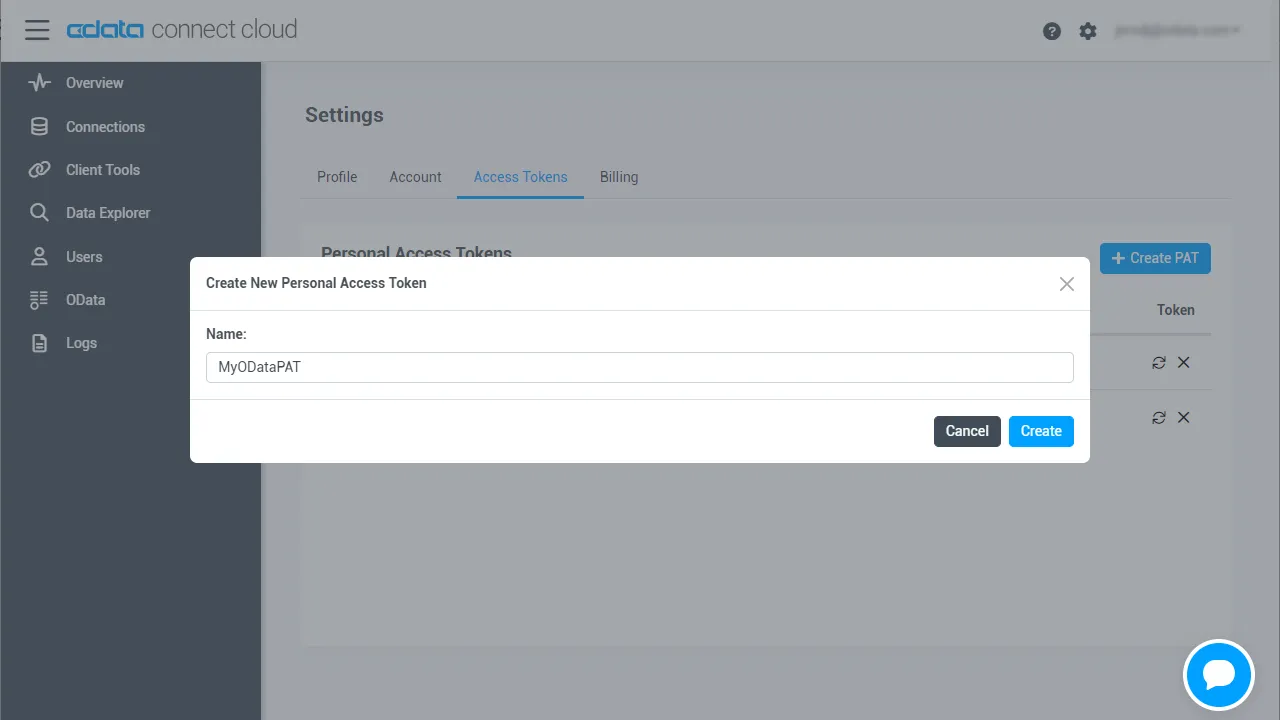

- Connect AI アプリの右上にある歯車アイコン () をクリックして、設定ページを開きます。

- 「Settings」ページで、「Access Tokens」セクションに移動し、 「Create PAT」をクリックします。

-

PAT に名前を付けて「Create」をクリックします。

- パーソナルアクセストークンは作成時にのみ表示されます。必ずコピーして、今後の使用のために安全に保管してください。

これで、Gumloop からSpark に接続する準備が整いました!

ステップ2:Gumloop でMCP Server に接続する

続いて、Connect AI の MCP Server エンドポイントと認証情報をGumloop の認証情報に追加します。

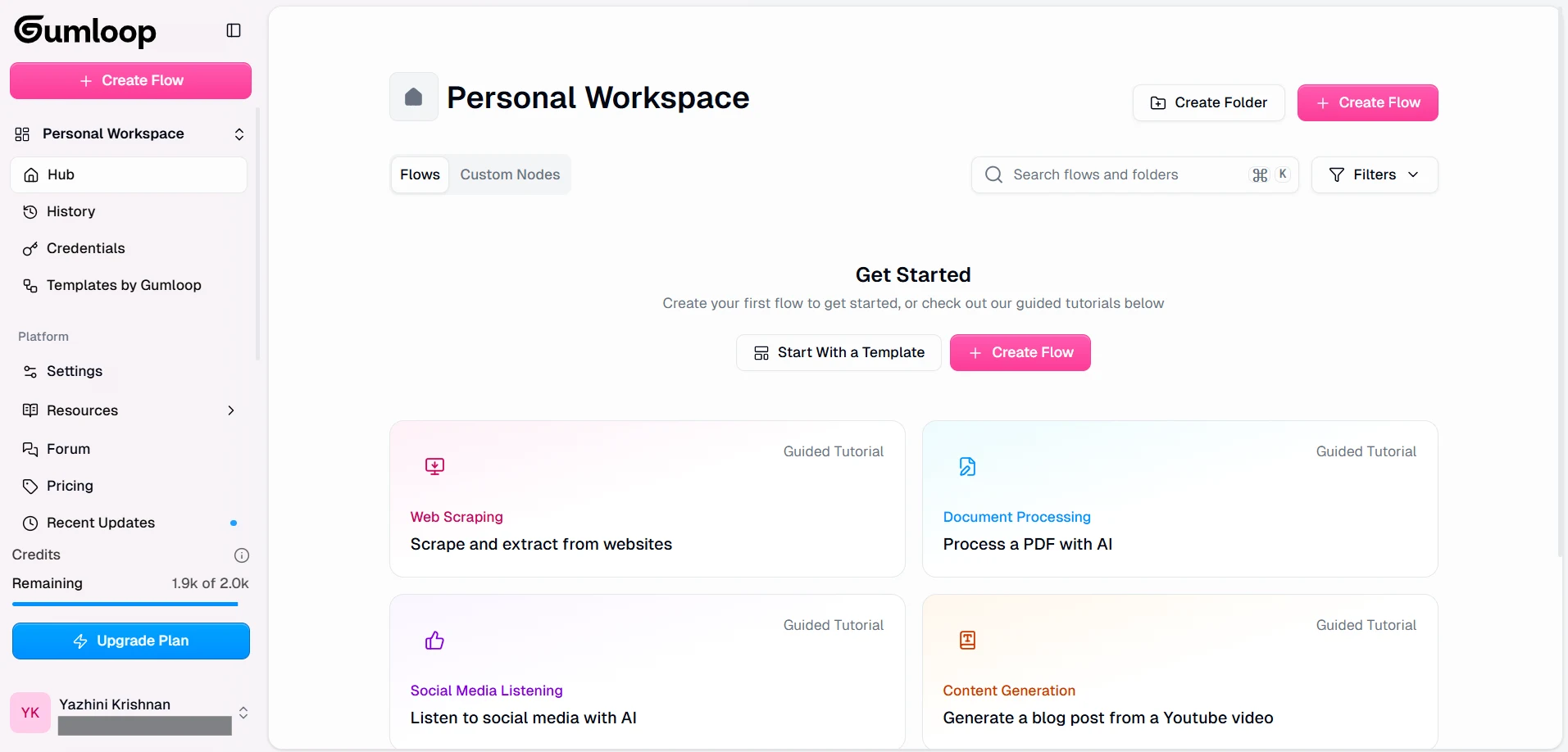

- Gumloop のアカウントを作成して(アカウント未作成の場合)、サインインしましょう。

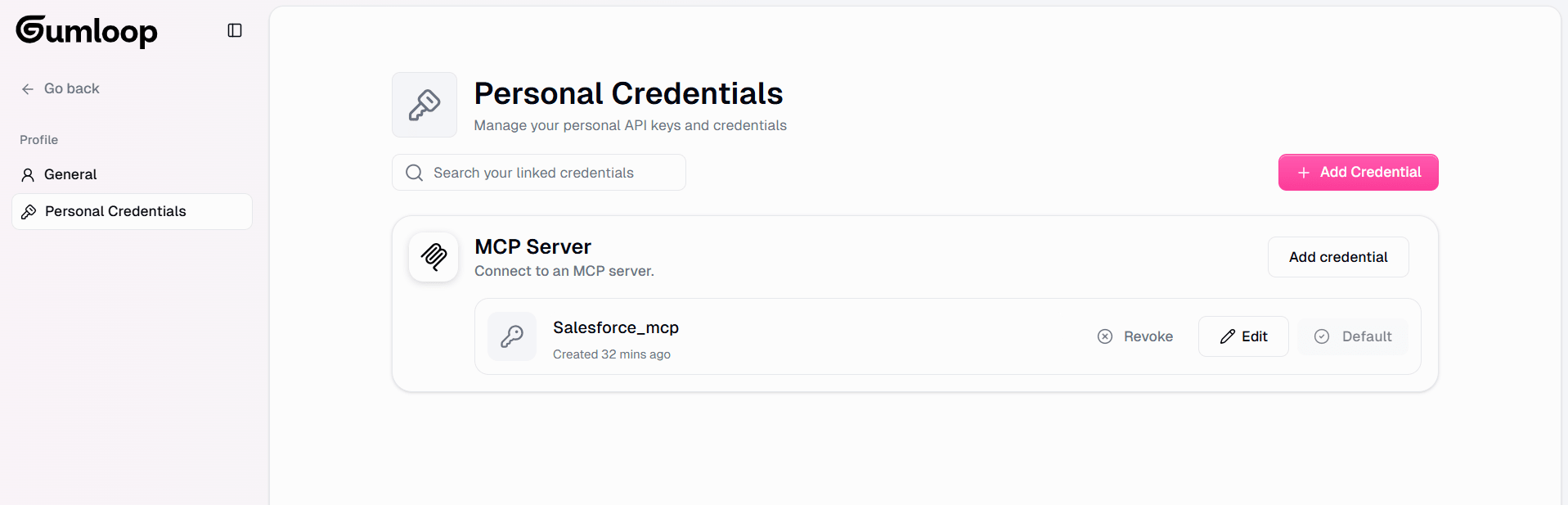

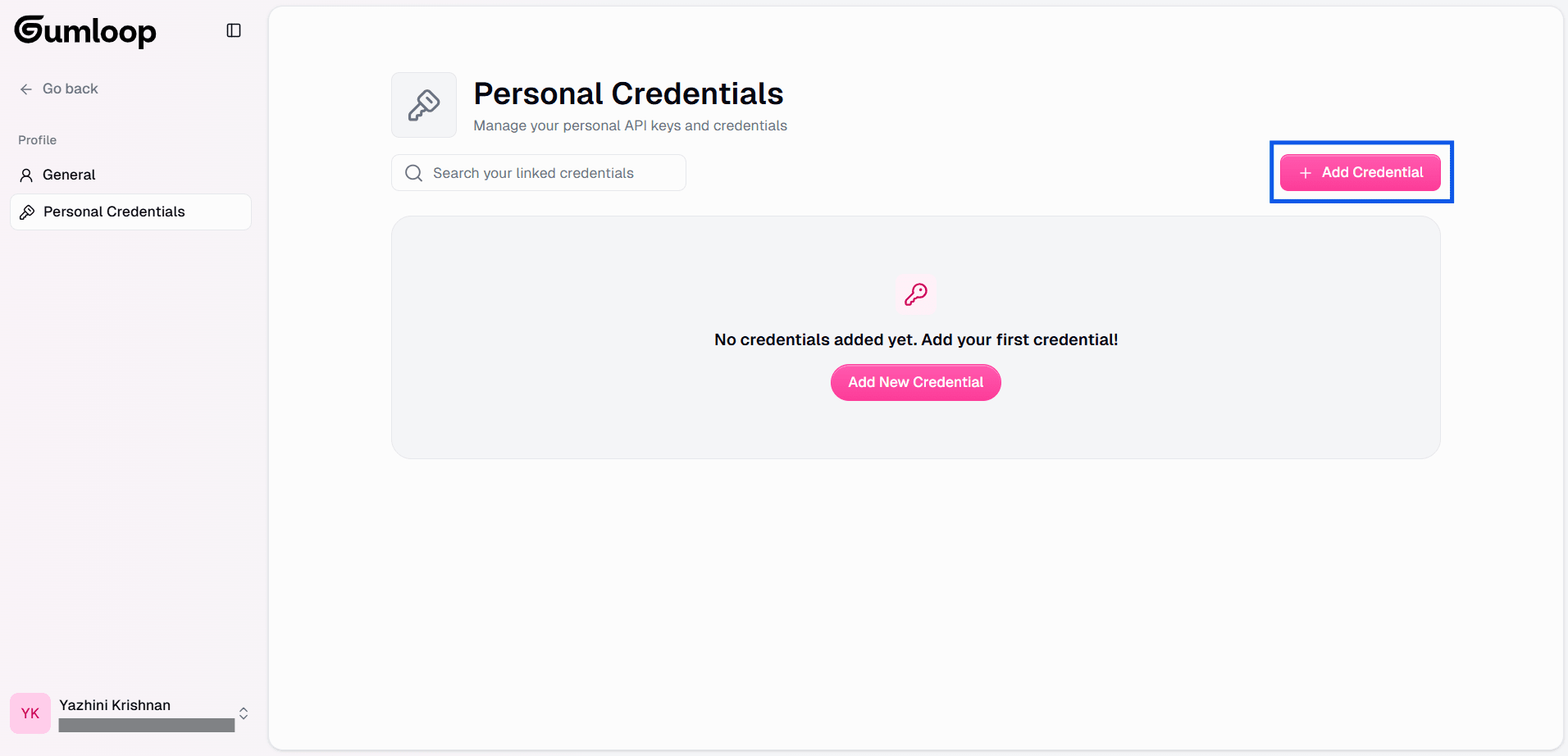

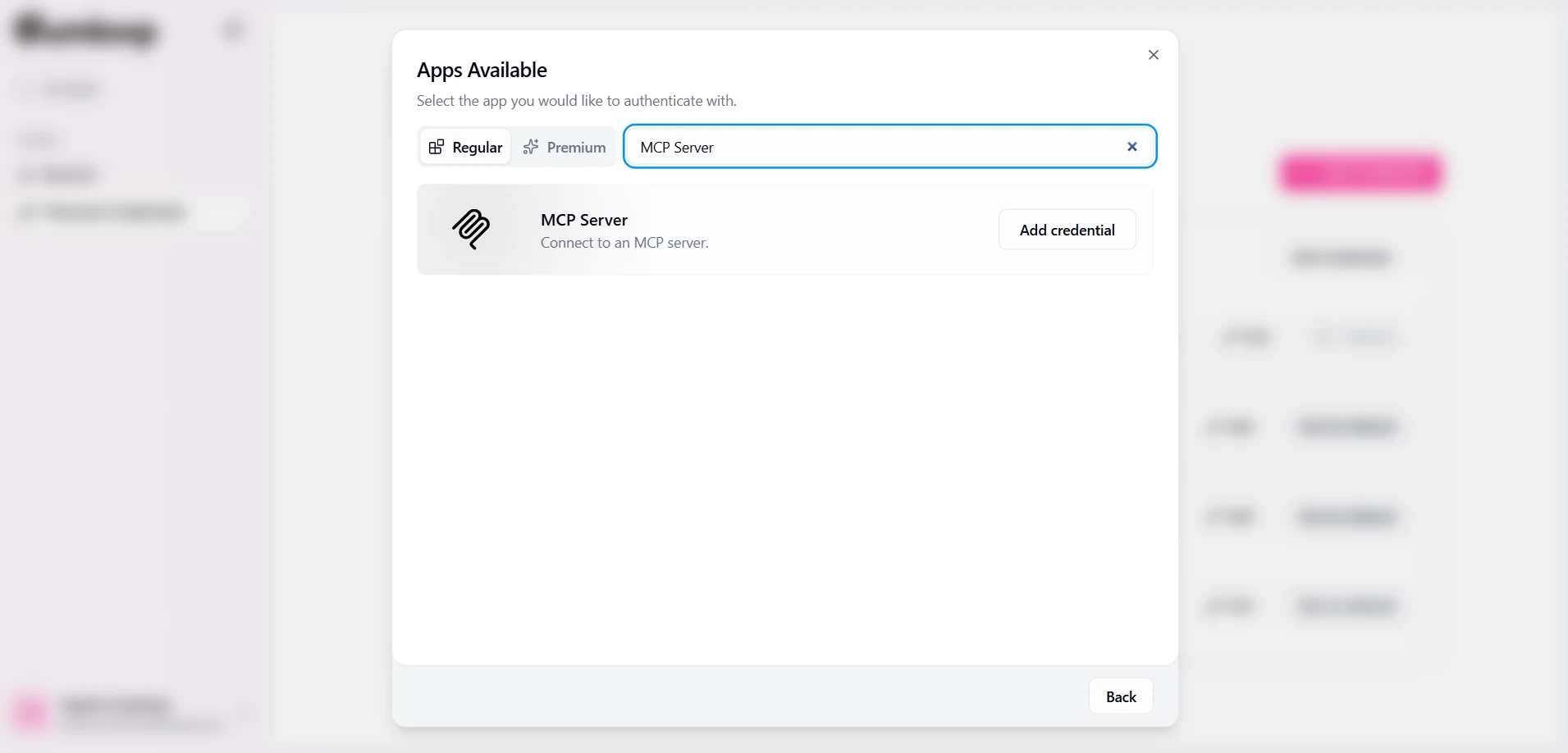

- Gumloop Credentials のページにアクセスして、MCP Server を構成します。

- 「Add Credentials」をクリックし、「MCP Server」を検索して選択します

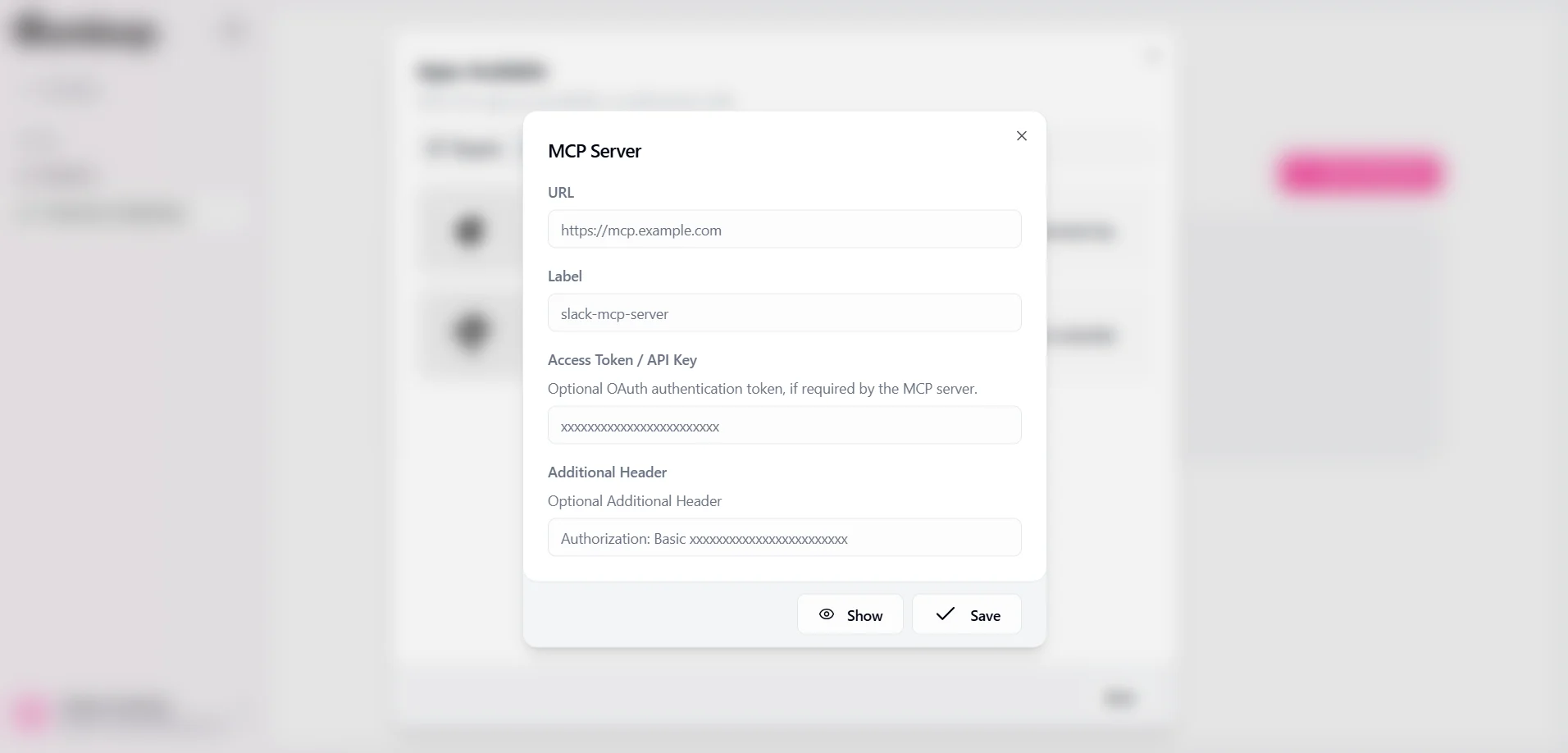

- 以下の詳細情報を入力します。

- URL: https://mcp.cloud.cdata.com/mcp

- Label: Spark-mcp-server などのわかりやすい名前

- Access Token / API Key: 空白のままにします

- Additional Header: Authorization: Basic YOUR EMAIL:YOUR PAT

- 認証情報を保存します

これで、Gumloop でワークフローを構築する際に MCP Server が利用できるようになりました。

ステップ3: ワークフローを構築してGumloop でSpark のリアルタイムデータを探索する

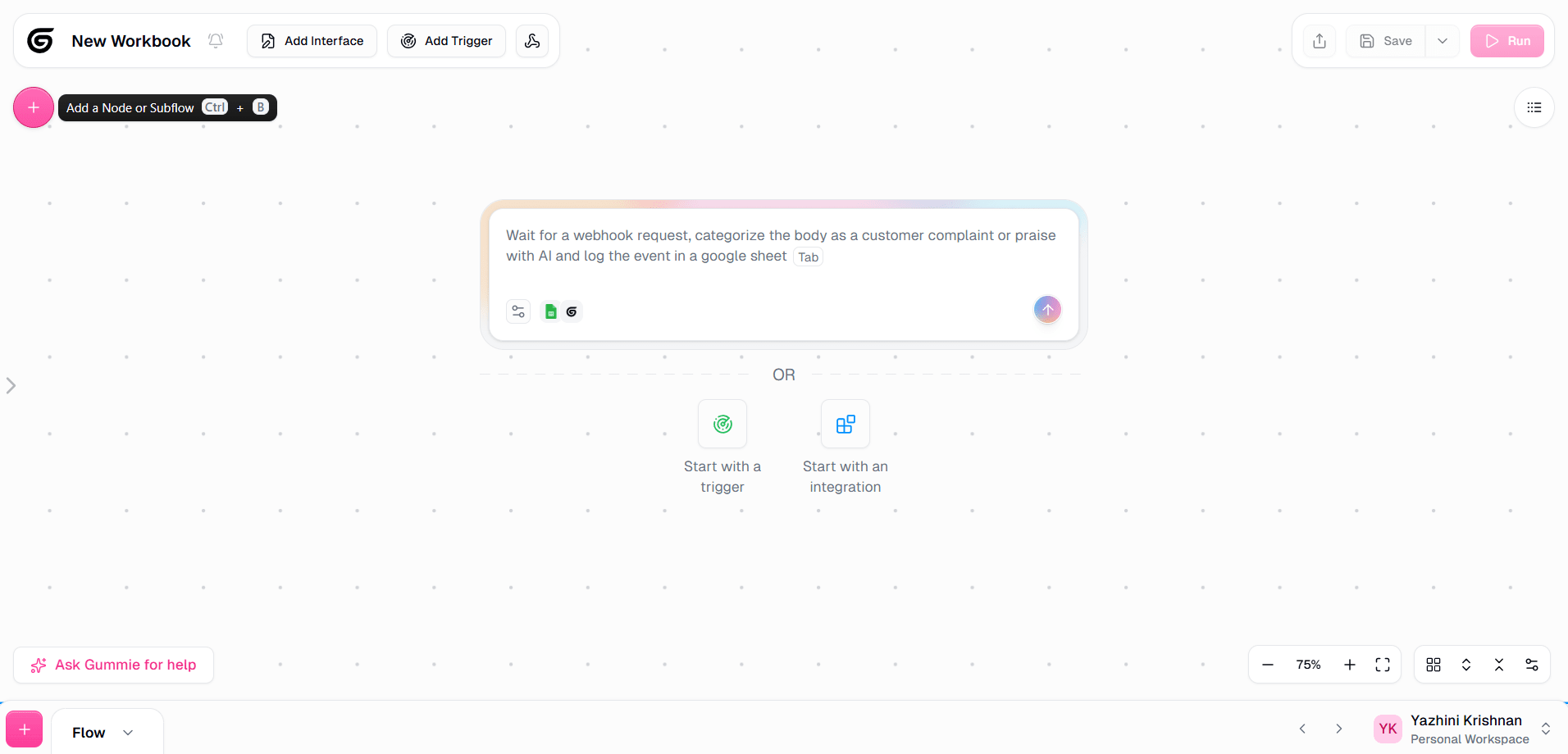

- Gumloop Personal workspace にアクセスし、 「Create Flow」をクリックします。

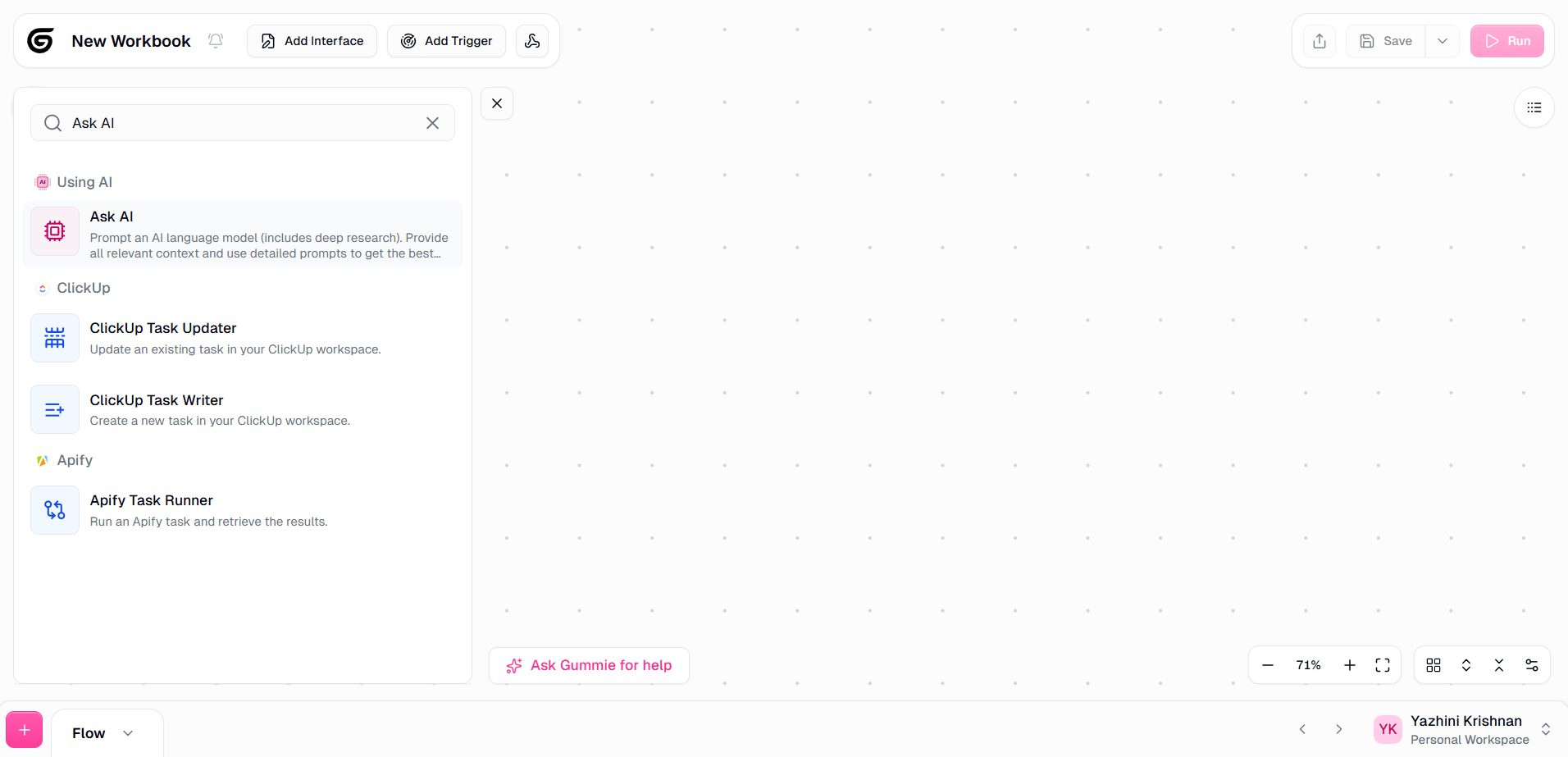

- 「」アイコンを選択するか、「Ctrl」+「B」を押してノードまたはサブフローを追加します。

- 「Ask AI」を検索して選択します。

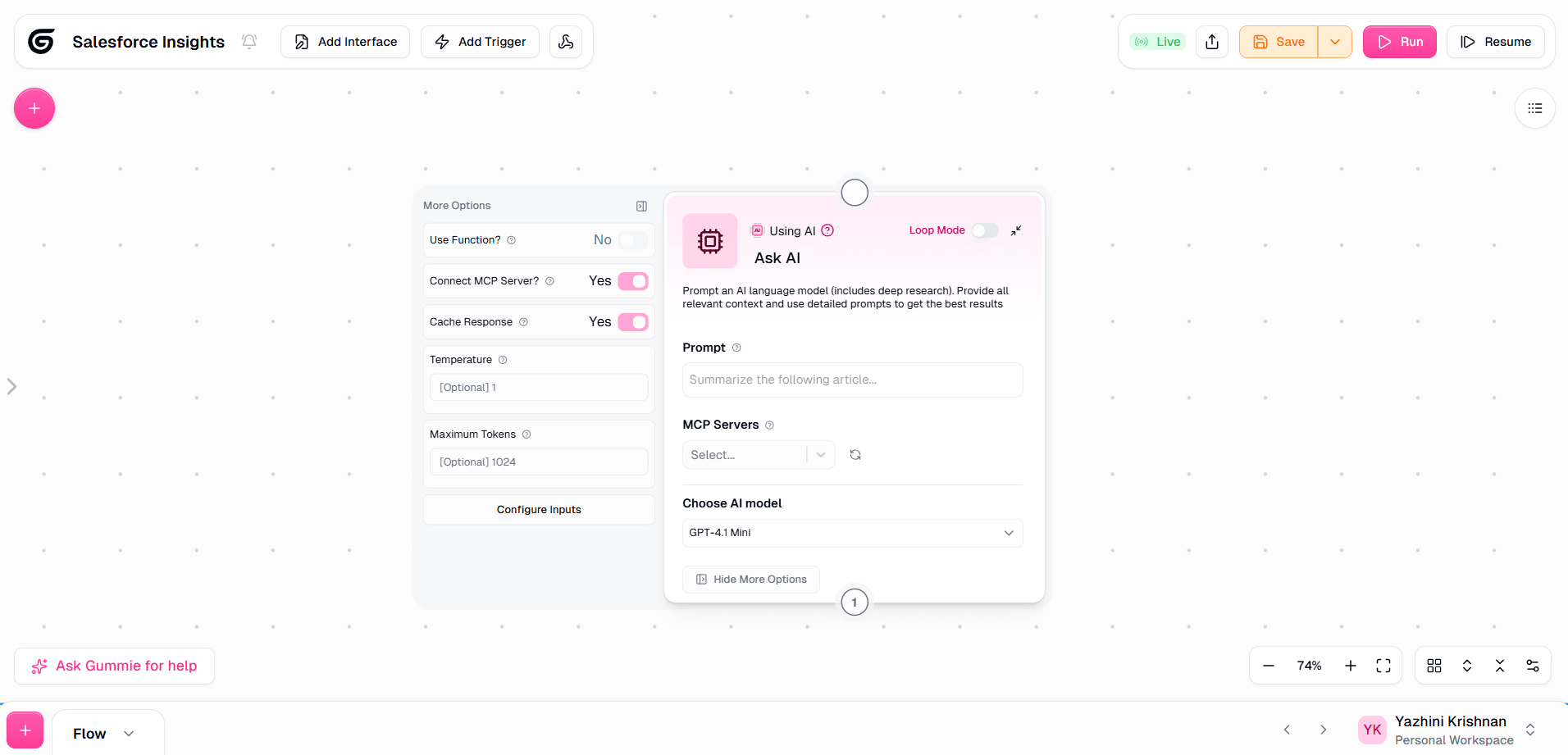

- 「Show More Options」をクリックし、「Connect MCP Server?」オプションを有効にします。

- 「MCP Servers」ドロップダウンから、保存したMCP 認証情報を選択します。

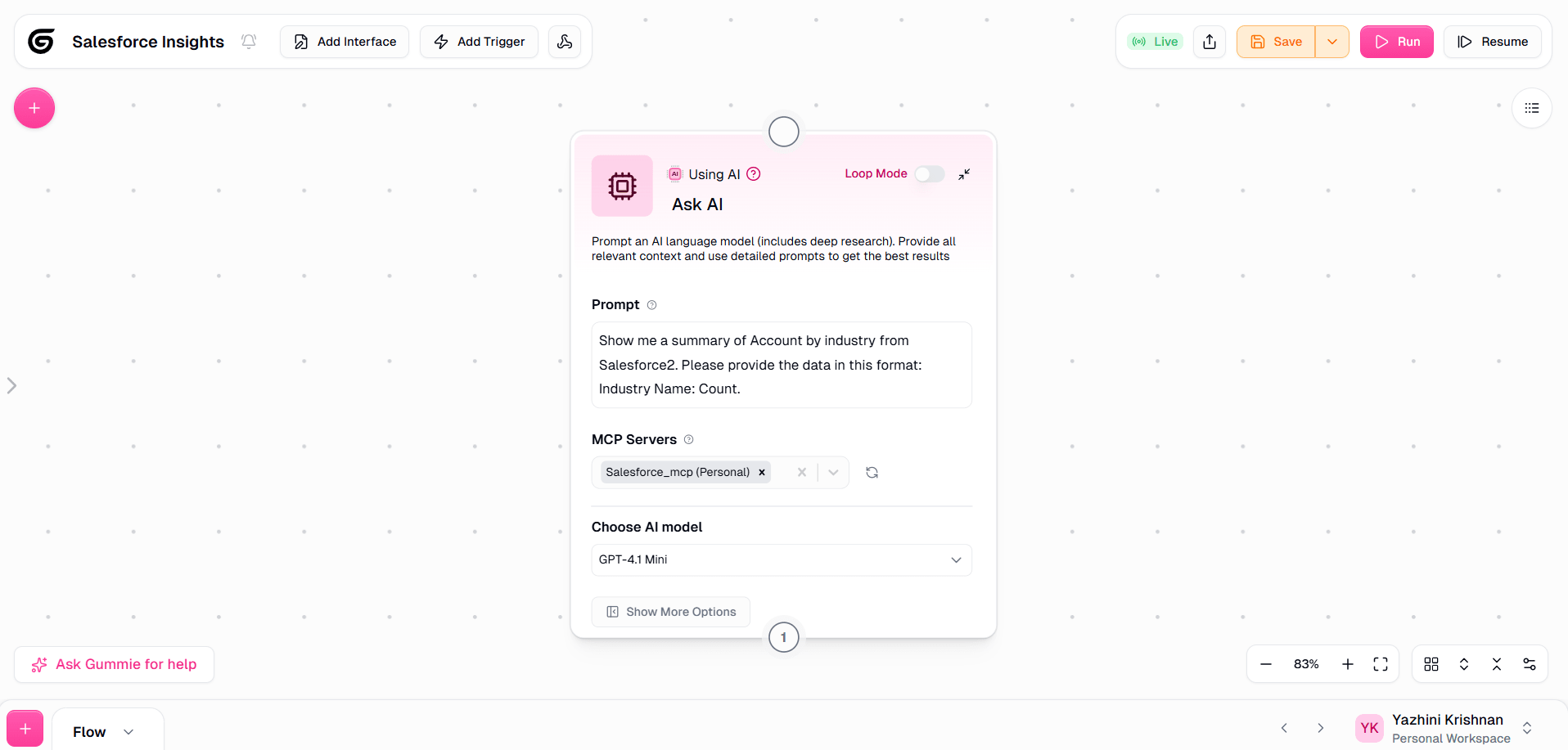

- プロンプトを追加し、要件に応じてAI モデルを選択します。

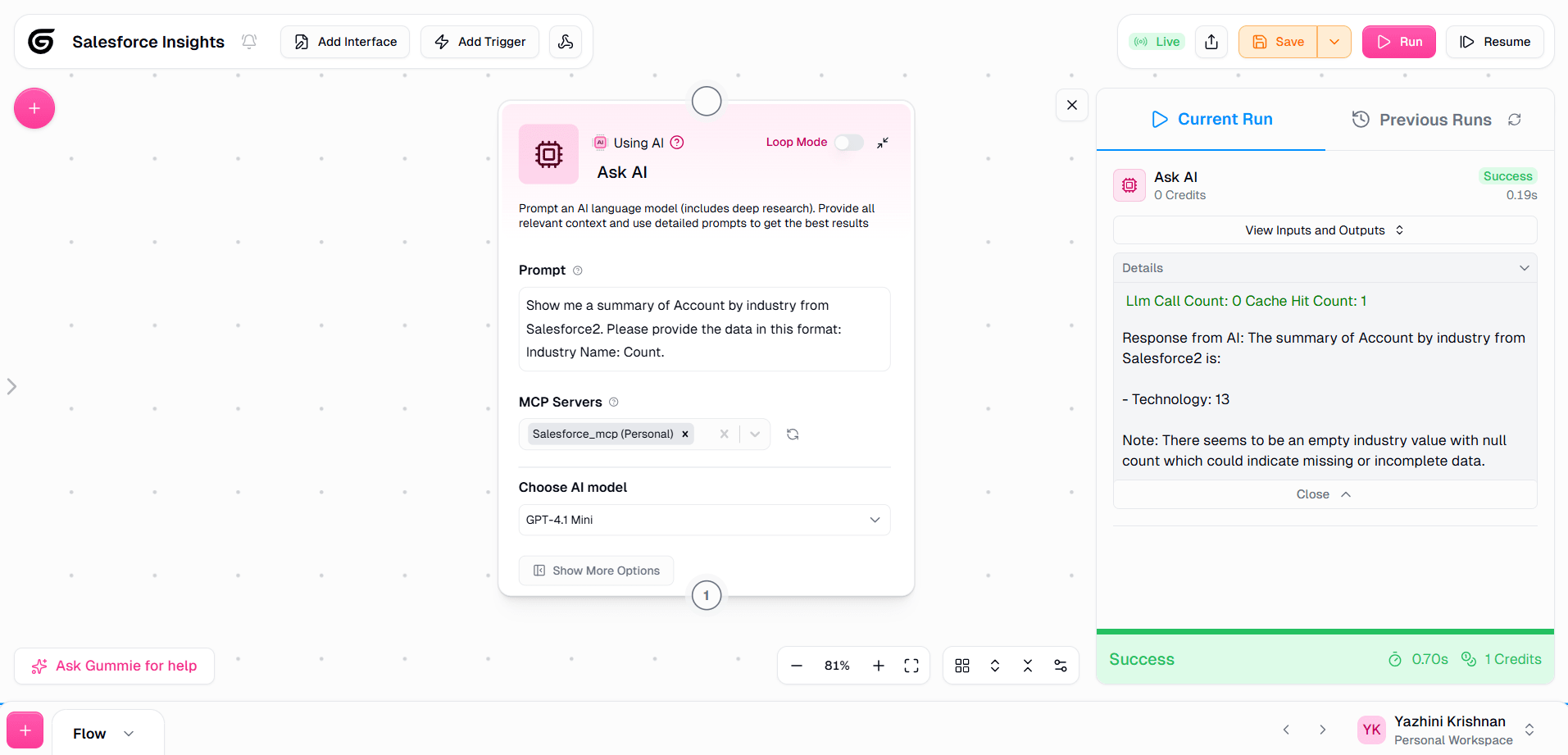

- 必要な詳細の構成が完了したら、「Run」をクリックしてパイプラインを実行します

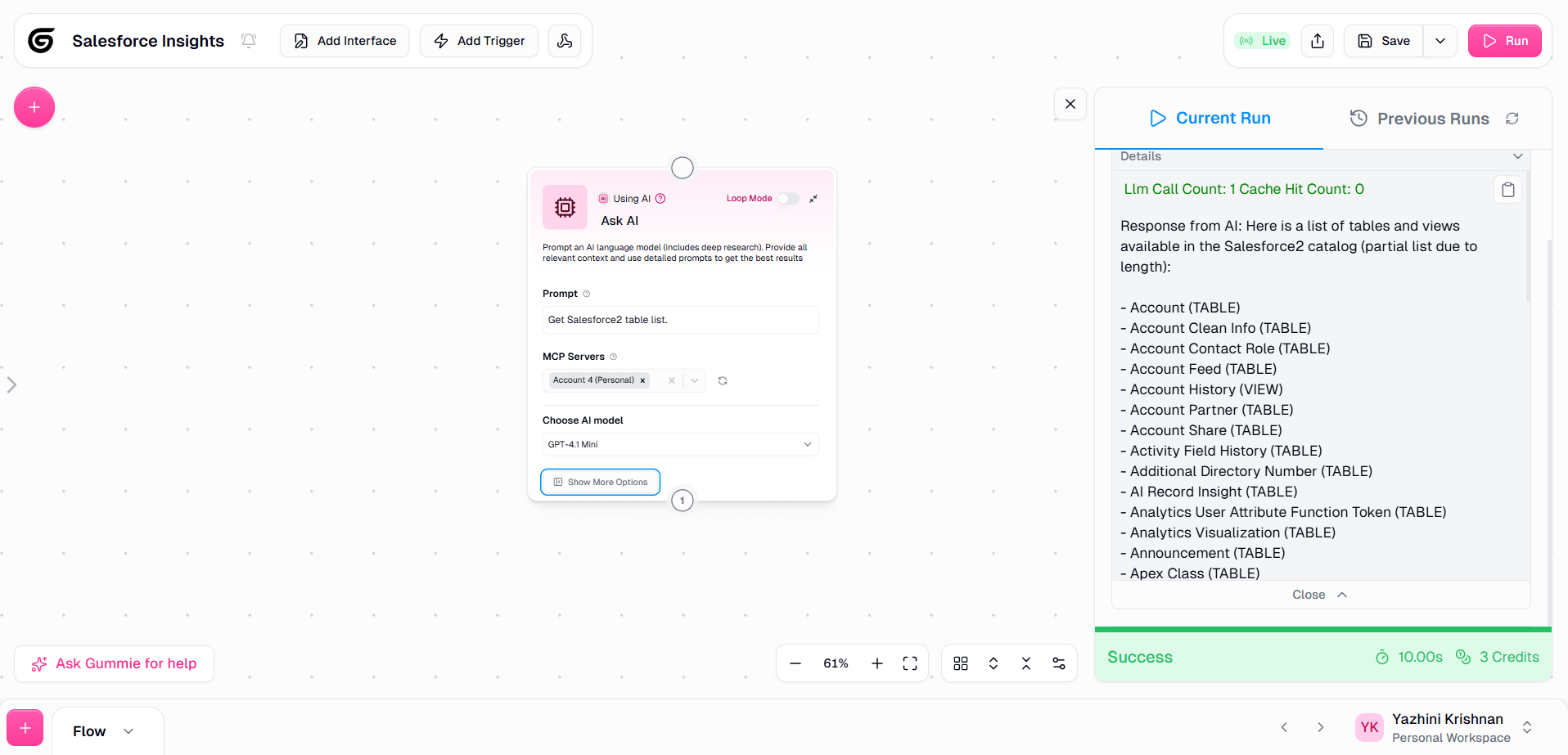

ワークフローの実行が完了すると、CData Connect AI MCP Serverを通じて Spark を正常に取得できたことが確認できます。MCP Client ノードを使用することで、データに対する質問、レコードの取得、アクションの実行が可能になります。

CData Connect AI でビジネスシステムのデータ活用を今すぐスタート

いかがでしたか?Gumloop からSpark へのデータ接続が10分もかからずに完了したのではないでしょうか。業務に使えそう、と感じてくださった方は、14日間の無償トライアルでAI ツールからビジネスシステムへのリアルタイムデータ接続をぜひお試しください。