PolyBase を使用して Spark のデータを外部データソースとして接続

SQL Server のPolyBase を使用すると、データベーステーブルのクエリに使用するのと同じTransact-SQL 構文を使用して外部データをクエリできます。CData ODBC Driver for Spark と組み合わせることで、SQL Server データのすぐ隣でSpark のデータに直接アクセスできます。この記事では、外部データソースと外部テーブルを作成して、T-SQL クエリを使用してリアルタイムのSpark のデータにアクセスできるようにする方法を説明します。

注意:PolyBase はSQL Server 19 以降でのみ使用できます。

CData Connect AI は Spark 専用のSQL Server インターフェースを提供し、ネイティブでサポートされているデータベースにデータをレプリケートすることなく Spark のデータをクエリできます。最適化されたデータ処理を標準で使用し、CData Connect AI はサポートされているすべてのSQL 操作(フィルター、JOIN など)を Spark に直接プッシュし、サーバーサイド処理を活用して必要なSpark のデータを迅速に返します。

PolyBase 用に Spark への接続を設定

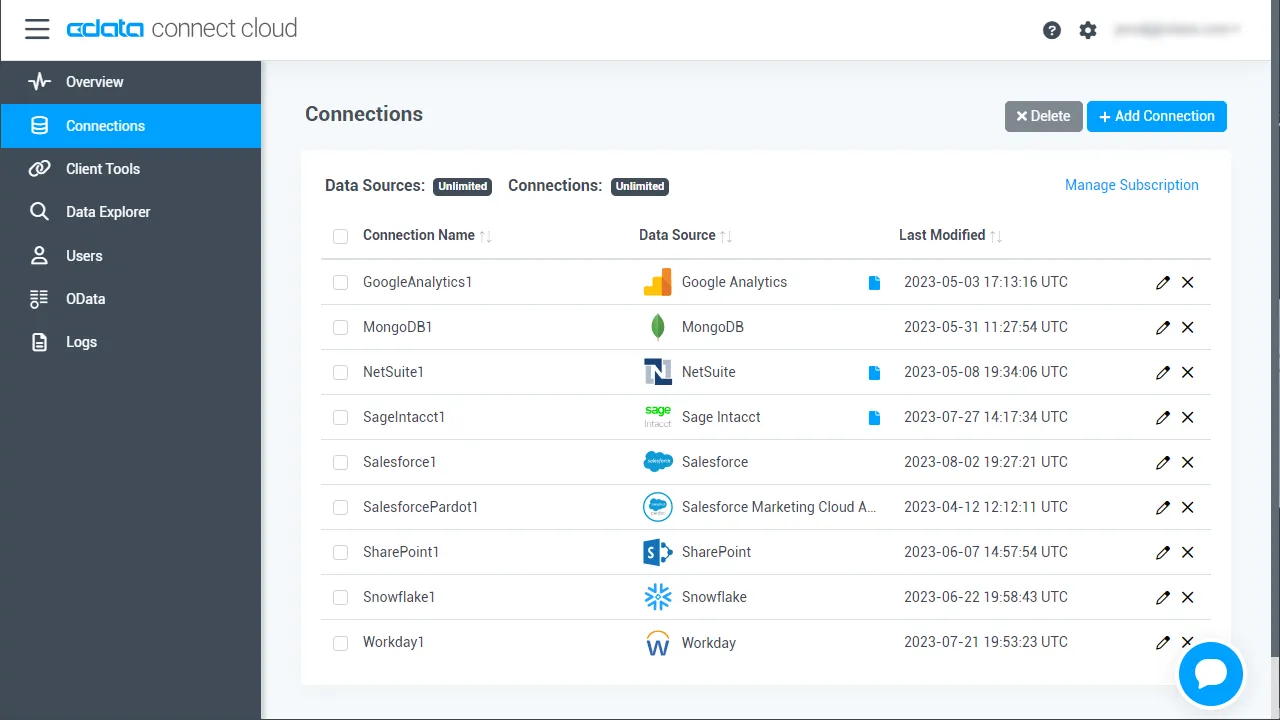

PolyBase から Spark への接続は、CData Connect AI によって実現されます。PolyBase からSpark のデータを操作するには、まず Spark 接続を作成し設定します。

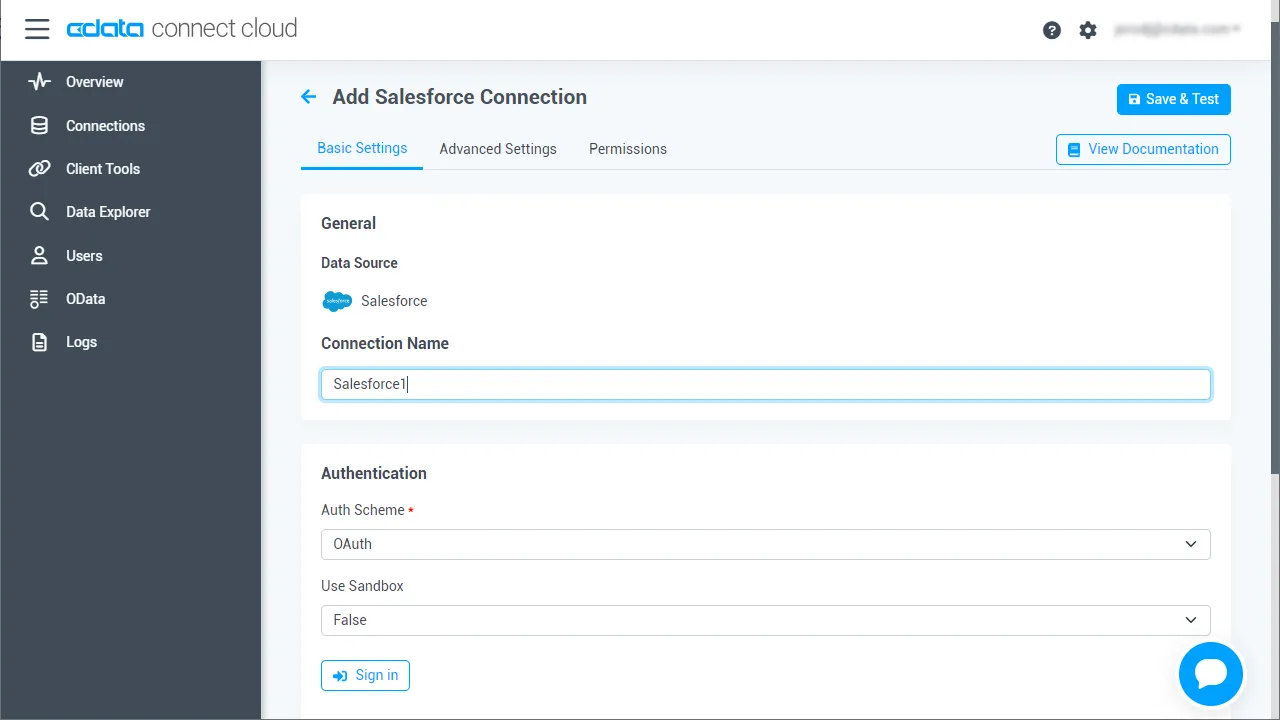

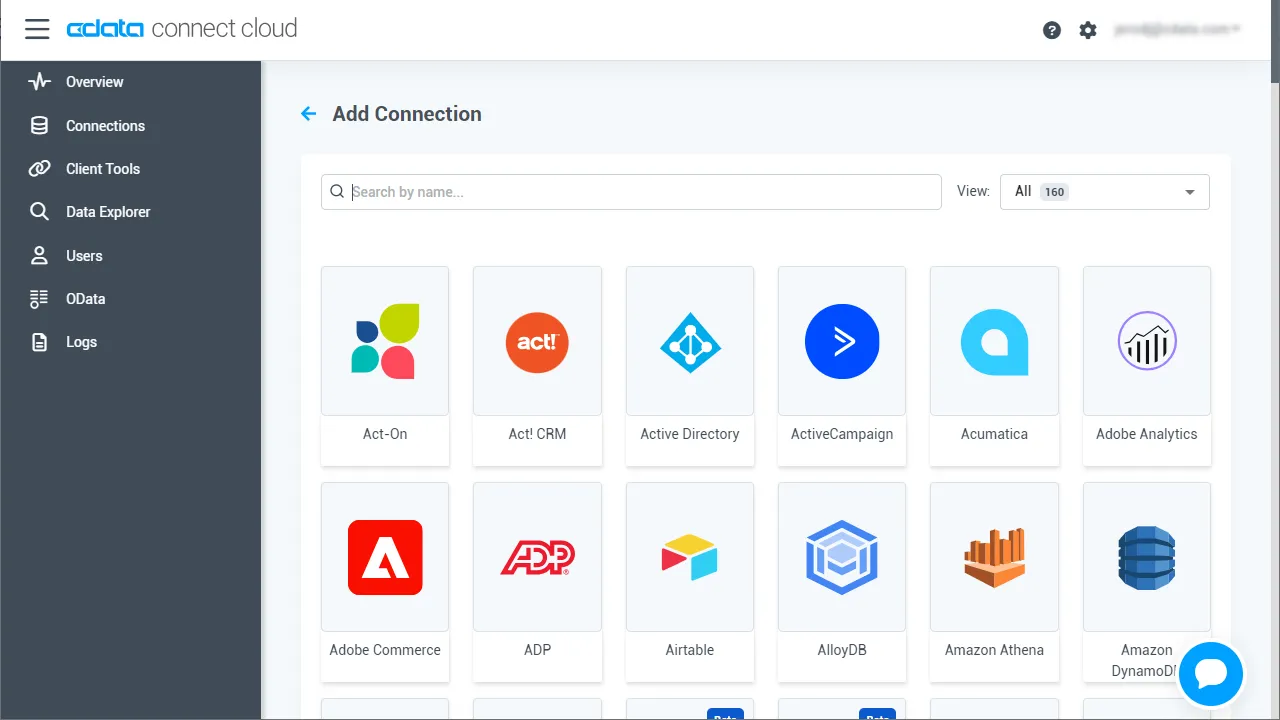

- Connect AI にログインして「Sources」をクリックし、 Add Connection をクリックします

- Add Connection パネルから「Spark」を選択します

-

Spark への接続に必要な認証プロパティを入力します。

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

- Save & Test をクリックします

-

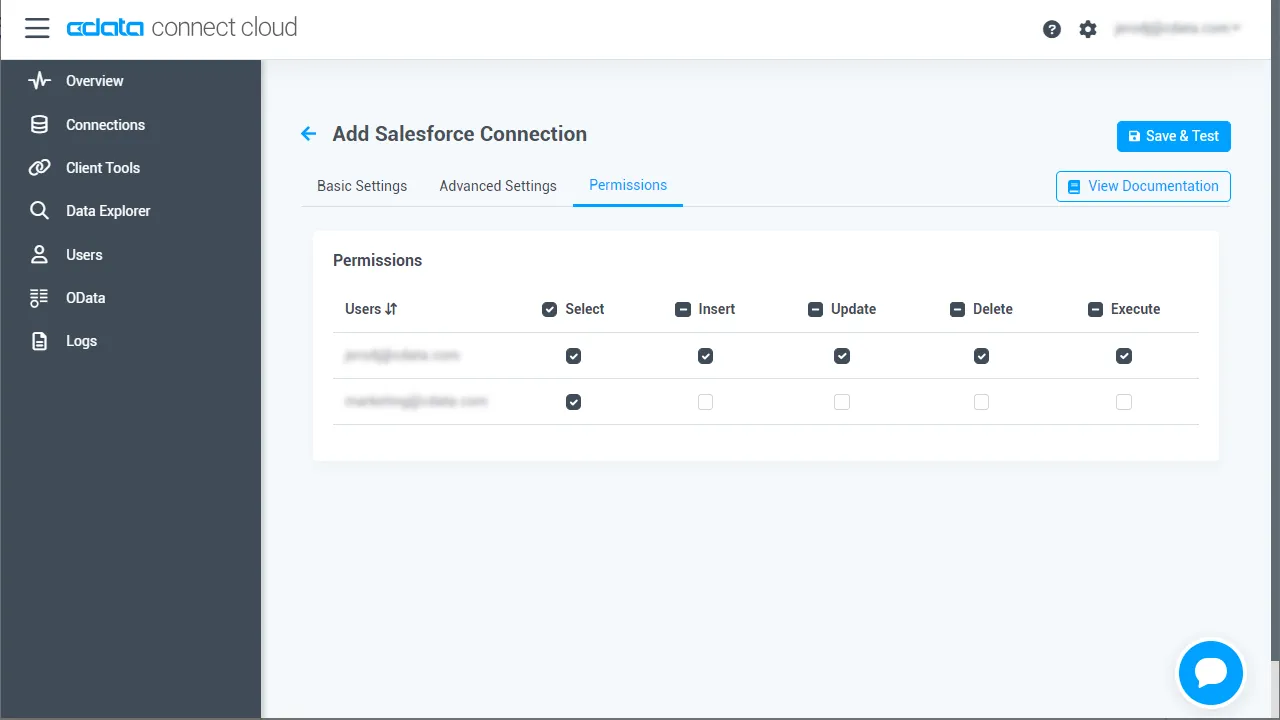

Add Spark Connection ページの「Permissions」タブに移動し、ユーザーベースの権限を更新します。

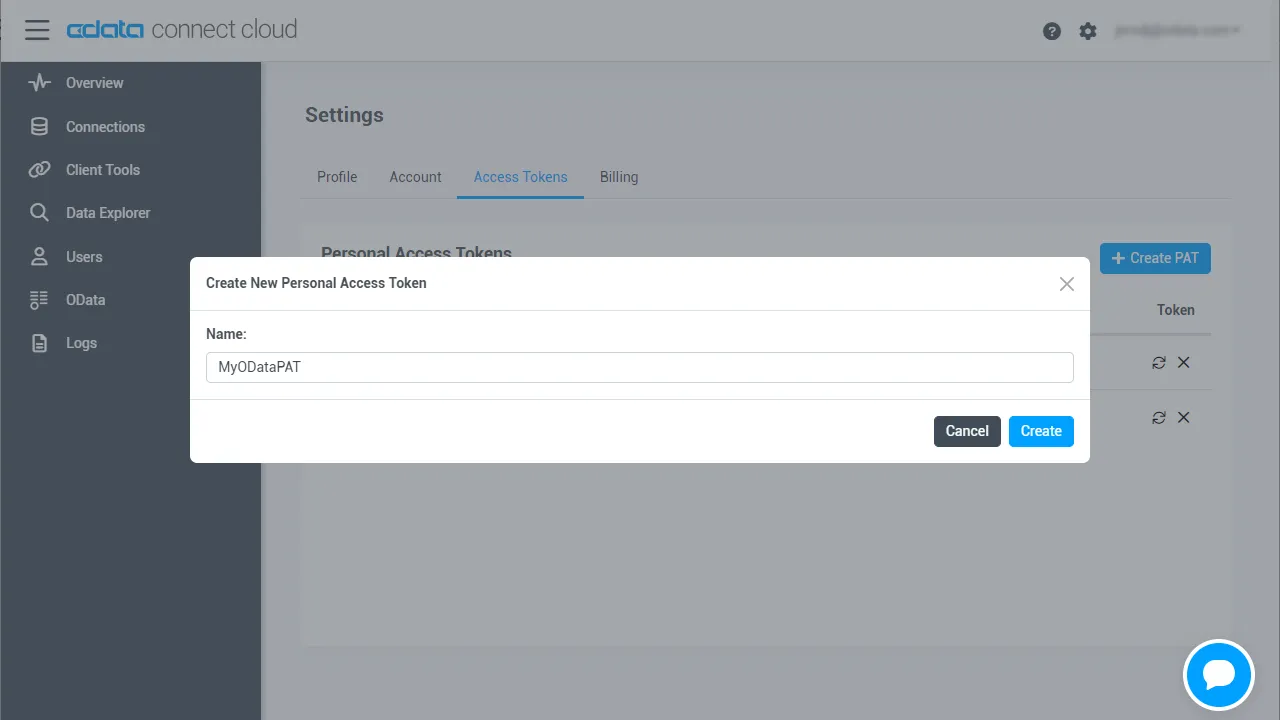

Personal Access Token の追加

REST API、OData API、またはVirtual SQL Server 経由でConnect AI に接続する場合、Personal Access Token(PAT)を使用してConnect AI への接続を認証します。アクセス管理の粒度を維持するために、サービスごとに個別のPAT を作成することをお勧めします。

- Connect AI アプリの右上にある歯車アイコン()をクリックして設定ページを開きます。

- Settings ページで「Access Tokens」セクションに移動し、 Create PAT をクリックします。

-

PAT に名前を付けて「Create」をクリックします。

- Personal Access Token は作成時にのみ表示されるため、必ずコピーして安全な場所に保存してください。

接続の設定とPAT の生成が完了したら、Polybase からSpark のデータに接続する準備が整いました。

Spark のデータ用の外部データソースを作成

接続を設定した後、外部データソース用の資格情報データベースを作成する必要があります。

資格情報データベースの作成

Spark のデータ に接続する外部データソースの資格情報を作成するには、以下のSQL コマンドを実行します。

注意:IDENTITY にはConnect AI のユーザー名を、SECRET にはPersonal Access Token を設定します。

CREATE DATABASE SCOPED CREDENTIAL ConnectCloudCredentials WITH IDENTITY = 'yourusername', SECRET = 'yourPAT';

Spark 用の外部データソースを作成

PolyBase で Spark 用の外部データソースを作成するには、CREATE EXTERNAL DATA SOURCE SQL コマンドを実行します:

CREATE EXTERNAL DATA SOURCE ConnectCloudInstance WITH ( LOCATION = 'sqlserver://tds.cdata.com:14333', PUSHDOWN = ON, CREDENTIAL = ConnectCloudCredentials );

Spark 用の外部テーブルを作成

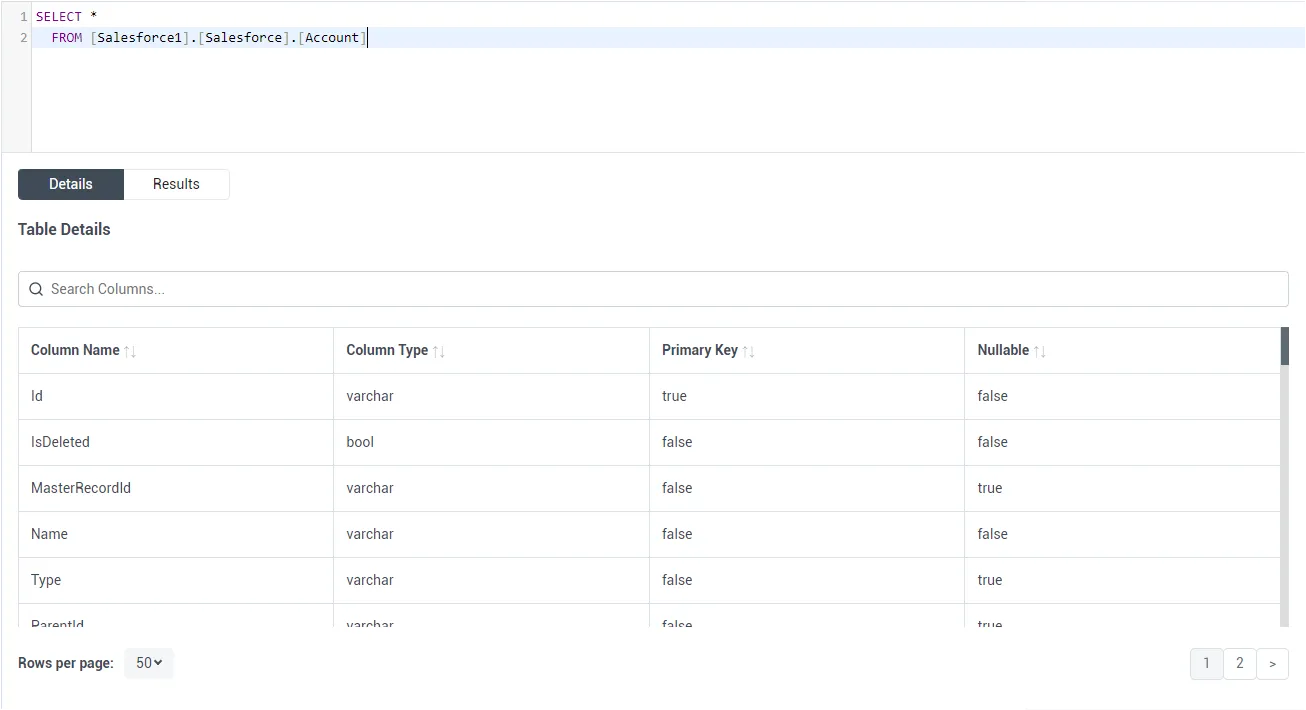

外部データソースを作成した後、CREATE EXTERNAL TABLE ステートメントを使用して、SQL Server インスタンスからSpark のデータにリンクします。テーブルのカラム定義は、CData Connect AI で公開されているものと一致する必要があります。Connect AI のData Explorer を使用してテーブル定義を確認できます。

サンプルCREATE TABLE ステートメント

外部テーブルを作成するには、CREATE EXTERNAL TABLE SQL コマンドを実行し、照合順序を使用してLOCATION に接続、カタログ、テーブルの3部構成の表記を設定します。Spark Customers に基づいて外部テーブルを作成するステートメントは、次のようになります。

CREATE EXTERNAL TABLE Customers( City COLLATE [nvarchar](255) NULL, Balance COLLATE [nvarchar](255) NULL, ... ) WITH ( LOCATION='SparkSQL1.SparkSQL.Customers', DATA_SOURCE=ConnectCloudInstance );

SQL Server インスタンスに Spark 用の外部テーブルを作成したので、ローカルデータとリモートデータを同時にクエリできるようになりました。SQL Server データベースから300以上のSaaS、Big Data、NoSQL ソースへのリアルタイムデータアクセスを実現するために、CData Connect AI を今すぐお試しください!