Claris FileMaker Pro のスクリプト機能を使ってSpark のデータに接続

Claris FileMaker は、データの管理や整理のためのカスタムアプリを作成できるローコードデータベースアプリケーション開発ツールです。強力なリレーショナルデータベースエンジンと直感的なインターフェースを組み合わせており、技術者でも非技術者でも、デスクトップ、Web、モバイルプラットフォーム向けのアプリケーションを設計・デプロイできます。

この記事では、CData ODBC Driver for Apache Spark と FileMaker のスクリプト機能を使ってSpark のデータに接続する方法を解説します。

Spark 用の ODBC データソースを作成

まだ設定していない場合は、最初に ODBC DSN(データソース名)で接続プロパティを指定します。これはドライバーインストールの最終ステップでもあります。Microsoft ODBC データソースアドミニストレーターを使用して ODBC DSN を作成・設定できます。

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

DSN を設定する際には、Max Rows 接続プロパティも設定することをお勧めします。これにより返される行数が制限され、レポートやビジュアライゼーションの設計時にパフォーマンスを向上させるのに役立ちます。

スクリプトを使用して FileMaker でSpark のデータを接続・同期

このセクションでは、CData ODBC Driver for Apache Spark とスクリプト機能を使用して、FileMaker にリアルタイムのSpark データを接続する手順を説明します。初回インポート時には、FileMaker は外部データソースからすべてのデータを取り込みます。2回目以降のインポートでは、外部ソースで変更されたデータのみが更新されます(差分更新)。また、現在のレコード順序でデータを置換したり、これらの差分更新を自動同期のためにスケジュール設定することもできます。

Mac/Windows/Linux システム向けの最新版 FileMaker Pro は、こちらのリンクからダウンロード・インストールできます。

スクリプトを使った FileMaker との接続と同期

FileMaker のスクリプト機能を使用すると、単一のコマンドで一連のアクションを実行し、複雑なタスクやワークフローを自動化できます。スクリプトを使ってSpark と連携することで、FileMaker アプリケーション内でSpark のデータへの接続、インポート、更新、置換を自動化し、データ管理を効率化できます。

スクリプトを使った初回インポートとデータの追加

このセクションでは、以下の手順でスクリプトを使ってSpark のデータを FileMaker にインポートします:

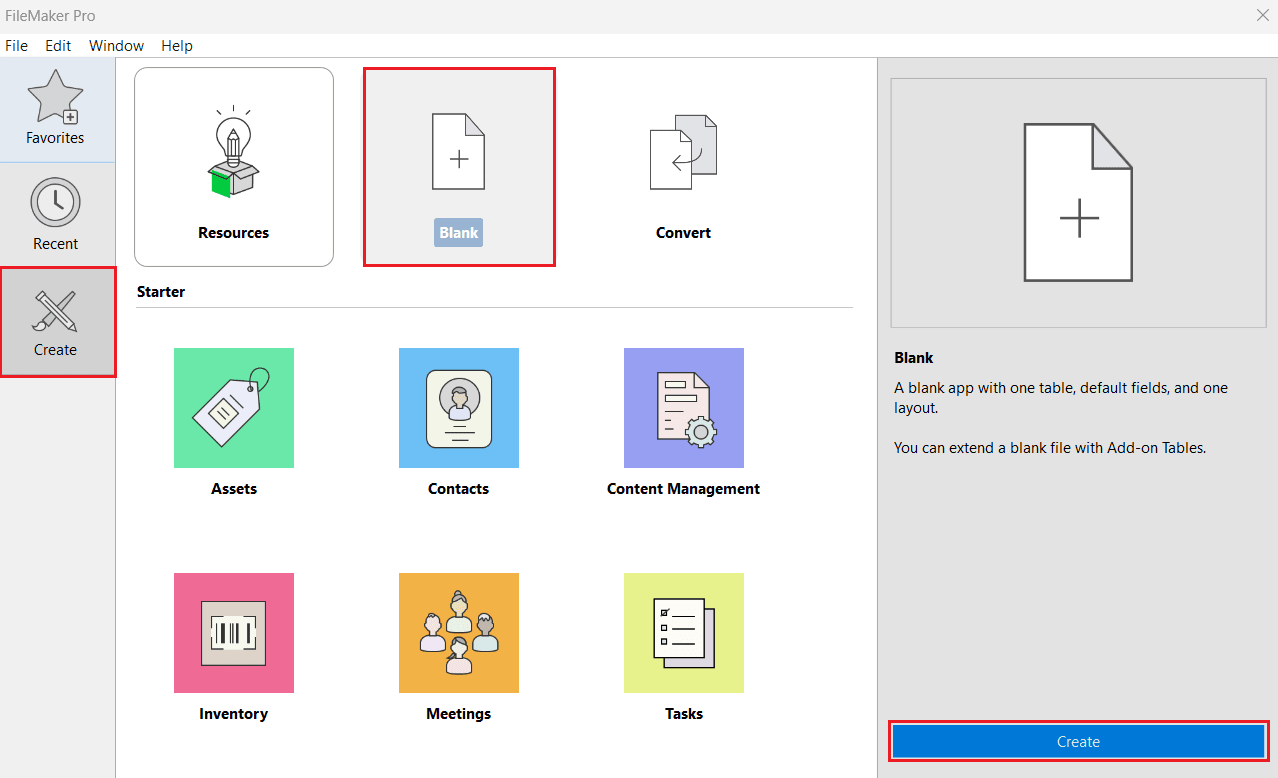

- FileMaker Pro を開きます。左パネルから Create に移動し、Blank > Create を選択します。

- 任意のファイル名を入力して Save をクリックします。

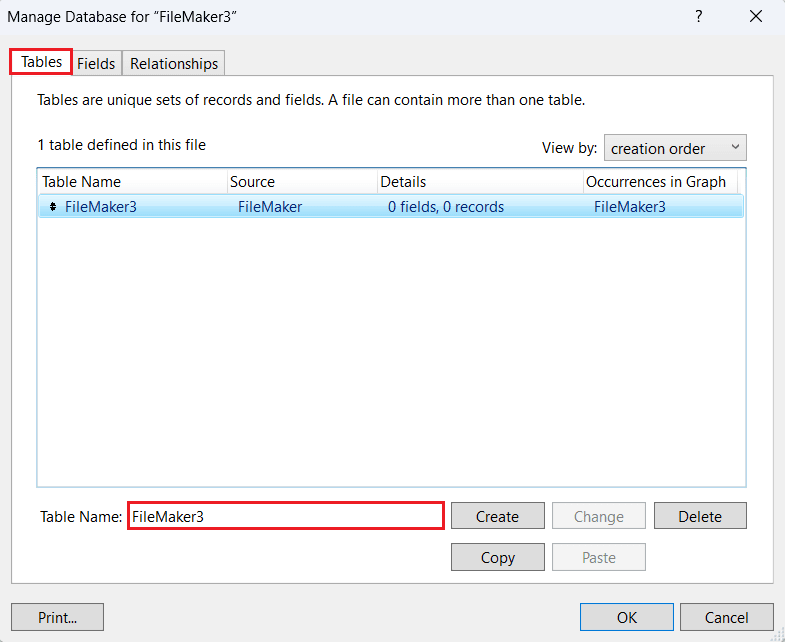

- Manage Database ウィンドウで Tables タブに移動し、Spark のデータを表示するテーブルを作成または名前変更します。

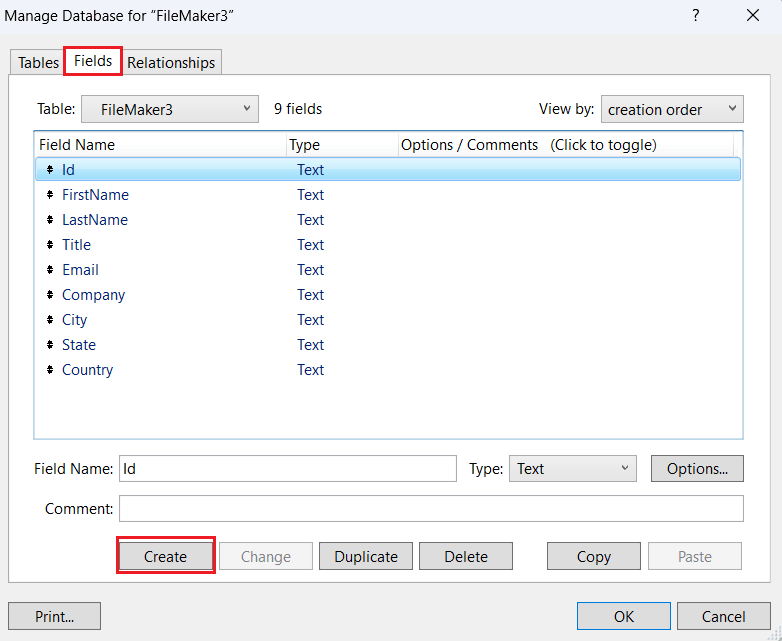

- Fields タブで、テーブルで使用するフィールドを作成・追加します。

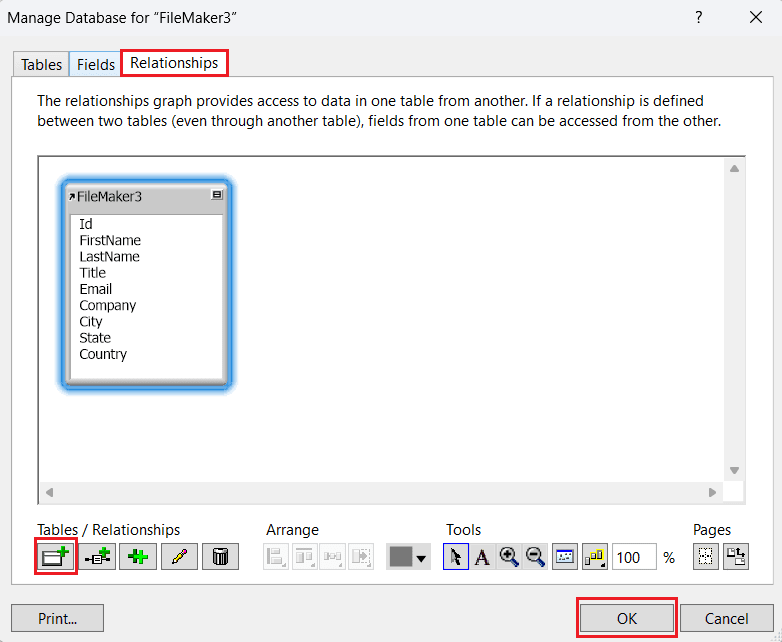

- Relationships タブで、複数のテーブルがある場合はテーブルのリレーションシップを追加し、OK をクリックします。

- テーブル構造を再度開いて変更するには、File > Manage > Database に移動します。

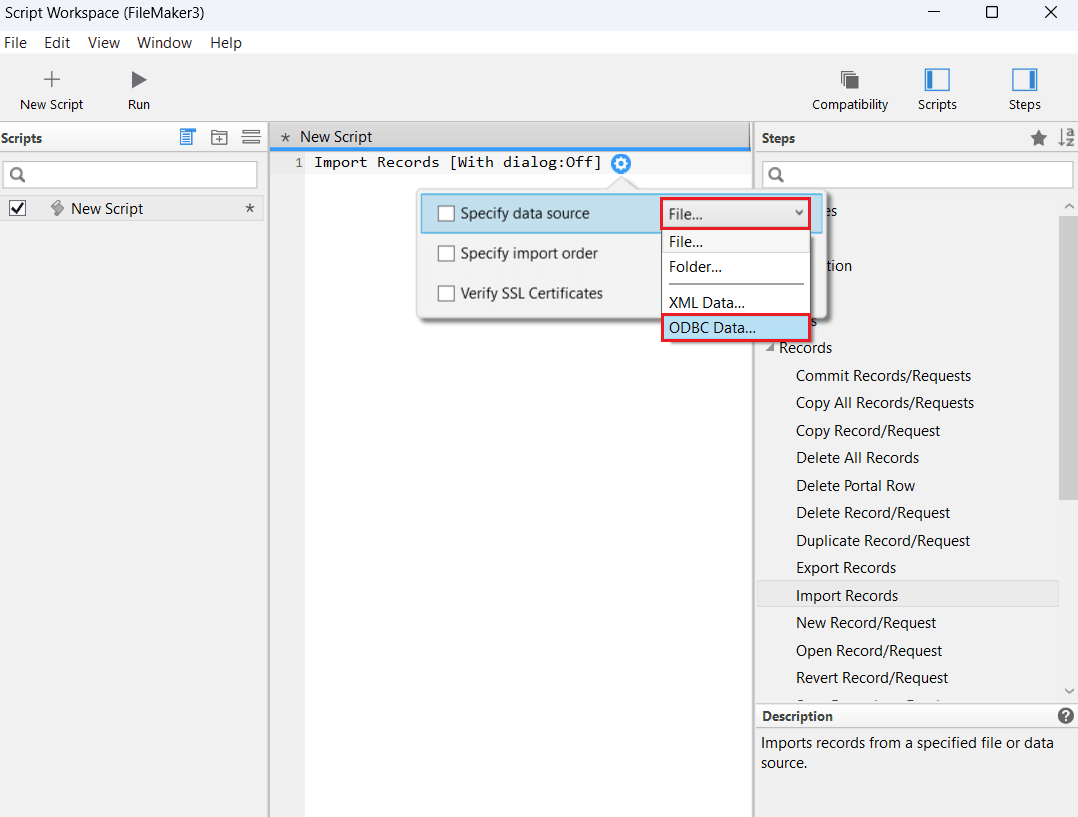

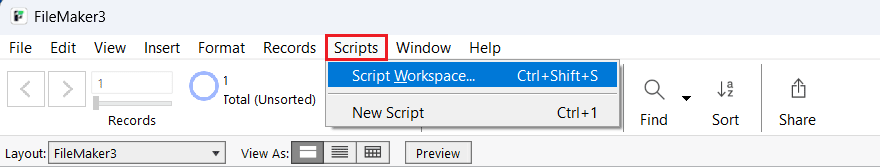

- Scripts > Script Workspace に移動します。

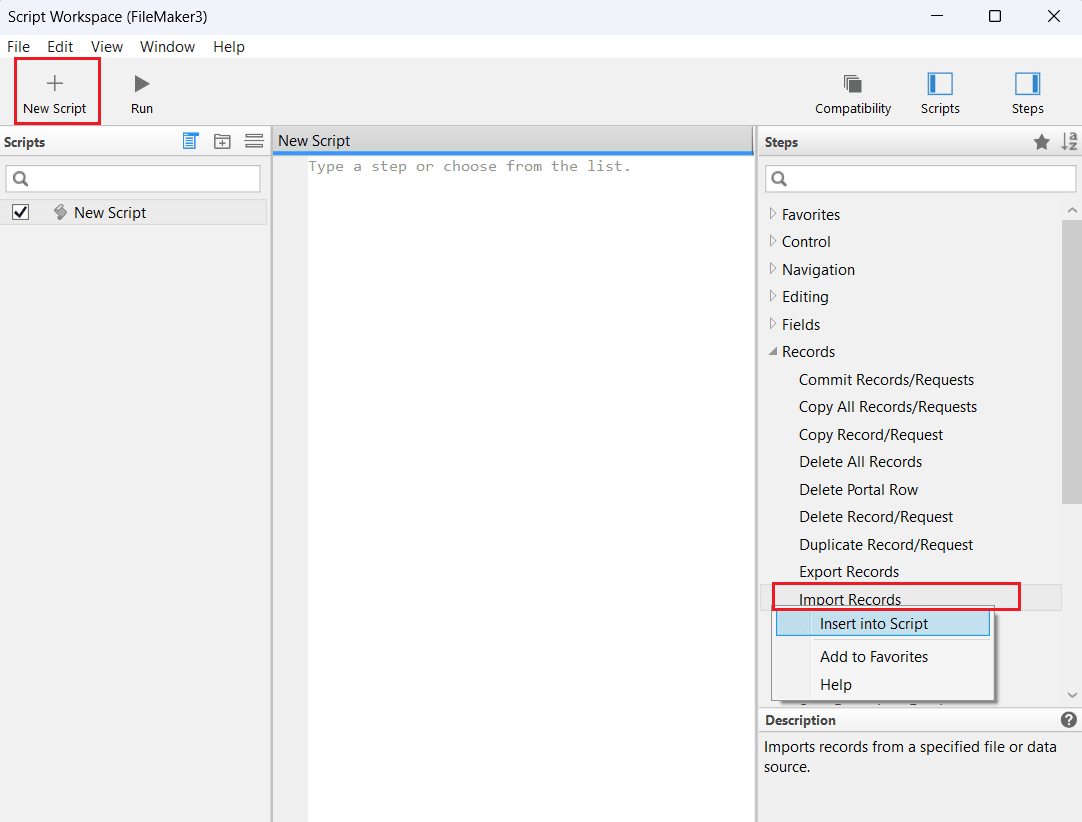

- New Script を選択して新しいスクリプトワークスペースを開きます。

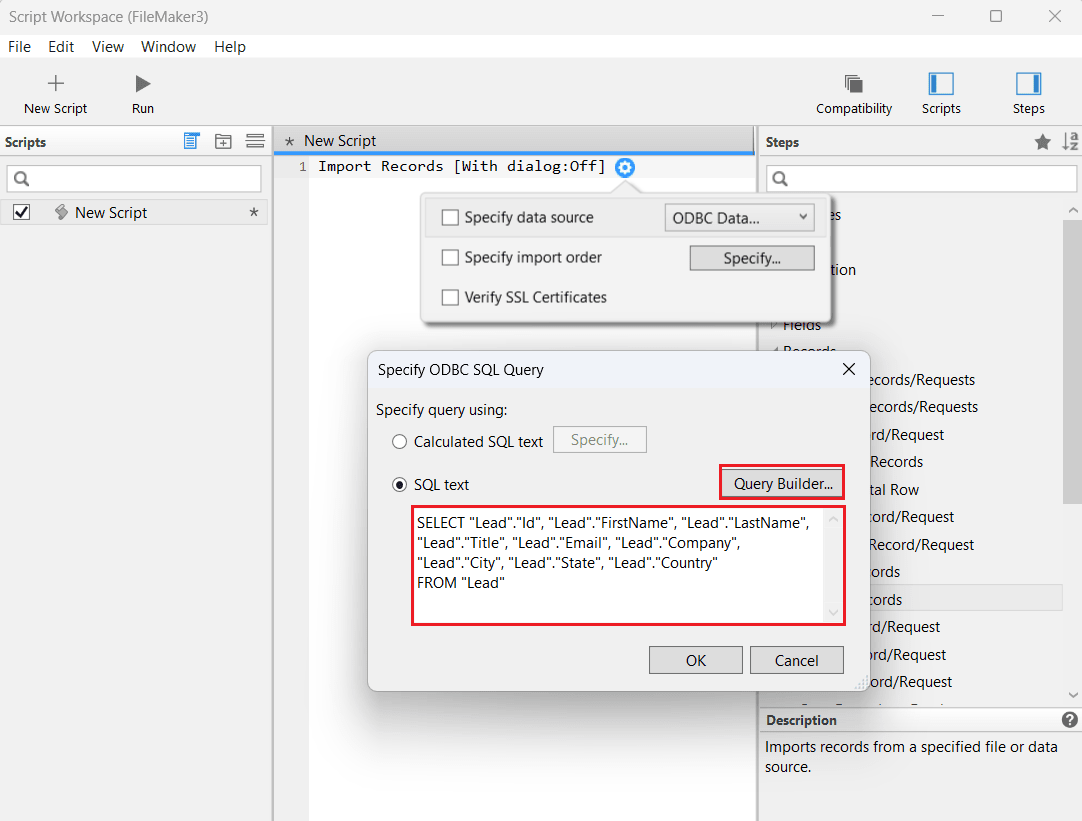

- 右側の Steps パネルから Records > Import Records > Insert into Script を選択します。

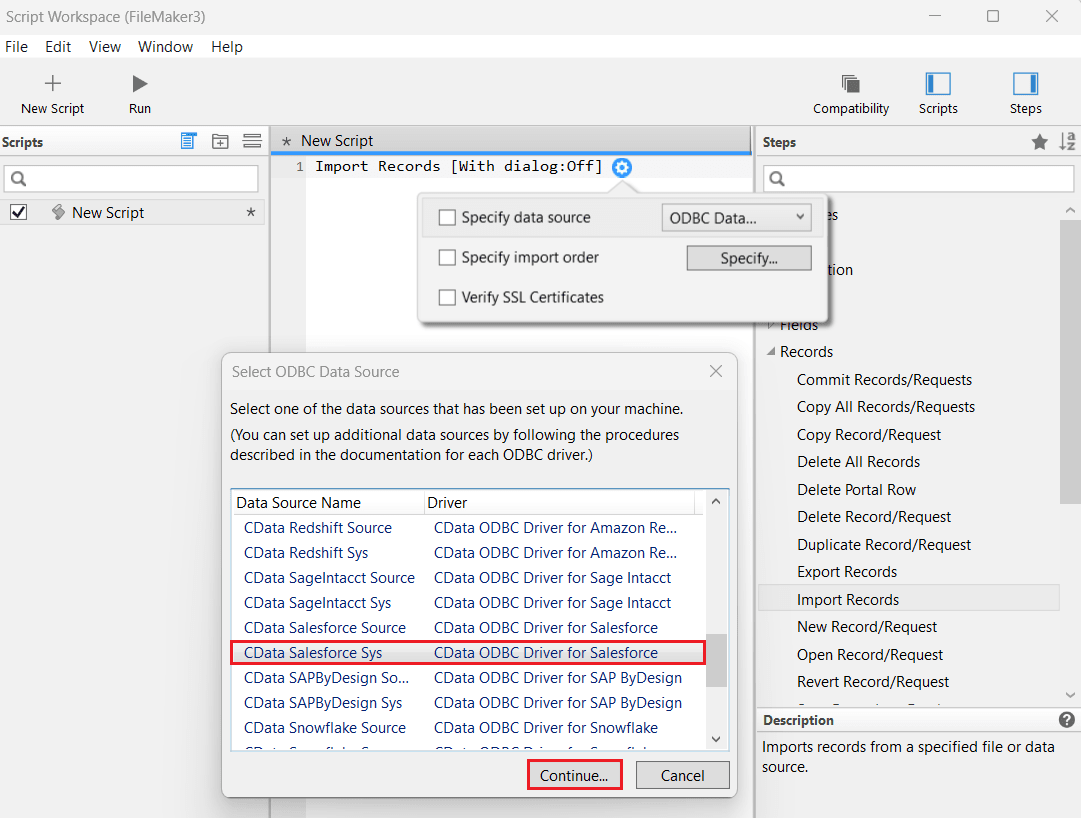

- Specify Data Source ドロップダウンで ODBC Data を選択します。

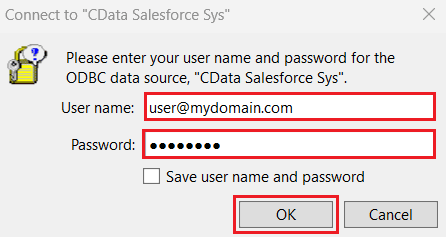

- Select ODBC Data Source ウィンドウから CData SparkSQL Sys を選択し、Continue をクリックします。Spark の資格情報を入力して OK をクリックします。

- Specify ODBC SQL Query ダイアログで、SQL text エディタに SQL クエリを入力して、インポートしたいSpark のデータを指定します。

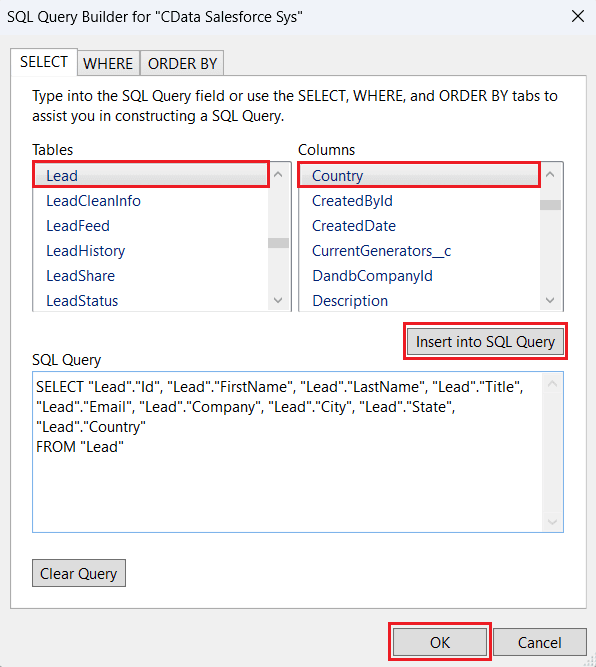

- あるいは、Query Builder を選択して SQL Query Builder ウィンドウを開きます。Tables セクションから対象テーブルを選択し、Columns セクションから関連するカラムを選択します。各選択後に Insert into SQL Query をクリックしてクエリを自動生成します。WHERE や ORDER BY 句、または専用のタブを使用してクエリを手動で編集することもできます。OK をクリックしてクエリを確定します。

- OK をクリックします。

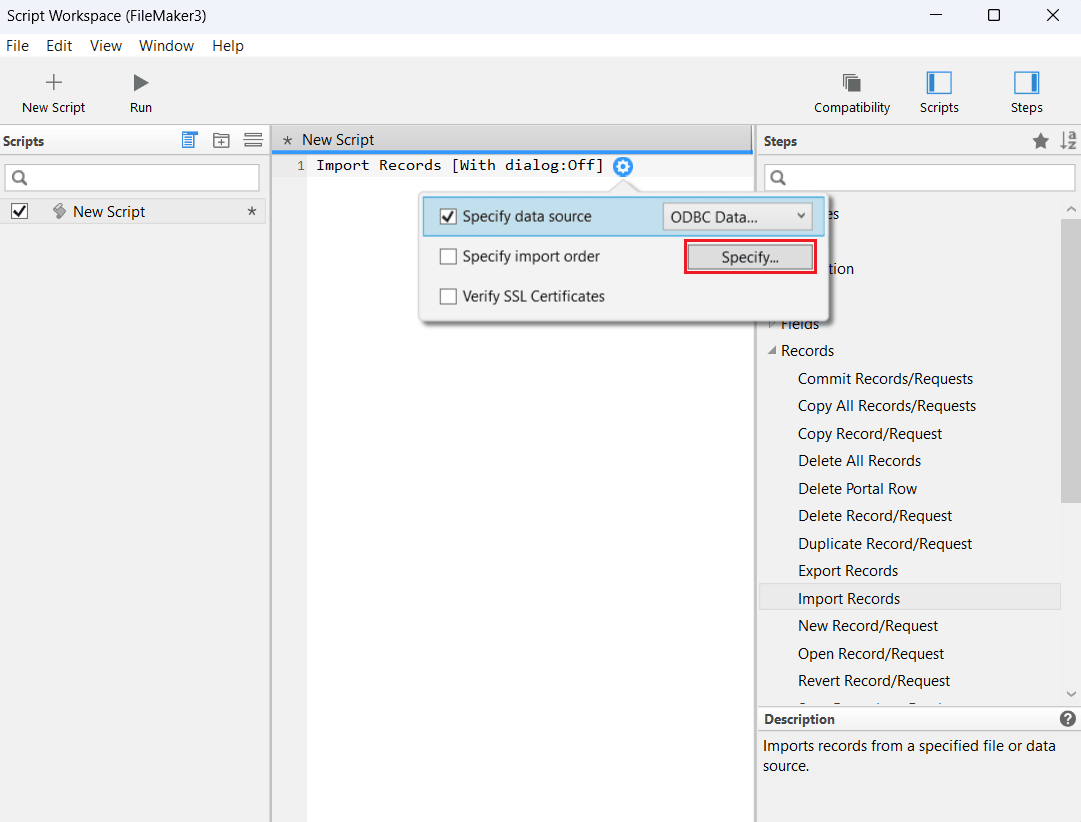

- Specify import order オプションで Specify をクリックし、Spark の資格情報を入力します。

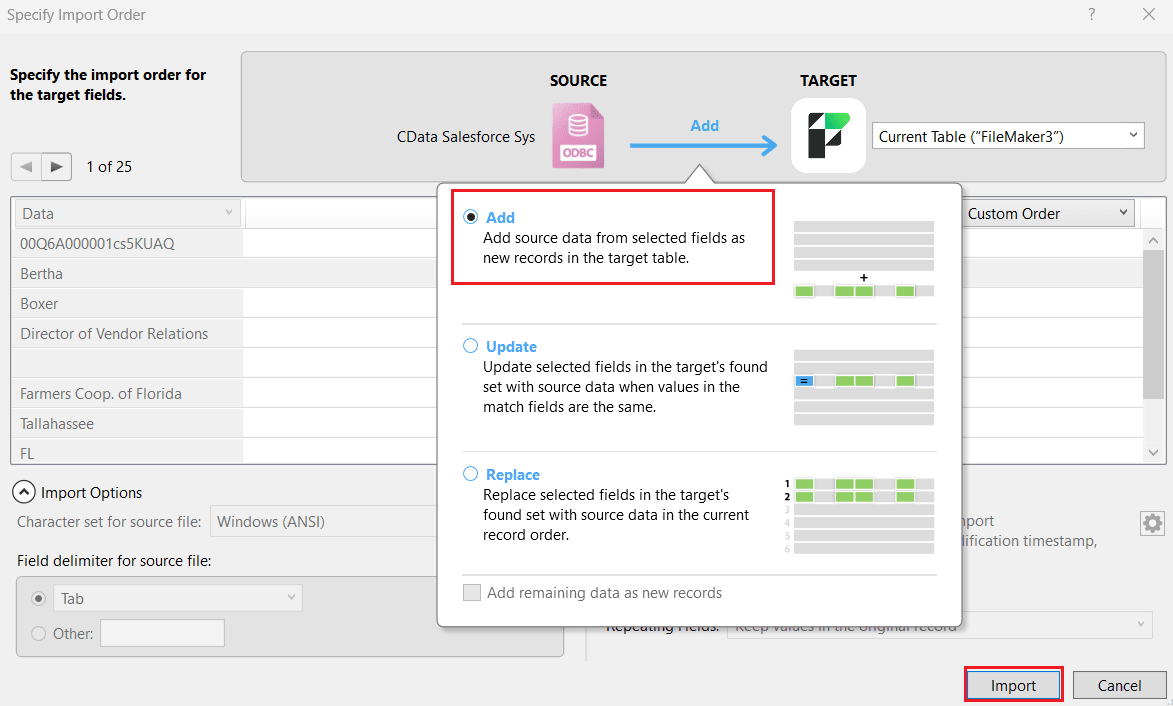

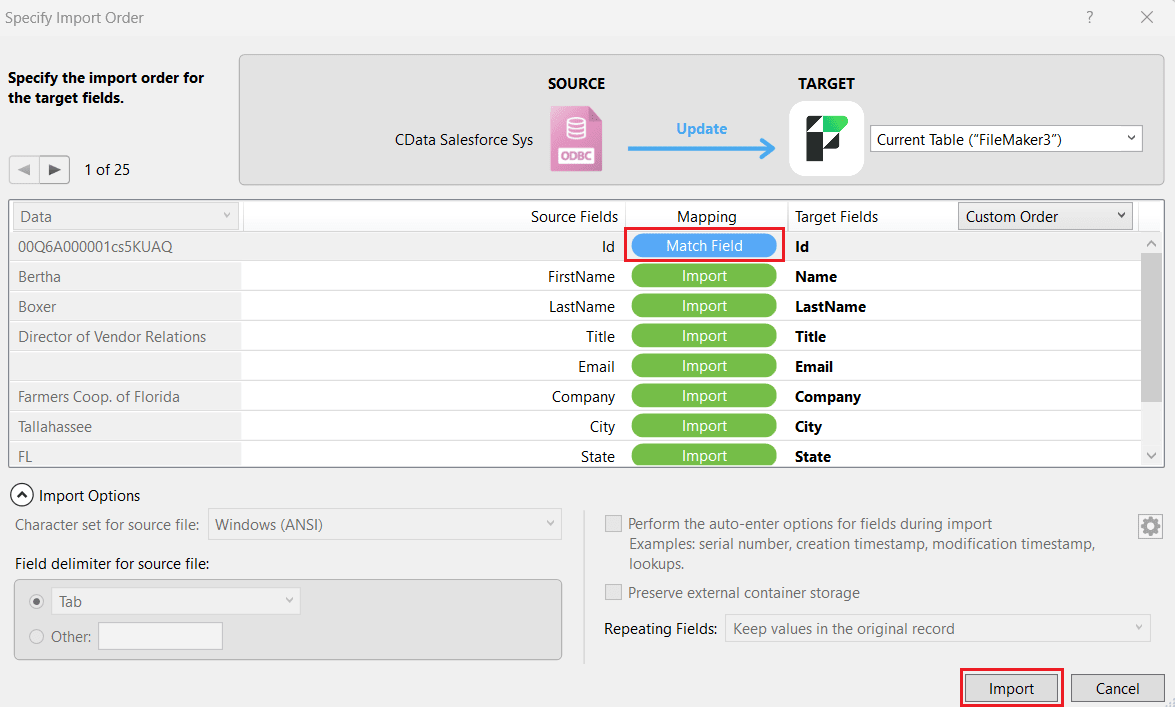

- Specify Import Order ウィンドウで、先ほど追加したターゲットフィールドのインポート順序を定義します。ソースフィールドとターゲットフィールドの間で Add を選択して、Spark のデータを新しいレコードとしてテーブルに挿入します。Import をクリックします。

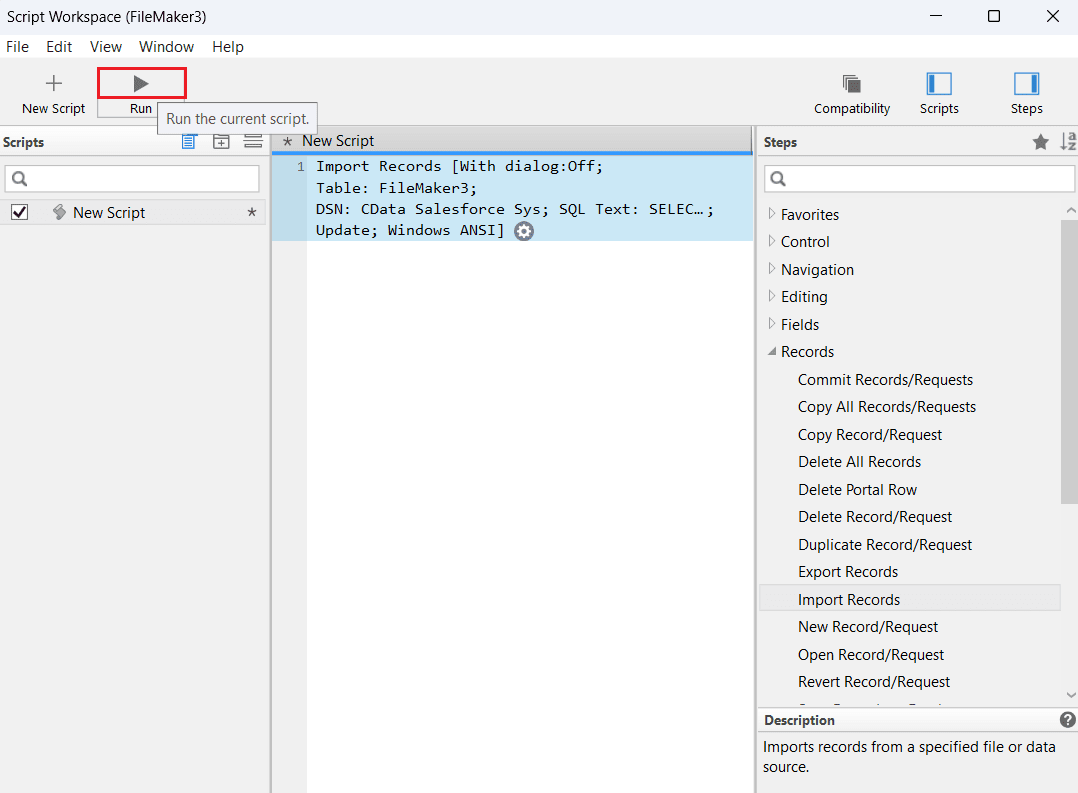

- これでスクリプトがワークスペースに表示されます。Run をクリックしてスクリプトを実行し、インポートを処理します。

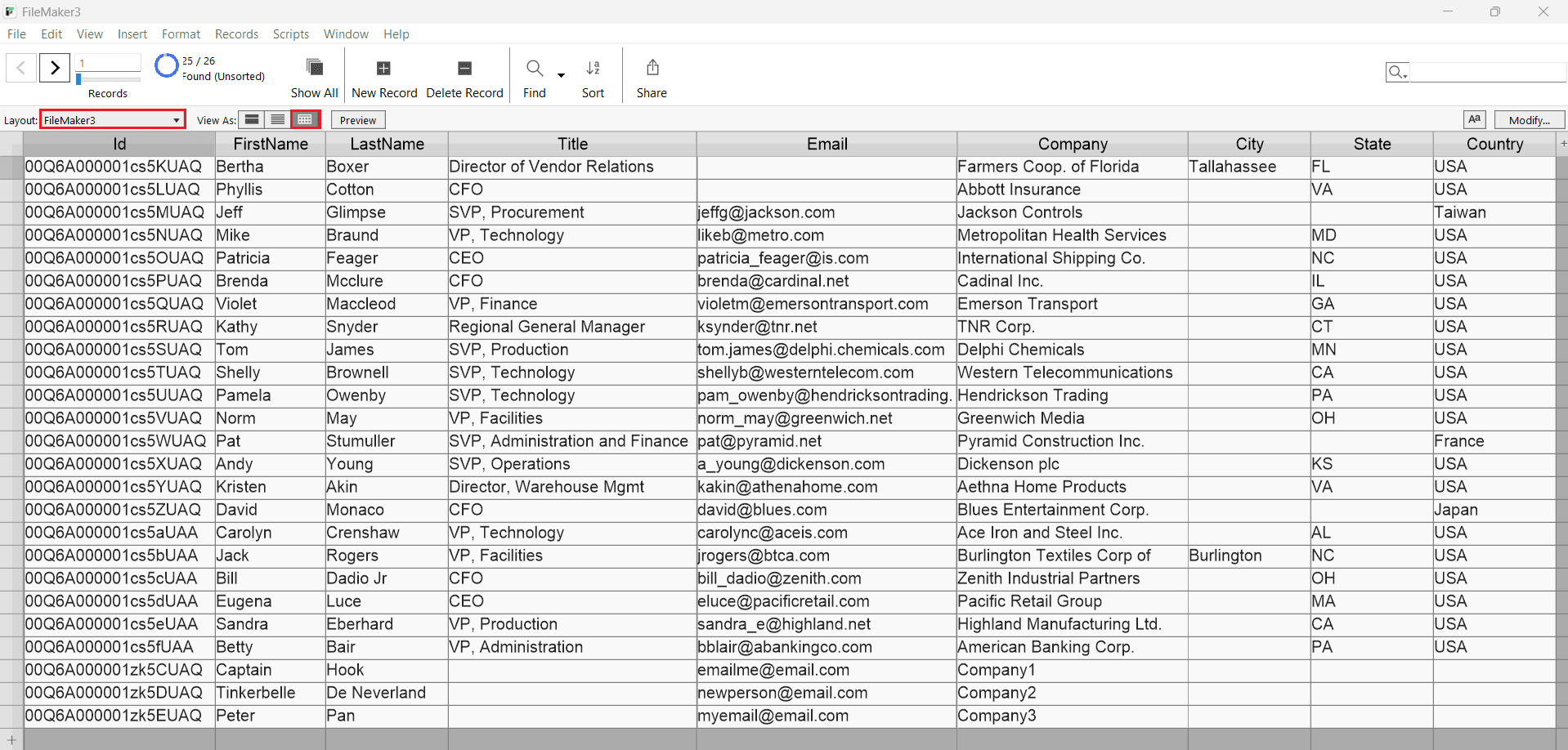

- FileMaker がSpark のデータをテーブルとしてインポートします。

スクリプトを使ったインポート済みデータの更新または置換

Spark のデータを FileMaker にインポートした後、以下の手順でスクリプトを使ってSpark で行われた変更を更新または置換できます:

- 前のセクションで説明した手順に従って Script Workspace に戻ります。

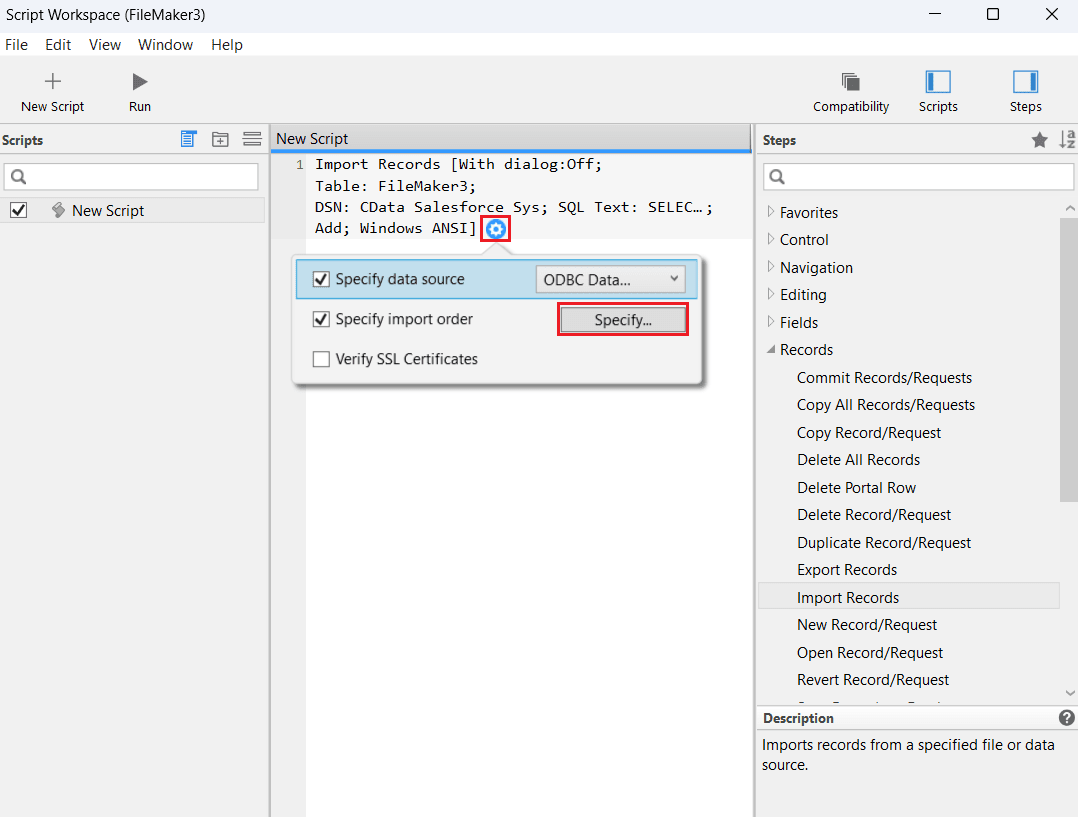

- 既存のスクリプトを選択し、設定ボタンをクリックして Specify Import Order の下の Specify を選択し、認証のためにSpark の資格情報を再入力します。

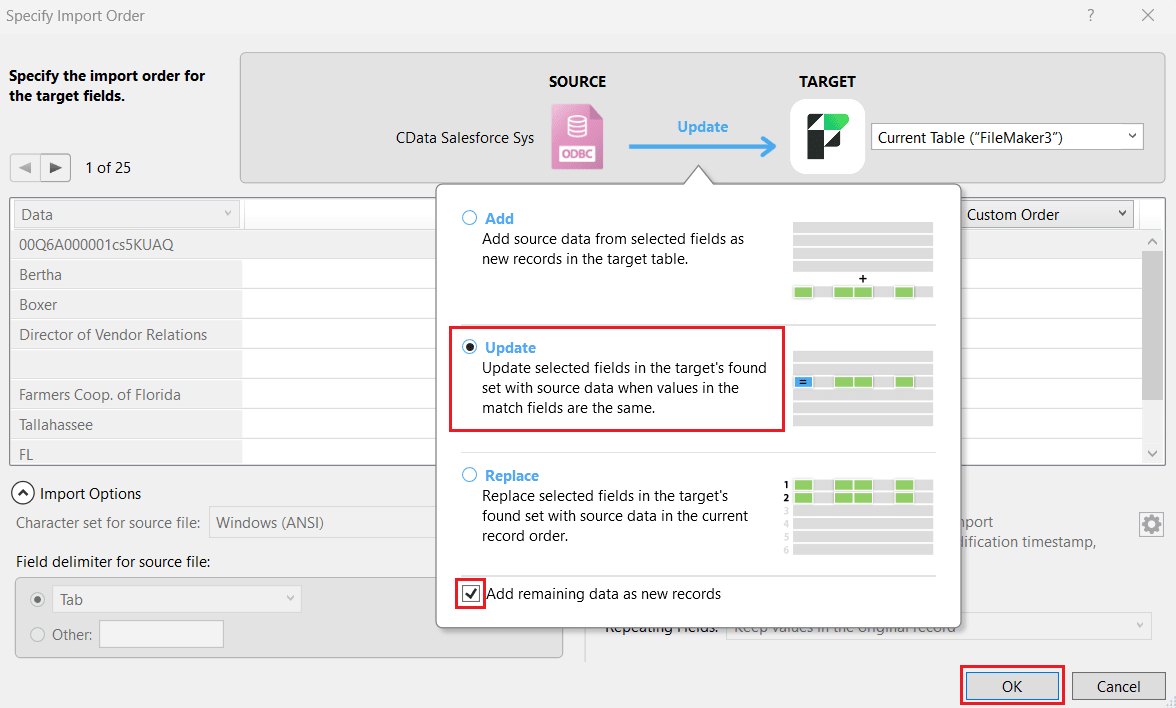

- Specify Import Order ウィンドウで、ソースとターゲットの間で Update を選択して、インポート済みのSpark データを更新します。これにより、マッチフィールドの値が同じ場合に、選択したフィールドのSpark データ値でターゲットの検索セットが更新されます。マッピングで少なくとも1つのマッチフィールドを定義し、Add remaining data as new records チェックボックスを選択する必要があります。Import をクリックします。

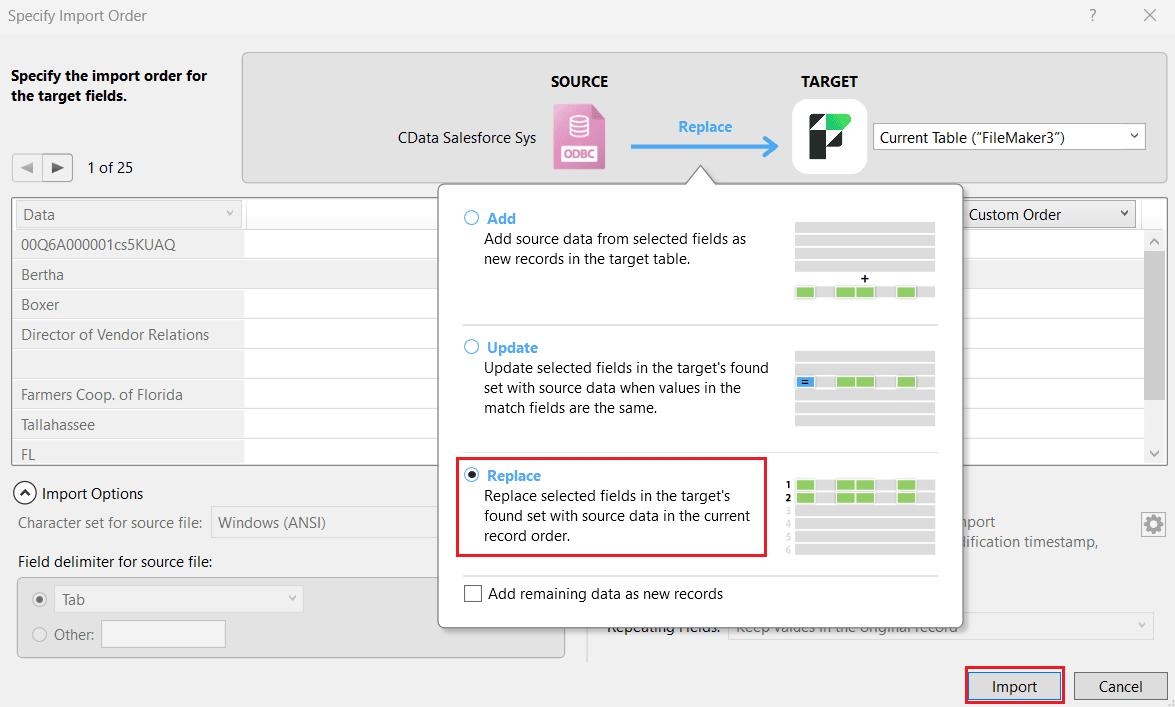

- あるいは、ユースケースに応じて Update の代わりに Replace オプションを選択します。これにより、ターゲットの検索セット内の選択したフィールドが、現在のレコード順序でSpark のデータに置換されます。Import をクリックします。

- FileMaker がスクリプトをワークスペースに追加します。Run をクリックしてスクリプトを実行し、インポートクエリを処理します。

- FileMaker が更新または置換されたSpark のデータをテーブルとしてインポートします。

今すぐ始めましょう

CData ODBC Driver for Apache Spark の30日間無償トライアルをダウンロードして、Spark のデータを Claris FileMaker に統合し、FileMaker アプリケーションでSpark のデータを活用してみてください。

ご質問がある場合は、サポートチームまでお問い合わせください。