Spark のデータ を Microsoft Fabric の OneLake に自動で継続的にレプリケーションする方法

常時稼働のアプリケーションには、自動フェイルオーバー機能とリアルタイムのデータアクセスが欠かせません。CData Sync を使えば、Microsoft Fabric の OneLake インスタンスにSpark のデータをリアルタイムで統合できます。すべてのデータを1カ所に集約し、アーカイブ、レポーティング、分析、機械学習、AI などさまざまな用途に活用できます。

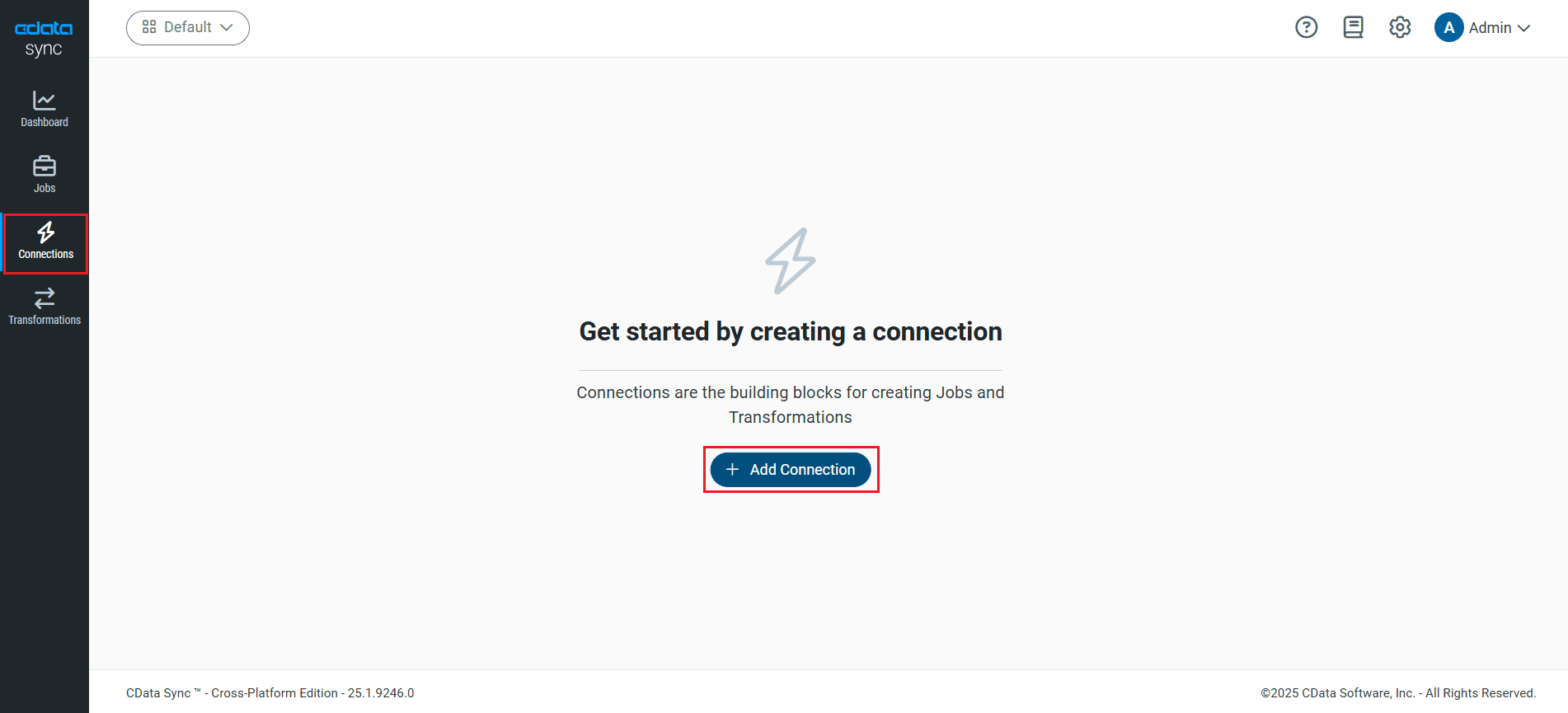

OneLake を同期先として設定する

CData Sync を使って、Spark のデータ を OneLake にレプリケーションできます。同期先を追加するには、接続タブに移動します。

- 接続の追加をクリックします。

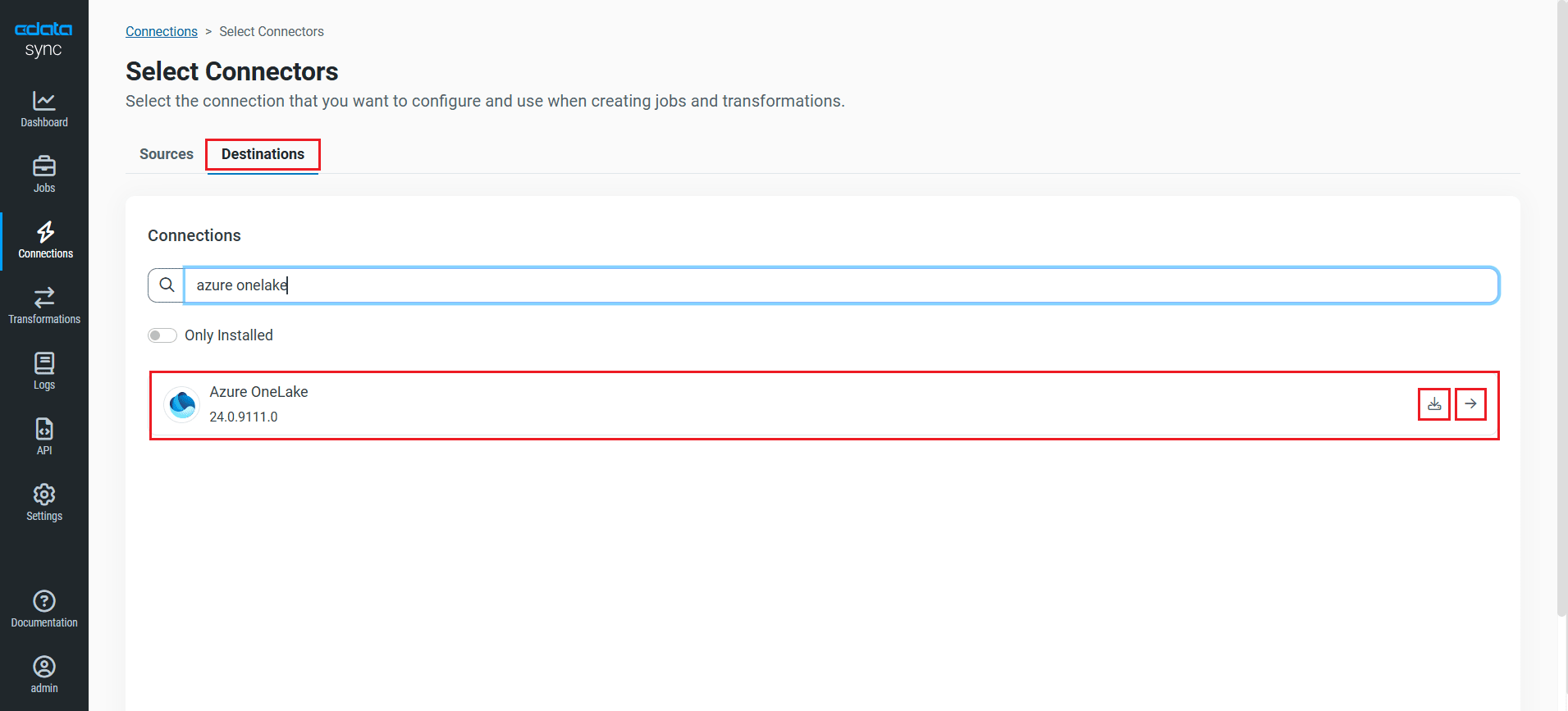

- 同期先タブをクリックし、Azure OneLake コネクタを探します。

- 該当行の末尾にある接続の設定アイコンをクリックして、新しい接続ページを開きます。接続の設定アイコンが表示されていない場合は、コネクタのダウンロードアイコンをクリックして OneLake コネクタをインストールします。新しいコネクタのインストールについて詳しくは、ヘルプドキュメントの「接続」セクションをご覧ください。

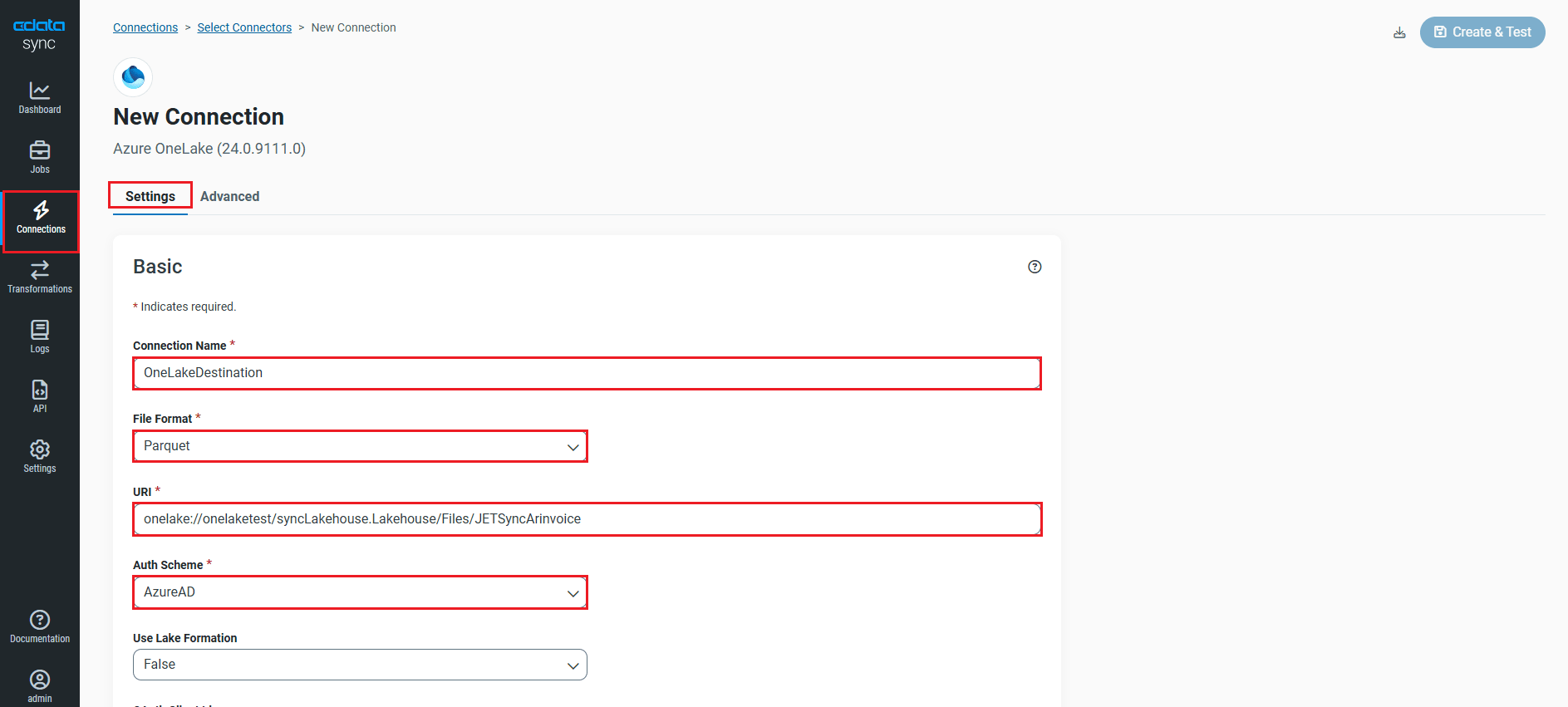

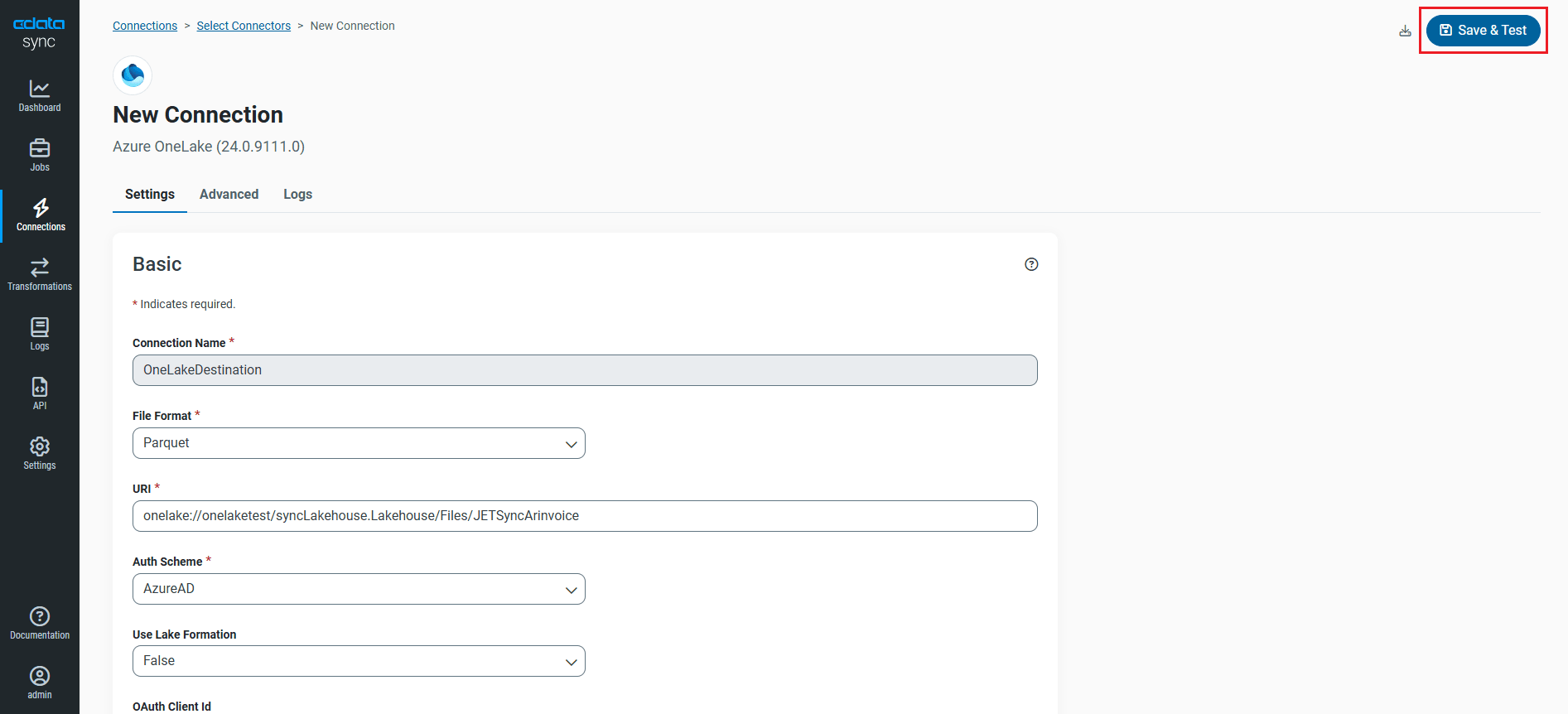

- コネクタが追加されたら、設定の基本タブで以下の接続プロパティを入力して OneLake に接続します:

- 接続名:任意の接続名を入力します。

- File Format:使用するファイル形式を選択します。Sync は CSV、PARQUET、AVRO ファイル形式をサポートしています。

- URI:ファイルを含むファイルシステムとフォルダのパスを入力します(例:onelake://Workspace/Test.LakeHouse/Files/CustomFolder)。

- Auth Scheme:Azure Active Directory(AD)ユーザーアカウントで接続する場合は、Auth Scheme にAzure ADを選択します。CData Sync には組み込みの OAuth アプリケーションが用意されているため、追加のプロパティ設定は不要です。

- Data Model:選択したファイル形式のドキュメントを解析し、データベースメタデータを生成する際に使用するデータ形式を指定します。

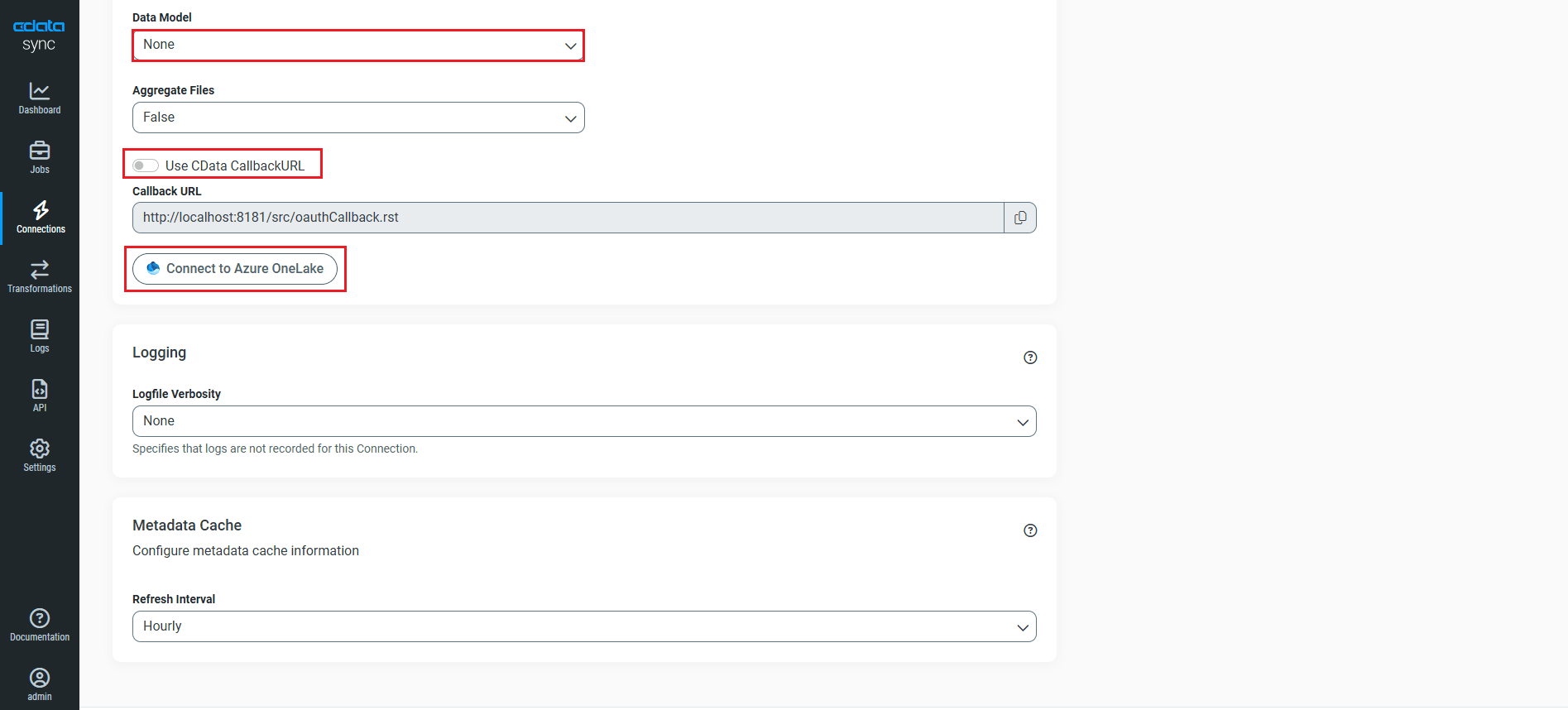

- CData Sync をホスティングしている場合(ローカルまたは独自のクラウド):

- Use CData CallbackURL:トグルを無効にします。

- Callback URL:コールバック URL を入力します。

- CData Sync Cloud を使用している場合は、Use CData CallbackURLトグルを有効のままにしてください。

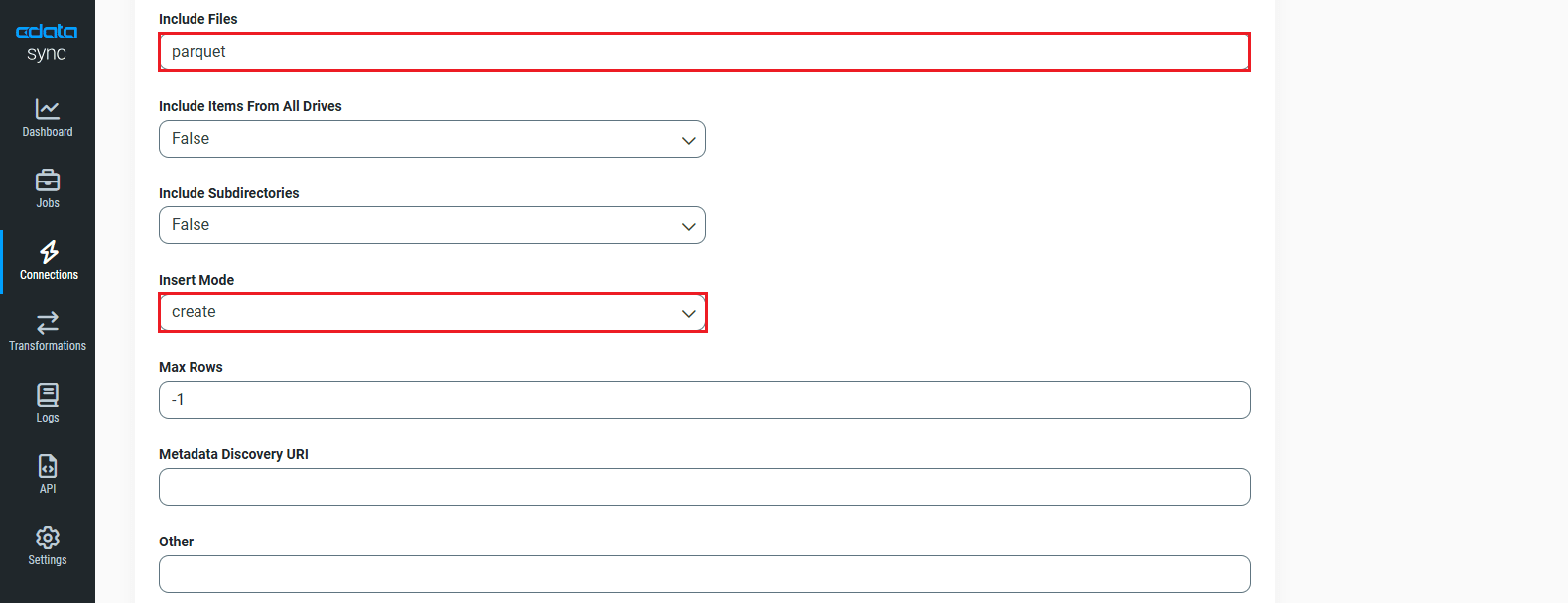

- 詳細タブに移動し、その他セクションまでスクロールします。

- Include Filesに、最初に選択したファイル形式を入力します。

- Insert ModeドロップダウンからCreateを選択します。その他の Insert Mode オプションにはOverwriteとBatchがあります。

- 基本設定に戻り、Azure OneLake に接続をクリックします。

- 接続が確立されたら、作成およびテストをクリックして接続を保存します。

これで OneLake に接続され、データソースとしても同期先としても使用できるようになりました。

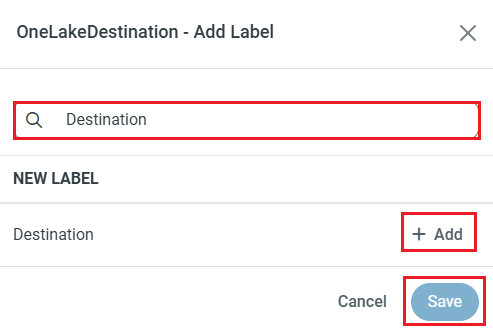

NOTE:ラベル機能を使って、データソースや同期先にラベルを追加できます。

この記事では、Spark のデータ を OneLake にロードし、同期先として活用する方法をご紹介します。

Spark への接続を設定する

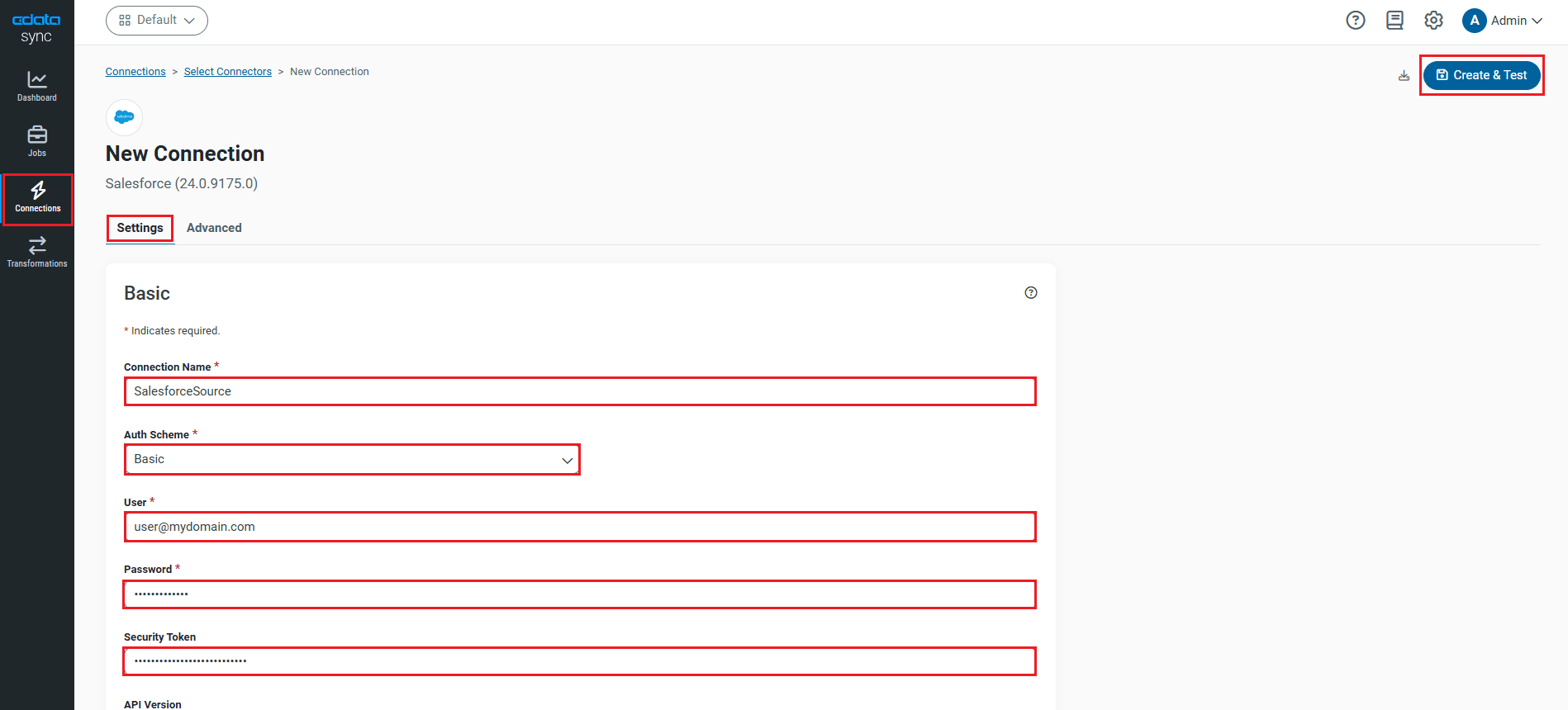

Spark への接続は、接続タブから設定できます。Spark アカウントへの接続を追加するには、接続タブに移動します。

- 接続の追加をクリックします。

- データソース(Spark)を選択します。

- 接続プロパティを設定します。

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

- Spark に接続をクリックして、接続が正しく設定されていることを確認します。

- 作成およびテストをクリックして変更を保存します。

レプリケーションクエリの設定

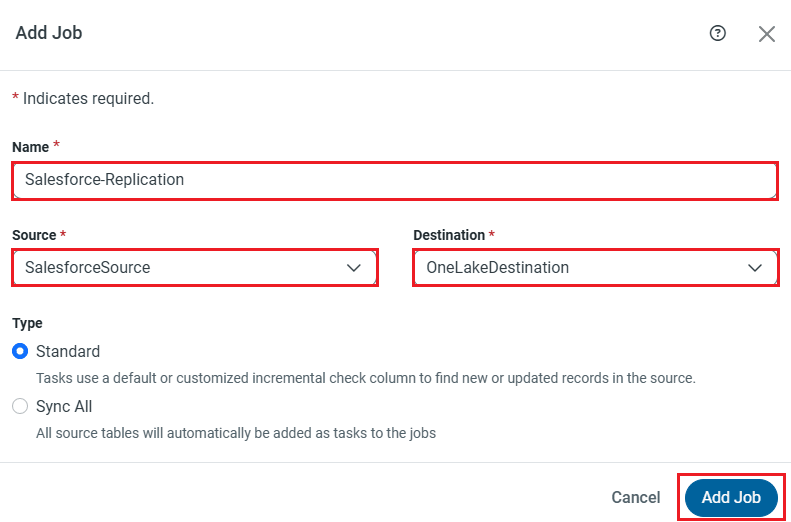

CData Sync では、ポイント&クリック操作と SQL クエリの両方でレプリケーションを制御できます。レプリケーションを設定するには、ジョブタブに移動し、ジョブを追加をクリックします。レプリケーションのデータソースと同期先を選択します。

ジョブの編集

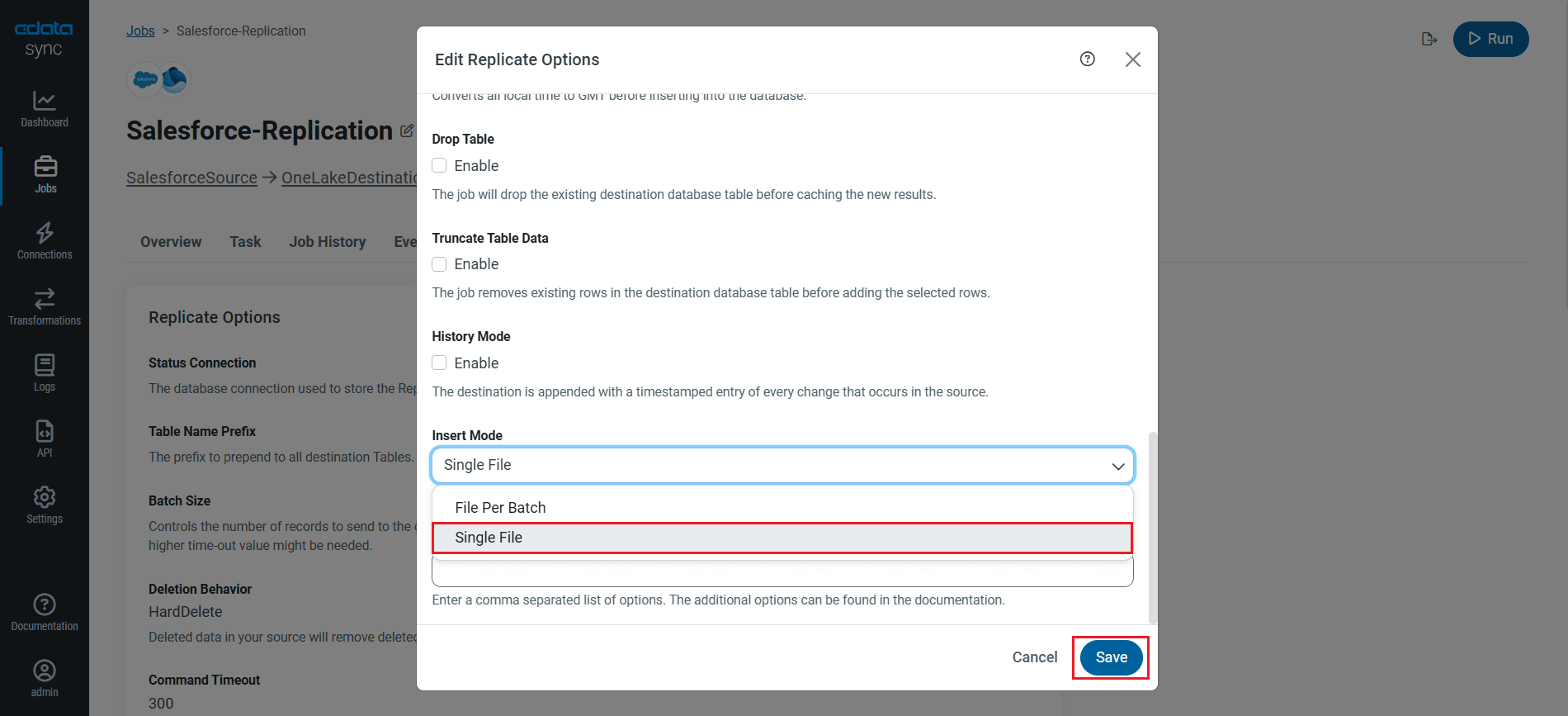

- ジョブの詳細タブで、レプリケーションオプションの編集をクリックし、Insert ModeをSingle Fileに設定します(OneLake コネクタで Insert Mode を「Create」に設定した場合)。

- 「Batch」モードの場合は、ジョブの Insert Mode をFile Per Batchに設定する必要があります。

- 「Overwrite」モードの場合は、Single FileとFile Per Batchのどちらも使用できます。

テーブル全体をレプリケーションする

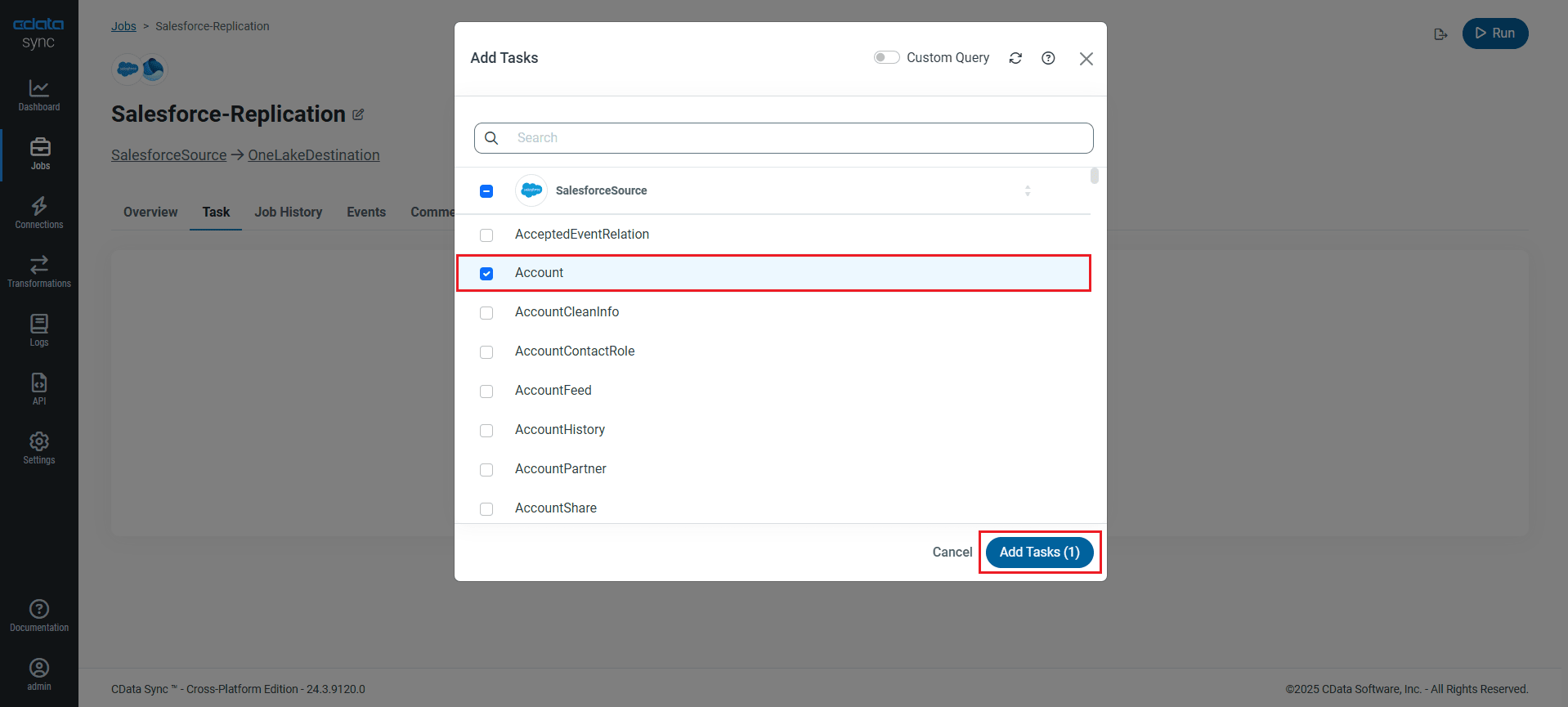

テーブル全体をレプリケーションするには、ジョブのタスクタブでタスクを追加をクリックし、OneLake にレプリケーションしたい Spark テーブルをリストから選択して、再度タスクを追加をクリックします。

レプリケーションのカスタマイズ

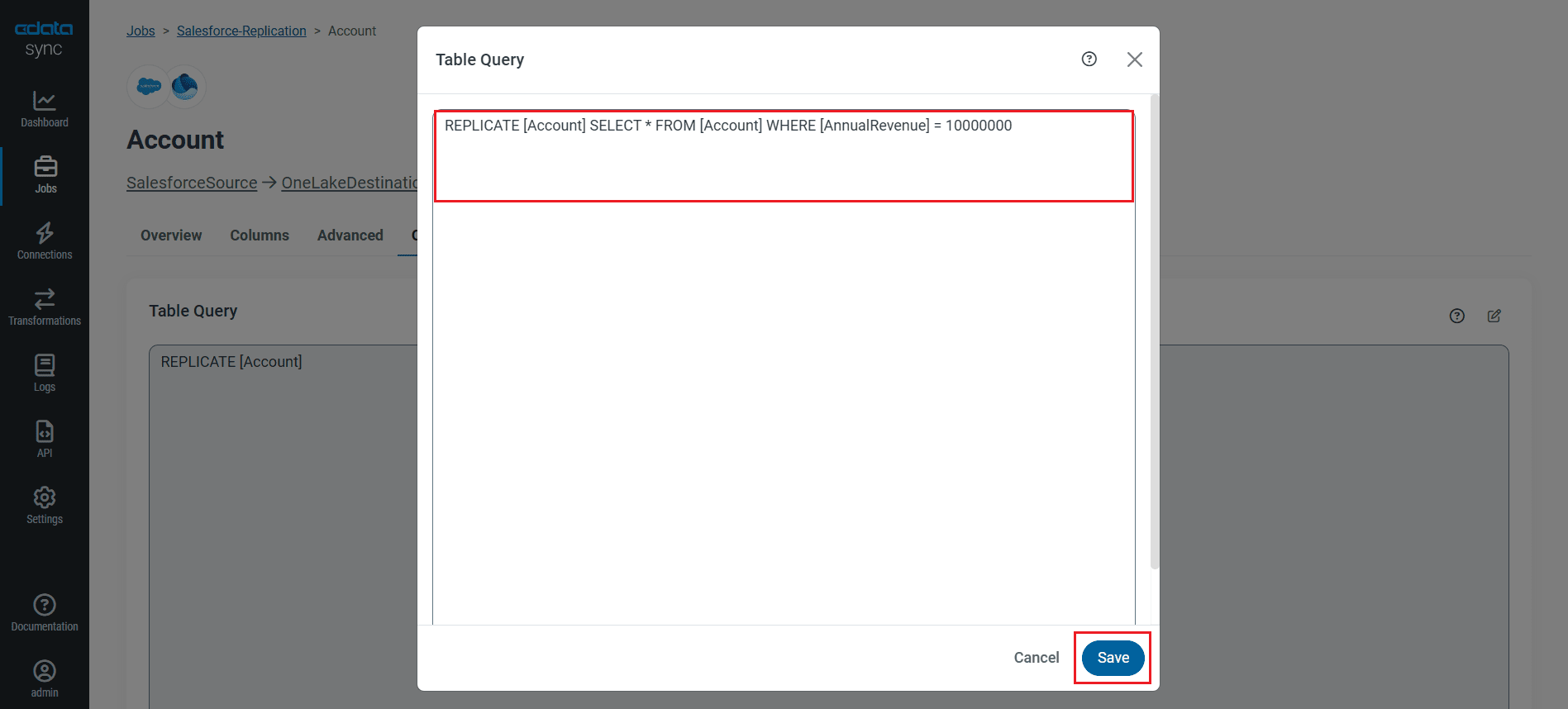

タスクのカラムタブとクエリタブを使って、レプリケーションをカスタマイズできます。カラムタブでは、レプリケーションするカラムの指定、同期先でのカラム名の変更、レプリケーション前のデータ操作などが可能です。クエリタブでは、SQL クエリを使ってフィルタ、グループ化、ソートを追加できます。

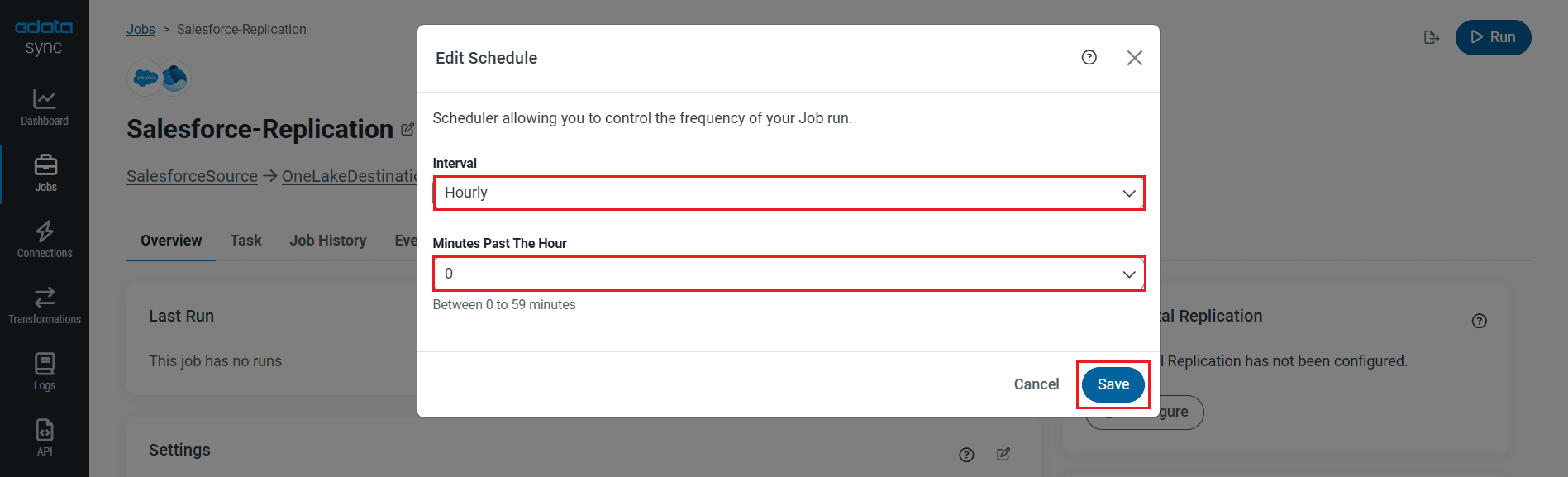

レプリケーションのスケジュール

ジョブの概要タブを選択し、スケジュールの下にある設定をクリックします。10分ごとから月1回まで、指定した間隔でジョブを自動実行するようにスケジュールできます。

レプリケーションジョブを設定したら、変更を保存をクリックします。Spark のデータ から OneLake へのレプリケーションを管理するジョブをいくつでも設定できます。

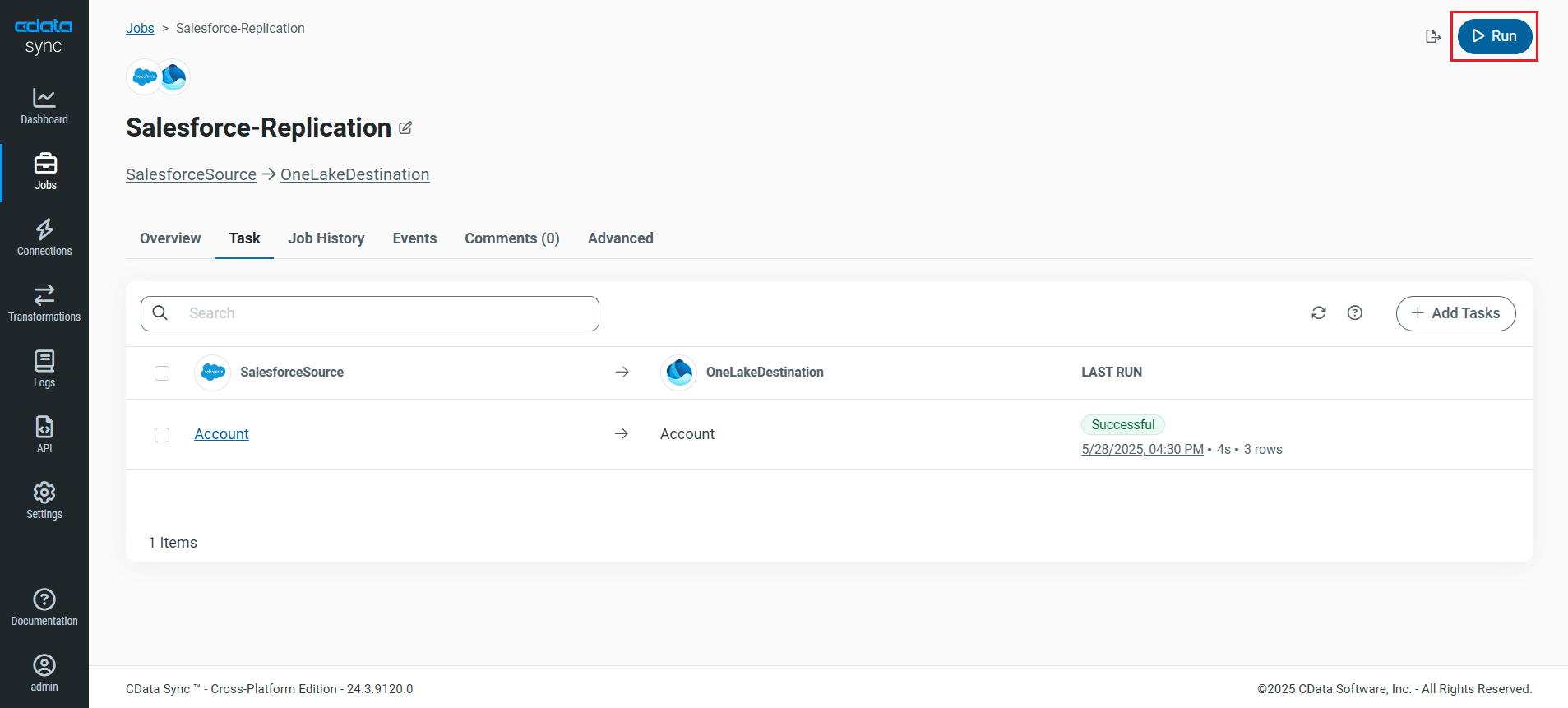

レプリケーションジョブの実行

ジョブに必要なすべての設定が完了したら、レプリケーションしたい Spark テーブルを選択し、実行をクリックします。レプリケーションが正常に完了すると、ジョブの実行時間とレプリケーションされた行数を示す通知が表示されます。

無料トライアル & 詳細情報

Spark のデータ を OneLake にレプリケーションする方法をご覧いただきました。CData Sync ページで詳細をご確認いただき、30日間の無料トライアルをダウンロードして、エンタープライズデータの統合を始めましょう。

ご不明な点がございましたら、サポートチームがいつでもお手伝いいたします。