Tableau Prep で Spark のデータ にリアルタイム接続してビジュアライズする方法

Tableau は、企業がデータを活用して課題を解決する方法を変革するビジュアル分析プラットフォームです。CData Tableau Connector for Apache Spark と組み合わせることで、Tableau Prep からSpark のデータに簡単にアクセスできるようになります。この記事では、Tableau Prep で Spark に接続し、シンプルなチャートを作成する方法をご紹介します。

CData Tableau Connector を使用すると、Tableau からSpark のデータに高速でアクセスできます。コネクタをインストールしたら、Spark で認証するだけで、レスポンシブで動的なビジュアライゼーションとダッシュボードの構築をすぐに開始できます。CData Tableau Connector は、ネイティブの Tableau データ型でSpark のデータを提供し、複雑なフィルタ、集計などの操作を自動的に処理することで、Spark のデータ へのシームレスなアクセスを実現します。

NOTE:CData Tableau Connector は、Tableau Prep Builder 2020.4.1 以降をサポートしています。それ以前のバージョンの Tableau Prep Builder をご使用の場合は、CData JDBC Driver をご利用ください。 Tableau Cloud でSpark のデータに接続したい場合は、CData Connect AI をご利用ください。

CData Tableau Connector のインストール

CData Tableau Connector for Spark をインストールすると、インストーラが TACO ファイルと JAR ファイルを適切なディレクトリにコピーします。以下の接続手順でデータソースが表示されない場合は、2つのファイルをコピーする必要があります:

- コネクタのインストール先(Windows では C:\Program Files\CData\CData Tableau Connector for Spark 20XX\lib)にある lib フォルダ内の TACO ファイル(cdata.sparksql.taco)を、Tableau Prep Builder リポジトリにコピーします:

- Windows:C:\Users\[Windows ユーザー]\Documents\My Tableau Prep Repository\Connectors

- MacOS:/Users//Documents/My Tableau Prep Repository/Connectors

- 同じ lib フォルダ内の JAR ファイル(cdata.tableau.sparksql.jar)を、Tableau のドライバーディレクトリ(通常 [Tableau のインストール先]\Drivers)にコピーします。

Tableau Prep Builder で Spark に接続する

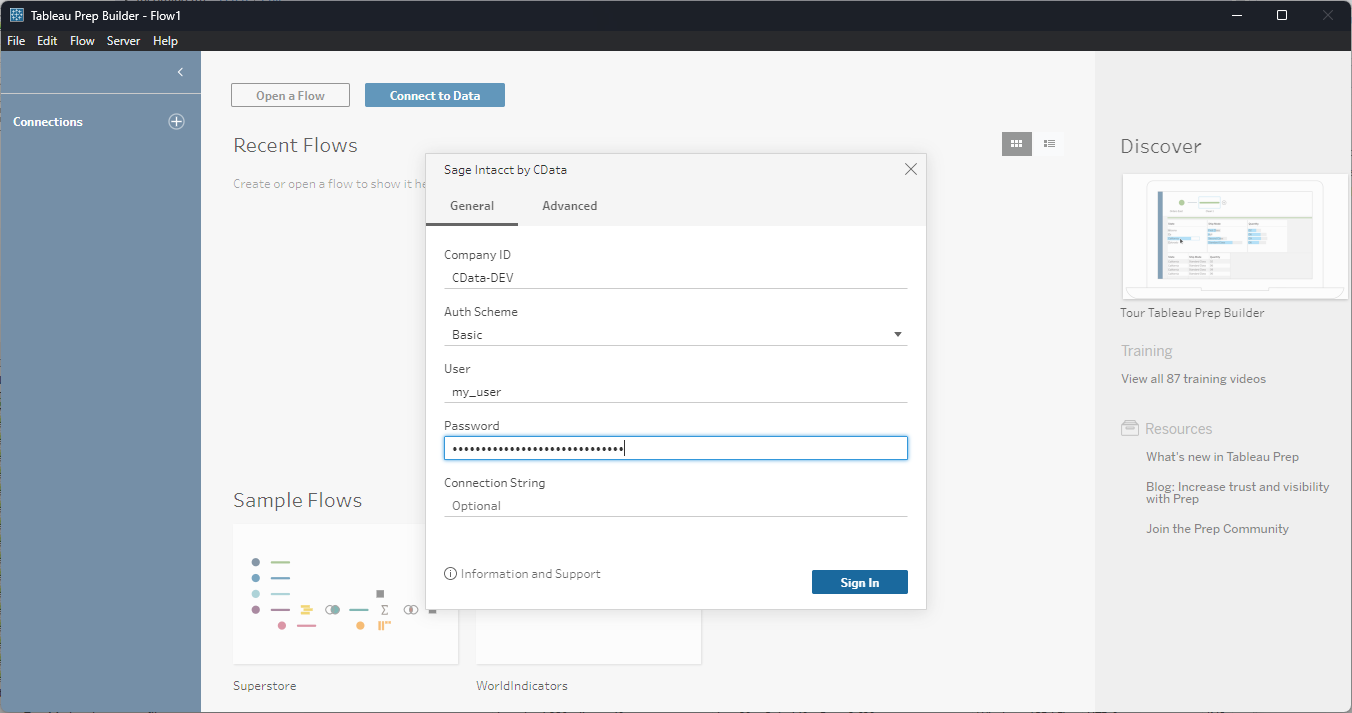

Tableau Prep Builder を開き、「データに接続」をクリックして「Spark by CData」を検索します。接続を設定し、「サインイン」をクリックします。

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

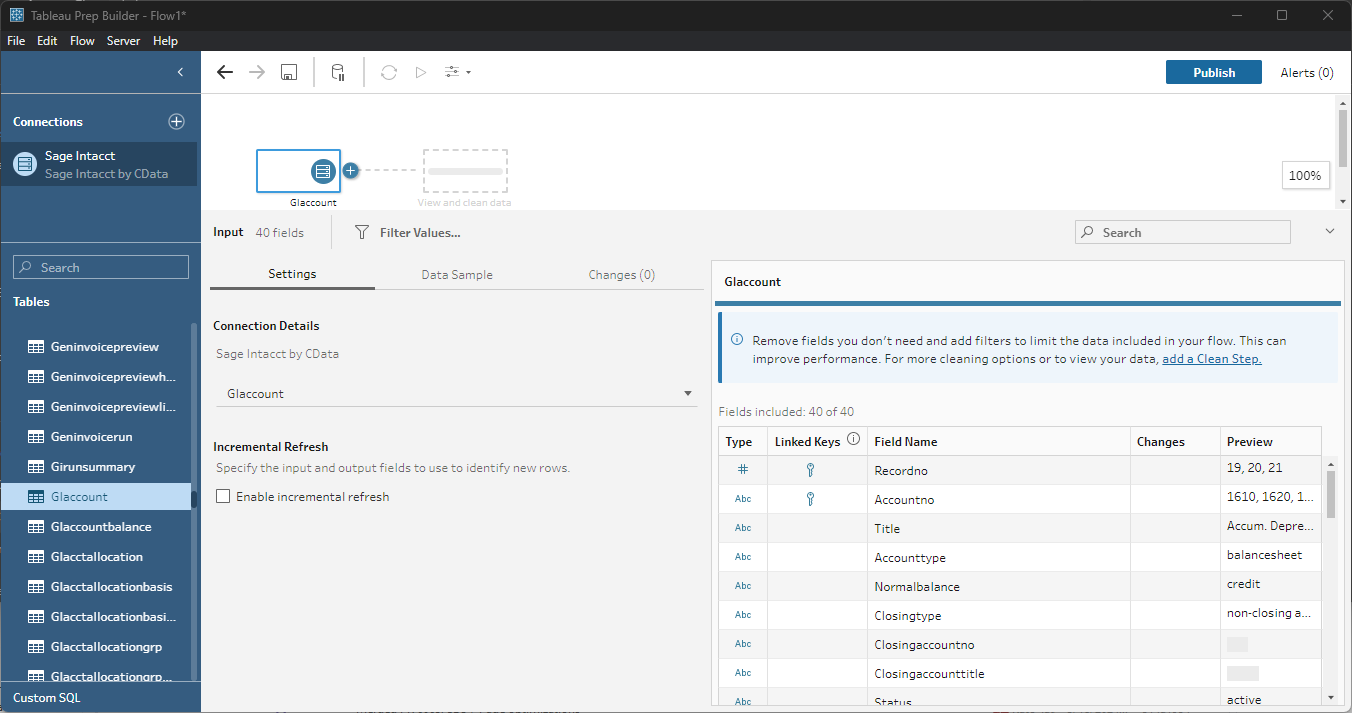

データの探索と準備

操作したいテーブルとビューをキャンバスにドラッグします。複数のテーブルを含めることができます。

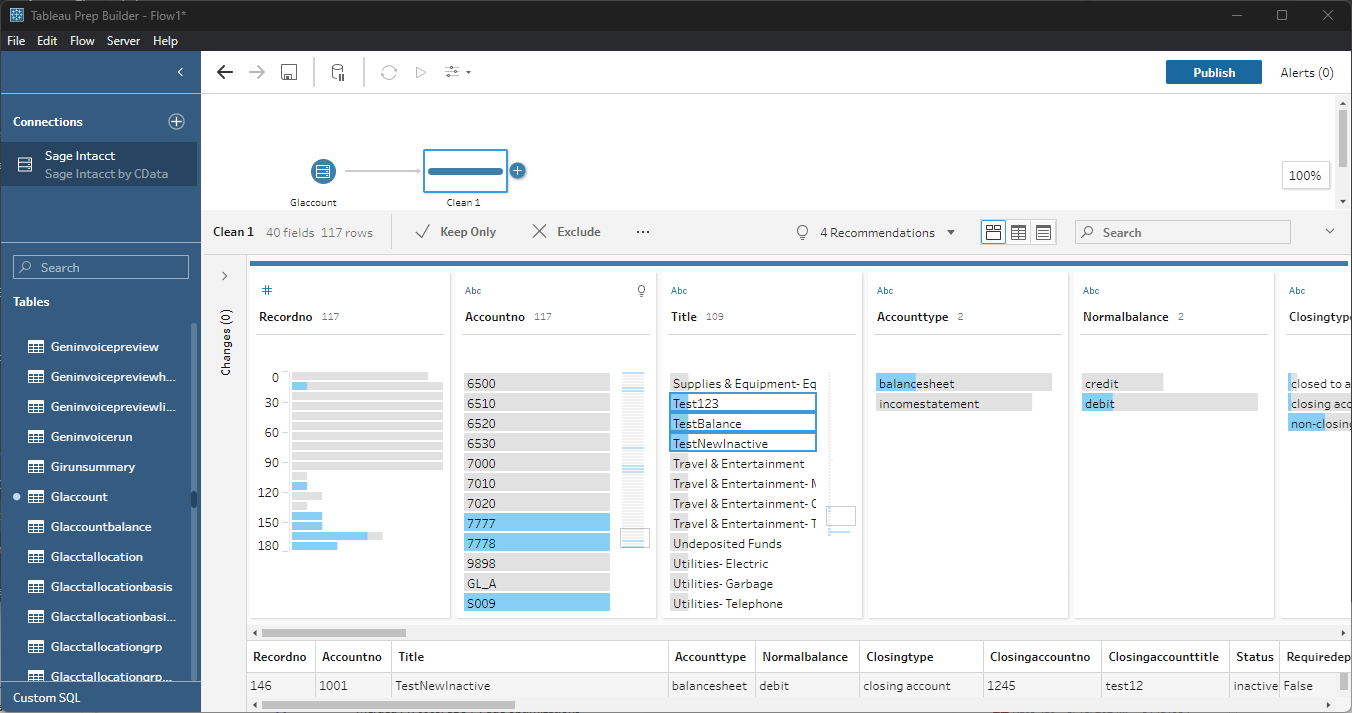

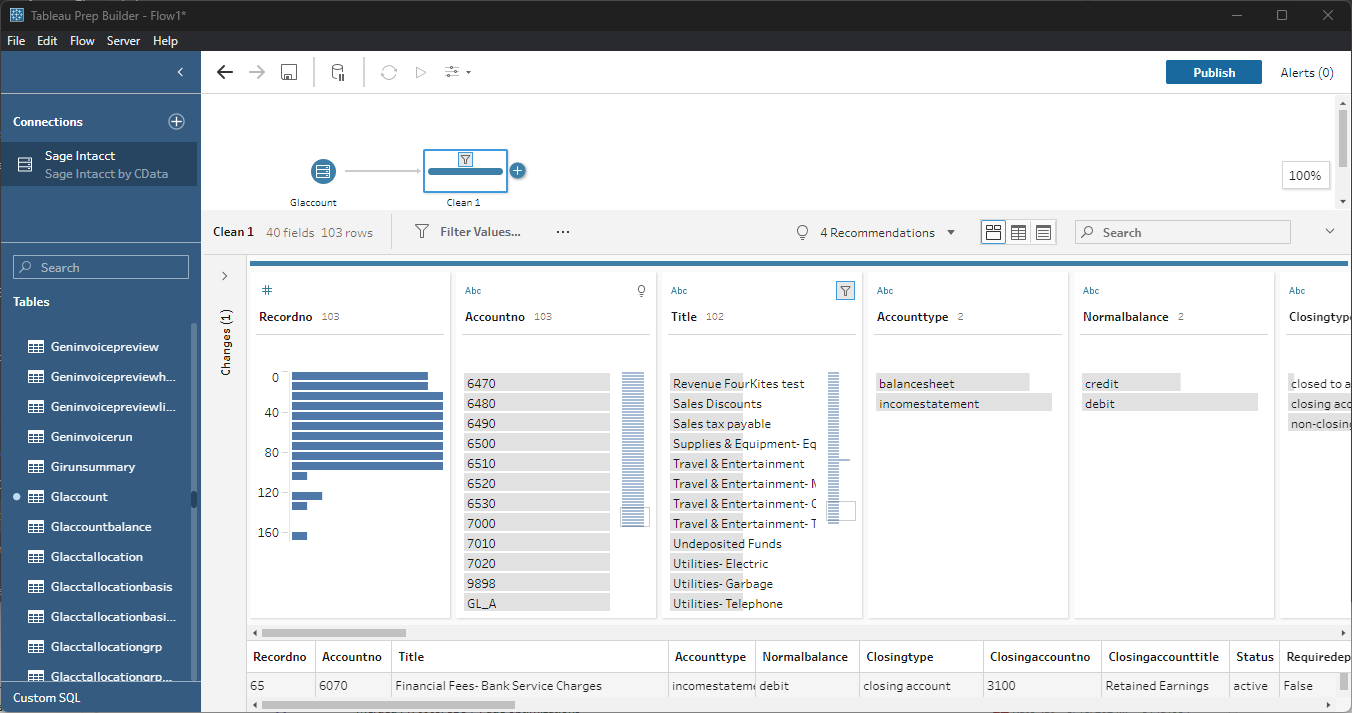

データのクレンジングとフィルタリング

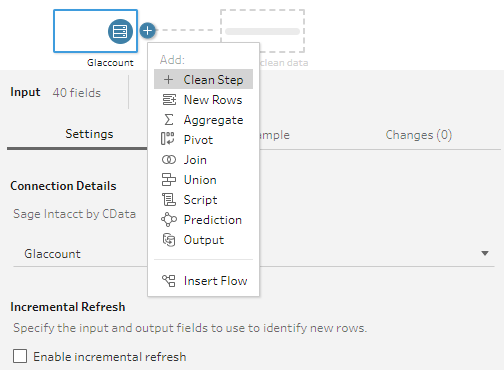

データをさらに準備するために、フィルタの適用、重複の削除、カラムの変更などを行うことができます。

- まず、テーブルの横にあるプラス をクリックし、「クリーンステップ」オプションを選択します。

- フィルタするフィールド値を選択します。値を選択すると、その選択が他のフィールドにどのように影響するかを確認できます。

- 選択した値を持つエントリを「保持のみ」または「除外」を選ぶと、それに応じてデータが変更されます。

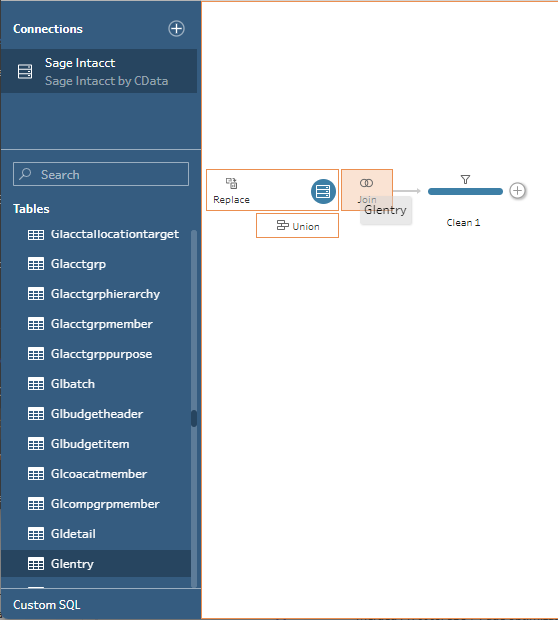

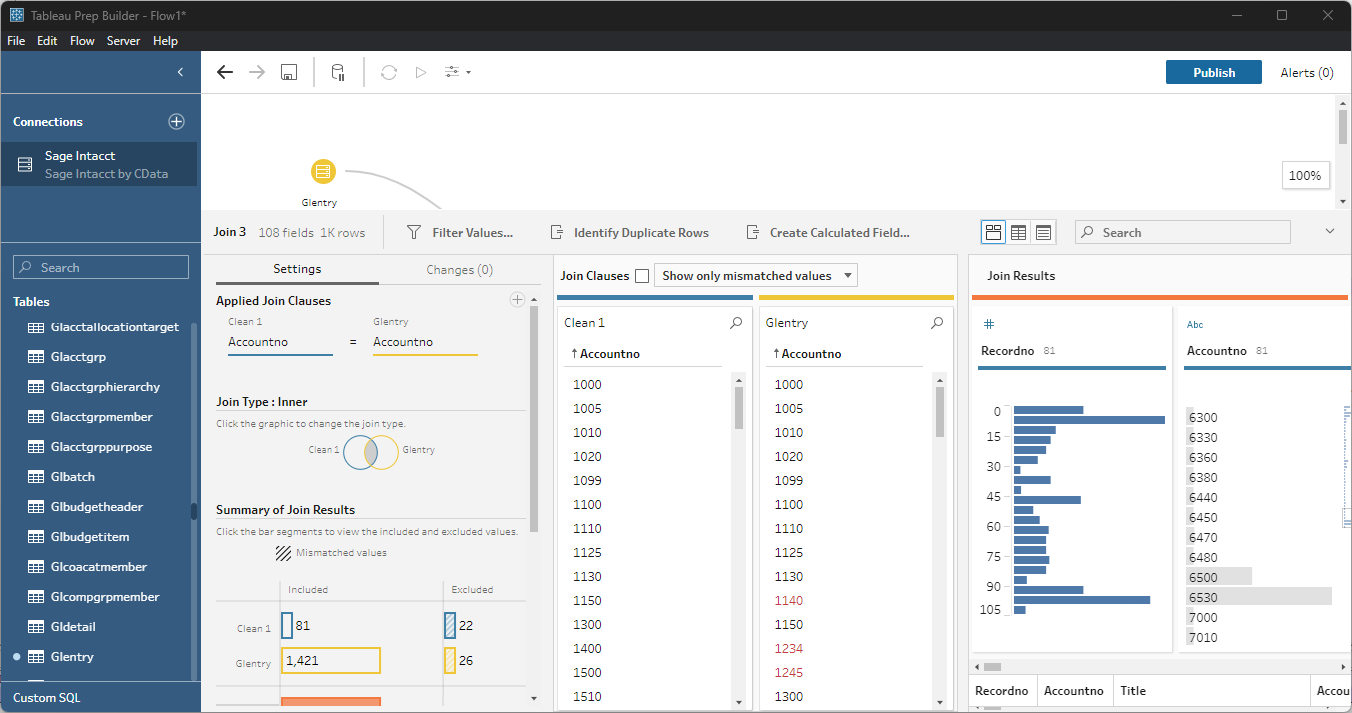

データの結合とユニオン

データ結合とは、共通のフィールドまたはキーに基づいて、2つ以上の関連テーブルからデータを組み合わせることです。

- 複数のテーブルを結合するには、関連テーブルをキャンバス上の既存のテーブルの横にドラッグし、結合ボックスに配置します。

- 両方のテーブルに存在する外部キーを選択します。

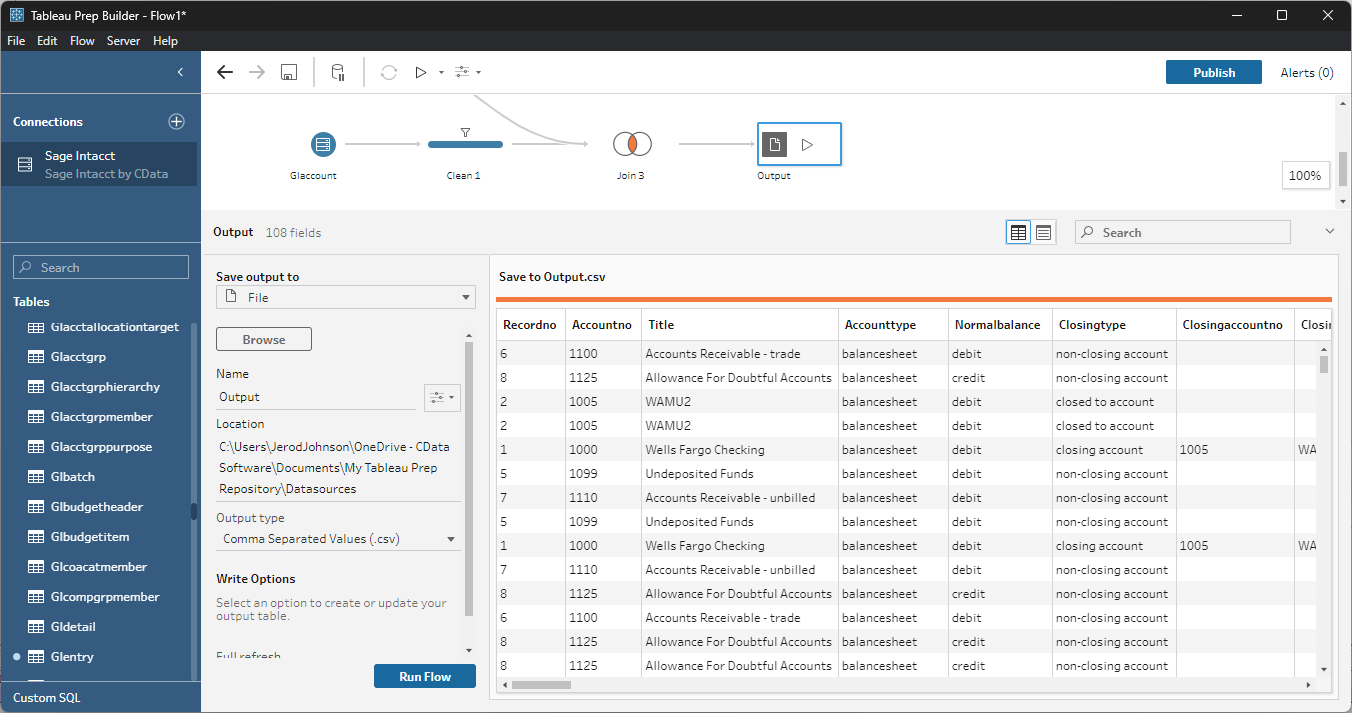

準備したデータのエクスポート

クレンジング、フィルタリング、変換、結合を行った後、Tableau でビジュアライズするためにデータをエクスポートできます。

- その他必要な変換を追加し、フローの最後に出力ノードを挿入します。

- 選択した形式でファイルに保存するようにノードを設定します。

出力データが保存されたら、他のファイルソースと同様に Tableau で操作できます。

CData Tableau Connector for Apache Spark と Tableau Prep Builder を使用すると、Spark のデータ の結合、クレンジング、フィルタリング、集計を簡単に行い、Tableau でビジュアライゼーションやレポートを作成できます。30日間の無料トライアルをダウンロードして、今すぐ始めましょう。