Pentaho Data Integration でAzure Data Lake Storage のデータを連携

CData JDBC Driver for Azure Data Lake Storage を使用すると、データパイプラインからリアルタイムデータにアクセスできます。Pentaho Data Integration は、ETL(Extraction, Transformation, and Loading)エンジンであり、データをクレンジングし、アクセス可能な統一フォーマットでデータを格納します。この記事では、Azure Data Lake Storage のデータ に JDBC データソースとして接続し、Pentaho Data Integration で Azure Data Lake Storage のデータ をベースにしたジョブやトランスフォーメーションを構築する方法を説明します。

Azure Data Lake Storage への接続を設定

Azure Data Lake Storage 接続プロパティの取得・設定方法

Azure Data Lake Storage Gen2 への接続

それでは、Gen2 Data Lake Storage アカウントに接続していきましょう。接続するには、以下のプロパティを設定します。

- Account:ストレージアカウントの名前

- FileSystem:このアカウントに使用されるファイルシステム名。例えば、Azure Blob コンテナの名前

- Directory(オプション):レプリケートされたファイルが保存される場所へのパス。パスが指定されない場合、ファイルはルートディレクトリに保存されます

Azure Data Lake Storage Gen2への認証

続いて、認証方法を設定しましょう。CData 製品では、5つの認証方法をサポートしています:アクセスキー(AccessKey)の使用、共有アクセス署名(SAS)の使用、Azure Active Directory OAuth(AzureAD)経由、Azure サービスプリンシパル(AzureServicePrincipal またはAzureServicePrincipalCert)経由、およびManaged Service Identity(AzureMSI)経由です。

アクセスキー

アクセスキーを使用して接続するには、まずADLS Gen2ストレージアカウントで利用可能なアクセスキーを取得する必要があります。

Azure ポータルでの手順は以下のとおりです:

- ADLS Gen2ストレージアカウントにアクセスします

- 設定でアクセスキーを選択します

- 利用可能なアクセスキーの1つの値をAccessKey 接続プロパティにコピーします

接続の準備ができたら、以下のプロパティを設定してください。

- AuthScheme:AccessKey

- AccessKey:先ほどAzure ポータルで取得したアクセスキーの値

共有アクセス署名(SAS)

共有アクセス署名を使用して接続するには、まずAzure Storage Explorer ツールを使用して署名を生成する必要があります。

接続の準備ができたら、以下のプロパティを設定してください。

- AuthScheme:SAS

- SharedAccessSignature:先ほど生成した共有アクセス署名の値

その他の認証方法については、 href="/kb/help/" target="_blank">ヘルプドキュメントの「Azure Data Lake Storage Gen2への認証」セクションをご確認ください。

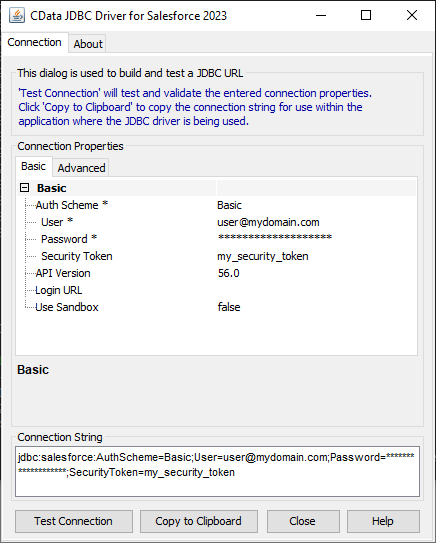

組み込みの接続文字列デザイナー

JDBC URL の構築を支援するには、Azure Data Lake Storage JDBC Driver に組み込まれている接続文字列デザイナーを使用してください。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行します。

java -jar cdata.jdbc.adls.jar

接続プロパティを設定し、接続文字列をクリップボードにコピーします。

JDBC URL を設定する際には、Max Rows 接続プロパティの設定も検討してください。これにより返される行数が制限され、レポートやビジュアライゼーションの設計時にパフォーマンスを向上させることができます。

一般的な JDBC URL は次のようになります:

jdbc:adls:Schema=ADLSGen2;Account=myAccount;FileSystem=myFileSystem;AccessKey=myAccessKey;

接続文字列を保存して、Pentaho Data Integration で使用します。

Pentaho DI から Azure Data Lake Storage に接続

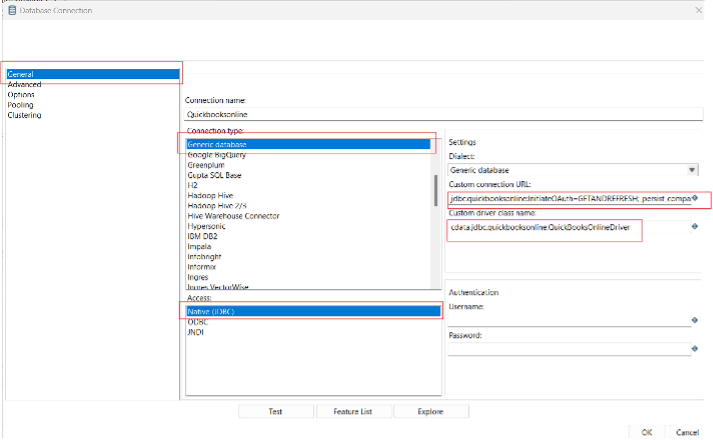

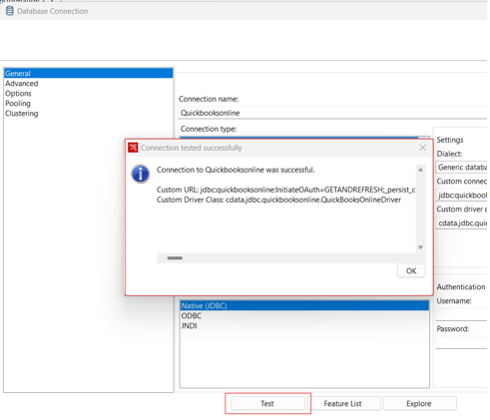

Pentaho Data Integration を開き、「Database Connection」を選択して CData JDBC Driver for Azure Data Lake Storage への接続を設定します。

- 「General」をクリックします。

- Connection name を設定します(例:Azure Data Lake Storage Connection)。

- Connection type を「Generic database」に設定します。

- Access を「Native (JDBC)」に設定します。

- Custom connection URL に Azure Data Lake Storage の接続文字列を設定します(例:

jdbc:adls:Schema=ADLSGen2;Account=myAccount;FileSystem=myFileSystem;AccessKey=myAccessKey;

)。 - Custom driver class name を「cdata.jdbc.adls.ADLSDriver」に設定します。

- 接続をテストし、「OK」をクリックして保存します。

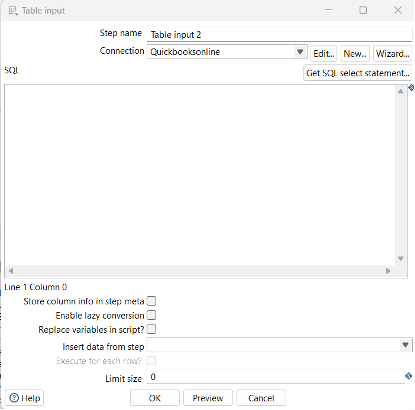

Azure Data Lake Storage のデータパイプラインを作成

CData JDBC Driver を使用して Azure Data Lake Storage への接続が設定されたら、新しいトランスフォーメーションまたはジョブを作成する準備が整いました。

- 「File」>>「New」>>「Transformation/job」をクリックします。

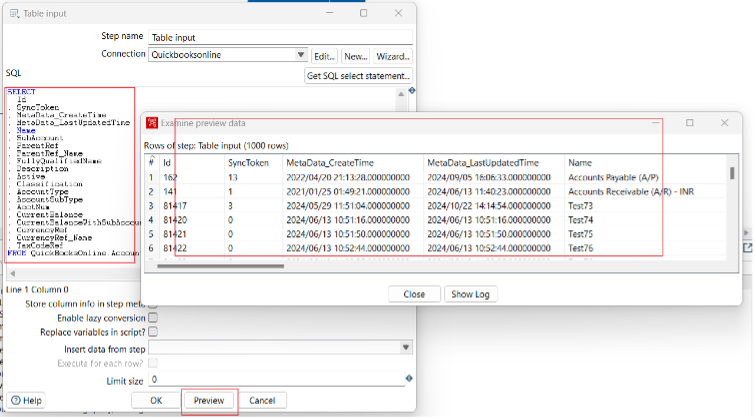

- 「Table input」オブジェクトをワークフローパネルにドラッグし、Azure Data Lake Storage 接続を選択します。

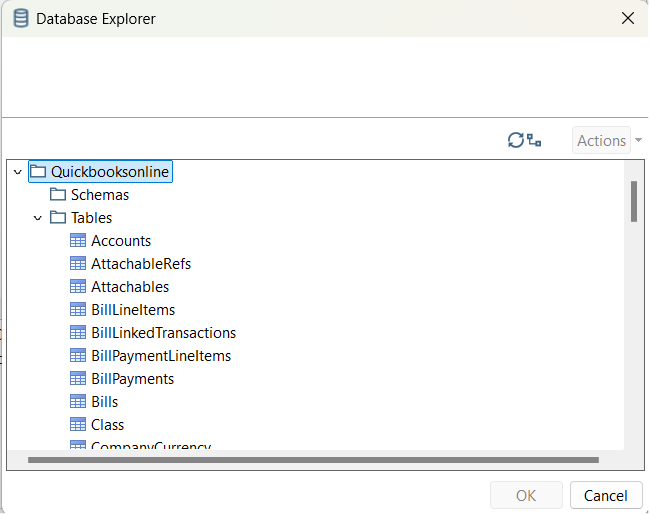

- 「Get SQL select statement」をクリックし、Database Explorer を使用して利用可能なテーブルとビューを表示します。

- テーブルを選択し、必要に応じてデータをプレビューして確認します。

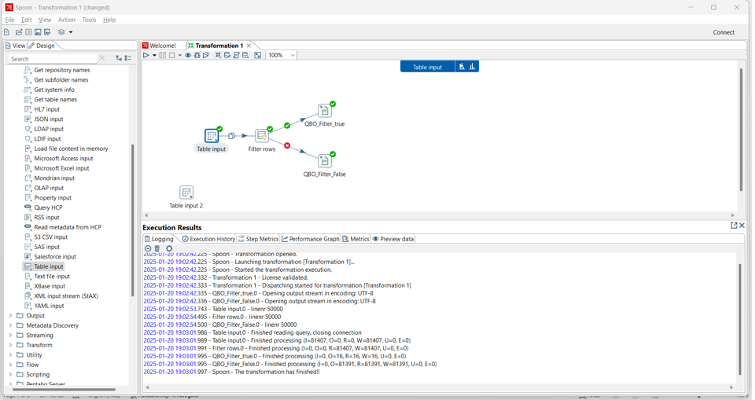

ここから、適切な同期先を選択し、レプリケーション中にデータを変更、フィルタリング、その他の処理を行うトランスフォーメーションを追加することで、トランスフォーメーションまたはジョブを続行できます。

無料トライアルと詳細情報

CData JDBC Driver for Azure Data Lake Storage の 30日間無料トライアルをダウンロードして、Pentaho Data Integration で Azure Data Lake Storage のデータ のリアルタイムデータを今すぐ活用しましょう。