Google Data Fusion で CSV に連携した ETL プロセスを作成

Google Data Fusion を使用すると、セルフサービス型のデータ連携を行い、異なるデータソースを統合できます。CData JDBC Driver for CSV をアップロードすることで、Google Data Fusion のパイプライン内から CSV のデータ にリアルタイムでアクセスできるようになります。CData JDBC Driver を使用すると、CSV のデータ を Google Data Fusion でネイティブにサポートされている任意のデータソースにパイプできますが、この記事では、CSV から Google BigQuery へデータをパイプする方法を説明します。

CData JDBC Driver for CSV を Google Data Fusion にアップロード

CData JDBC Driver for CSV を Google Data Fusion インスタンスにアップロードして、CSV のデータ にリアルタイムでアクセスしましょう。Google Data Fusion では JDBC ドライバーの命名規則に制限があるため、JAR ファイルを driver-version.jar という形式に合わせてコピーまたはリネームしてください。例:cdatacsv-2020.jar

- Google Data Fusion インスタンスを開きます

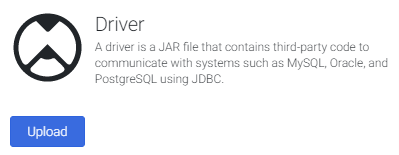

- をクリックしてエンティティを追加し、ドライバーをアップロードします

- "Upload driver" タブで、リネームした JAR ファイルをドラッグまたは参照します。

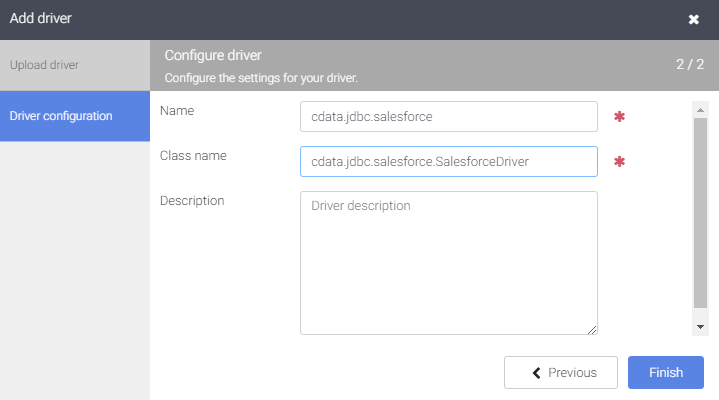

- "Driver configuration" タブで以下を設定します:

- Name: ドライバーの名前(cdata.jdbc.csv)を作成し、メモしておきます

- Class name: JDBC クラス名を設定します:(cdata.jdbc.csv.CSVDriver)

- "Finish" をクリックします

Google Data Fusion で CSV のデータ に接続

JDBC Driver をアップロードしたら、Google Data Fusion のパイプラインで CSV のデータ にリアルタイムでアクセスできます。

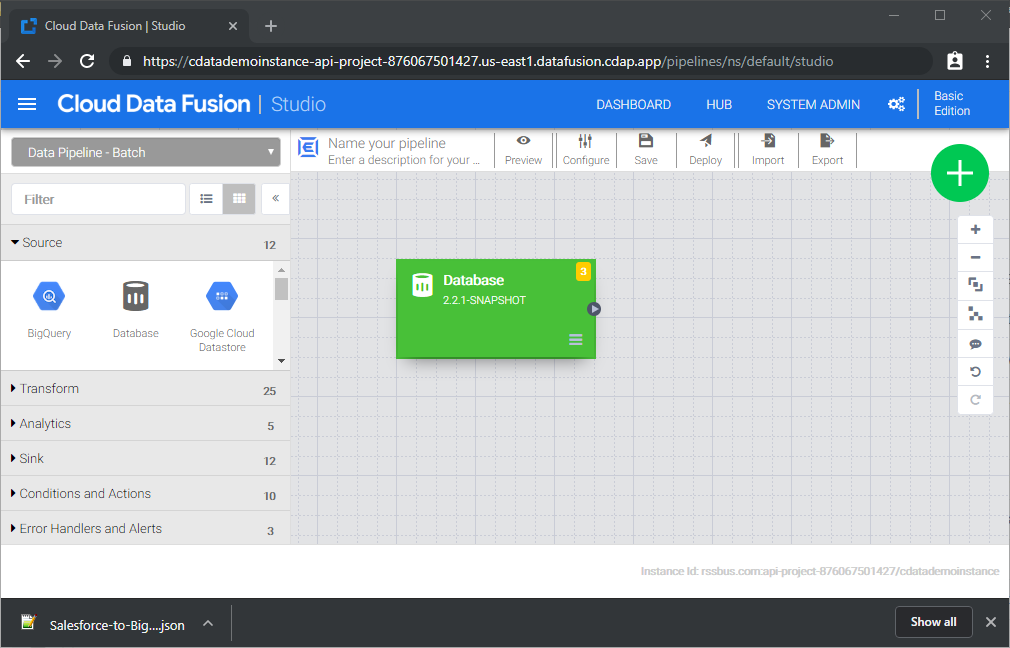

- Pipeline Studio に移動して、新しいパイプラインを作成します

- "Source" オプションから "Database" をクリックして、JDBC Driver 用のソースを追加します

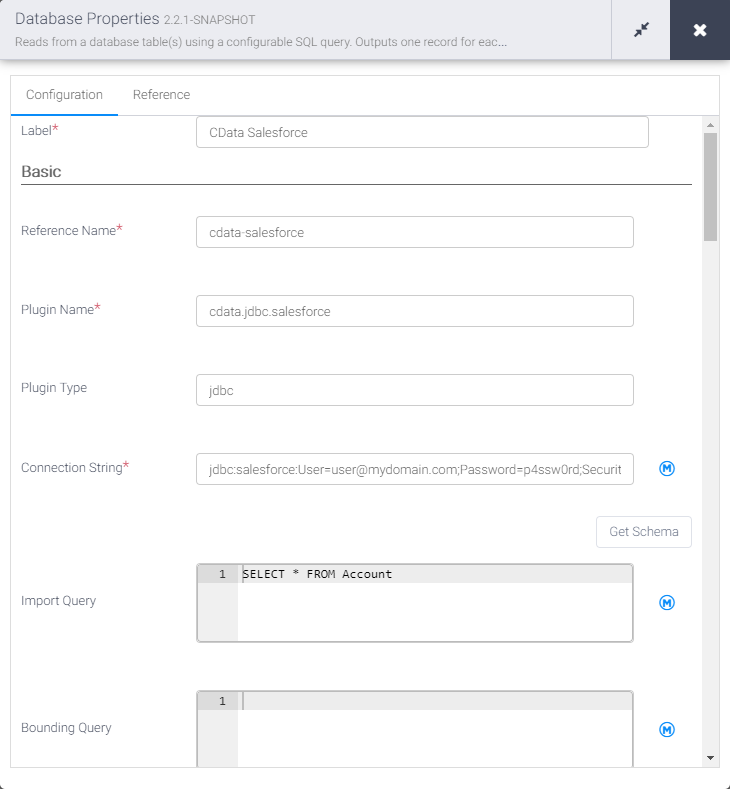

- Database ソースの "Properties" をクリックしてプロパティを編集します

NOTE:Google Data Fusion で JDBC Driver を使用するには、ライセンス(製品版またはトライアル)とランタイムキー(RTK)が必要です。ライセンス(またはトライアル)の取得については、CData までお問い合わせください。

- Label を設定します

- Reference Name を将来の参照用の値に設定します(例:cdata-csv)

- Plugin Type を "jdbc" に設定します

- Connection String を CSV の JDBC URL に設定します。例:

jdbc:csv:RTK=5246...;DataSource=MyCSVFilesFolder;CSV 接続プロパティの取得・設定方法

DataSource プロパティにローカルフォルダ名を設定します。

.csv、.tab、.txt ではない拡張子のファイルを扱う場合には、IncludeFiles 使用する拡張子をカンマ区切りで設定します。Microsoft Jet OLE DB 4.0 driver 準拠の場合にはExtended Properties を設定することができます。別の方法として、Schema.ini ファイルにファイル形式を記述することも可能です。

CSV ファイルの削除や更新を行う場合には、UseRowNumbers をTRUE に設定します。RowNumber はテーブルKey として扱われます。

Amazon S3 内のCSV への接続

URI をバケットおよびフォルダに設定します。さらに、次のプロパティを設定して認証します。

- AWSAccessKey:AWS アクセスキー(username)に設定。

- AWSSecretKey:AWS シークレットキーに設定。

Box 内のCSV への接続

URI をCSV ファイルを含むフォルダへのパスに設定します。Box へ認証するには、OAuth 認証標準を使います。 認証方法については、Box への接続 を参照してください。

Dropbox 内のCSV への接続

URI をCSV ファイルを含むフォルダへのパスに設定します。Dropbox へ認証するには、OAuth 認証標準を使います。 認証方法については、Dropbox への接続 を参照してください。ユーザーアカウントまたはサービスアカウントで認証できます。ユーザーアカウントフローでは、以下の接続文字列で示すように、ユーザー資格情報の接続プロパティを設定する必要はありません。

SharePoint Online SOAP 内のCSV への接続

URI をCSV ファイルを含むドキュメントライブラリに設定します。認証するには、User、Password、およびStorageBaseURL を設定します。

SharePoint Online REST 内のCSV への接続

URI をCSV ファイルを含むドキュメントライブラリに設定します。StorageBaseURL は任意です。指定しない場合、ドライバーはルートドライブで動作します。 認証するには、OAuth 認証標準を使用します。

FTP 内のCSV への接続

URI をルートフォルダとして使用されるフォルダへのパスが付いたサーバーのアドレスに設定します。認証するには、User およびPassword を設定します。

Google Drive 内のCSV への接続

デスクトップアプリケーションからのGoogle への認証には、InitiateOAuth をGETANDREFRESH に設定して、接続してください。詳細はドキュメントの「Google Drive への接続」を参照してください。

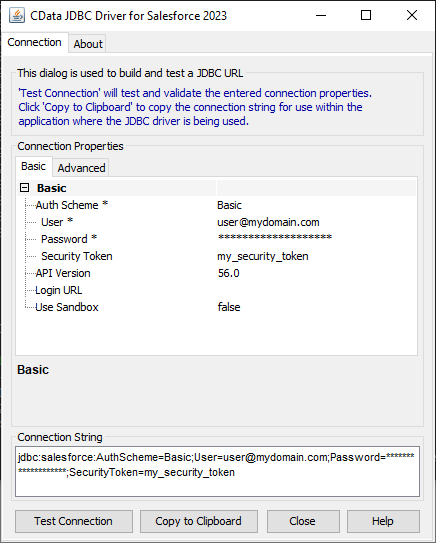

ビルトイン接続文字列デザイナー

JDBC URL の作成には、CSV JDBC Driver に組み込まれている接続文字列デザイナーを使用できます。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行してください。

java -jar cdata.jdbc.csv.jar接続プロパティを入力し、接続文字列をクリップボードにコピーします。

- Import Query を CSV から取得したいデータを抽出する SQL クエリに設定します。例:

SELECT * FROM Customer

- "Sink" タブから、同期先シンクを追加します(この例では Google BigQuery を使用します)

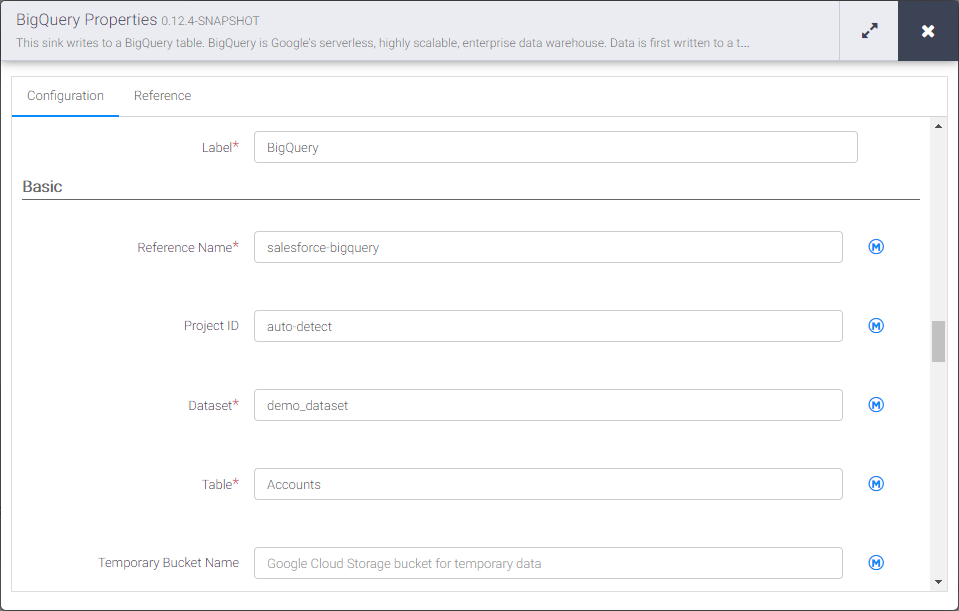

- BigQuery シンクの "Properties" をクリックしてプロパティを編集します

- Label を設定します

- Reference Name を csv-bigquery のような値に設定します

- Project ID を特定の Google BigQuery プロジェクト ID に設定します(またはデフォルトの "auto-detect" のままにします)

- Dataset を特定の Google BigQuery データセットに設定します

- Table を CSV のデータ を挿入するテーブル名に設定します

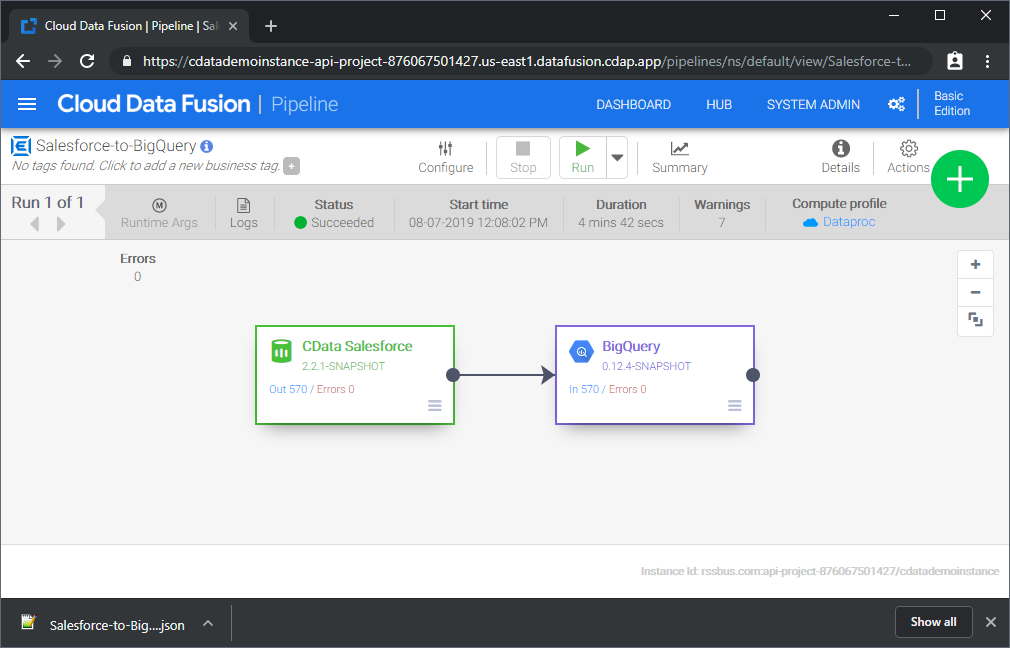

Source と Sink を設定すると、CSV のデータ を Google BigQuery にパイプする準備が整います。パイプラインを保存してデプロイしてください。パイプラインを実行すると、Google Data Fusion が CSV からリアルタイムデータをリクエストし、Google BigQuery にインポートします。

これはシンプルなパイプラインの例ですが、変換、分析、条件などを使用してより複雑な CSV パイプラインを作成できます。CData JDBC Driver for CSV の 30日間の無償トライアルをダウンロードして、今すぐ Google Data Fusion で CSV のデータ をリアルタイムで活用しましょう。