CData Connect AI を使用して Databricks でリアルタイムの Databricks データに接続・クエリ

Databricks は、データエンジニアリング、機械学習、アナリティクスを大規模に統合する AI クラウドネイティブプラットフォームです。 データウェアハウスのパフォーマンスとデータレイクの柔軟性を兼ね備えた強力なデータレイクハウスアーキテクチャを提供しています。 Databricks を CData Connect AI と統合すると、 複雑な ETL パイプラインやデータの複製を必要とせず、Databricks のデータ にリアルタイムでアクセスでき、 運用の効率化とインサイトまでの時間短縮を実現できます。

この記事では、CData Connect AI を使用して Databricks から Databricks へのセキュアなライブ接続を設定する方法を説明します。 設定が完了すると、標準 SQL を使用して Databricks ノートブックから直接Databricks のデータにアクセスでき、 データエコシステム全体でリアルタイム分析を統合できます。

Databricks データ連携について

CData を使用すれば、Databricks のライブデータへのアクセスと統合がこれまでになく簡単になります。お客様は CData の接続機能を以下の目的で利用しています:

- Runtime バージョン 9.1 - 13.X から Pro および Classic Databricks SQL バージョンまで、すべてのバージョンの Databricks にアクセスできます。

- あらゆるホスティングソリューションとの互換性により、お好みの環境で Databricks を使用し続けることができます。

- パーソナルアクセストークン、Azure サービスプリンシパル、Azure AD など、さまざまな方法で安全に認証できます。

- Databricks ファイルシステム、Azure Blob ストレージ、AWS S3 ストレージを使用して Databricks にデータをアップロードできます。

多くのお客様が、さまざまなシステムから Databricks データレイクハウスにデータを移行するために CData のソリューションを使用していますが、ライブ接続ソリューションを使用して、データベースと Databricks 間の接続をフェデレートしているお客様も多数います。これらのお客様は、SQL Server リンクサーバーまたは Polybase を使用して、既存の RDBMS 内から Databricks へのライブアクセスを実現しています。

一般的な Databricks のユースケースと CData のソリューションがデータの問題解決にどのように役立つかについては、ブログをご覧ください:What is Databricks Used For? 6 Use Cases

はじめに

概要

シンプルなステップの概要は以下のとおりです:

- ステップ 1 - 接続と設定: CData Connect AI で Databricks ソースへの接続を作成し、ユーザー権限を設定して、 Personal Access Token(PAT)を生成します。

- ステップ 2 - Databricks からクエリ: Databricks に CData JDBC ドライバーをインストールし、ノートブックに接続情報を設定して、 SQL クエリでリアルタイムのDatabricks のデータにアクセスします。

前提条件

始める前に、以下を準備してください:

- アクティブな Databricks アカウント

- CData Connect AI アカウント。ログインまたは 無料トライアルにサインアップできます。

- Databricks アカウント。こちらからサインアップまたはログインできます。

ステップ 1:CData Connect AI で Databricks 接続を設定

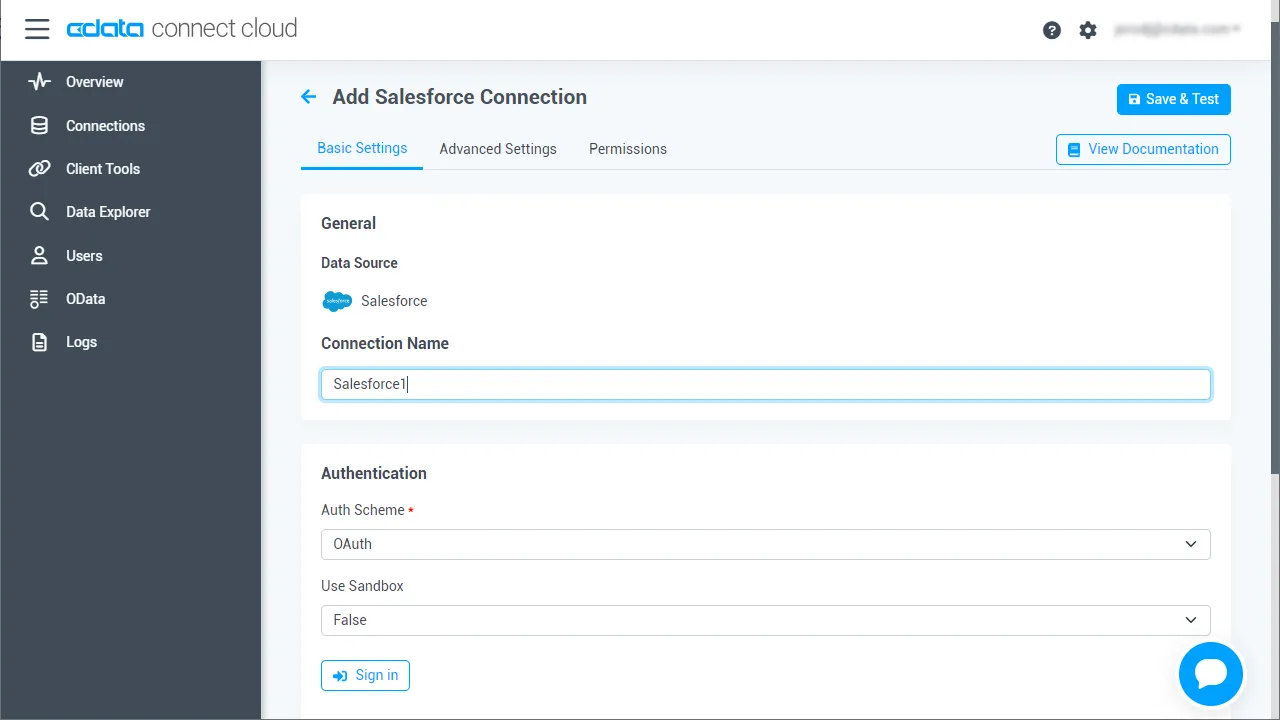

1.1 Databricks への接続を追加

CData Connect AI は、利用可能なデータソースに接続するためのシンプルなポイント&クリックインターフェースを提供しています。

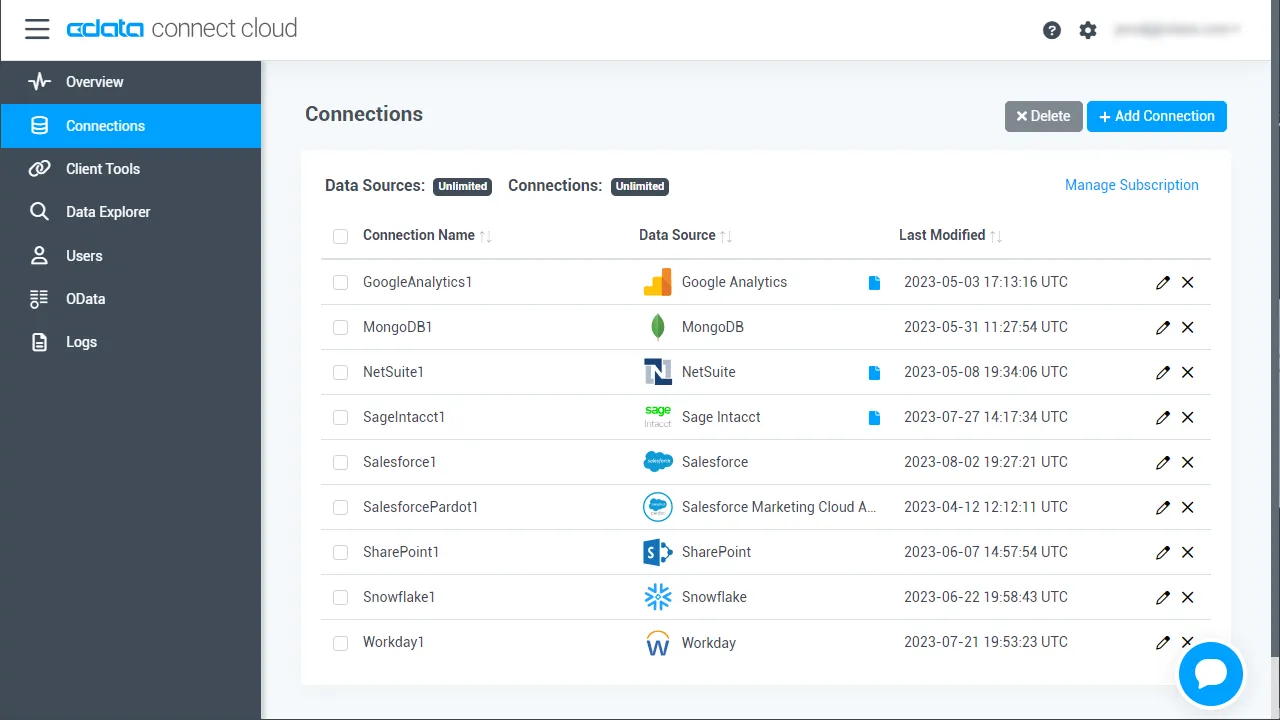

- Connect AI にログインし、左側の Sources をクリックして、 右上の Add Connection をクリック

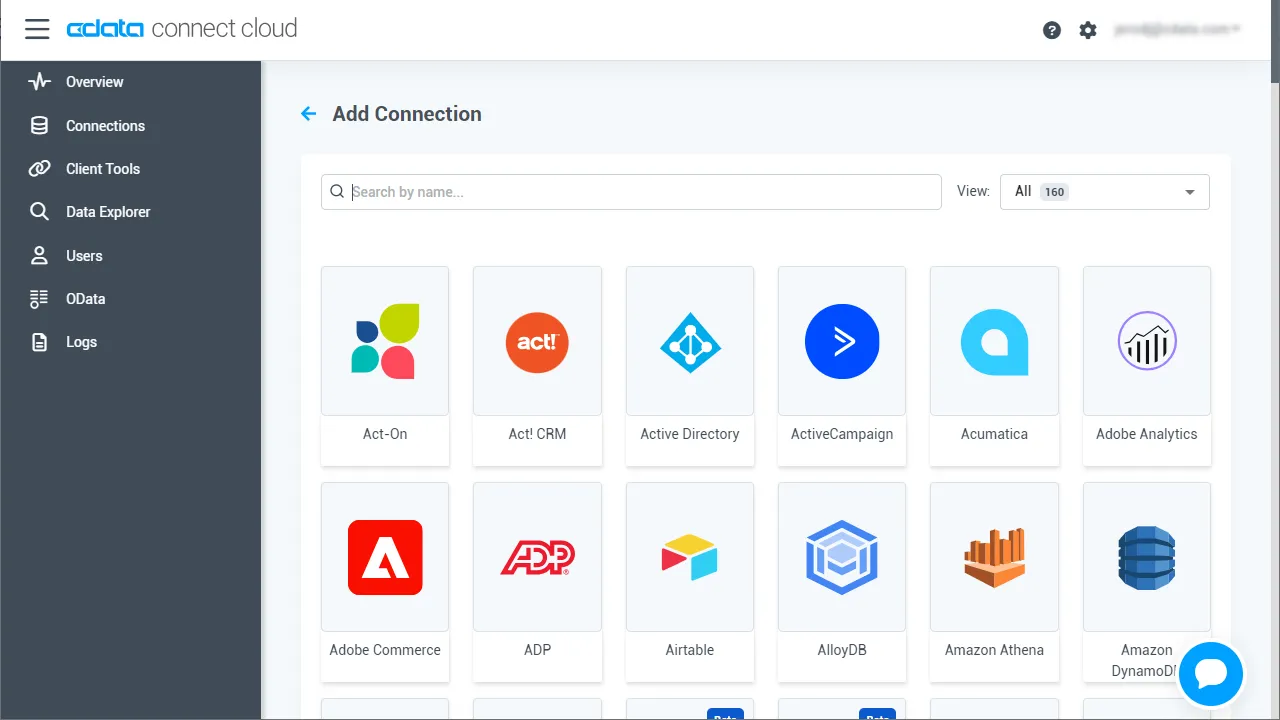

- Add Connection パネルから 「Databricks」 を選択

-

Databricks に接続するために必要な認証プロパティを入力します。

Databricks 接続プロパティの取得・設定方法

Databricks クラスターに接続するには、以下のプロパティを設定します。

- Database:Databricks データベース名。

- Server:Databricks クラスターのサーバーのホスト名。

- HTTPPath:Databricks クラスターのHTTP パス。

- Token:個人用アクセストークン。この値は、Databricks インスタンスのユーザー設定ページに移動してアクセストークンタブを選択することで取得できます。

Databricks への認証

CData は、次の認証スキームをサポートしています。

- 個人用アクセストークン

- Microsoft Entra ID(Azure AD)

- Azure サービスプリンシパル

- OAuthU2M

- OAuthM2M

個人用アクセストークン

認証するには、次を設定します。

- AuthScheme:PersonalAccessToken。

- Token:Databricks サーバーへの接続に使用するトークン。Databricks インスタンスのユーザー設定ページに移動してアクセストークンタブを選択することで取得できます。

その他の認証方法については、ヘルプドキュメント の「はじめに」セクションを参照してください。

- 右上の Save & Test をクリック

-

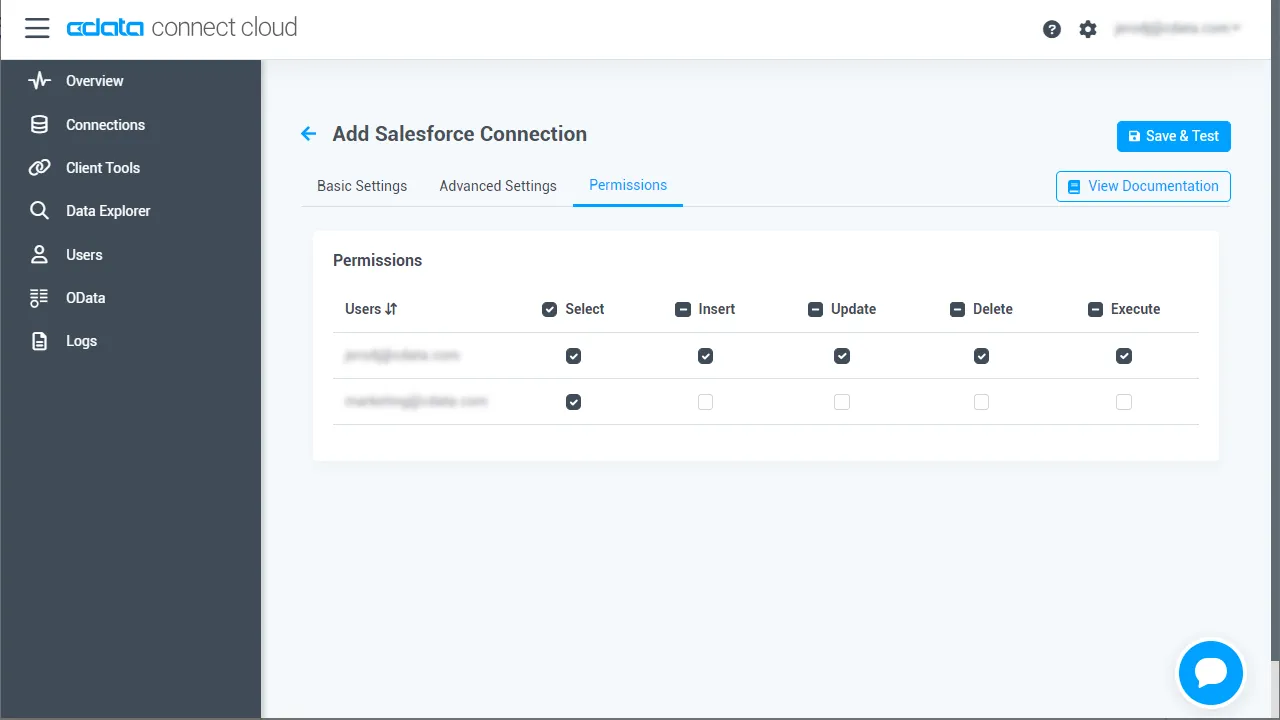

Databricks Connection ページで Permissions タブに移動し、

お好みに応じてユーザーベースの権限を更新します。

1.2 Personal Access Token(PAT)を生成

REST API、OData API、または仮想 SQL Server 経由で Connect AI に接続する場合、 Personal Access Token(PAT)が Connect AI への接続認証に使用されます。PAT は、セキュアなトークンベースの認証として ログイン認証情報の代わりに機能します。アクセスの粒度を維持するため、 サービスごとに個別の PAT を作成することをお勧めします。

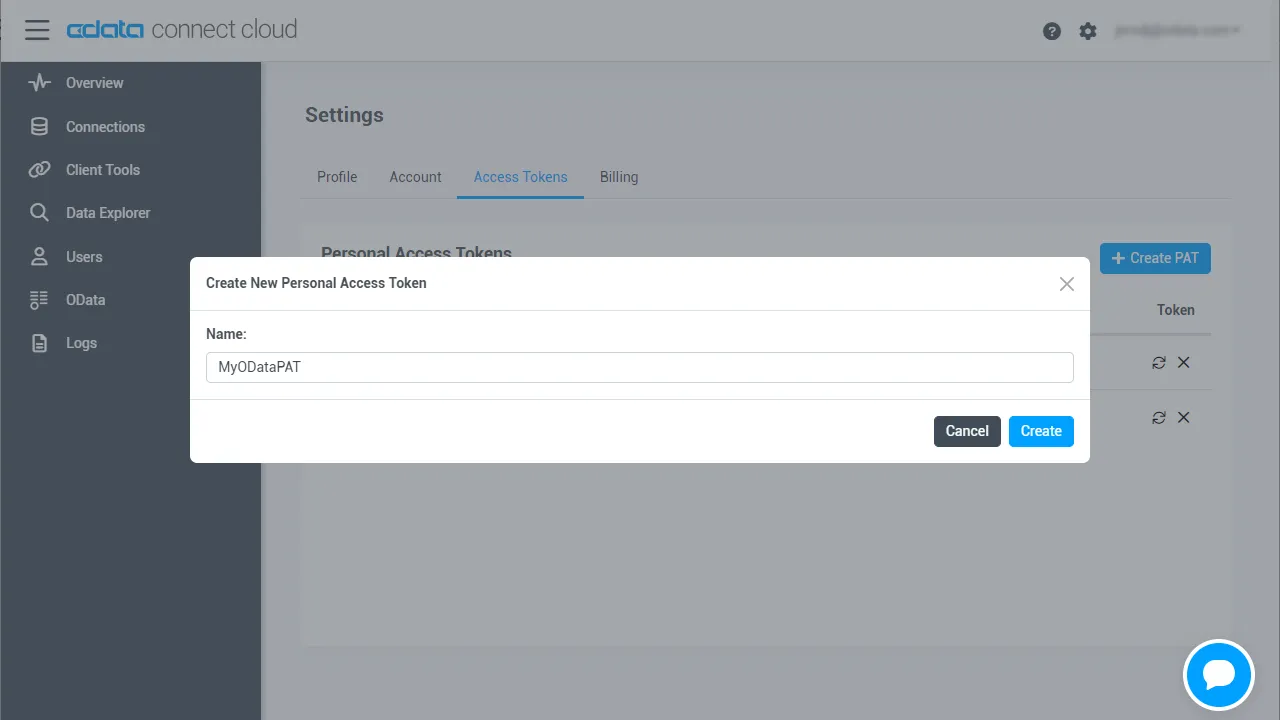

- Connect AI アプリの右上にある歯車アイコン()をクリックして Settings ページを開く

- Settings ページで Access Tokens セクションに移動し、 Create PAT をクリック

-

PAT に名前を付けて Create をクリック

- 注意:Personal Access Token は作成時にのみ表示されるので、必ずコピーして安全な場所に保存してください。

ステップ 2:Databricks で Databricks データに接続・クエリ

以下の手順に従って、Databricks から Databricks への接続を確立します。 CData JDBC Driver for Connect AI をインストールし、JAR ファイルをクラスターに追加して、ノートブックを設定し、 SQL クエリでリアルタイムのDatabricks のデータにアクセスします。

2.1 CData JDBC Driver for Connect AI をインストール

- CData Connect AI で、左側の Integrations ページをクリック。 JDBC または Databricks を検索し、Download をクリックして、 お使いの OS 用のインストーラーを選択します。

-

ダウンロード後、インストーラーを実行して指示に従います:

- Windows の場合:セットアップファイルを実行し、インストールウィザードに従います。

- Mac/Linux の場合:アーカイブを解凍し、フォルダを /opt または /Applications に移動します。実行権限があることを確認してください。

-

インストール後、インストールディレクトリで JAR ファイルを見つけます:

- Windows:

C:\Program Files\CData\CData JDBC Driver for Connect AI\lib\cdata.jdbc.connect.jar

- Mac/Linux:

/Applications/CData/CData JDBC Driver for Connect AI/lib/cdata.jdbc.connect.jar

- Windows:

2.2 Databricks に JAR ファイルをインストール

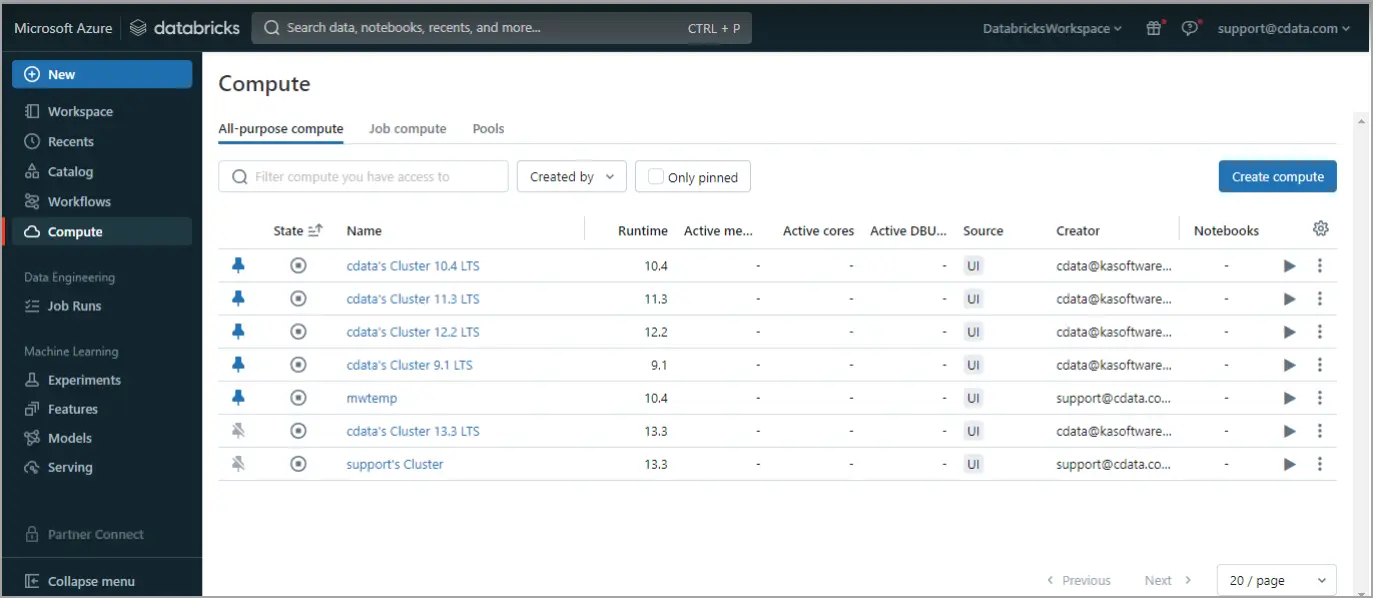

-

Databricks にログイン。左側のナビゲーションペインで Compute をクリック。コンピュートクラスターを開始または作成します。

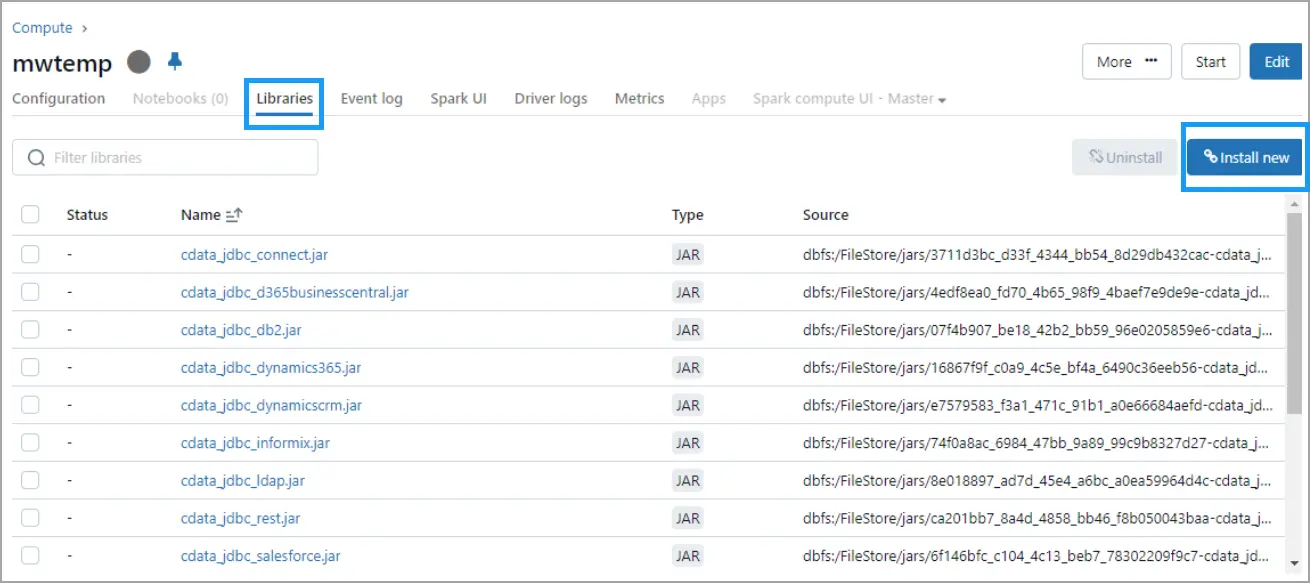

-

実行中のクラスターをクリックし、Libraries タブに移動して、右上の Install New をクリック。

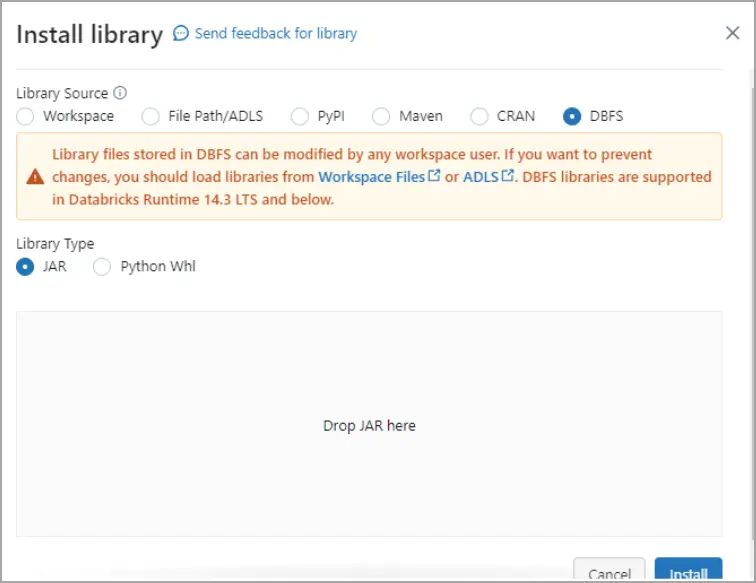

-

Install Library ダイアログで DBFS を選択し、

cdata.jdbc.connect.jar ファイルをドラッグ&ドロップ。Install をクリック。

2.3 Databricks ノートブックで Databricks データをクエリ

ノートブックスクリプト 1 - JDBC 接続を定義:

- 以下のスクリプトをノートブックセルに貼り付けます:

driver = "cdata.jdbc.connect.ConnectDriver" url = "jdbc:connect:AuthScheme=Basic;User=your_username;Password=your_pat;URL=https://cloud.cdata.com/api/;DefaultCatalog=Your_Connection_Name;"

- 以下を置き換えます:

- your_username - CData Connect AI のユーザー名

- your_pat - CData Connect AI の Personal Access Token(PAT)

- Your_Connection_Name - Sources ページの Connect AI データソース名

- スクリプトを実行します。

ノートブックスクリプト 2 -Databricks のデータから DataFrame を読み込み:

- 2 番目のスクリプト用に新しいセルを追加します。ノートブック右側のメニューから Add cell below をクリック。

- 以下のスクリプトを新しいセルに貼り付けます:

remote_table = spark.read.format("jdbc") \

.option("driver", "cdata.jdbc.connect.ConnectDriver") \

.option("url", "jdbc:connect:AuthScheme=Basic;User=your_username;Password=your_pat;URL=https://cloud.cdata.com/api/;DefaultCatalog=Your_Connection_Name;") \

.option("dbtable", "YOUR_SCHEMA.YOUR_TABLE") \

.load()

- 以下を置き換えます:

- your_username - CData Connect AI のユーザー名

- your_pat - CData Connect AI の Personal Access Token(PAT)

- Your_Connection_Name - Sources ページの Connect AI データソース名

- YOUR_SCHEMA.YOUR_TABLE - スキーマとテーブル名(例:Databricks.Customers)

- スクリプトを実行します。

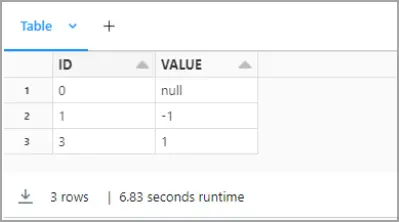

ノートブックスクリプト 3 - カラムをプレビュー:

- 同様に、3 番目のスクリプト用に新しいセルを追加します。

- 以下のスクリプトを新しいセルに貼り付けます:

display(remote_table.select("ColumnName1", "ColumnName2"))

- ColumnName1 と ColumnName2 を Databricks 構造の実際のカラム名に置き換えます(例:City、CompanyName など)。

- スクリプトを実行します。

これで、バックエンド API の複雑さを意識することなく、またDatabricks のデータをレプリケーションすることなく、 Databricks ノートブック内で直接リアルタイムの Databricks のデータ を探索、結合、分析できるようになりました。

CData Connect AI を 14 日間無料でお試しください

Databricks のデータへのリアルタイムアクセスを簡素化する準備はできましたか? CData Connect AI の 14 日間無料トライアルを今すぐ開始して、 Databricks から Databricks へのシームレスなライブ接続を体験してください。

ローコード、インフラ不要、レプリケーション不要 - 重要なデータとインサイトへの シームレスでセキュアなアクセスを実現します。