AWS Lambda でリアルタイムDatabricks のデータにアクセス

AWS Lambda は、新しい情報やイベントに素早く応答するアプリケーションを構築できるコンピューティングサービスです。CData JDBC Driver for Databricks と組み合わせることで、AWS Lambda 関数からリアルタイムDatabricks のデータを操作できます。この記事では、Eclipse で構築した AWS Lambda 関数からDatabricks のデータに接続してクエリを実行する方法を説明します。

なお、この記事の執筆時点(2022年6月)では、AWS Toolkit for Eclipse がサポートする最新バージョンは Eclipse 2019-12 および Java 8 となっています。

最適化されたデータ処理機能を組み込んだ CData JDBC ドライバは、リアルタイムDatabricks のデータとのインタラクションにおいて卓越したパフォーマンスを発揮します。Databricks に対して複雑な SQL クエリを発行すると、ドライバーはフィルタや集計などのサポートされている SQL 操作を直接Databricksにプッシュし、サポートされていない操作(主に SQL 関数や JOIN 操作)は組み込みの SQL エンジンを使用してクライアント側で処理します。さらに、動的メタデータクエリ機能により、ネイティブのデータ型を使用してDatabricks のデータの操作・分析が可能です。

Databricks データ連携について

CData を使用すれば、Databricks のライブデータへのアクセスと統合がこれまでになく簡単になります。お客様は CData の接続機能を以下の目的で利用しています:

- Runtime バージョン 9.1 - 13.X から Pro および Classic Databricks SQL バージョンまで、すべてのバージョンの Databricks にアクセスできます。

- あらゆるホスティングソリューションとの互換性により、お好みの環境で Databricks を使用し続けることができます。

- パーソナルアクセストークン、Azure サービスプリンシパル、Azure AD など、さまざまな方法で安全に認証できます。

- Databricks ファイルシステム、Azure Blob ストレージ、AWS S3 ストレージを使用して Databricks にデータをアップロードできます。

多くのお客様が、さまざまなシステムから Databricks データレイクハウスにデータを移行するために CData のソリューションを使用していますが、ライブ接続ソリューションを使用して、データベースと Databricks 間の接続をフェデレートしているお客様も多数います。これらのお客様は、SQL Server リンクサーバーまたは Polybase を使用して、既存の RDBMS 内から Databricks へのライブアクセスを実現しています。

一般的な Databricks のユースケースと CData のソリューションがデータの問題解決にどのように役立つかについては、ブログをご覧ください:What is Databricks Used For? 6 Use Cases

はじめに

接続プロパティの設定と接続文字列の構築

Databricks 接続プロパティの取得・設定方法

Databricks クラスターに接続するには、以下のプロパティを設定します。

- Database:Databricks データベース名。

- Server:Databricks クラスターのサーバーのホスト名。

- HTTPPath:Databricks クラスターのHTTP パス。

- Token:個人用アクセストークン。この値は、Databricks インスタンスのユーザー設定ページに移動してアクセストークンタブを選択することで取得できます。

Databricks への認証

CData は、次の認証スキームをサポートしています。

- 個人用アクセストークン

- Microsoft Entra ID(Azure AD)

- Azure サービスプリンシパル

- OAuthU2M

- OAuthM2M

個人用アクセストークン

認証するには、次を設定します。

- AuthScheme:PersonalAccessToken。

- Token:Databricks サーバーへの接続に使用するトークン。Databricks インスタンスのユーザー設定ページに移動してアクセストークンタブを選択することで取得できます。

その他の認証方法については、ヘルプドキュメント の「はじめに」セクションを参照してください。

NOTE: AWS Lambda 関数で JDBC ドライバーを使用するには、ライセンス(製品版または試用版)とランタイムキー(RTK)が必要です。ライセンス(または試用版)の取得については、弊社営業チームまでお問い合わせください。

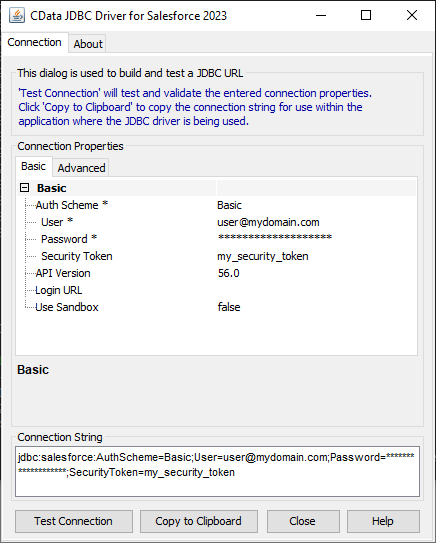

組み込みの接続文字列デザイナー

JDBC URL の構築には、Databricks JDBC Driver に組み込まれている接続文字列デザイナーを使用できます。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行してください。

java -jar cdata.jdbc.databricks.jar

接続プロパティ(RTK を含む)を入力し、接続文字列をクリップボードにコピーします。

AWS Lambda 関数の作成

- CData JDBC Driver for Databricks のインストーラーをダウンロードし、パッケージを解凍して JAR ファイルを実行してドライバーをインストールします。

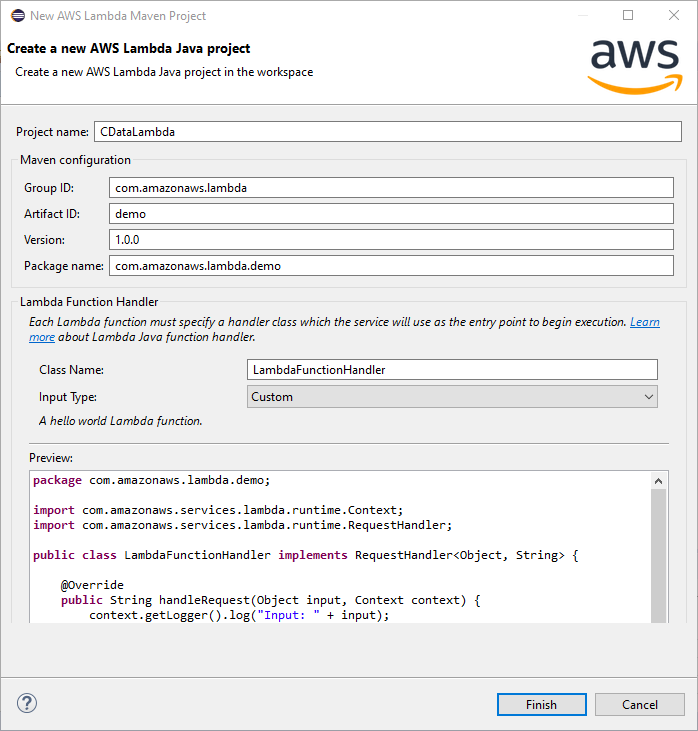

AWS Toolkit for Eclipse を使用して、Eclipse で新しい AWS Lambda Java プロジェクトを作成します。詳細な手順は AWS のチュートリアル(amazon.com)を参照してください。

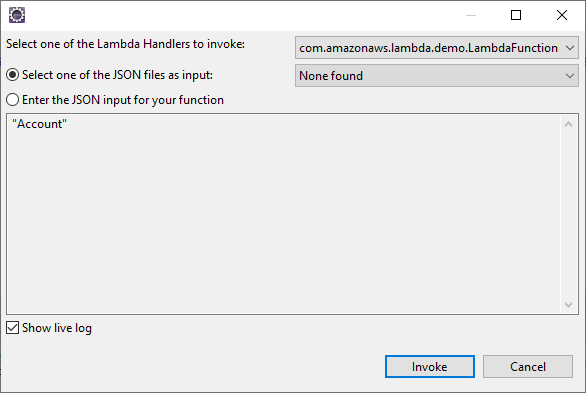

この記事では、テーブル名を入力として渡せるように、プロジェクトのInput Type を「Custom」に設定します。

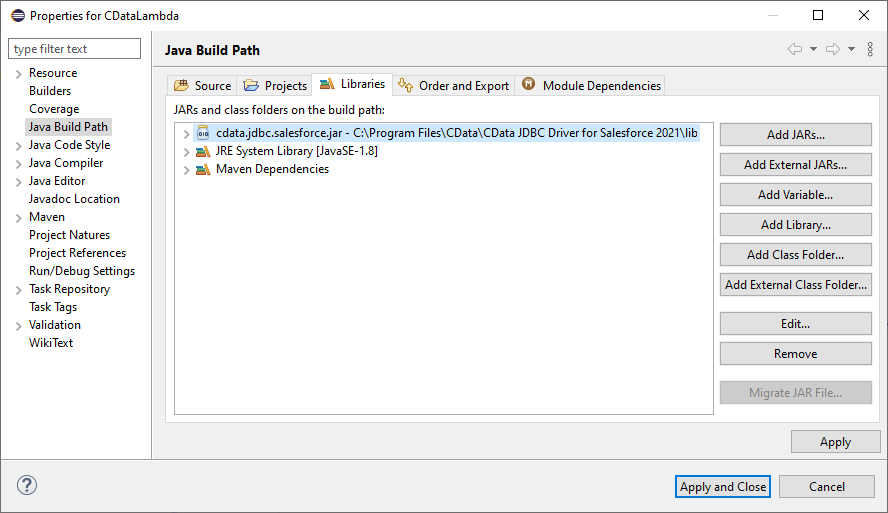

- CData JDBC Driver for Databricks の JAR ファイル(cdata.jdbc.databricks.jar)をビルドパスに追加します。このファイルは INSTALL_PATH\lib\ にあります。

- Java クラスに以下の import 文を追加します。

import java.sql.Connection; import java.sql.DriverManager; import java.sql.ResultSet; import java.sql.ResultSetMetaData; import java.sql.SQLException; import java.sql.Statement;

handleRequest メソッドの本体を以下のコードに置き換えます。DriverManager.getConnection メソッド呼び出し内の接続文字列は、実際の値に置き換えてください。

String query = "SELECT * FROM " + input; try { Class.forName("cdata.jdbc.databricks.DatabricksDriver"); } catch (ClassNotFoundException ex) { context.getLogger().log("Error: class not found"); } Connection connection = null; try { connection = DriverManager.getConnection("jdbc:cdata:databricks:RTK=52465...;Server=127.0.0.1;HTTPPath=MyHTTPPath;User=MyUser;Token=MyToken;"); } catch (SQLException ex) { context.getLogger().log("Error getting connection: " + ex.getMessage()); } catch (Exception ex) { context.getLogger().log("Error: " + ex.getMessage()); } if(connection != null) { context.getLogger().log("Connected Successfully!\n"); } ResultSet resultSet = null; try { //executing query Statement stmt = connection.createStatement(); resultSet = stmt.executeQuery(query); ResultSetMetaData metaData = resultSet.getMetaData(); int numCols = metaData.getColumnCount(); //printing the results while(resultSet.next()) { for(int i = 1; i <= numCols; i++) { System.out.printf("%-25s", (resultSet.getObject(i) != null) ? resultSet.getObject(i).toString().replaceAll("\n", "") : null ); } System.out.print("\n"); } } catch (SQLException ex) { System.out.println("SQL Exception: " + ex.getMessage()); } catch (Exception ex) { System.out.println("General exception: " + ex.getMessage()); } String output = "query: " + query + " complete"; return output;

Lambda 関数のデプロイと実行

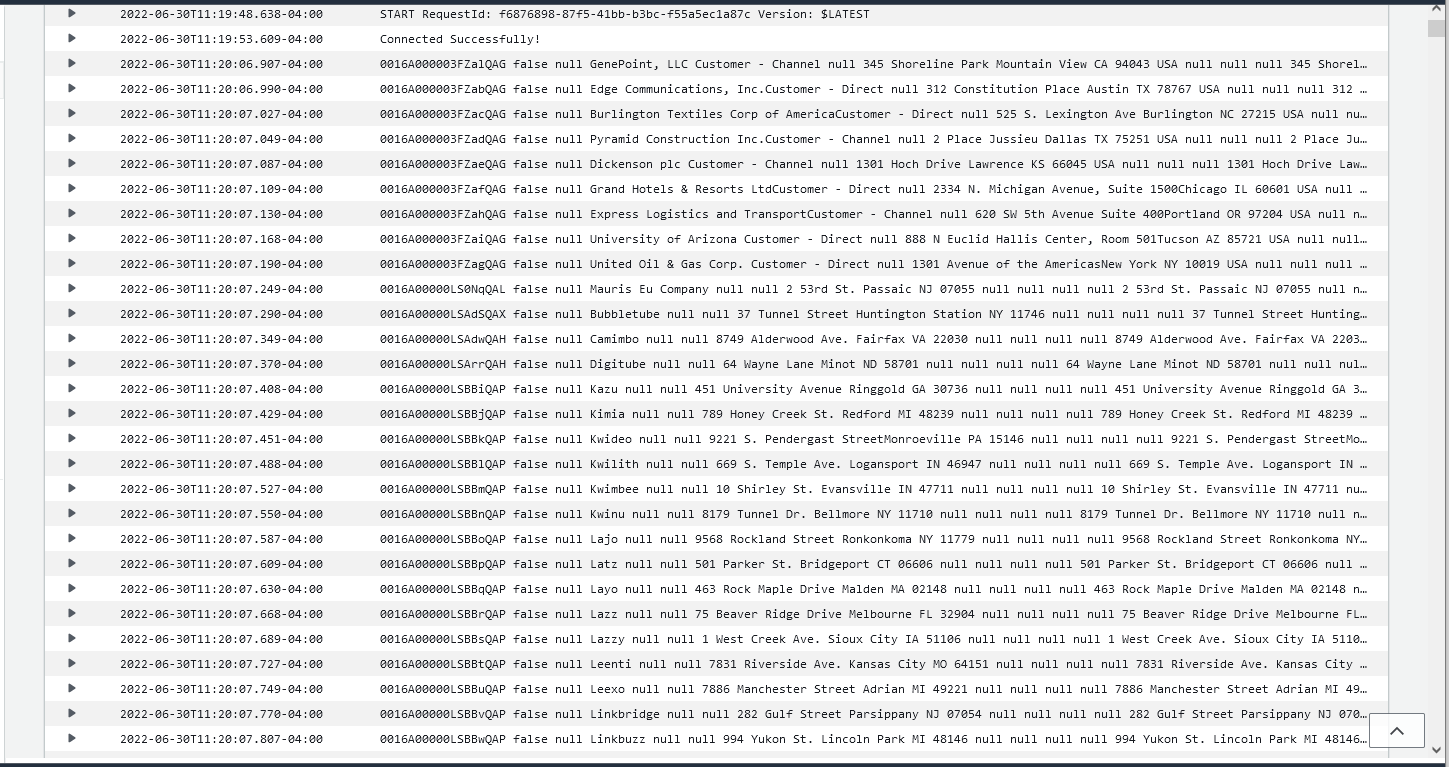

Eclipse で関数をビルドしたら、アップロードして実行する準備が整います。この記事では出力を AWS ログに書き込んでいますが、これをテンプレートとして、AWS Lambda 関数でDatabricks のデータを操作する独自のカスタムビジネスロジックを実装できます。

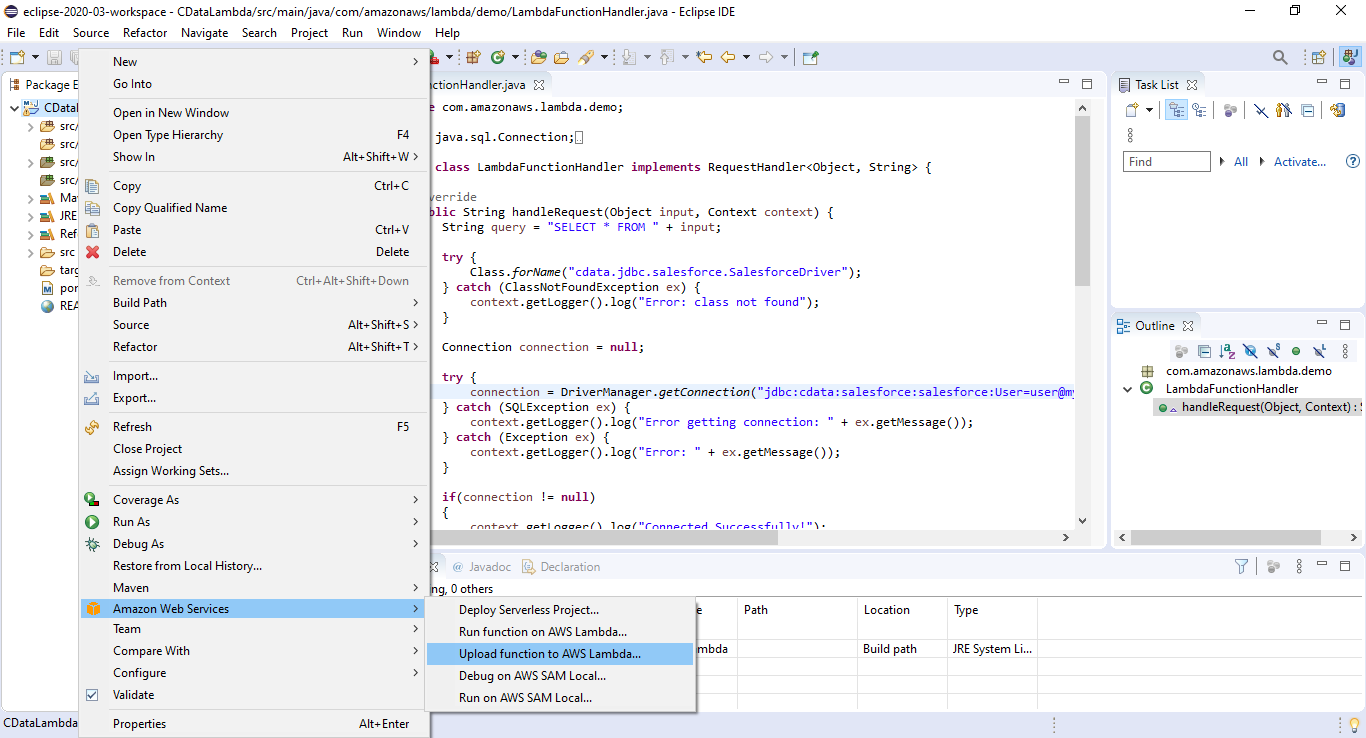

- パッケージを右クリックして、Amazon Web Services -> Upload function to AWS Lambda を選択します。

- 関数に名前を付け、IAM ロールを選択し、タイムアウト値を関数が完了するのに十分な値に設定します(クエリの結果サイズによって異なります)。

- パッケージを右クリックして、Amazon Web Services -> Run function on AWS Lambda を選択し、クエリ対象のDatabricksオブジェクト名(例:「Customers」)を入力します。

- ジョブの実行後、CloudWatch ログで出力を確認できます。

無償トライアル・詳細情報

CData JDBC Driver for Databricks の30日間の無償トライアルをダウンロードして、AWS Lambda でリアルタイムDatabricks のデータを活用してみてください。ご不明な点があれば、サポートチームまでお気軽にお問い合わせください。