DataGrip で Spark のデータ をクエリ

DataGrip は、SQL 開発者がデータベースへのクエリ、作成、管理を行えるデータベース IDE です。CData JDBC Driver for Apache Spark と組み合わせることで、DataGrip からリアルタイムSpark のデータを操作できます。この記事では、DataGrip で Spark のデータ への接続を確立し、テーブルエディタを使用して Spark のデータ を読み込む方法を説明します。

Spark 用の新しいドライバー定義を作成

以下のステップでは、DataGrip で Spark 用の新しいデータソースを作成する方法を説明します。

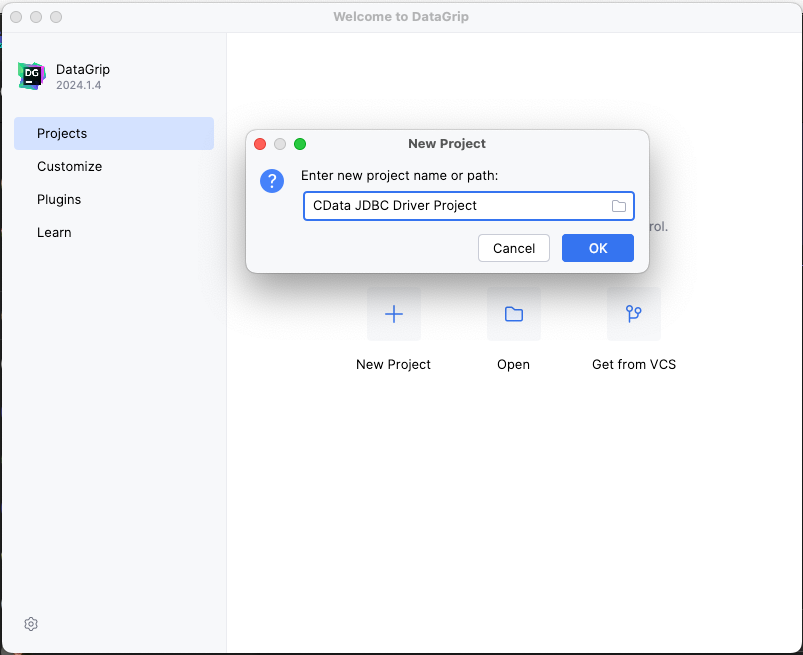

- DataGrip で、File -> New -> Project をクリックしてプロジェクト名を入力します。

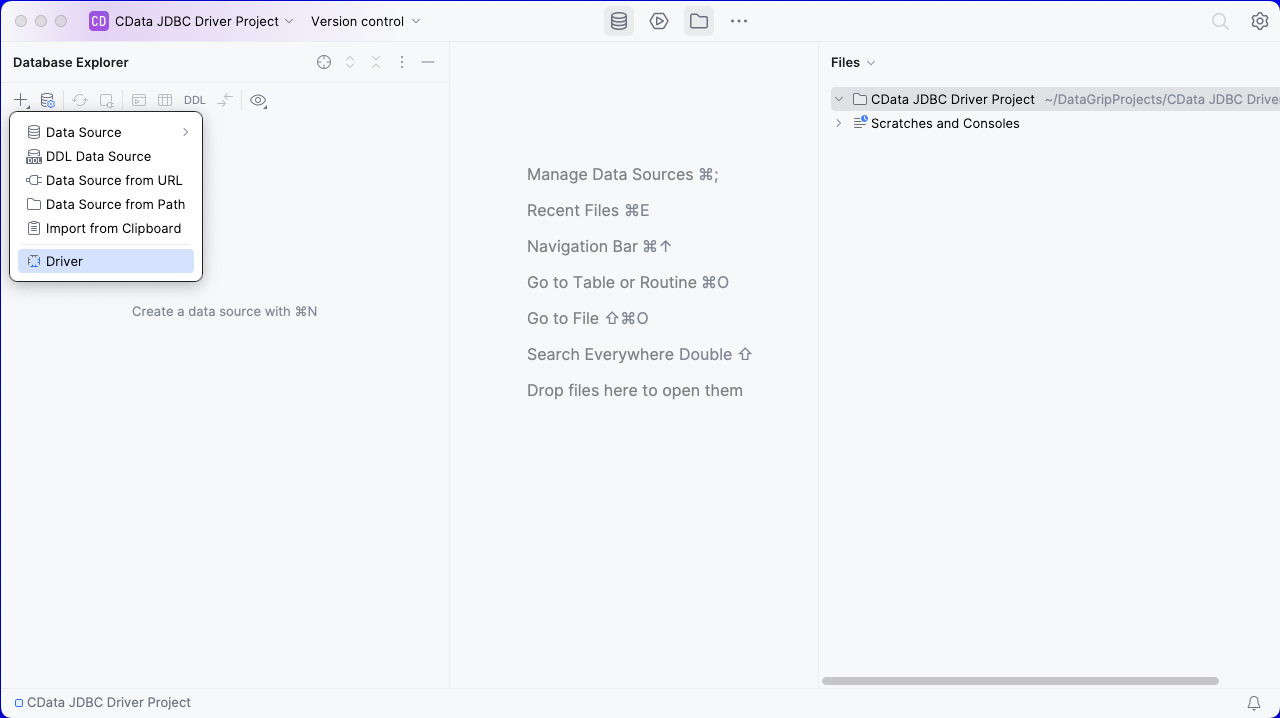

- Database Explorer で、プラスアイコン()をクリックして Driver を選択します。

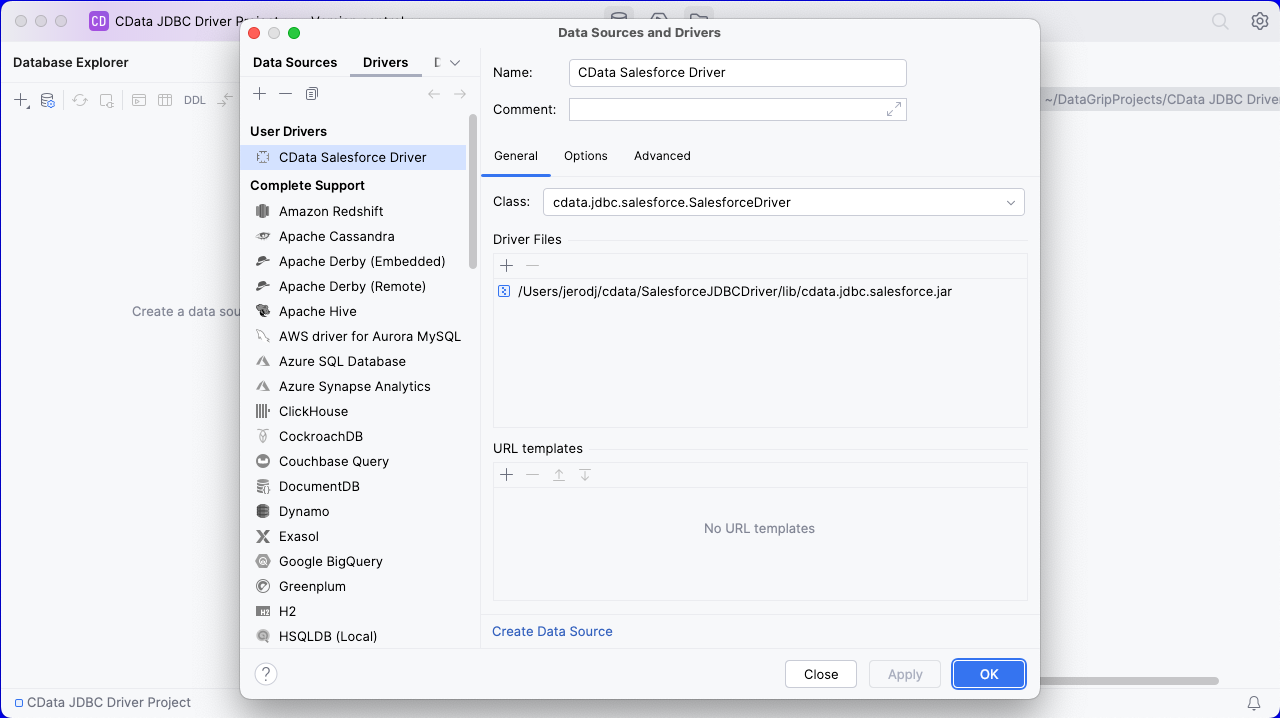

- Driver タブで以下を設定します。

- Name をわかりやすい名前に設定します(例:"CData Spark Driver")。

- Driver Files を適切な JAR ファイルに設定します。ファイルを追加するには、プラス()をクリックし、「Add Files」を選択して、ドライバーのインストールディレクトリ内の「lib」フォルダに移動し、JAR ファイル(例:cdata.jdbc.sparksql.jar)を選択します。

- Class を cdata.jdbc.sparksql.SparkSQL.jar に設定します。

また、詳細タブでは、ドライバーのプロパティや、VM Options、VM environment、VM home path、DBMS などの設定を変更できます。 - ほとんどの場合、Expert options で DBMS type を「Unknown」に変更して、ネイティブの SQL Server クエリ(Transact-SQL)を回避してください。これを行わないと、無効な関数エラーが発生する可能性があります。

- 「Apply」をクリックし、「OK」をクリックして接続を保存します。

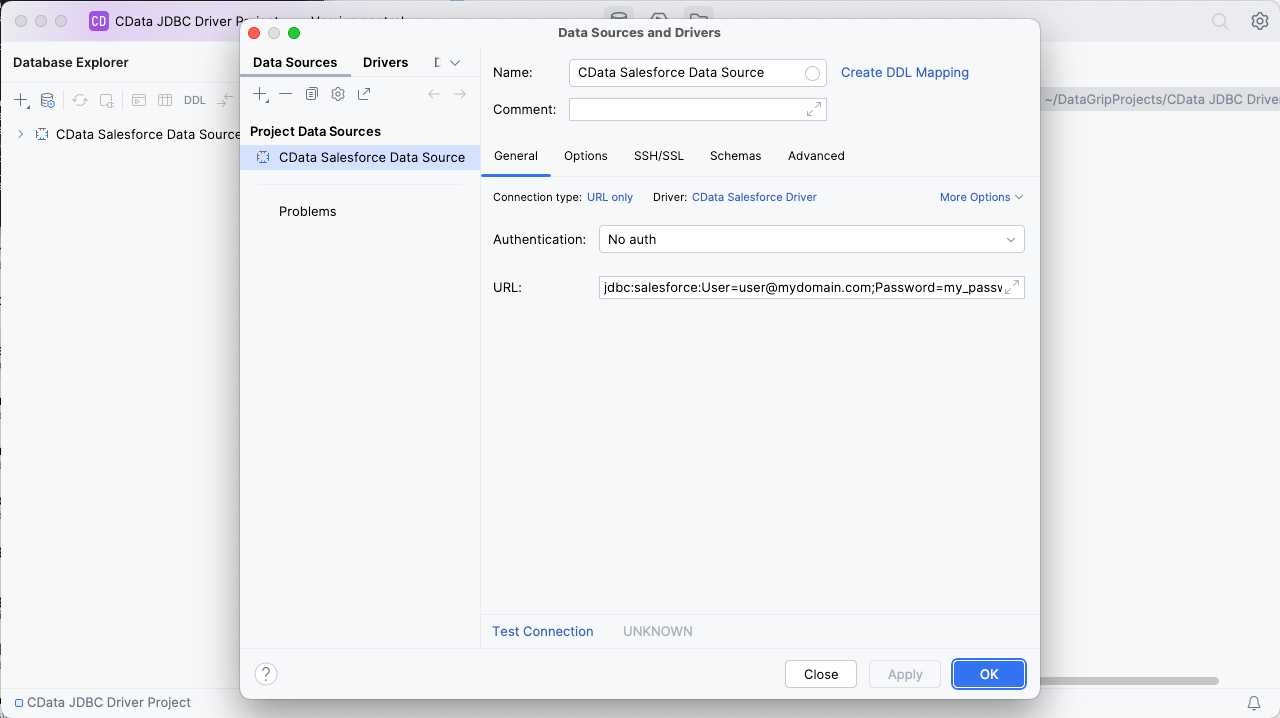

Spark への接続を設定

- 接続を保存したら、プラス()をクリックし、「Data Source」→「CData Spark Driver」を選択して、新しい Spark データソースを作成します。

- 新しいウィンドウで、JDBC URL を使用して Spark への接続を設定します。

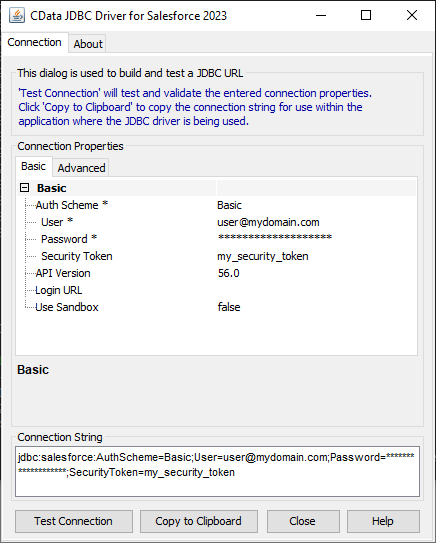

組み込みの接続文字列デザイナー

JDBC URL の構築には、Spark JDBC Driver に組み込まれている接続文字列デザイナーを使用してください。JAR ファイルをダブルクリックするか、コマンドラインから JAR ファイルを実行します。

java -jar cdata.jdbc.sparksql.jar接続プロパティを入力し、接続文字列をクリップボードにコピーします。

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

- URL を接続文字列に設定します。例:

jdbc:sparksql:Server=127.0.0.1;

- 「Apply」と「OK」をクリックして接続文字列を保存します。

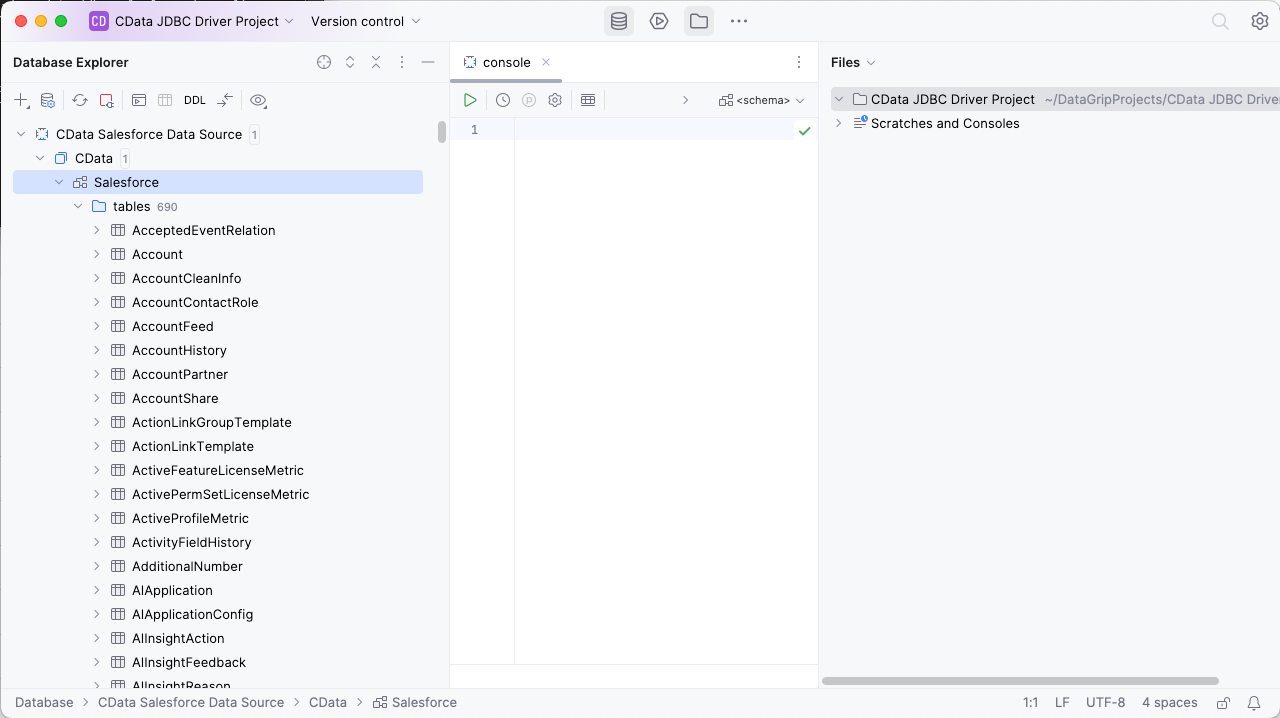

これで、Data Explorer にデータソースが表示されます。

Spark に対して SQL クエリを実行

JDBC Driver を介してアクセス可能な Spark のエンティティ(テーブルとして利用可能)を参照するには、データソースを展開します。

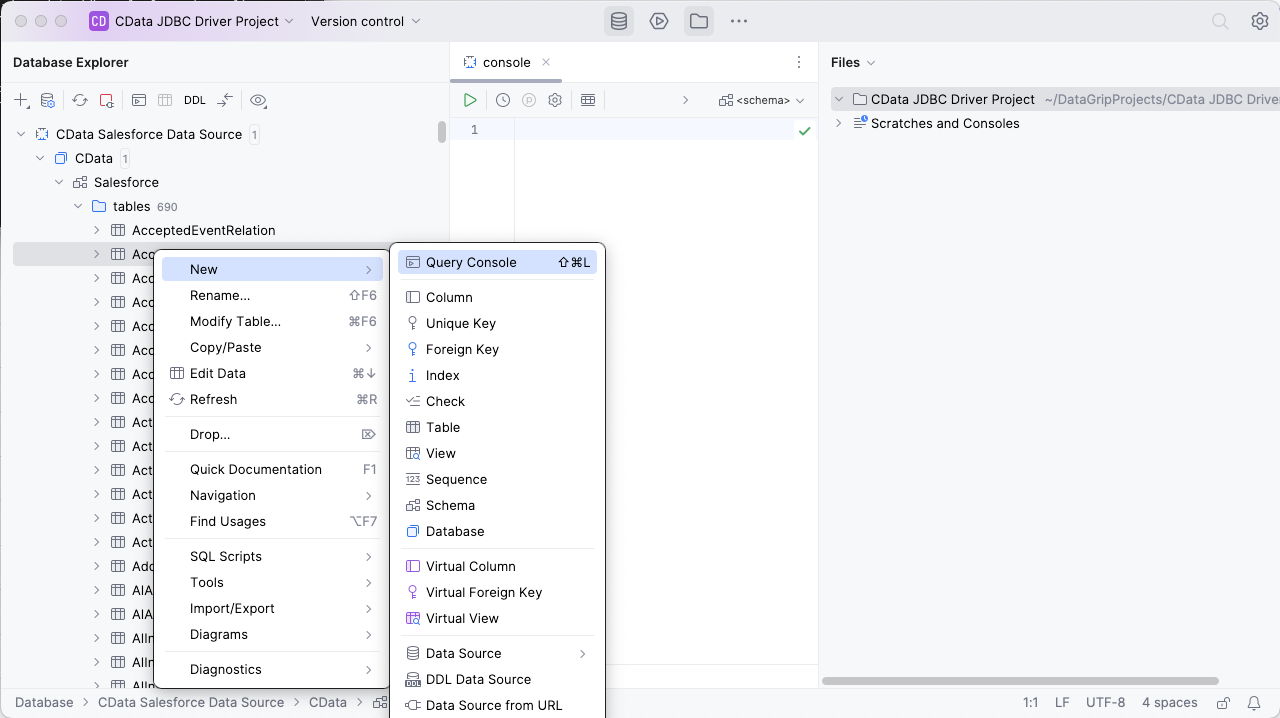

クエリを実行するには、任意のテーブルを右クリックして「New」→「Query Console」を選択します。

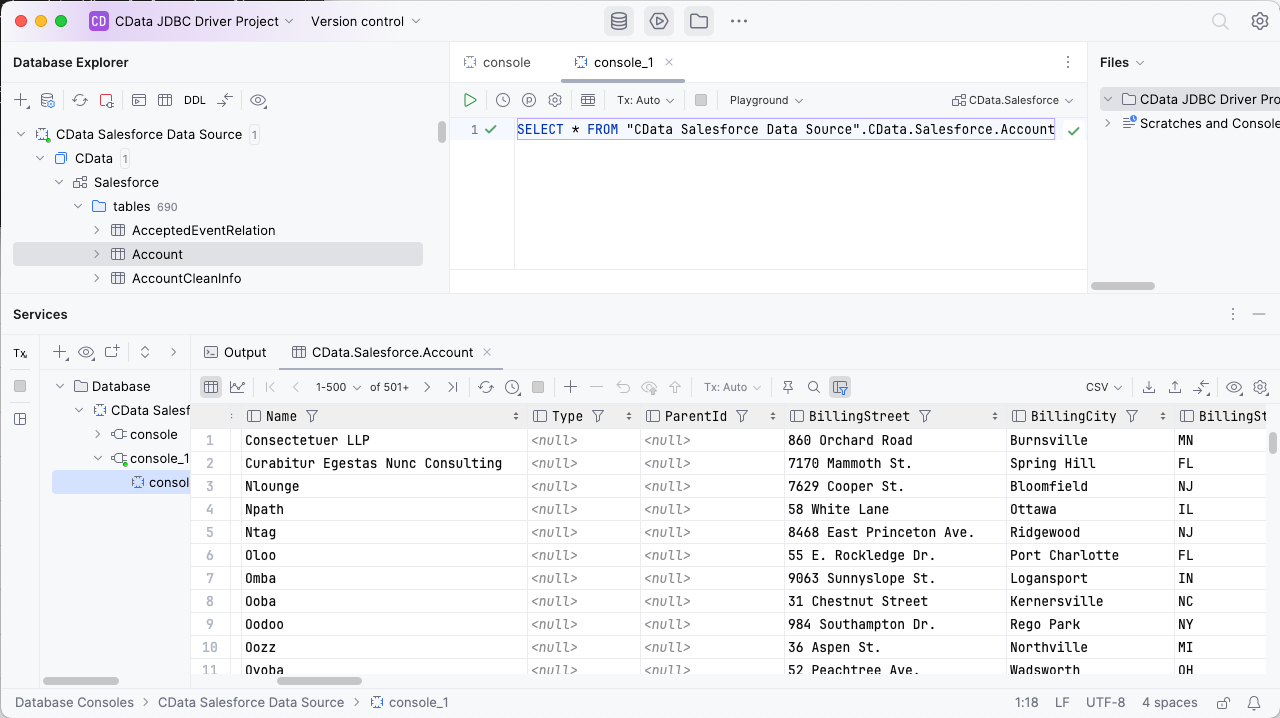

Console で、実行したい SQL クエリを記述します。例:

SELECT City, Balance FROM Customers

CData JDBC Driver for Apache Spark の30日間の無料トライアルをダウンロードして、DataGrip でリアルタイムSpark のデータを操作してみてください。ご不明な点があれば、サポートチームにお問い合わせください。