JayDeBeApi を使って Python からSpark のデータにアクセス

Python と Java がインストールされている環境であれば、Python スクリプトと標準 SQL を使ってSpark のデータにアクセスできます。CData JDBC Driver for Apache Spark と JayDeBeApi モジュールを組み合わせることで、Python からリモートのSpark のデータを操作できます。CData ドライバーを使用することで、業界標準に準拠した実績のあるドライバーを Python という人気の高い言語で活用できます。この記事では、ドライバーを使って Spark に SQL クエリを実行し、標準的な Python でSpark のデータを可視化する方法を説明します。

JayDeBeApi モジュールを使用

JayDeBeApi は、JDBC(Java Database Connectivity)のブリッジとして機能する Python ライブラリで、Python プログラムから CData JDBC ドライバーを含む Java データベースとやり取りできるようになります。pip install コマンドでモジュールをインストールします。

pip install JayDeBeApi

JDBC URL を作成

JayDeBeApi をインストールしたら、SQL を使って Python からSpark のデータを操作する準備が整います。

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

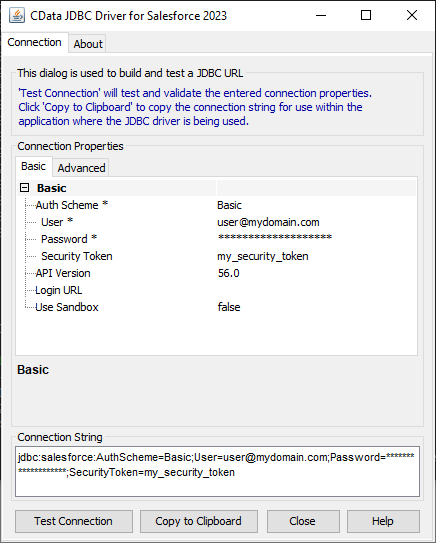

ビルトイン接続文字列デザイナー

JDBC URL の作成には、Spark JDBC Driver に組み込まれている接続文字列デザイナーを使用してください。JAR ファイルをダブルクリックするか、コマンドラインから実行します。

java -jar cdata.jdbc.sparksql.jar

接続プロパティを入力し、接続文字列をクリップボードにコピーします。

以下は、一般的な JDBC 接続文字列を含む変数の例です。

jdbc_url = "jdbc:sparksql:Server=127.0.0.1;"

Python からSpark のデータにアクセス

JDBC URL を設定したら、あとは JDBC ドライバーの JAR ファイルへの絶対パスだけが必要です。これはインストールディレクトリの "lib" フォルダにあります(Windows では "C:\Program Files\CData[product_name] 20XX\lib\cdata.jdbc.sparksql.jar")。

注意: まだ設定していない場合は、JAVA_HOME 環境変数を Java のインストールディレクトリに設定してください。

以下のようなコードで Spark からデータを読み取り、表示できます。

import jaydebeapi

#The JDBC connection string

jdbc_url = "jdbc:sparksql:Server=127.0.0.1;"

username = "****"

password = "****"

#The absolute Path to the JDBC driver JAR file, typically:

jdbc_driver_jar = "C:\Program Files\CData[product_name] 20XX\lib\cdata.jdbc.sparksql.jar"

conn = jaydebeapi.connect(

"cdata.jdbc.sparksql.SparkSQLDriver",

jdbc_url,

[username, password],

jdbc_driver_jar,

)

cursor = conn.cursor()

cursor.execute("SELECT * FROM Customers;")

results = cursor.fetchall()

for row in results:

print(row)

cursor.close()

conn.close()

無料トライアルと詳細情報

CData JDBC Driver for Apache Spark の 30 日間無料トライアルをダウンロードして、Python でリアルタイムのSpark のデータを操作してみてください。ご不明な点がございましたら、サポートチームまでお問い合わせください。