Spring Boot からSpark のデータに接続する方法

Spring Boot は、Java Web アプリケーションの開発を容易にするフレームワークです。 最小限の設定でスタンドアロンアプリケーションを作成できるのが特徴です。 CData JDBC Driver for Spark と組み合わせることで、Spring Boot からリアルタイムのSpark のデータを扱えるようになります。 この記事では、CData JDBC Driver for Apache Spark を使用してSpring Boot アプリケーションでデータソースを設定し、データを取得する方法を説明します。

ビルトインの最適化されたデータ処理機能により、CData JDBC Driver は リアルタイムのSpark のデータとのやり取りにおいて比類のないパフォーマンスを発揮します。Spark に 複雑なSQL クエリを発行すると、ドライバーはフィルタや集計などのサポートされている SQL 操作を直接Spark にプッシュし、サポートされていない操作(多くの場合SQL 関数や JOIN 操作)は組み込みのSQL エンジンを利用してクライアント側で処理します。 組み込みの動的メタデータクエリにより、ネイティブのデータ型を使用して Spark のデータを操作・分析できます。

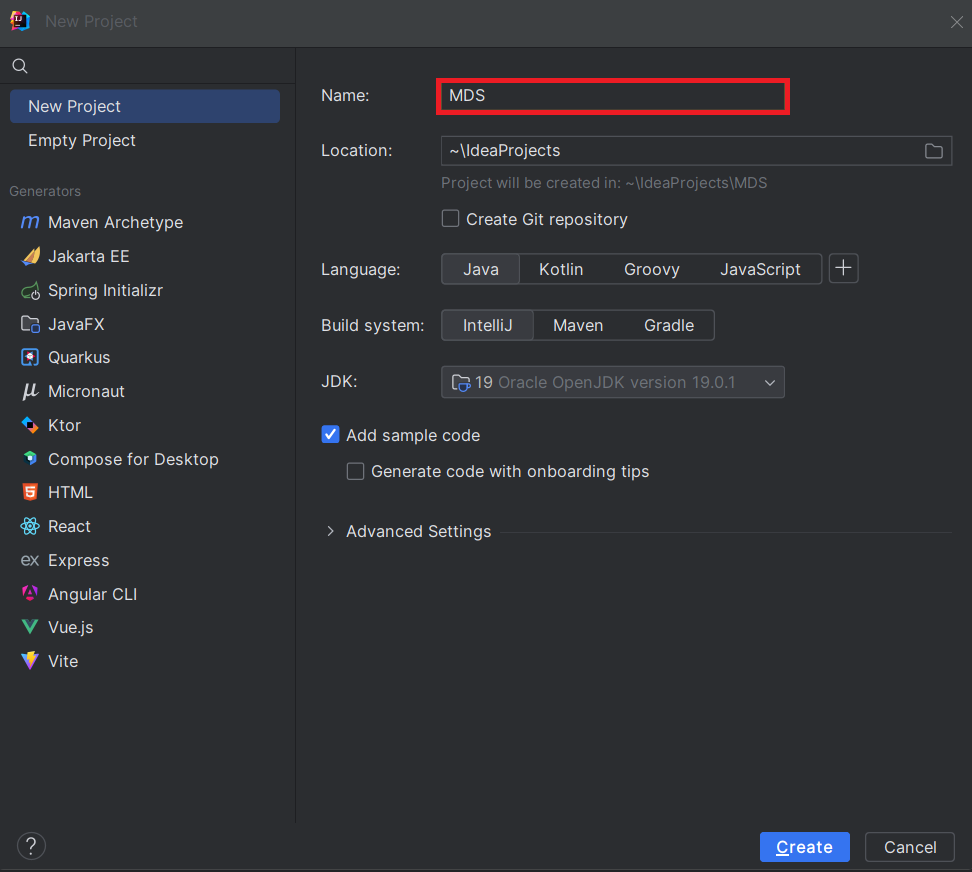

Java でSpring Boot プロジェクトを作成

IDE(このチュートリアルではIntelliJ を使用)で、Maven プロジェクトを選択します:

生成されたプロジェクトで、pom.xml ファイルを開き、Spring Boot に必要な依存関係を追加します:

生成されたプロジェクトで、pom.xml ファイルを開き、Spring Boot に必要な依存関係を追加します:

<?xml version="1.0" encoding="UTF-8"?> <project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 https://maven.apache.org/xsd/maven-4.0.0.xsd"> <modelVersion>4.0.0</modelVersion> <parent> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-parent</artifactId> <version>2.7.2</version> <relativePath/> </parent> <groupId>com.example</groupId> <artifactId>demo</artifactId> <version>0.0.1-SNAPSHOT</version> <name>demo</name> <description>Demo project for Spring Boot</description> <properties> <java.version>1.8</java.version> </properties> <build> <plugins> <plugin> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-maven-plugin</artifactId> </plugin> <plugin> <groupId>org.apache.maven.plugins</groupId> <artifactId>maven-install-plugin</artifactId> <version>2.5.1</version> <executions> <execution> <id>id.install-file</id> <phase>clean</phase> <goals> <goal>install-file</goal> </goals> <configuration> <file>C:\Program Files\CData[product_name] ####\lib\cdata.jdbc.sparksql.jar</file> <groupId>org.cdata.connectors</groupId> <artifactId>cdata-sparksql-connector</artifactId> <version>23</version> <packaging>jar</packaging> </configuration> </execution> </executions> </plugin> </plugins> </build> <dependencies> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-web</artifactId> </dependency> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-jdbc</artifactId> <version>2.7.0</version> </dependency> <dependency> <groupId>org.cdata.connectors</groupId> <artifactId>cdata-sparksql-connector</artifactId> <version>23</version> </dependency> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-test</artifactId> <scope>test</scope> </dependency> </dependencies> <distributionManagement> <repository> <uniqueVersion>false</uniqueVersion> <id>test</id> <name>My Repository</name> <url>scp://repo/maven2</url> <layout>default</layout> </repository> </distributionManagement> </project>

Note: 年(####)とバージョン番号(上記のXML スクリプトに記載)は、使用しているCData JDBC Driver の現在のバージョンに合わせて調整してください。

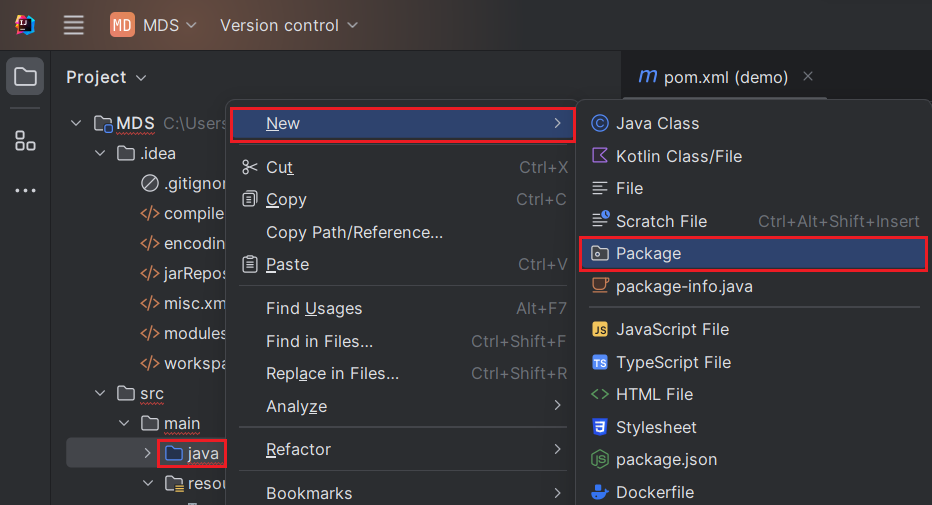

プロジェクト構造

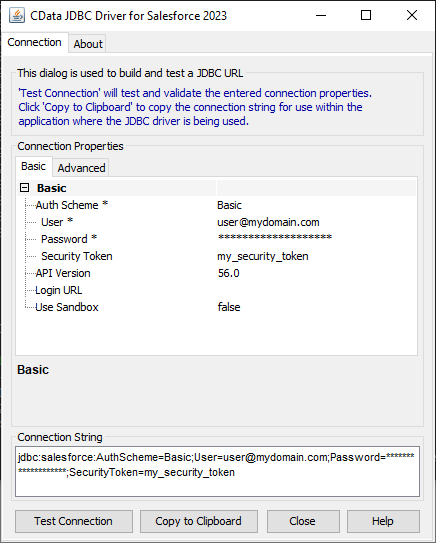

java ディレクトリに新しいパッケージを作成します。通常、パッケージ名はgroupId

(com.example)の後にartifactId(.MDS)を付けたものになります。

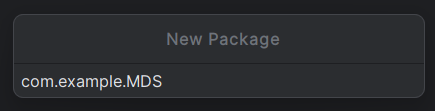

「java」ディレクトリを「Sources Root」としてマーク(青色で表示)します。これを行うには、java ディレクトリを右クリックし、「Mark Directory as」->「Sources Root」を選択します(以下を参照)。また、「resources」ディレクトリを「Resources Root」としてマークします。

データベース接続プロパティの保存

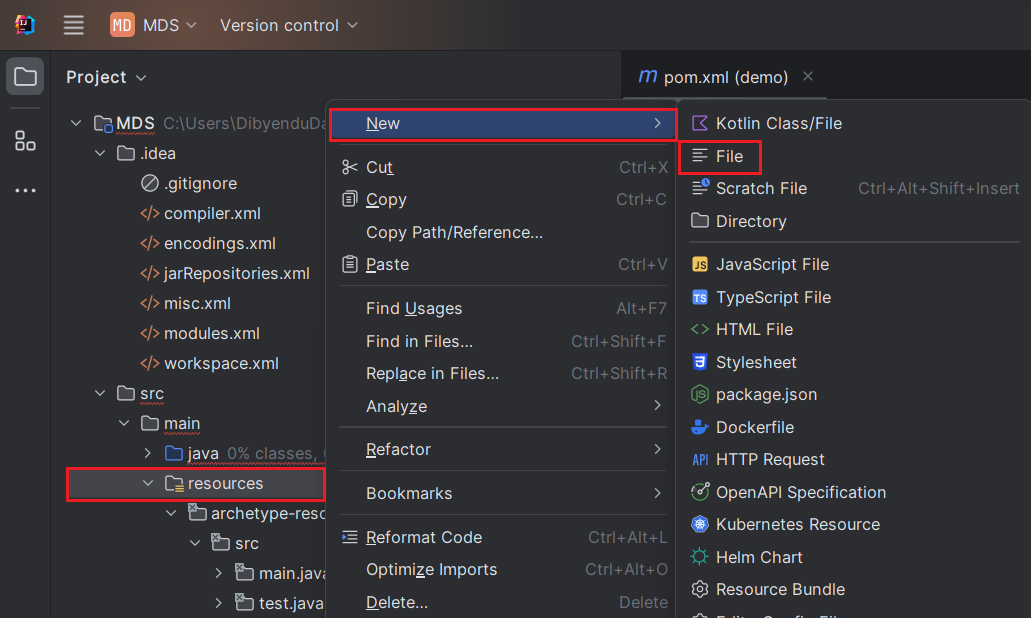

データベース接続プロパティを保存するための「application.properties」ファイルを作成します。これを行うには、「resources」フォルダを右クリックし、「New」->「File」を選択し、ファイル名を「application.properties」と入力してEnter を押します。

application.properties ファイルで、クラス名とJDBC URL を使用してSpark JDBC Driver の設定プロパティを設定します:

spring.datasource.driver=cdata.jdbc.sparksql.SparkSQLDriver spring.datasource.url=jdbc:sparksql:Server=127.0.0.1;

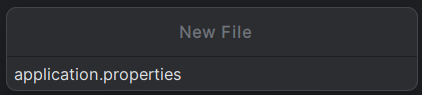

組み込みの接続文字列デザイナー

JDBC URL の作成については、Spark JDBC Driver に組み込まれている接続文字列デザイナーを使用してください。JAR ファイルをダブルクリックするか、コマンドラインからjar ファイルを実行します。

java -jar cdata.jdbc.sparksql.jar

SparkSQL への接続

SparkSQL への接続を確立するには以下を指定します。

- Server:SparkSQL をホストするサーバーのホスト名またはIP アドレスに設定。

- Port:SparkSQL インスタンスへの接続用のポートに設定。

- TransportMode:SparkSQL サーバーとの通信に使用するトランスポートモード。有効な入力値は、BINARY およびHTTP です。デフォルトではBINARY が選択されます。

- AuthScheme:使用される認証スキーム。有効な入力値はPLAIN、LDAP、NOSASL、およびKERBEROS です。デフォルトではPLAIN が選択されます。

Databricks への接続

Databricks クラスターに接続するには、以下の説明に従ってプロパティを設定します。Note:必要な値は、「クラスター」に移動して目的のクラスターを選択し、 「Advanced Options」の下にある「JDBC/ODBC」タブを選択することで、Databricks インスタンスで見つけることができます。

- Server:Databricks クラスターのサーバーのホスト名に設定。

- Port:443

- TransportMode:HTTP

- HTTPPath:Databricks クラスターのHTTP パスに設定。

- UseSSL:True

- AuthScheme:PLAIN

- User:'token' に設定。

- Password:パーソナルアクセストークンに設定(値は、Databricks インスタンスの「ユーザー設定」ページに移動して「アクセストークン」タブを選択することで取得できます)。

application.properties ファイルでプロパティを設定したら、次にそれらを構成します。

データソースの設定

まず、Spark データソースをプライマリデータソースとしてマークします。次に、データソースBean を作成します。

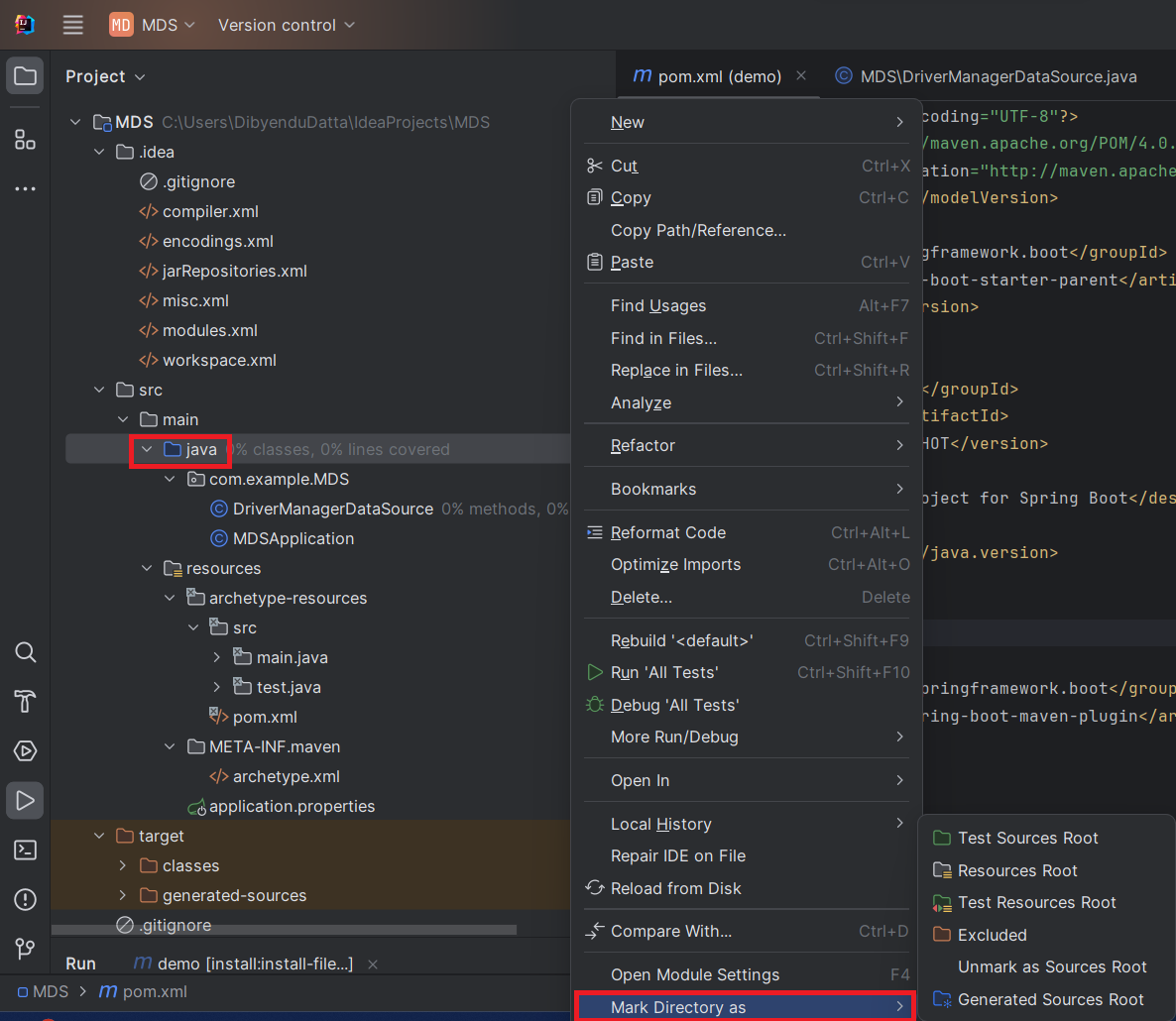

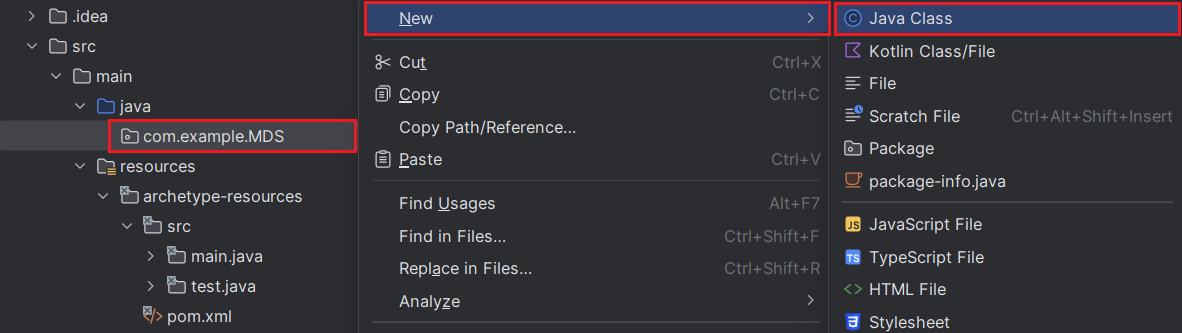

DriverManagerDataSource.java ファイルを作成し、以下のようにBean を作成します。@Bean でエラーが発生する場合、 Spring Boot が正しくロードされていない可能性があります。これを修正するには、「File」->「Invalidate Caches」でキャッシュを無効にして再起動します。 また、Maven がSpring Boot の依存関係を追加していることを確認してください。

データソースBean を作成するには、DriverManagerDataSource クラスを使用します。このクラスを使用すると、

データソースのプロパティを設定できます。このJava クラスを作成するには、「com.example.MDS」パッケージを右クリックし、「New」->「Java Class」を選択します。

以下のコードは、データソースのBean 定義を示しています。各ドライバーにはBean が必要です。

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.boot.jdbc.DataSourceBuilder;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Primary;

import org.springframework.core.env.Environment;

import javax.sql.DataSource;

public class DriverManagerDataSource{

@Autowired

private static Environment env;

@Bean(name ="SparkSQL")

@Primary

public static DataSource SparkSQLDataSource()

{

DataSourceBuilder<?> dataSourceBuilder = DataSourceBuilder.create();

dataSourceBuilder.driverClassName("cdata.jdbc.sparksql.SparkSQLDriver");

dataSourceBuilder.url("jdbc:sparksql:Server=127.0.0.1;");

return dataSourceBuilder.build();

}

//@Override

public void setEnvironment( final Environment environment) {

env=environment;

}

}

次に、Spark jar ファイルをDocuments フォルダに移動します(以下のコマンドのパスを参照)。jar ファイルのパスにスペースが含まれないようにするためです。次に、

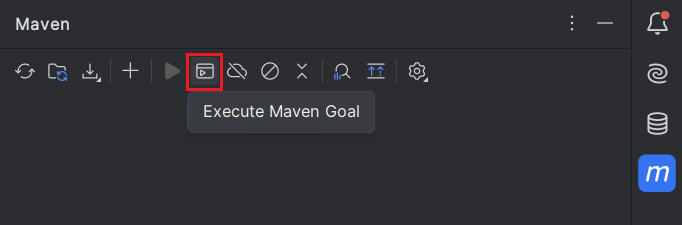

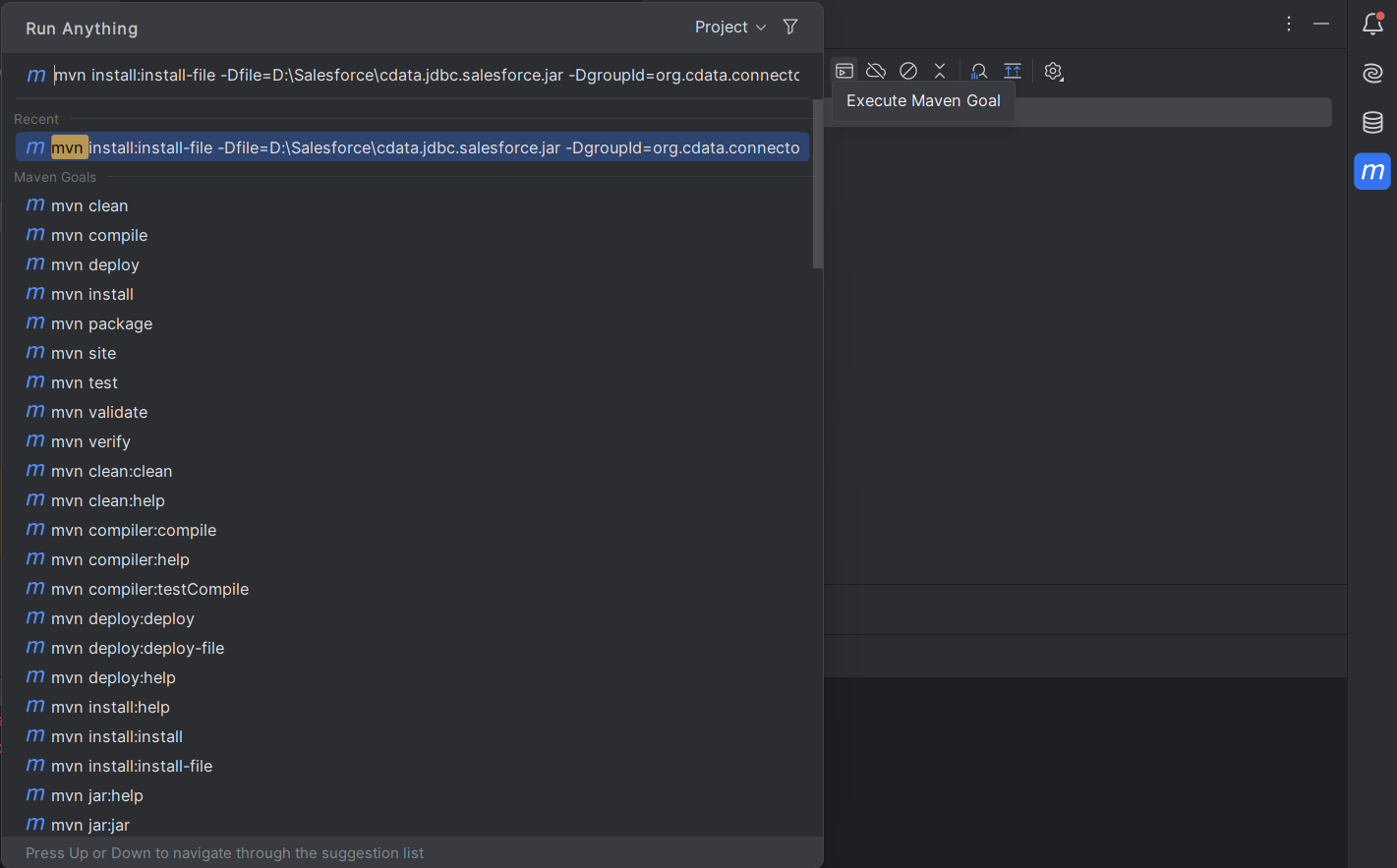

Maven アイコン(IntelliJ の右上隅)をクリックし、「Execute Maven Goal」をクリックします。以下のコマンドを実行します:

mvn install:install-file "-Dfile=C:\Program Files\CData[product_name] ####\lib\cdata.jdbc.sparksql.jar" -DgroupId=org.cdata.connectors -DartifactId=cdata-sparksql-connector -Dversion=23 -Dpackaging=jar

このコマンドを実行するには、以下のいずれかの手順に従ってください:

- 「-Dfile location」はCData JDBC Driver のデフォルトのインストールパスのままにできます。この場合、パスを引用符で囲んでください。また、使用しているドライバーの現在のバージョンに基づいて年と「Dversion」を変更してください。

- 記事の前半で述べたように、

jar ファイルをDocuments フォルダに移動した場合は、提供されたコマンドのパスを変更してください。この場合、Dfile location を引用符で囲まないでください。使用しているドライバーの現在のバージョンに基づいて「Dversion」を編集してください。

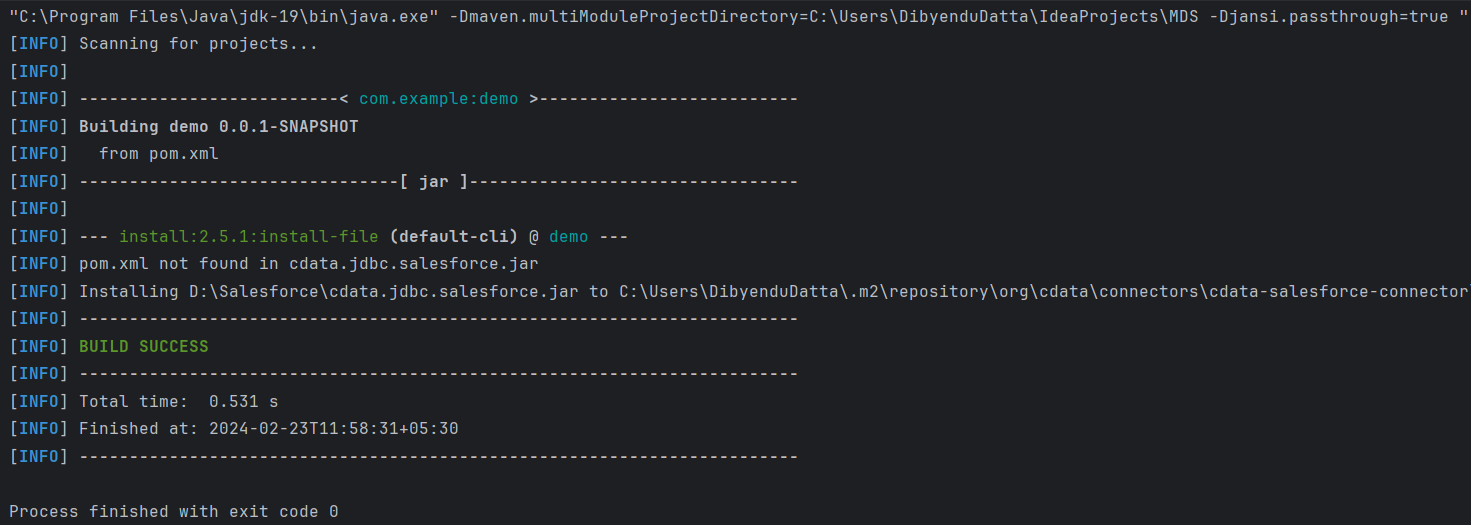

Enter を押すと、以下の出力が表示されます:

接続のテスト

最後のステップは接続のテストです。

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.boot.autoconfigure.jdbc.DataSourceAutoConfiguration;

import java.sql.Connection;

import java.sql.SQLException;

import static com.example.demo.DriverManagerDataSources.SparkSQLDataSource;

@SpringBootApplication(exclude = {DataSourceAutoConfiguration.class})

public class MDSApplication {

//remove the comment on the line below

public static void main (){

SpringApplication.run(DemoApplication.class, args);

Connection conn = SparkSQLDataSource().getConnection();

System.out.println("Catalog: "+ conn.getCatalog());

}

}

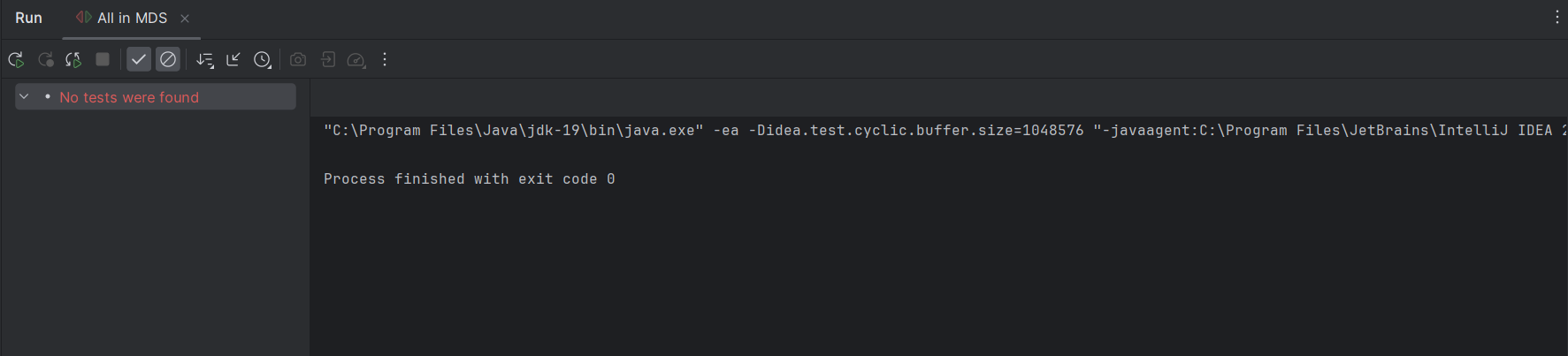

生成される出力は以下のようになります:

無償トライアルと詳細情報

CData JDBC Driver for Spark の30日間の無償トライアルをダウンロードして、Spring Boot でリアルタイムのSpark データを使い始めましょう。